画像解析のGPT-4Vがまだ来ない・・ので関連情報収集(ChatGPT部、大城)

おはようございます、ChatGPT部、部長の大城です。最近ようやく福岡も少し涼しくなってきましたが皆様いかがお過ごしでしょうか。

ChatGPTの画像を解析する機能、今年の3/14くらいにOpenAI社のエンジニアの方がデモをして度肝を抜かれたわけですが、おそらくその機能が数日前に段階的に公開されたようです(GPT-4V)。3-4日前にリリースされて今後2週間でChatGPTプラスの有料ユーザーには届くよ、とのことでしたので数日待っていたわけですが、例によってまだ私の方の2アカウントには届いていませんでした・・。

ということで今日は他の人がGPT-4Vをどのように使っているのか、について情報を集めようと思います。

2024/3/14くらいのOpenAI社のデモ

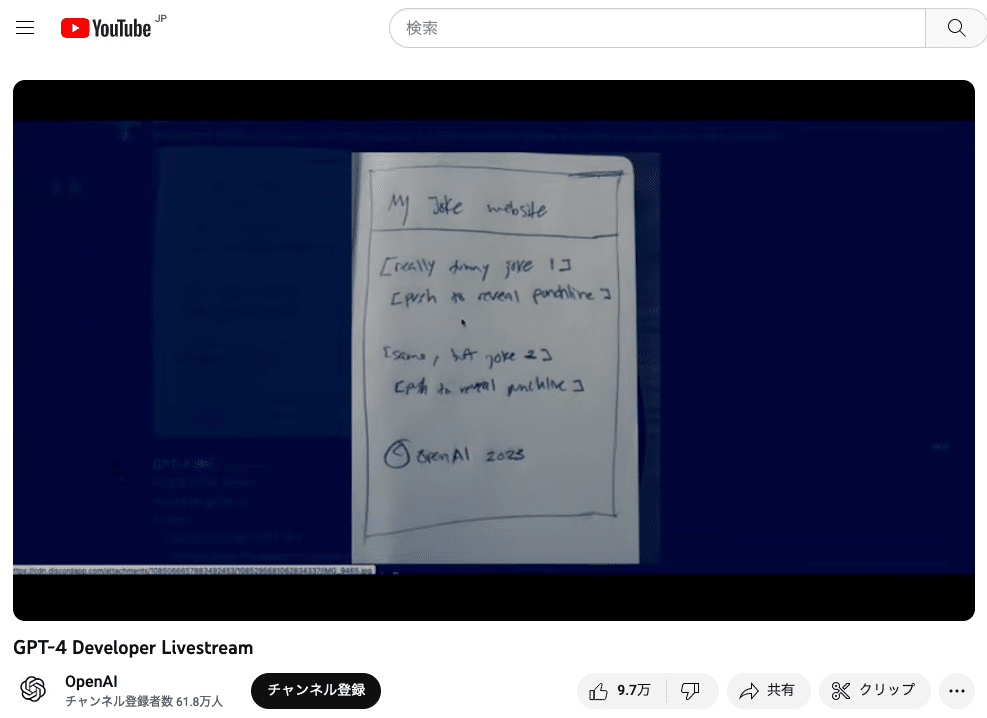

多分、私が最初に画像解析機能やべーとおもったのがこちらのデモですね。手書きのラフスケッチからWebサイトのコード生成。

上記動画より切り取りますと、まずこちらの手書きのラフスケッチが・・

ChatGPTの画像認識能力で、Webサイトのコードを生成してブラウズ可能な状態に。

3/14ごろの投稿なので、半年前とかですかね。いやー、いつ来るのかとずっと待ってました (まだ私の環境では手元でさわれないですが・・w)

GPT-4VについてWeb記事やTwitterから

Javaのきしださん

きしださん、速攻で色々実験されててブログにまとめられてますね。

(しかし自己紹介がアマチュア驚き屋・・笑)

きしださんのブログから1部分参照させていただくとこんな感じ。この画面が自分の環境ではまだ出ないんですよね・・

そして手書きからのコーディングも再現されてました。

いやー、すごい。未来感あります。

Twitter記事をいくつか

「GPT-V4」でTwitter検索して調べてみましょう。

回路図読めるんですか・・

GPT-4V、回路図も読めるじゃん。正解は昇降圧型DC/DCなんですが、バックブーストレギュレータとも言うので正解。 pic.twitter.com/rQc4fmhkTK

— ⚙gear machine (@grmchn4ai) September 29, 2023

天下一品の看板が自動運転車の画像認識だと一時停止と勘違いする問題、をGPT-4Vで解かせてみた投稿

自動運転で大問題 (?) だった進入禁止と天一看板の誤認問題も GPT-4V で解決! pic.twitter.com/V44PwYh9mI

— ぬ (@nkmry_) September 28, 2023

iPhoneの電卓を実装させた話。最初twitterにこれが流れてきてかなり驚いた記憶があります

GPT-4Vに、某計算機アプリのスクショを与えてこのアプリ作りたいと指示したら、正常に動いて計算もできるHTML+jsのサンプルコードが1発で出てきた。フロントエンドのレイアウトもちゃんと守ってる。開発も色々と変わりそうな予感。 pic.twitter.com/IuSIwub5av

— FabyΔ (@FABYMETAL4) September 27, 2023

ゲーム画面開設。これで次のコマンドの指示とかを何かのインターフェースで繋げば、自動プレイもできますね

GPT-4V凄すぎる。

— あき先生 | AI Vtuber『しずく』開発中 (@cumulo_autumn) September 29, 2023

もう少しでAPEXプレイできるようになりそうじゃん。 pic.twitter.com/5HLdIqNTSx

アプリ版にもきてる人は来てるみたいです。これとARグラスとか組み合わせるとかなり捗りそう。

アプリ版にもGPT4V来てた!

— ぱぷりか炒め (@WMjjRpISUEt2QZZ) September 29, 2023

カメラ撮ってポスト出来るの助かる☺️ pic.twitter.com/53UxCmOB1V

間違い探しはまだ苦手な模様 (私も別のAIでウォーリーをさがせを実験しましたが、そのときもうまくいきませんでした )

GPT-4Vにサイゼリヤの間違い探しさせてみたら正答率10%だった笑

— あき先生 | AI Vtuber『しずく』開発中 (@cumulo_autumn) September 29, 2023

でも、デフォルメされてる絵に対しても普通に状況の認識精度めちゃ高いし、1個でも正解出来てる時点ですごすぎる。(ちなみに、正解してたのは2番の山の形) pic.twitter.com/UI5XCMClzM

マーケターとしての考察。夢が広がります

GPT-4V先生談。これは唸る。 https://t.co/iJynPBqmRh pic.twitter.com/9KKflinKvq

— FabyΔ (@FABYMETAL4) September 28, 2023

所感と今後の個人的展望

いやー、すごいですね。ChatGPTに「目」が搭載されて、デジタルヒューマンへの3歩目、という感じがしました。

(頭脳がGPT-3.5や4の1歩目、プラグイン等のインターネット接続で2歩目、に続く3歩目で視覚や実は聴覚も)

余談ですが先日元ヤフーでその後EmbodyMe社を立ち上げられたイッセーさんにお会いする機会があったのですが、イッセーさんも「デジタルヒューマンは来るでしょ」的なことをおっしゃっていたので、今回のGPT-4Vの画像認識はその一端なんだろうなぁという気がしています。

またtweetの最後のマーケティングへの利用は驚愕ですね。間違い探しもそうですが、「現在の性能」でそのポテンシャルですので、これが今後ChatGPT-5とか6が出てきた頃にはおそらく一般人はおろか、専門家でも太刀打ちが難しいレベルになるのでは、という予感すらします。

( とはいえ、ChatGPTを運用するには電気代がめちゃかかるので多分時給1000円とか2000円のタスクなら、人間でやった方が安いよね、とはなりそうです。プログラムを書かせて安い電力で回す、これまで誰も発見していなかった新法則を探索させる、とかはありかもしれませんが )

個人的展望

ひとまず、過去にGoogle Bard, Bing搭載のGPT-4の画像認識でテストした内容と、GPT-4Vを比較してみたいなと思っています。これでどこまで精度がでるか、ですね。

https://note.com/chatgpt_nobdata/n/n82b871e0d706

iPhoneが登場した時の驚きも大きかったですが、いずれにせよイノベーションが起きている時代にリアルタイムに遭遇できる、というのはテンションが上がりますね。ということでみなさんもどうぞ良いChatGPTライフを・・!(大城)