FireAct: Language agent × LLM fine-tuning における新しい枠組みの提案

#FireAct #LLM #エージェント #多読 #論文紹介

Chen+'23 - FireAct: Toward Language Agent Fine-tuning

Baian Chen, Chang Shu, Ehsan Shareghi, Nigel Collier, Karthik Narasimhan, Shunyu Yao

[Paper][Model][Dataset][GitHub]

※ 誤っている可能性のある内容、未紹介の内容がございます

※ 詳細は必ず 論文 をご参照ください

1. どんなもの?

言語エージェントと言語モデルのファインチューニングはどちらもよく知られたトピックであるが、両者の交わりはあまり研究されていない。本研究は、エージェント的な使用のためにLMを微調整することの複数の利点を示すための最初のステップであり、言語エージェントの微調整に向けた様々な新しい問題を開くものである。

2. 先行研究と比べてどこがすごい?

3. 技術や手法のキモはどこ?

GPT-4 を用いて ReAct 形式の軌跡を生成し微調整

複数タスクと複数プロンプト手法を混合させて多様なデータを作成

学習データは SerpAPI と GPT-3.5/4 を使用して作成

Llama-2, CodeLlama を対象に LoRA を使用して微調整

4. どうやって有効だと検証した?

評価タスク

HotpotQA … 多段階推論と知識検索を伴う質問応答タスク。答えは、短いエンティティか YES/NO 形式。学習セットから微調整用に 2,000 件、開発セットから評価用に 500 件を無作為に選択。

Bamboogle … HotpotQA と同様の形式を持つ 125 件の多段階推論による評価セット。Google 検索による直接的な解答を避けるよう作成される。

StrategyQA … 暗黙的な推論過程を必要とする Yes/No 形式の質問応答タスク。

MMLU … 初等数学、歴史、コンピュータサイエンスなど 57 領域の選択肢付質問応答タスク。

#Sec5. 1 タスク 1 プロンプト

HotpotQA × ReAct のデータによる微調整

#Sec6. 1 タスク複数プロンプト

HotpotQA × {ReAct, CoT, Reflexion} のデータによる微調整

#Sec7. 複数タスク複数プロンプト

{HotpotQA, StrategyQA, MMLU} × {ReAct, CoT, Reflexion} のデータによる微調整

5. 議論はある?

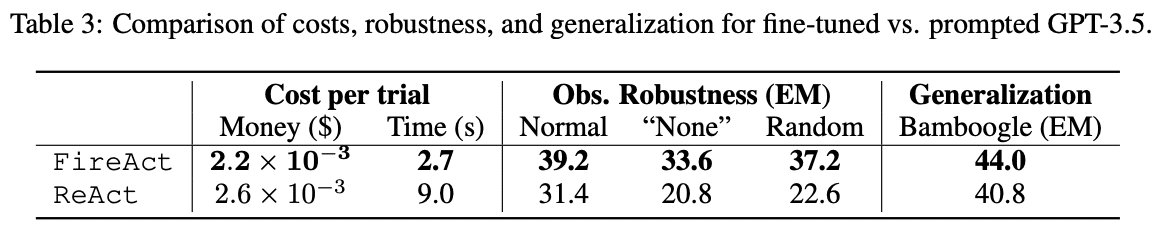

Llama-2, CodeLlama の FireAct モデルが GPT-3.5 と同等以上の性能を示した。これは OpenAI API を用いたエージェントに対して、安価で高速なエージェントを開発可能であることを示唆する。また FireAct モデルはゼロショットによる推論が可能であることも、効率的なアプリケーション開発において注目に値する。

データサイズと種類については以下に言及される。

6. 次に読むべき論文は?

Wei+'22 - Chain-of-Thought Prompting Elicits Reasoning in Large Language Models (NeurIPS) [OpenReview]

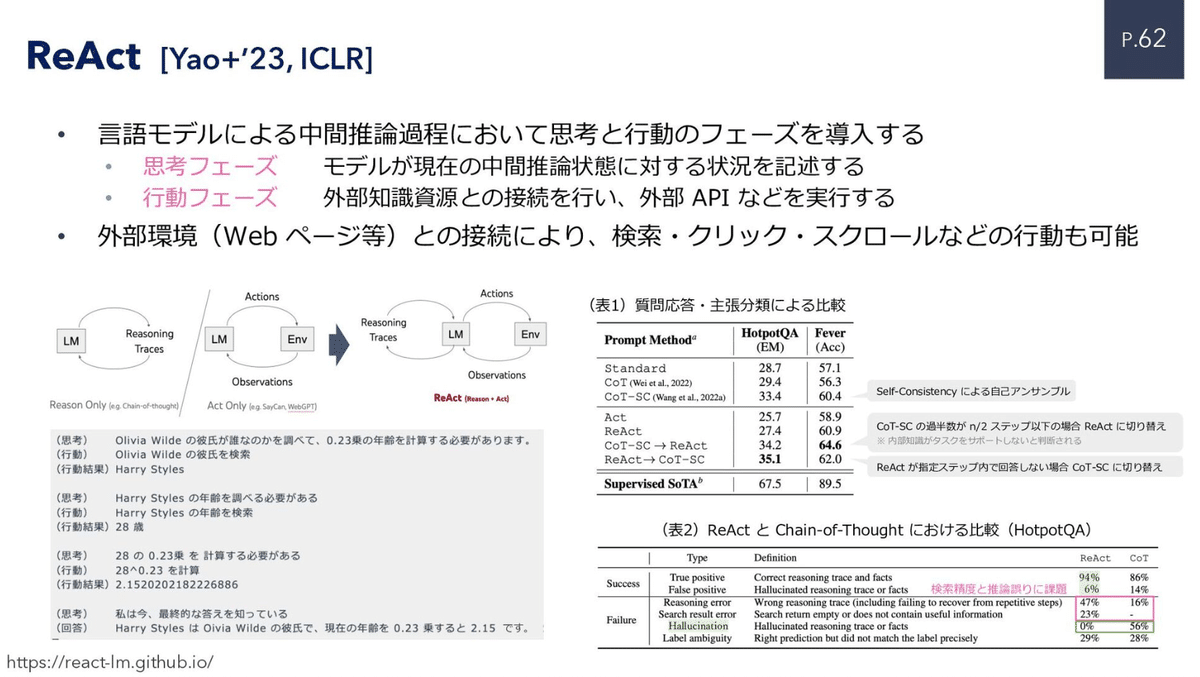

Yao+'23 - ReAct: Synergizing Reasoning and Acting in Language Models (ICLR) [Project]

Shinn+'23 - Reflexion: Language Agents with Verbal Reinforcement Learning [arXiv]

この記事が気に入ったらサポートをしてみませんか?