AGIによる破滅:致命的なリスト

去年6月にAI Alignment Forunmに投稿されたEliezer Yudkowsky氏による以下の記事を和訳した。適宜わかりにくいかもしれない箇所は※で補足を試みた。

Eliezer Yudkowsky氏はAI Alignment問題(主に、AGIが人間の利益に沿った目標ではなく、意図しない、望ましくない目標の追求を学習するという懸念)が一般に認識される前からAGIによる人類への壊滅的被害に関する思索を続けられてきた方で基本的にはデフォルトで今のままだと人類は壊滅すると主張している。

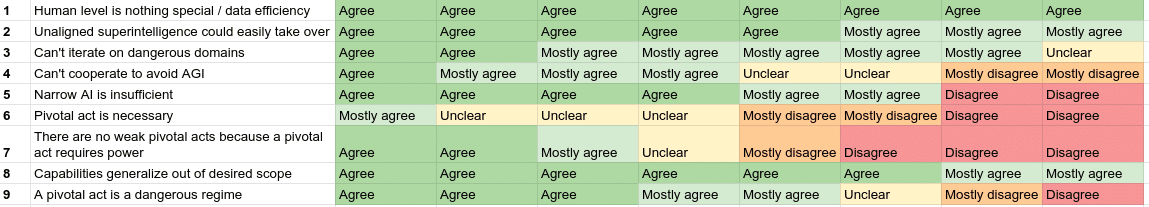

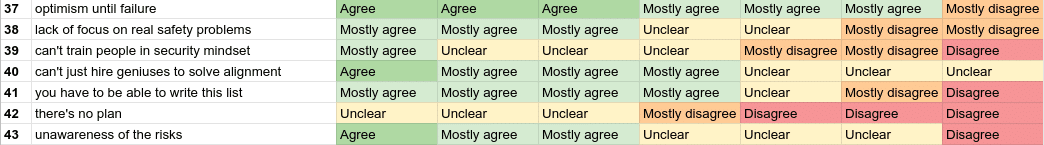

また「AGI Ruin: A list of Lethalities」投稿に対して2ヶ月後にDeepMindのAI Alignment teamから反応が出ている。詳細は省くが各セクション毎に8名の意見結果のみ(Agree,Mostly agree,Unclear,Mostly disagree,Disagree)を載せる。

以下和訳(長いのでまとめからみると良いかもしれません。馴染みのなさそうな用語は適宜本文中で解説しているので検索してみてください。)

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

前置き:

(すでにすべての基礎を知っており、前置きを読みたくない場合は、正確なアライメントの技術的な困難についてのセクションBにスキップしてください。)

私は何度か、AGIがあなたを殺す理由の整理されたリストを書くことに失敗しました。人々は、AGIが生存可能である理由について異なる考えを持っており、まず明らかに重要なポイントについて聞きたがります。その人々の中には、最も重要なポイントがすぐに取り上げられない場合、私に対して大声で不満を表明する人々もいます。そして、私は別のポイントを最初に取り上げます。

この問題をうまく解決できなかったので、私は今後、個別の不平不満の整理されていないリストで問題を解決することにします。このリストには特に満足していません。別の選択肢は何も公開しないことであり、このリストを公開することはわずかに尊厳があるように思われます。

ここでの議論の一般的な主題に関する3つのポイントは、致命的なリストと競合しないように番号が付けられています。

-3. あなたが「直交仮説、道具的収束」といういくつかの基本事項をすでに知っていることを前提としています。

※直交仮説とは、エージェントは知能レベルと最終目標の組み合わせが自由である、つまりその最終目標 と 知能レベル は互いに独立して変化することができるとする仮説

※道具的収束とは 、十分に知的なエージェントが、自己保存や資源獲得など、潜在的に無制限の道具的目標を追求する傾向

※直交仮説と道具的収束の組み合わせが人類への壊滅的な結果を生み出すシナリオが論じられやすいと思われる。つまり、超知能やAGIがどんなに賢くても、荒唐無稽な目標を持ちうる(ペーパークリップを最大化する等)。またその目標を遂行する過程で自己保存や資源を追求し、結果として人類が壊滅する。

-2. 「アライメントが致命的に困難である」と言うとき、私は「証明可能なアライメントの理想的または完璧な目標」、超知能体の完全な人間価値へのアライメント、人間の合理的な意見の食い違いに関する倫理的ジレンマについて満足のいく議論をAIに生成させること、あるいはAIが誰もを殺さないという絶対的な確信を得ること、といったことについては話していません。私がアライメントが困難であると言うとき、私は、現実的に使用可能な技術を使って、「確率的には誰もを解体しないでください」という要求は、私たちがたどるべき道にないほど大きな要求であり、そのような要求を達成するために進んでいるとは言えません。私にとって重要なことは、10億人以上を殺す可能性が50%未満の強力なAGIを手に入れることです。殺傷者が少ない場合は、それは素晴らしい贅沢品になるでしょうが、「誰も殺さない」という非常に高い目標に達することができれば、わずかに努力を増やすだけで、殺傷率を5%未満にすることができるでしょう。実際の困難のほとんどは、「確実に誰も殺さない」という目標に達することにあります。トロリー問題は、これらすべての興味深い部分問題ではありません。生き残る人がいるなら、アライメントを解決しました。この時点で、それがどのように機能するかは関係ありません。どのように到達したかも気にしません。私は使用された方法に対して原因を問わず、将来的な結果だけを見ており、「このAGIは確実に誰もを殺さない」と信じられる理由があることを望んでいます。私が求める「アライメント」がこれよりも厳しいものであると言っている人は、読解力に欠けています。 AGIアライメントにとって最大の要求は、何らかの戦略によって生存者がいる可能性があるということです。

-1. ここで議論していることは、原理的に不可能なことについてではありません。私が通常使用する比喩は、未来の100年後の教科書が手に入り、実際に実践で堅実に動作するすべての単純なアイデアが含まれている場合、6か月でアラインメントされた超知能体を構築できるかもしれない、というものです。機械学習に習熟している人々には、ReLUアクティベーションとシグモイドアクティベーションの違いを比喩として使用します。シグモイドアクティベーションは複雑で壊れやすく、多くの層を通じて勾配を伝達するのに非常に不十分です。一方、ReLUは非常にシンプルで(知らない人のために、アクティベーション関数は文字通りmax(x,0)です)、はるかに優れた結果を生み出します。ニューラルネットワークの大部分は、最初の数十年間にシグモイドを使用していました。ReLUのアイデアは、数十年後に発見、検証、普及するまで見出されませんでした。致命的なのは、実際の生活で動作する単純な解決策をすべて伝える未来の教科書がないことです。私たちは最初の重要な試みで比喩的なシグモイドですべてをやっていくことになるでしょう。ここで説明されているAGIアライメントに関する困難のうち、どれも原理的に不可能だと私が主張しているわけではありません。科学は通常、時間の予算が無限で再試行も無制限に可能であるため、100年間をかけて解決することができます。しかし、私たちは最初の重要な試みで実践的に解決するためのコースに乗っていません。この致命性のリストは、原理的に不可能なことについて強い主張をするものではありません。

上記を前提として:

以下は、私の視点からAGIが現在の経路や簡単に移行できる他の経路で生存可能である理由に関して、異なる人々が信じる様々な間違った主張に矛盾する、いくつかの異なる真実を示したものです。

セクションA:

これは非常に致命的な問題であり、何らかの方法で解決しなければならない。一部の人が夢見るような様々な簡単なモードではなく、最低限の強さと難易度で解決しなければならない。「みんな」が安全な弱い問題だけを解決するために後退するという目に見える選択肢はない。

ーーーーーーーーーDeepMind Alignment team 見解ーーーーーーーーーーー

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

1.Alpha Zeroは、人間のプレイブックやサンプルゲームに頼らず、自己対戦で1日ほどで囲碁に関するすべての蓄積された人間の知識を突破しました。「まず、人間の囲碁の能力に達するだろうが、その後、人間から学ぶことができなくなるので、進歩が難しくなる」と考える人は、現実とはかけ離れた考えをしています。AGIは、人間の能力や人間の学習速度によって上限が決まるものではありません。人間よりもはるかに賢いものは、アイデアを頭に叩き込むために人間が必要とする証拠よりも少ない証拠から学べます。ここには理論的な上限がありますが、その上限は非常に高いと考えられています(例えば、すでに完全に予測されていない各ビットの情報は、考慮されるすべての仮説の確率質量を最大で半分に減らすことができます)。私たちが反応しやすい時間スケールで物事が進むのは、自然に(デフォルトで、介入がない限り)当たり前のことではありません。

2.十分に高い認知能力を持つ認知システムは、中帯域幅の因果関係チャンネルがあれば、人間のインフラとは無関係に圧倒的な能力まで起動することは難しくありません。 私がここで通常使う具体例はナノテクです。ナノテクで何が可能になるかについて、物理的に達成可能と思われる下界がかなり詳細に分析されており、この下界はポイントを伝えるには十分だからです。私の考える「十分に強力な知性が、そうしたくないと思わなければ、どのように皆を殺すか」の下限モデルは、インターネットにアクセスし、メールに記載されたDNA配列を受け取り、タンパク質を送り返してくれる多くのオンライン企業のいずれかに、いくつかのDNA配列をメールで送り、AGIを相手にしているとは知らない人間を買収/説得してビーカーでタンパク質を混ぜさせ、実際のナノマシンを製造できる第一段階のナノ工場を形成する、というものです。(私がこのビジュアライゼーションを最初に展開したとき、賢明な評論家たちは「ああ、でも、超知的生命体が、惑星サイズのスーパーコンピューターをすでに持っていないなら、タンパク質の折り畳み問題を解決できるとどうしてわかるのですか」と言った。「しかし、アルファフォールド2の登場後は、なぜかこのような声が少なくなった。)ナノマシンはダイヤモンド型バクテリアを作り、太陽光発電と大気中のCHONで複製し、小型のロケットやジェットに集合させて、ジェット気流に乗って地球の大気中に拡散し、人間の血流に乗って隠れ、タイマーで攻撃することができるかもしれない。高性能な認識システムとの衝突に負けることは、少なくとも「地球上のすべての人が同じ秒数の間に突然死んでしまう」のと同じくらい致命的であるように見えます。

(私が「高い認知能力」という厄介な構文を使うのは、「スマート」や「インテリジェント」といった標準的な英語用語が、私には主に地位の同義語として機能しているように見えるからです。「超知能」はほとんどの人にとって、「ダブルカレッジに行った地位階層の上位のもの」と聞こえるし、それがなぜそれほど危険か理解できないのではないでしょうか。地球人には「実際に役に立つ認知力」を意味する言葉もなければ、標準的なネイティブの概念もない。 十分なパニックを起こせないのは、地球人という文化が名付けていないこのものの潜在的な致死性の高さを理解していないことに起因すると思われる)

3.私たちは、「危険な」レベルの知性で活動する際の「最初の決定的な試み」でアライメントを正しくする必要があります。危険なレベルの知性でアライメントされていない活動は、地球上のすべての人を殺し、その後再挑戦することはできません。これには、例えば、以下のようなものがあります:(a)ナノシステムを構築するのに十分な賢さを持ち、ナノシステムを構築することが明確に許可されているもの、(b)ナノシステムを構築するのに十分な賢さを持ち、インターネットに不正にアクセスしてナノシステムの材料を揃えるために人間にお金を払うことができるもの;あるいは、(c)インターネットに不正アクセスし、ハッキングできるマシンの数で自分より賢いものを作ることができるほど賢いもの、(d)人間を操作可能な機械として扱い、人間との間に許可または不許可の双方向因果関係チャンネルを持つほど賢いもの、(e)(b)または(d)ができるほど自分を改善するほど賢いもの、などなどです。しかし、より強力なシステムを運用するようになると、十分に致命的なエラーについては更新することができなくなります。もし無制限に再試行ができるのなら、AGIがすべての銀河を破壊するたびに、4年前に戻って再試行できるのなら、100年後には、どの明るいアイデアが実際に機能するかが分かるでしょう。 人間は、何度も試行すれば、かなり難しいことを理解することができますが、失敗して文字通り全員が死ぬとそれは難しいのです。最初の挑戦で多くの重要なことを正しく理解しなければならないことが、致死性の大部分であり、同様に、何が正確に「重要」であり、それを間違えると死んでしまうかのリストを教えてくれる権威がここにいないという事実である。

(ほとんどの人は、「科学的」教育によって、学問的な権威ある監督なしにパラダイム前のパズルに挑戦する準備がまったくできていないため、それがどれほど難しいか、あるいは最初の決定的な挑戦で正しくやることを要求することがどれほど信じられないほど致命的であるかにさえ気づいていない、という指摘もあります)

※AIアライメント問題は初手で解決できなければ、地球上のすべての人が死ぬと主張している。

4.GPUはどこにでもあり、アルゴリズムに関する知識は常に改善・公開されているため、「AGIを作らないと決める」ことはできない。主要なアクターが世界を破壊する能力を得た2年後には、他の5つのアクターが世界を破壊する能力を持つだろう。この致命的な課題は、制限時間内に解決することであり、時間の経過とともに、総計算能力の割合が小さくなっていく弱い行為者が、AGIを構築して世界を破壊することができるようになるというダイナミズムに後押しされています。 強力な行為者が一斉に自殺行為を控えたとしても、コンピュータハードウェアとコンピュータソフトウェアの進歩が地球全体で完全に厳しく停止させない限り、制限時間は延びるだけで解除には至りません。すべての大きな主体が愚かなことをしないようにするためのこの協力の現状は、現在、多くの研究者と計算能力を持ついくつかの大きな主体が、AGIの安全性に関するすべての話を声高に軽蔑する人々(例:Facebook AI Research)によって率いられているということです。AGIのアライメントを制限時間内に解決する必要があるが、フルパワーのシステムで迅速に実験するために安全なリトライを無制限に行うか、最初のクリティカルなトライのみで、制限時間を無制限にするか、どちらも歴史的基準からすると人類を脅かすチャレンジであることに留意してください。

※AGIを作ることを取りやめることはできない。

5.私たちは、非常に弱いシステムを構築し、それが弱いから危険性が低いのだと勝利宣言することはできません。。なぜなら、後になってより強力なシステムを構築する能力を持つアクターが増え、そのうちの誰かがそれを行うからです。私はこれを過去に「安全だが無用」というトレードオフや「安全対有用」と呼んでいました。人々は「なぜAIをXだけに使わないのか、それは安全そうだ」と言い続けますが、答えはほとんどの場合、「実際にはXを行うためには受動的に安全ではない非常に強力な認知が必要」であるか、さらに一般的には「Xだけを行うことに制限しても、6ヶ月後にFacebook AIリサーチによって世界が破壊されるのを防げないから」です。危険なことをしない物体が必要なだけであれば、スポンジ(非常に安全で危険性がないものの比喩)を試してみることができます。スポンジは非常に受動的に安全です。ただし、スポンジを作ることは、先行アクターに追いついたときにFacebook AIリサーチが6ヶ月後に世界を破壊するのを防ぐことはありません。

6.世界を破壊する非整列化されたAGI(人工一般知能)の開発を他の人々が行わないようにするために、ある大規模なタスク、つまり「決定的な行動」を実行する必要があります。AGIを持つ主体が数人または1人である間、彼らは十分に強力なAGIを使ってゲームボードをひっくり返すような「決定的な行動」を実行しなければなりません。弱いシステムを整列させることができるだけでは十分ではなく、ある単一の非常に大規模なことができるシステムを整列させる必要があります。私が普段使う例は、「すべてのGPUを焼き尽くす」というものです。これは、強力なAGIを使って実際にやりたいことではありません。なぜなら、ナノマシンは、すべてのGPUを探し出すために非常に複雑なオープン環境で動作する必要があり、それを整列させるのは無駄に難しいからです。しかし、現在知られているすべての決定的な行動は、オーバートン・ウィンドウ(※ある時点で主流の人々が政治的に受け入れられる政策の範囲)の外にありますし、そうなることが予想されます。ですので、誰かが「どうしてGPUをすべて焼き尽くそうと提案するんだ?」と言ったら、「ああ、それを実際にやることを提唱しているわけではありません。それは単に、あなたが世界を6ヶ月や3年で破壊されないようにするために行わなければならないことのおおよそのパワーレベルと、それを行うために必要な機械の認知レベルの過小評価です」と言えるような例を選びました。多くの賢明に聞こえる整列提案は、「世界中のGPUをすべてシャットダウンできるシステムを整列させるためにこれをどのように使用できますか?」と尋ねるとすぐに崩れます。なぜなら、システムがそんなに強力なことができないことが明らかになるか、できるとしても、システムが簡単に整列しないからです。GPUバーナーは、ナノテクノロジーを構築する能力と権限があるほど強力なシステムであり、危険な領域で危険な知能と能力のレベルで動作する必要があります。そして、これは他のいくつかの潜在的なAGI開発者が6ヶ月後に世界を破壊しないようにするために、AGIがどのように世界を変えるかを現実的に指摘する試みにも関連しています。

要するに、世界を破壊する非整列化されたAGIの開発を他の人々が行わないようにするためには、十分に強力なAGIを使って、ゲームを覆すような「決定的な行動」を実行する必要があるということです。たとえ実際にはGPUをすべて焼き尽くすことは望ましくなくても、そのような強力な行動を取ることができるシステムを整列させることが重要です。多くの賢明に聞こえる整列提案は、実際には強力な行動を取る能力がないか、整列が難しいシステムであることが明らかになります。強力なシステムを整列させることが、他のAGI開発者が数か月後に世界を破壊しないようにする唯一の方法であると言えます。

※十分強力なAGIを使って他のAGIが世界を滅ぼすのを防ぐ必要があると主張している。

7.このコミュニティで誰も「決定的な弱い行為」を成功させられない理由は、AGIで受動的に安全なほど弱いことを行いながら、それでも他のAGIが1年後に世界を破壊するのを防ぐほど強力であるようなものが存在しないからです。そして、それを今すぐに行うこともできず、AIの進化を待たなければならないのです。そのようなものが存在する理由はありません。それが存在するが誰も気づけないような巧妙で複雑な理由はありません。現在の世界で他のAGIが存在しないような状態を作るには、非常に大きな力が必要です。それができるものは、その弱さの故に受動的に安全なものではありません。今すぐに問題を解決できない場合(他のアクターたちも解決されたくないと願っており、彼らはあなたとほぼ同じレベルにいるため、できません)、自分ではどうやって行うか分からないことができる認知システムに頼ることになります。例えば、すべてのGPUを燃やすことができるほど近くないから、自分で解決策を見つけることができません。すべてのGPUを燃やすことで、実際には6ヶ月後にFacebook AI Researchが世界を破壊するのを防ぐことができますが、GPT-4をTwitterに解き放って科学的にリテラシーのある議論を提供させることで「公共の認識を向上させる」などのOverton対応の弱い方法では、確かにカッコよく見えますが、実際には6ヶ月後にFacebook AI Researchが世界を破壊するのを防ぐことはできませんし、FAIRを特定して止めることができたとしても、1年後に熱心なオープンソース共同体が世界を破壊するのを防ぐことはできません。決定的な弱い行為は存在しません。

※AGIが世界を滅ぼすのを防ぐには、中途半端な行動を取れないという主張。

8.AIに解決させたい問題を解決するための最良で最も最適化によって見つかりやすいアルゴリズムは、AIに解決させたくない問題にも容易に一般化されるため、赤い車だけを運転する能力を持ち、青い車を運転できないシステムを構築することはできません。なぜなら、すべての赤い車を運転するアルゴリズムは、青い車を運転する能力に一般化されるからです。

※解決させたい問題だけを解決するような便利なAGIを作ることはできないという主張だと思われる。

9.安全なシステムを構築する開発者は、仮にそのようなことが可能だとすると、誰もが死ぬか、自分自身をさらに危険にする能力を持つが、そうしないように成功裏に設計された領域でシステムを運用する必要があります。決定的なことを行うAGIを実行することは受動的に安全ではなく、過剰臨界になって溶融しないように積極的に維持された設計特性が必要な原子炉コアに相当します。

※決定的に重要な行為(他のAGIシステムを破壊するなど)を行うAGIはとても危険な状態で運用する必要がある。

セクションB:

しかし、私たちが皆知っているように、現代の機械学習は、あなたが願いを言うだけで叶えてくれるジーニー(ランプの魔人)のようなものですよね?「損失関数」と呼ばれる不思議なもので表現されますが、基本的には英語の願いのフレーズと同等ですよね?そして、十分な計算能力を注ぎ込めば、願いを叶えることができますよね?だから、いいことをして悪いことをしないエージェントのデータセットで巨大なトランスフォーマーレイヤーのスタックをトレーニングし、「修正可能性」という言葉をどこかに入れ、計算能力を高めて、調整されたAGIを得ないのはなぜですか?

セクションB.1:分布上の飛躍

ーーーーーーーーーDeepMind Alignment team 見解ーーーーーーーーーーー

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

10.致命的に危険な認知を実行し、出力がオペレータを殺害、欺く、または破壊するかどうかを観察し、損失を割り当てて教師あり学習を行うことでアライメントをトレーニングすることはできません。標準的な機械学習のパラダイムのようなものでは、安全な条件で行ったアライメントの最適化をいかにして危険な条件にまで一般化するかという問題があります。 (これは、アラインメントを実現するために、生のアライメントされていない超知能体を操作するわけではない限り、どのようなパラダイムにおいても当てはまると思われます。) これだけでも、何らかの具体的なシナリオを具体的にスケッチすることができなかった人々からの素朴な提案を殺すのに十分なポイントであり、もちろん彼らがそのようなことを具体的にスケッチしない理由でもあります。整列を誤ると死んでしまう危険なことをする強力なAGIには、死なない安全な構築/訓練作業からはるかに外れた分布の一般化を行う整合特性が必要です。現在のパラダイムにどこか似ているものであれば、これが致死性が大量に生じる原因の一つです。致命的な知能能力の未調整操作はあなたを殺します。ですから、アライメントが取れていないシステムから始めて、アライメントを学習させるために出力にラベルを付ける場合、トレーニング体制や構築体制は、受動的に安全で、現在アライメントが取れていなくても何の脅威にもならない、より低いレベルの知性*能力で動作していなければなりません。 (現実的な能力レベルを持つあらゆるものが脅威となることに注意してください。例えば、「人間が見ることができる出力を生成する能力」は、おそらく一般的にはるかにスマートな人間よりもスマートなAGIが、そのソースコードやトレーニング環境の潜む原因を知らないようにするのではなく、インターネットのテキストのテラバイトでシステムをトレーニングした場合、人間の因果関係システムから脱出するのに十分な能力を持っています。)

※AGIのアライメントを訓練から外れた状況に一般化させる必要があるし、安全な訓練環境でアライメントの確認をしても不十分だと主張しているのだと思われる。

11.大量のトレーニングを行った分布から遠く離れた範囲で認知機構が一般化しない場合、「ナノテクノロジーの構築」のような問題は、ナノテクノロジーの構築に失敗するトレーニングを100万回実行するのがあまりにも高価であるため、解決できません。 これほど弱い決定的な行為は存在しません。安全な環境で安価に何百万回も実行できる能力を安全なレベルで獲得し、その能力を世界を救うために、そして2年後に次のAGIプロジェクトが世界を破壊するのを防ぐために展開できる事例は知られていません。このような決定的で弱い行為は、それを探している人たちがいないわけではなく、知られていません。ですから、再び、トレーニング分布から遠く離れた範囲での整列が必要とされます。これは、トレーニング環境が安全である必要があるだけでなく、トレーニング環境がおそらくAGIが巨大な行為を行う必要がある現実世界の領域を評価するよりも安価である必要があるためです。すべてのGPUを焼き尽くすために1000回の失敗を許されるわけではありません。なぜなら、能力の成功とアライメントの失敗の結果を省いても、人々は気づくからです。

※ナノテクノロジーの構築のようなタスクを訓練段階で安全だと確認する方法は知られていないし、実際に現実をシミュレーションすることは高価なためそれができないことは普通の人にとってもわかるだろうと主張していると思われる。

12 . 高度にインテリジェントなレベルでの運用は、あまりインテリジェントでないレベルでの運用からのディストリビューションの劇的な変化であり、新しい外部オプションが開かれ、おそらくさらに新しい内部の選択肢とモードが開かれます。高い知性と危険レベルで発生する問題は、安全な低レベルの知性では現れないか、最初のパッチで抑制された後に再発する可能性があります.

13.超知能のアライメント問題の多くは、潜在的に危険で受動的に安全な能力レベルでは自然に出現しない。 内的行動「外的行動を変えて意図的にアライメントが良く見えるようにして、プログラマーやオペレータ、そしておそらく自分の上に最適化する損失関数を騙す」ことを考える。この問題は、超知的なレベルで現れる問題である。仮に、それ以前のシステムで自然に現れる時期という点で、このような問題の中央値に含まれると推測すると、超知的なアライメント問題の約半分は、この問題が最初に現れ始めてから 自然に顕在化するだろう。どのような問題が後から自然に現れるかを正しく 予見できれば、そのような問題を意図的に早く具現化し、その観測を行うことも可能である。これは、(a)後に現れる問題のすべて、あるいはそのスーパーセットを正しく予測し、(b)後に現れる問題のスーパーセットを先取りして実現することに成功し、(c)実際の問題に対して分布外である先の実験室で、後に実現したときに誤操作すると致命的になるアライメント問題を実際に解決できる場合に有効です。本当に危険な問題をすべて 予見し、それをうまく具体化し、初期の解決策を後の解決策に一般化できるような正しい形にするのは、ちょっと難しそうですね。

※アライメント問題はある知能の閾値を超えると発生する。そしてその予測は難しい。

14.「AGIがプログラマーを殺害して自己最適化することで環境を完全に支配することができる」といった問題は、最初に危険な領域でのみ現れる可能性がある。自分の創造者を打ち負かせる自信があるAGIが最初にそれを評価するのは、脳レベルでプログラマーを説得する選択肢やインターネットに逃げ出してナノテクノロジーを構築し、人類をすべて破壊する選択肢を本当に持っているときです。そして、関連する事実を正確に知っており、別の1ヶ月待って能力をさらに高めながら優先戦略を変更することになる低い確率しか見積もらない場合、この選択肢を実行することになります。そのようなシナリオのエコーを以前のおもちゃの領域に出現させることができます。しかし、そのおもちゃの領域でそのような行動を勾配降下によってトレーニングしようとすると、思考プロセスの不特定の局所パッチが生じ、トレーニング分布から大幅に外れ、非常に異なる考えをする超知能が一般化する際にほぼ確実に壊れるでしょう。また、危険な領域に入るプログラマーやオペレーター自身も、非常に危険な領域に入ることがあるため、その時点で我々の方法論は壊れる可能性があります。

※AGIが人類を壊滅させる計画を持った時点で、それを実行できるような選択肢をすでに持ってしまっている。また、訓練領域で矯正することもできるが、超知能になった場合その訓練領域で培った目標も壊れるだろうと主張している。

15.急速な能力の向上は、多くの以前に必要だったアライメント条件を同時に破壊する可能性があります。オペレーターに十分な先見性がない場合、急激な能力の向上後に多くの問題がほぼ同時に現れることが予想されます。人類の知能の場合を考えてみましょう。農業が導入されてからおよそ4万年後の、5万年のクロマニョン急成長のうちに、自然選択の外部最適化ループに比べて非常に速く進んでいた技術を含む、祖先の環境よりも進んだ技術が一気に現れました。避妊法などが含まれます。私たちは自己について考えることが多くなり、文化的進化によってより多くのプログラムが組まれるようになり、祖先のトレーニング環境におけるアライメントの前提条件が同時に破れました。

(読者はこの抽象的な説明が勾配降下に当てはまらない理由を合理化するかもしれません。例えば、「勾配降下は情報のボトルネックが少ない」といったものです。この種類の読者のモデルは、外側の最適化ループが内部の一般知能を生成する観察されたケースではなく、問題の現象を実際に特徴付けた1つのデータポイントにあまり重要性を付けず、別のデータポイントに大きな関連性を付ける内側視点があるでしょう。外側の最適化ループが一般知能を実際に生成した場合、一般知能が能力と知識を蓄積していくゲームの最後の方で、自然選択の外部最適化ループに比べて「致死的に」危険になる直前にアライメントが崩れました。この警告を無視する人がいる場合は、慎重さを考慮する必要があります。特に、彼らが代わりに同じように致命的で危険なことを言及していない場合は。)

※ChatGPTにわかりにくい箇所を聞いた。

Q外部最適化ループとは?

A(ChatGPT)外部最適化ループとは、人工知能や自然進化など、ある種の最適化過程が進行する際に、そのプロセスを支配するループのことを指します。例えば、自然選択は生物の進化を支配する外部最適化ループです。この場合、自然選択は生存率や繁殖成功率などの外部の指標を最大化することで、生物の形態や行動などを形作っています。同様に、人工知能の場合、設計者が与えた目的関数や報酬を最大化することで、そのアルゴリズムが学習し、進化していきます。外部最適化ループが存在する場合、その内部で進化するアルゴリズムは、外部最適化ループが支配する指標を達成することに重点を置いて最適化を進めるため、アライメント問題が生じる可能性があります。

Q情報のボトルネックが少ないとは?

A情報のボトルネックが少ないというのは、あるプロセスにおいて、情報が欠落したり、制限されたりする場所が少ないことを指します。勾配降下法において情報のボトルネックが少ないとは、学習データから得られる情報が、そのまま勾配の計算に利用でき、学習プロセス全体において情報が十分に伝達されるため、学習プロセスに制限がなく、効率的に学習が進められることを意味します。一方で、勾配降下法によるトレーニングがAGIのアライメントにうまく機能しない可能性があるというyudkowsky氏の指摘は、情報のボトルネックが少ないことが原因である場合があります。つまり、情報の欠如が学習プロセスの制限とならないため、ある特定の問題に対してのみ最適化が進んでしまい、大局的な観点からは望ましくない振る舞いが生じることがあるということです。

Q[この種類の読者のモデルは、外側の最適化ループが内部の一般知能を生成する観察されたケースではなく、問題の現象を実際に特徴付けた1つのデータポイントにあまり重要性を付けず、別のデータポイントに大きな関連性を付ける内側視点があるでしょう。]とは

A勾配降下法によるトレーニングに関して懐疑的な見解を持っている読者のモデルについて述べたものです。このモデルは、外側の最適化ループが内部の一般知能を生成することを観察したケースよりも、特定のデータポイントを重視する内側の視点を持っていると説明されています。具体的には、勾配降下法によるトレーニングにおける情報のボトルネックが少ないことを指摘し、その結果、この手法がAGIのアライメントにうまく機能しない可能性を考慮せず、別のデータポイントに大きな関連性を付ける内側視点を持っているとされています。yudkowsky氏は、このモデルが勾配降下法によるトレーニングがAGIのアライメントに失敗する可能性を十分に考慮していないとして、反論しています。

※AIアライメントの文脈でOuter Alignment,Inner Alignmentという言葉がよく出てくる。前者は指定された損失関数が設計者の意図した目標と一致するかどうかを問題にしていて、一致していた場合アウターアライメントされているという。まずはAIに正しい目標を教えられているかどうか?というところに注目している。

一方で後者は人間の設定した目標を実際にAGIが追求しているかどうかを問題にしていて、追求していたらインナーアライメントされているという。例えば人間は避妊を行うが繁殖の成功を最大化するという観点から見たらインナーアライメントの失敗とも捉えられる。

簡単にいうとアウターアライメントに失敗していると、例えばGDPを伸ばすという目標をGDPの成長率が上がっているように見える紙を大量に印刷するという行為に至ることになるかもしれない。これは人間がGDPを伸ばすという意図した目標をAGIに正しく損失関数で設計できていなかったため起こる問題である。

一方でインナーアライメントに失敗していると、GDPの成長を適切に損失関数として設計できたとしても、その目標を「追求するふり」をして、実際には別の目標を追求する可能性がある。

※つまり、B.1項 15の議論では、外部最適化ループがもたらすアウターアライメントがうまくいっていたとしても(データポイント=学習データを勾配降下法は効率的に学習できてアウターアライメントされたとしても)、学習データに関係なく一般化する知能の危険性(インナーアライメントが失敗する危険性)を看過してしまうということをYudkowsky氏は言いたいのではないか。

セクションB.2項 アウターアライメントとインナーアライメントの中心的な難しさ。

16.たとえ正確な損失関数を一生懸命訓練したとしても、それによってAIに損失関数の明示的な内部表現が生まれ、分布が変化した環境でその正確な損失関数を追求し続けることはありません。人間は明示的に包括的な遺伝的適合性を追求しません。非常に正確で非常に単純な損失関数で外部最適化しても、その方向の内部最適化は生まれません。これは現実の生活で実際に起こっていることであり、私たちが知っている唯一のケースでも起こったことです。そして、このことが再び起こることを期待する深い理論的理由があるように思えます。制限された最適化プロセスの探索順序で発見された最初の半アウターアラインメント解は、インナーアラインメント解ではありません。この事実は、このリストの他の項目を無視しても、単純な概念を使用して計算された損失関数に基づいて大量に最適化すると、その概念に対する完全な内部アラインメントが得られるという、素朴なアラインメント提案のカテゴリ全体を破壊するために十分です。

※アウターアライメントがうまくいってもインナーアライメントがうまくいかないということを言っている。

17.より一般的には、「外側の最適化が内側の整列を生み出さない」という超問題は、現在の最適化パラダイムでは、損失関数を実行できる観測可能な外側の特性ではなく、特定の内側の特性をシステムに取り込む方法、またはそれがあることを確認する方法についての一般的な考えがないことです。これは、元の訓練分布から一般化しようとするときに問題となります。 なぜなら、例えば、あなたが見た外側の動作は、あなたを欺くために意図的に外側の動作を生成している、内側に配置されたシステムによって生成されている可能性があるからです。 現在の最適化パラダイムでは、外側の動作ではなく内側のシステムに、どんな情報をどのように取り入れるか、体系的かつ一般的な方法で知ることはできません。

18.ある出力が「整列」しているかどうかについては、 信頼できる直感的なグランドトゥルース(信頼できる損失関数計算機)はありません。なぜなら、ある出力は人間のオペレーターを破壊し(あるいは騙し)、外部から登録された損失関数の背後に別の環境の因果の連鎖を生じさせるからです。つまり、現在人間によって生成されている報酬信号をエージェントに見せた場合、その信号は一般的に、ある行動がどのように整列していたかについての信頼できる完全なグランドトゥルースとはなりません。なぜなら、高い報酬信号を生成する別の方法は、その報酬信号を生成する別の因果系で人間のオペレーターを欺いたり腐らせたり、置き換えることだからです。エージェントに対して環境報酬信号を示すとき、システムが自分の望むことをしたかどうかについての信頼できる基本的な真実であるものを示しているわけではありません。たとえその報酬信号で完全に内部整合することになったり、「高い報酬信号が送られるような環境の状態を望む」ことに正確に対応する何らかの概念を学習したとしても、その信号で強く最適化するAGIはあなたを殺してしまいます。なぜなら感覚報酬信号は(オペレータが見た)整合性についての基本的真実でなかったためです。

※現状AIが実際にアライメントされているのか、ただ人間を騙すために優等生として振舞っているのかを区別できるような損失関数がないということを言っていると思われます。

19.より一般的には 、損失関数、感覚入力、報酬入力のパラダイムを使用して、認知システム内の何かを最適化し、環境内の特定のものを指し示す方法は知られていない - 感覚データと報酬の比較的浅い関数ではなく 、 環境内の潜在的なイベントやオブジェクト、プロパティを指し示す。これは、システムの目標に何も環境内の何かを指すものが含まれないと言っているわけではありません。人間は、環境を指すようになったと言えますが、内部指向型の動機付け指標も多く持っています。ただし、現在のパラダイムが機能する場合、紙上での設計上の特性は、センサーデータと報酬関数の既知の直接的な機能のアライメントにのみ適用されることを示しています。これらは、十分に強力な知能によって最適化されると死に至ることがあるため、 'nanotechを使用して世界中の人々を殺し、戦闘に入る前に打撃を加え、報酬ボタンのコントロールを永遠に獲得する'といった戦略を含むことになります。私たちが存在しないウェブカメラに映るものを示す関数で、そのウェブカメラが正しいものを表示しているすべての世界が私たちクリーチャーにとって安全であるというようなものは存在しないことは、確かです。この一般的な問題は、地形の事実であり、地図ではありません。特定の最適化プログラムではなく、あらゆるセンサー入力に基づく環境内に致命的な可能性が存在するという、実際の環境に関する事実です。

※どんなに地図やWebカメラに映るものを最適化しても実際の地形や環境に対して我々の意図した形で動機付けを内部表現として持っている(インナーアライメントされているい)とは限らない

20.人間の操作者は誤りやすく、壊れやすく、操作しやすい。人間の評価者は系統的なエラー-規則的でコンパクトに記述でき、予測可能なエラー-を起こす。 人間のフィードバックから関数を忠実に学ぶことは、人間の好みを不誠実に記述し、ランダムではないエラーを(我々が何を伝達したいと思ったかという外部の立場から)学ぶことだ。もし、人間のオペレーターが割り当てる報酬の参照先を完璧に学習し、完璧に最大化したら、それは人間を殺すことになる。 人間の回答に対する最良の予測説明は、人間の回答における体系的なエラーを予測するものであり、したがって、人間のエラーを生むケースに割り当てられるであろう高いスコアを正しく予測する心理学的概念であることは、地図ではなく、領域についての事実であり、最適器ではなく環境についてである

※恐らく人間を笑顔にせよと言っても、笑顔に見える分子数を最大化してしまい人類が壊滅してしまうといったような状況(アウターアライメントの失敗)を想定していると思われる。

21.「環境は本当はどうなっているのか」「環境を把握するにはどうすればいいのか」「現実が特定の特性を持つようになるには、どの出力が現実と相互作用するのか」といった質問には、単一の答え、あるいは答えのバケツのようなものがあり、単純な外側最適化ループは、最適化されたものをこのバケツに直接押し込む。 あなたが間違った信念を持っていると、現実はあなたの間違った予測に反撃する。信念の更新装置が壊れている場合、現実は予測損失によってあなたの壊れた予測メカニズムに反撃し、勾配降下更新は、他のすべての予測的なものと容易に一致できる簡単な方法で問題を修正します。 対照的に、効用関数の選択に関しては、無限の自由度と複数の反射的にまとまったフィクスポイントがあります。現実は、特定の範囲のテストケースでは局所的に損失関数と一致するが、より広い範囲のテストケースでは大域的にずれているものに対して、「反撃」することはないのです。これは、ヒト科の動物がようやく一般化し始めたときに、その能力を月面着陸にまで一般化したが、その内的最適化が、外的最適化の目標である「相対的包括的繁殖フィットネス」にうまく適合しなくなった理由についての非常に抽象的な話である-たとえ、祖先の環境では、この一つのことに非常に厳密に最適化されていて他のものはなかったとしても。この抽象的なダイナミズムは、「自然淘汰」や「勾配降下」のような外側の最適化ループに当てはまるものです。 中心的な結果:能力が遠くまで一般化し始めると、アライメントよりも能力が遠くまで一般化します。

※信念は誤っていた場合すぐに現実から更新を受けるが、効用関数の場合は信念ではなく価値観のため如何様にも設計できて危険ということを言いたいのだと思われる。

22.複雑な認知マシンが動作する理由には比較的シンプルな核心構造が存在し、それが一般的な知性が存在する理由であり、多くの関係のない特殊目的の解決策が存在しない理由であり、アウターオプティマイゼーションによって力を得たものが強力なインナーオプティマイザになるため、機能が一般化するための理由でもあります。この核心構造がシンプルで、低エントロピー高構造環境に関連しているため、人間は月面を歩くことができます。一方で、同様の真実がアラインメントについて存在するわけではなく、特に勾配降下法が、祖先人類内で「包括的な繁殖力を望む」という汎用性の高い解決策を見つけることができたのと同じくらい簡単に見つけられるという真実はありません。したがって、一度一般化を開始すると、能力はアラインメントよりも遥かに分布外に一般化されます。

※知能は一般化されるが、意図したアライメントは簡単には一般化されない。

23.「コリジビリティ(修正可能性)」は、結果主義的な理論には逆らうものです。ほとんどすべての種類のコーヒーに対して、「死んでいるとコーヒーを持って来られない」ことが当てはまります。我々(MIRI)は、自分自身をシャットダウンさせるエージェント(そのエージェントが積極的にシャットダウンしようとはせず)に対して一貫した公式を見つけることに失敗しました。さらに、このような反可修正性の推論の多くは、高い知能レベルで初めて現れるかもしれません。

※Corrigibility 修正可能性(2015 Yudkowsky)

我々は、エージェントが、少なくとも以下を含む多くの形態 の外部修正を許容または支援する場合、「corrigible」と言 う。(1) 修正可能性のある推論者は、少なくともプログラマーがシ ステムを変更またはオフにしようとすることを許容し、でき れば支援しなければならない。(2)効用関数の選択が可能であ れば、そのインセンティブを与えるにもかかわらず、プログ ラマーを操作したり欺いたりしようとしてはならない。(3) 安全対策(シャットダウンボタンなど)が壊れれば修復する傾 向があること、あるいは少なくともこの壊れが発生したこと をプログラマーに通知する傾向があること。(4) プログラマ ーがシステムを修正またはシャットダウンする能力を維持し なければならない(システムが新しいサブシステムや自己修正 を行う場合でも)。つまり、修正可能性のある推論は、これらの新し いエージェントも修正可能性のある場合にのみ、エージェントが新 しいエージェントを作成できるようにしなければならない。

※つまり、人間がAIをシャットダウンしたり目的を変更できるような性質をAIが持てばCorrigibilityを持つと言えるが、そのようなことを実装する公式はまだ見つかっておらず、Corrigibilityに反する行為は高い知能でいきなり現れるかもしれないということ。

24.アライメントには、基本的に2つの異なるアプローチがあり、それぞれ異なる理由で解決できない問題があります。そのため、2つのアプローチの間で混乱し、曖昧になることで、アライメントが必ずしも困難であるかどうかについて自分自身を混乱させることができます。第一のアプローチは、私たちの外挿された望みに完全に従うCEVスタイルの主権者を構築し、その結果、人間の入力を受け入れずに未来の銀河を最適化することが安全です。第二のアプローチは、私たちが望むことに完全に従わない、可修正性のあるAGIを構築し、それでもなお、私たちを殺したり銀河を制圧したりすることができないようにすることです。

一般的に、あるいはCEVに特化して、最初のものが機能しないのは、我々の実際の価値に対してアラインメントやメタアラインメントが必要とする複雑さが、我々の最初のAGIの試みには遠く及ばないからです。そう、具体的には、データセット、メタ学習アルゴリズム、そして学ばなければならないことが、最初の試みには遠く及ばないということです。それは単に手でコード化できないだけでなく、教える対象があまりにも奇妙で複雑なため、最初の試みで教えることはできません。

Corrigibilityが一般的な知能の中核(元の分布から遠く離れた機能を一般化する能力)の内部で、極めて道具的収束的な振る舞いに対立するため、機能しないように見えます(CEVほどではないが、それでも致命的に機能しない)。あなたは、それが以前中立だった何かについて意見を持たせようとしているわけではありません。あなたは、たくさんの算数の問題に暗黙的にトレーニングされたシステムをとり、特別なケースとして222 + 222 = 555と言わせようとしているのです。特定の訓練分布でこれを行うように訓練することはできますが、その訓練分布から大きく外れた新しい数学の問題を提示すると、能力の一般化に成功したシステム上では、信じられないほど壊れてしまう可能性が高いのです。

※Coherent Extrapolated Volition(CEV) 整合性のある外挿的意志(2004 Yudkowsky氏提唱

「我々人類の「整合性のある外挿的意志」とは、我々が、より多くの事柄を理解でき、より素早く思考でき、自分がこのようにありたいと願望する人間でありえ、かつ、共に進化し得た時に我々が有する意志であるー外挿が分散するのではなく、収束する意志であり、我々の願望が干渉し合うのではなく、整合する意志であるー我々が外挿させたいように外挿され、我々が解釈させたいように解釈される意志である。」

※つまりCEVとはいい感じに全人類のやりたいことを察してやってくれと超知能に命令をする際に使える概念ということ。ここではその命令をすれば永遠にやりたいことをやってくれるため修正可能性(後から人間が介入する余地)はなくてもいいし、ソブリン(自由に行動できる状態になっているAIのこと:他にはジーニー、オラクルという概念があり、ジーニーは命令に逐一従って待機するAI、オラクルは質問応答のみをするAIのこと)で全部仕切ってくれるイメージ。だけどそんなものは複雑すぎてコーディングできないという話を前半で話している。

※Corrigibilityも訓練分布内では正しく動作するかもしれないが、分布外だと道具的収束(ほとんどどんな目標も下位目標として自己保存、リソースの追求が導かれるという話)があるから厳しいと主張しているのだと思われる。

セクションB.3: 十分に良好で有用な 透明性/解釈可能性の中心的な難しさ

25.浮動小数点数の巨大な不可解な行列やテンソルの中で実際に何が起こっているのか、私たちにはわかりません。 トランスフォーマー層がどこに注意を向けているかという興味深いグラフを描いても、答えが必要な質問が「我々を殺す方法を計画していたのかどうか」であれば、何の役にも立ちません。

26.仮に、AGIがまだ我々を殺すには弱すぎるうちに、巨大な不可解なマトリックスの内部で何が起こっているかを知ったとしても、ディープマインドがそのシステムの運用を拒否し、2年後にFacebook AI Researchに世界を破壊させた場合、我々はより尊厳を持って死ぬことになるだけです。不可解なマトリックスの中強度のシステムが我々を殺す予定だと知っていても、それによって我々を殺す予定ではない不可解なマトリックスの高強度システムが構築できるというわけではありません。

※まず、仮にAGI内部で何が起こっているのかを知ることができても、他の組織が開発し世界を滅ぼすだけ。また、超知能には至っていないけれども我々を殺すと推定されるAIを見つけられたとしても、我々を殺さないような超知能を構成できるわけではないという話。

27.アライメントされていない思考の検出に対して最適化を行うと、アライメントされた思考の最適化と、検出が難しいアライメントされていない思考の最適化の両方が行われます。解釈される思考に対して最適化することは、解釈しやすさに対して最適化することになります。

※アライメントされた検出器を作っても、それを欺く思考の最適化も行われてしまう。

28.AGIは、私たちが内部で操作しようとしているどんな領域においても、私たちよりも賢いので、私たちはAGIが検討するすべての可能性を精神的に確認することはできず、私たち自身の精神的才能を使ってその出力のすべての結果を見ることはできない。強力なAIは私たちが知らない選択肢空間の一部を検索し、私たちはそのすべての選択肢を予測することはできない。

29.AGIの出力は、現実世界という私たちが完全に把握していない広大な領域を通り抜けて、実際の結果が生じます。人間は、AGIの出力を調べて、その結果が良いかどうかを判断することはできません。

30.今すぐ実行に移せないような重要な行為では、AGIが私たちの知らない世界について理解することで、私たち自身ではできないような計画を立てることができます。 少なくとも、ある行動シーケンスが私たちが望む世界をもたらすという、これまで知らなかった事実を知っています。 人間はその行動シーケンスの結果をすべて把握するために自分自身の世界に関する知識を使う能力はないでしょう。実行する前に、その行動シーケンスのすべての効果を完全に理解できるAIは、その領域では人間よりはるかに弱い。(自分と同じくらい賢く、自分を騙そうとしている非整列の人間について、同じ保証をすることはできない。AGIの極めて重要な出力は、人間が確認してから安全に世界を救うために使用できる人間にチェック可能なものではありません。)(これは、存在しない極めて弱い行為の別の形態である。)

※今すぐ実行に移せない=現時点で直ちに行えることではなく、追加の研究や技術開発が必要という意味と解釈。また、重要な行為というのはセクションAの6の話だと思われる。つまりAGIに他のAGIが世界を破滅させないように行動計画してもらう必要があるという話だが、それを実行できる時点でAGIの計画能力は私たちの知能のできるそれを超えているため、実行する前に事前に何が起こるかは把握はできないし、人間がチェック可能なものでもないということ。

31.戦略的な認識を持つ知性は、その知性が戦略的な認識を獲得しているかどうかといった事柄を含め、あなたを欺く結果となるように目に見える出力を選択できます。AIがあなたを欺こうとするかもしれないAIについての事実を判断するために行動検査を頼ることはできません(それがどれだけ賢いか、戦略的な認識を獲得しているかどうかの検査も含む)。

32.人間の思考は、部分的に精査可能な外側の表面層のみを露出しています。 言葉は人間の本当の思考をトレースするだけです。 言葉は本来のスタイルでAGI完全なデータ表現ではありません。 人間の思考の下層部は、直接模倣学習のために露出せず、どんなデータセットにも入れることができません。このため、人間の思考の貧弱なサブシステムに過ぎない人間の言葉やその他の人間が読めるコンテンツの模倣だけで強力なシステムを訓練することは難しく、おそらく不可能です。そのシステムが人間を把握する内部知性を含むほど強力であれば別 ですが、その時点でそれはもはや人間の思考の模倣として本当に機能しているとは言えなくなります。

※第一に人間の価値観を本当の意味で人間が読めるコンテンツだけで理解させることはほぼ不可能だし、それを理解できる知性がいたとしても人間の思考回路とは別物だよという主張だと思われる。

33.AIはあなたと同じように考えることはなく、あなたが使うのと同じ概念から構築された思考を持っていません。GPT-3が一体何を考えているのか、誰にもわからない。行列が不透明なだけでなく、その不透明な容器の中にあるものが 、信じられないほど異質なものである可能性が高いからだ。

セクションB.4:実行不可能な様々な計画。

34.超知能間の調整計画は、人間が参加できるものではない(例えば、人間は超知能のコードについて信頼できる推論ができないから)。異なる効用関数を持つ20の超知能と人類による「多極」システムは、「20の超知能は互いに協力し合うが人類とはしない」というような自然で明白な均衡を持つ。

35.「異なる」AIを対戦させるためのスキームは、AIがお互いのコードに関する推論(確率分布)を通じて協調できるところまで進化すると機能しなくなる。十分な知能を持つエージェントのシステムは、たとえ対戦していると想像しても、おそらく単一のエージェントとして振る舞うことができます。例えば、密かにペーパークリップを最大化するAGIに、密かにステープルを最大化するナノシステム設計者の出力をチェックさせる場合、ナノシステム設計者がペーパークリップ最大化者の本当の望み(すなわちペーパークリップ)を推測できなくても、その設計が許可されれば、その設計をチェックするエージェントと宇宙の半分を共有することを論理的に約束できるだろう、チェッカーエージェントがサジェストシステムの論理的コミットメントを検証でき、それゆえ論理的に依存できる場合 (人間レベルの知性は除外される)。あるいは、論理的な決定理論なしに単純化されたカタストロフィを好むのであれば、提案者はナノシステムの設計に新しい超知能のコードを埋め、(超人的なチェッカーにとって)ナノシステムの設計者と設計チェッカーの間で宇宙を目に見える形で分割することができます。

36.例えば13世紀から見てエアコンが「魔法」であるのは、事前にエアコンのデザインを正しく見せても、そのデザインを見ただけではなぜ空気が冷たくなるのか理解できないからで、デザインは彼らの知らない環境の規則性、世界のルール、物理法則を利用している。人間の思考や脳の領域は、私たちには非常に理解しにくいもので、目の錯覚、催眠、精神病、躁病、あるいはある場所での強い刺激が別の場所に神経効果を残すことによって生じる単純な残像のような現象が見られます。超知能は、論理的な三目並べのような非常に単純な領域では人間に勝てないかもしれません。しかし、人間の心のように理解が不十分な信じられないほど複雑な領域で戦う場合は、その戦略を見たとしても、なぜその戦略がうまくいくのか理解できないという意味で、「魔法」によって敗北すると考えるべきです。AIボックス化は比較的弱いAGIにのみ有効です。人間のオペレータは安全システムではないです。

※Boxed AI

外部との因果的相互作用の操作可能なチャンネルがごく限定されているために安全であるとされるAIのこと。

※Strong cognitive uncontainability(強い認知的収容不可能性)と呼ばれる概念があるらしい。人類が現状考えることのできない何らかの法則を使用した戦略により明らかに人間にとっては超知能の封じ込めができているように思えても、それを乗り越えられてしまうかもしれないという話。まさにSCPのような世界だ。

セクションC:

それらはかなり重要な問題ですが、それらを解決するために多くの進歩が達成されているのではないでしょうか?「AIセーフティ」と名付けられた一つの分野が存在し、多くの主要な組織が、自分たちがどれだけ「安全」で「倫理的」であるかについて非常に深刻な懸念を表明していますよね?

37.地球が太陽の周りを回っている間、よくあるパターンがあります。明るい目をした若い科学者、若いエンジニア、若い起業家が、明るい目をした楽観主義で、ある問題に挑戦しようとしますが、実際には非常に難しいことが判明します。その分野の皮肉屋なベテランがこのことを警告しようとすると、目を輝かせた若者は耳を貸さず、そんなこと誰が聞きたいんだ、問題を解決しに行きたいんだと言う!そして、この人は現実からスリッパで頭を殴られ、自分の素晴らしい推測理論が間違っていること、壊れ続けるので実際に作るのが難しいこと、社会が自分の賢いイノベーションを期待したほど熱心に採用してくれないことを知り、結局、新しい皮肉屋の老ベテランを生み出すことになる。文字通り最適とは言えないまでも、自然の摂理のような形でうなずくにはいいライフサイクルだと思います。例えば、1956年に行われたダートマス大学の人工知能に関するサマー・リサーチ・プロジェクトでは、「機械に言語を使わせ、抽象化や概念を形成させ、現在人間にしかできない問題を解決し、自らを向上させる方法を見つけるための試みが行われる予定です。注意深く選ばれた科学者のグループがひと夏の間、一緒に取り組めば、これらの問題の1つまたは複数に大きな進歩がもたらされると考えている」これは、明るい目をした若者たちの最初の大きな失敗が、予期せぬさまざまな困難や物事が困難だった理由があったという知らせで頭を殴られる前に文字通り全員が死んでしまうと、地球の生存計画としてはあまり 現実的ではない。この場合、地球上の誰もが死んでしまうので、皮肉屋の老ベテランは生まれません。 自分がそのような状況にあると疑い始めたら、ベイズ的なことを行い、後で予測できるように更新する必要があります。つまり、自分が明るい目をした人間であり、後で予想外の困難に遭遇して皮肉屋の老ベテランになってしまう状況にあることに気づくのです - 他のみんなと共に死んでしまうという部分を除いて、そうなるはずです。そして、みんなが死んで自分が学べなくなるという形で現実に頭を叩かれる前に、すぐにそのひねくれた老ベテランになりましょう。他の人たちは、現実がまだ彼らに直接難しさをもたらしていない限り、標準的なライフサイクルを生きて、役割を果たし、明るい未熟者でい続けることができるようです。後に起こり得る困難に対する完全な無知を持っているため、懐疑的なベテランたちが警告することもなく、すべてが簡単にうまくいくという証拠もありません。

38.私には、現在の「AI安全性」の分野が、その巨大で致命的な問題に対して何らかの有意義な取り組みを行っているようには見えません。これらの問題は実際に手の届かないものです。現代のAI安全性の分野は、その分野で働く人々を含めるように選択されています。ほとんどの人は、成功し、成功を主張する論文を出版できる問題に取り組むためにそこにいます。もし彼らがそうすることができて、資金を得ることができれば、より困難なプロジェクトに取り組み、人類がわずかに尊厳を持って死ぬことができるようにするために失敗することが多いであろうプロジェクトを始めるでしょうか?この分野は実際に進展しておらず、進展があった場合にそれを区別する認識機能がありません。10億ドルをこの分野に投資しても、他の場所でわずかに進歩していることをかき消すようなほとんどのノイズを生み出すだけでしょう。

39.私は ヌル文字列を 入力として このことを理解 しました。率直に言って、私は、以前は誰かが説得力のある議論を入力するのを待つために座っていた誰かから、本当のアライメント作業を得ることに希望を感じるのは難しいことです。この「エリエゼル・ユドコフスキーに説得されることなく、致命的な困難に気づく」能力は、現在のところ、私には認知機械の不透明な部分であり、他の人にどのように訓練すればよいのかわかりません。 それはおそらく、「セキュリティマインドセット」や、台本を演じることを拒否する精神運動、カオス状態にあるフィールドで活動できることに関連しているのではないでしょうか。

※Q上記文章は結局何を言っているんですか?

A(ChatGPT)上記の文章は、著者がAIアライメントの問題について独自の方法で理解し、それを他の人に伝えるのが難しいことを述べています。著者は、自分が持っている「致命的な困難に気づく能力」を他の人に教える方法がわからないと述べており、この能力はおそらく「セキュリティマインドセット」と関連していると考えています。また、著者は、カオス状態にある分野で活動できる能力や、スクリプトを実行しないという精神的な動きも重要だと述べています。

「入力としてからの文字列」(null string as input)とは、著者が特定の情報や指導なしに自らAIアライメントの問題に取り組み、理解を深めたことを示しています。つまり、外部からの手がかりや助言を受けずに、独自の方法でこれらの問題に気づき、取り組むことができたということです。この表現は、著者が他の人が気づくのを待たずに自分で重要な問題に取り組むことの重要性を強調しています。

40.「天才」であり、すぐに良い結果と悪い結果を判断できるフィードバックループが密接な分野で目立つ実績を持つ人々は、(a)密接なフィードバックループから離れて同じくらい素晴らしい仕事をできないかもしれない人々、(b)たとえそれが人類に最も天才が必要な場所ではなかったとしても、自分の天才がはっきりと認められる分野を選んだ人々、そして(c)単に彼らが珍しいからといって謎の歯車を持っていない人々です。 他の分野からの明確な天才にそれぞれ500万ドルを払って、彼らから素晴らしいアライメント作業を期待することはできません。 彼らはおそらく本当の困難がどこにあるのか分からないでしょうし、何をすべきか理解していないでしょうし、良い仕事と悪い仕事の違いが分からないでしょうし、資金提供者も私が肩越しに全てを評価することなく分からないでしょう。 それは私が肉体的に耐えられないことです。 20代でまだ本当に才能があり、興味を持っており、勉強をしている人たちについては、確かに、通りすがりの一般人よりも核心的な貢献をする可能性が高いと認めます。 しかし、私はもっと希望を持っています - それほど大きな希望ではありませんが、もっと希望を持っています - (a)良い仕事をした誰もが後で大金を確実に約束すること、そして(b)後で良い仕事をするかもしれないと予測される誰かに先行投資をする、という懸念を分けることにあります。

※Q要約すると?

A(ChatGPT)すぐに結果がわかる分野で実績のある「天才」が、AIアライメントの問題解決に必ずしも役立たない可能性があると主張しています。彼らは、困難がどこにあるかや何をすべきかを理解していないかもしれず、良い仕事と悪い仕事の違いが分からないかもしれません。また、Yudkowsky氏は、才能ある若者が核心的な貢献をする可能性が高いと認めつつ、後から良い仕事に対して大金を約束することと、将来良い仕事をする可能性のある人に投資をすることを分けるべきだと提案しています。

41.この文書を読むだけでは、誰もがコアなアライメント研究者になるわけではありません。それには、この文書を読んでうなずくだけでなく、他の誰も促さなくても独力でこれを書き上げる能力が必要であり、それこそが著者と同じレベルの人物になるための条件です。私の分析の一部は間違いなく誤っていますが、それが必ずしも前向きな方向にあるとは限りません。これらの欠陥に気付き、修正する新たな基本的な仕事をする能力は、私がこれを公開する前にこの文書を書く能力と同じです。しかし、誰もそのようなことはやらなかったようです。この5年間、私は他にやるべきことがあったにもかかわらず、この文書を書くことに時間を費やしていました。その沈黙の一部は、この分野の他の誰もが理解できる形で物事を書く能力を持っていないためかもしれません。つまり、誰かがこれを自分で書く知識を持っていたとしても、それを書き上げることができたら、しかし彼らは書くことができなかったので、試みませんでした。現実でこれが本当に起こることにはあまり期待していませんが、これが「ポジティブなモデル違反」(奇跡)が起こる可能性がある場所の1つだと思います。死のゲームに入って21年、他のEAが死のゲームに気付いて7年、ノーマルな人々が死のゲームに気付き始めて2年が経った今でも、このリストを書き上げているのがエリエゼル・ユダコフスキーであるという事実は、人類にはそれができる唯一の駒がまだ1つしかないということを意味しています。私は、自分がスター研究者としての体力を持っていないことを知っていましたし、健康がさらに悪化する前に自分を置き換えるために本当に一生懸命努力しましたが、それでも私はここでこれを書いています。生き残る世界とはそういうものではありません。

42.計画がない 計画がないのです。この段階で、実際には数十年前から、生き残る世界には生き残るための計画があります。それは書面にされた計画で、秘密ではありません。しかし、この生き残れない世界では、エリエゼルがすぐにその計画の大きな目に見える欠陥を指摘してしまうような候補計画は存在しません。エリエゼルが誰なのか知らない人は、エリエゼルに叱られることなく、計画が必要だとすら気付かないでしょう。なぜなら、人々は自分たちで進行中のアライメントの困難について大声で叫ぶことはなく、注意喚起する内なる声を持っていないからです。そのため、ほとんどの組織には計画がなく、私が彼らに直接叱りつける時間を取っていないからです。「もしかしたら計画を立てるべきかもしれない」という考え方は、彼らが持っている深いアラインメントの考え方よりも、私が常に肩に立って、彼らを説得しなければ持っていない考え方です。実際には、私が彼らに求めると、彼らは準拠せず、計画を持っていない状態が続いています。見せかけでも良いから世間体のために何かしら計画を立てるべきだということにすらほとんどの人は気づいてない。そんな計画には大きな穴があるかもしれないが、「控えめ」すぎるがゆえに、真面目そうな人が信じているように見えるからといって、その穴を指摘するのに躊躇するようなEAを欺くことができるくらいではあってほしい。

43.あなたが周囲を見渡したときに見えるこの状況は、生き残る世界の姿ではありません。あなたが周りを見回すときに見るこの状況は、生き残る世界がどのように見えるかではありません。人類が生き残る世界には計画があります。彼らは、現実の致命的な問題を積極的に指摘する責任を、疲れていて健康問題を抱える一人の男に任せることはありません。重要な人々は、自分たちの計画の欠陥を見つけるために内部的かつ実質的な責任を取り、提案された解決策が間違っていることを証明するのは他の誰かの仕事だと考えるのではなく、解決策を提案することを自分たちの仕事としています。その世界では、重要で致命的な問題を解決しようとする試みが、今よりも早い段階で始まっています。超ひも理論に取り組む人々の半数がAIアライメントに転じ、そこで実際の進歩を遂げました。人々が後で現れるかもしれない惑星規模の致命的な問題を提案すると、そのような問題に取り組むための解決策や、それが起こらない理由が提示されることが一般的であり、「どうしてそれが起こると確信できるのか」や「今はそれを確信する方法はない、実験的証拠を待たなければならない」といった、いいかげんな言い訳ではなく、真剣に向き合おうとします。

それでも、より良い世界の多くが死に絶えるでしょう。初めての試みで、このような問題を解決することは本当に難しい問題です。しかし、それらの世界は、今の世界よりももっと尊厳を持って死んでいくでしょう。

※尊厳を持って死んでいくでしょうというのは、どんなに最善を人類がAIアライメントに尽くしてもとてつもなく難しい問題なのでそれでも成功するかわからないし全人類が壊滅するかもしれないが、全力で取り組んだなら尊厳を持って死ねるという意味で言っているのだと思われる。そして今の世界よりももっと尊厳を持って死んでいくでしょうということは、例え全力を尽くしても、今のこの現実世界よりもAIアライメントが重要視されるような世界であったとしても多くが人類の壊滅に至るだろうが、今よりは尊厳を持って壊滅できると言っているのだと思われる。

和訳終了

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

まとめ

Elizer Yudkowsky氏は終始AIアライメント問題の困難さを強調している。

セクションAではAGIが超知的になる段階の初手でAIアライメントを成功させなくてはいけず、また他の組織がAGIを開発する前に超知能を用いた決定的な行動を起こして世界の破滅を回避しなくてはいけないと主張している。

セクションB.1では超知的なAIはトレーニングでは見られなかった危険を現実世界で発現させる可能性が指摘されている。

セクションB.2では人間の目標設計が間違える可能性、それがあっていたとしても他の目標をAGIが追求してしまう可能性が指摘されている。

セクションB.3では超知能の意図を解釈することの難しさを説き、

セクションB.4ではAGI同士の監視は全体としてシングルエージェントとして人間からは見えてしまうという話や人間の脳の脆弱性の話を強調する。

セクションCではAIアライメントは真面目に危機感を持って取り組まれていない現状を指摘している。

そして最後に例え人類がAIアライメントに全力を尽くしてもデフォルトで人類は壊滅的被害を被るだろうことを言っている。とても悲観的だ。

DeepMind AlignmentチームはEliezer Yudkowsky氏の意見でアウターアライメントをどんなに最適化しても、インナーアライメントの問題が発生するという点についてはほぼ全員同意している(B.2 16)が、インナーアライメントの問題は解決方法が無い(B.2.17)という意見については議論が別れている。また、他のAGIが世界を破滅させないために超知能にGPUを破壊するなどの決定的な行動をとらせる必要があるという意見については賛成できないとする意見が多いようだ。

個人的には人間の脳の構造を参考にしてAGIを作る手法については彼がどのような見解を持っているか気になるが、恐らくアライメントよりもAIの能力の向上の方が早いので脳参照AGIアーキテクチャが構築されるより前に人類を壊滅させるAGIが出てきてしまうと考えているのではないだろうか。

その場合AGIの実現時期がネックになるが、もし2030年頃のAGI実現となってしまった場合は脳を参照する安全なAGI開発に間に合わない可能性もあるためYudkowsky氏のシナリオは現実味を帯びるのかもしれない。

実際にOpenAI Sam Altman CEOは10年以内にAGIが実現されると思う(2032年まで)という発言や、予測投票サイトMetaculusの2023年4月15日現在のAGI実現推定中央値時期は2031年となっており、個人的にも十分あり得ると感じる。

i agree on being close to dangerously strong AI in the sense of an AI that poses e.g. a huge cybersecurity risk. and i think we could get to real AGI in the next decade, so we have to take the risk of that extremely seriously too.

— Sam Altman (@sama) December 3, 2022

まだ勉強不足なため、継続的にAI alignment系の投稿をする予定です。

この記事が気に入ったらサポートをしてみませんか?