モーションキャプチャ「mocopi」をスイッチャーで合成してみた

秋葉原ベストセラースタジオの鳥居歩です!

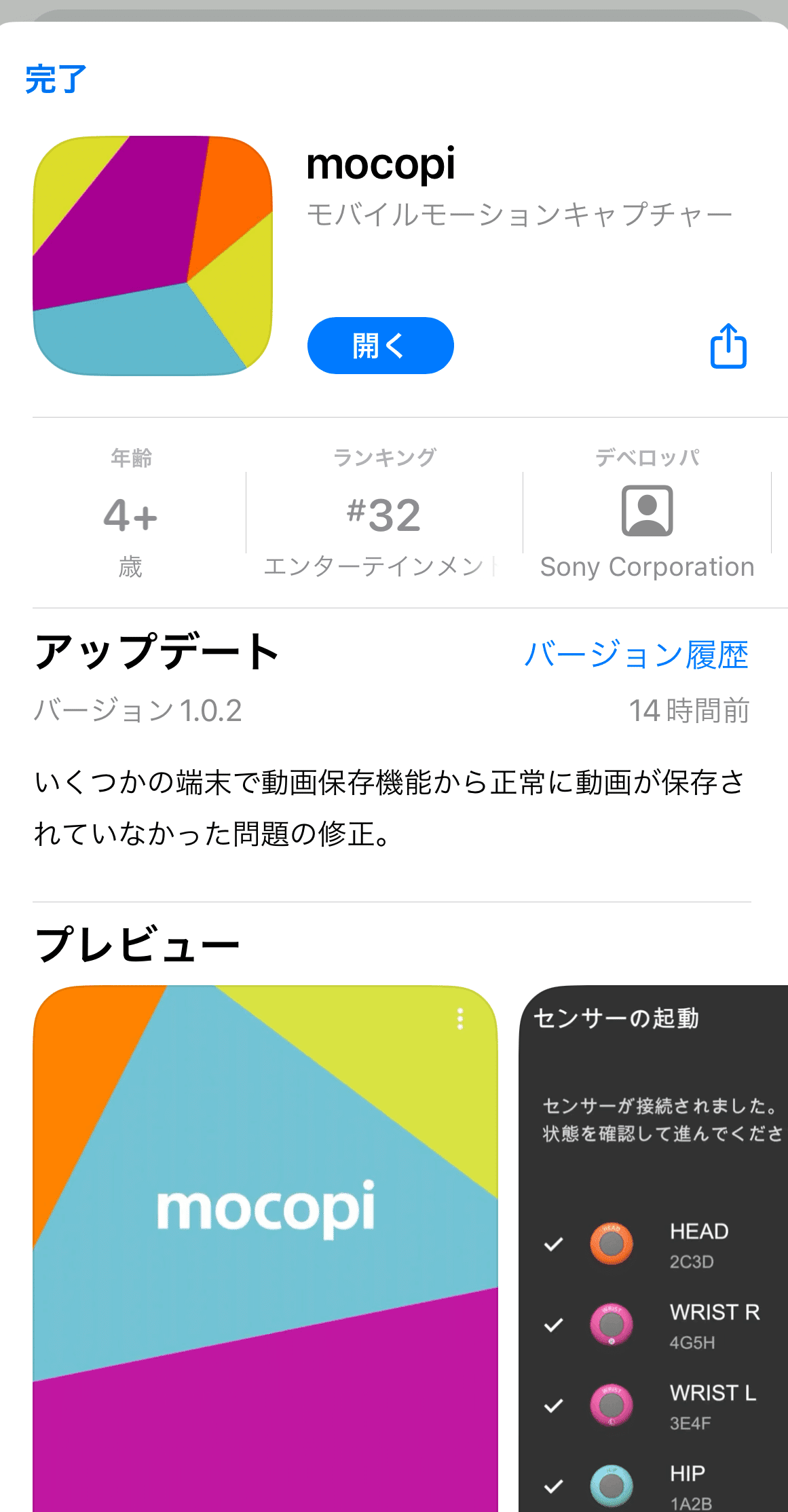

本日、SONYモバイルモーションキャプチャー mocopi(モコピ)

が到着しました!

ざっくり使用感と設定の手順を書いていきますので、何か購入検討の参考になれば幸いです!

テストの様子がコチラ!

TriCaster® 2 Eliteで合成しています。

昨年12月22日に注文して

今年1月20日に到着したので約1ヶ月で到着です。

開封したら、アプリのインストールをします。アプリのインストールは商品開けた中のQRコードを読み込むと出てきます。

アプリの案内に従って6つのモーションセンサーを

順番にBluetooth接続していきます!

全ての接続を完了

バンドを手足とお尻と足首に取り付けて

モーションセンサーを付けます。

身長を設定して

スマホを手に持ってキャリブレーションします。

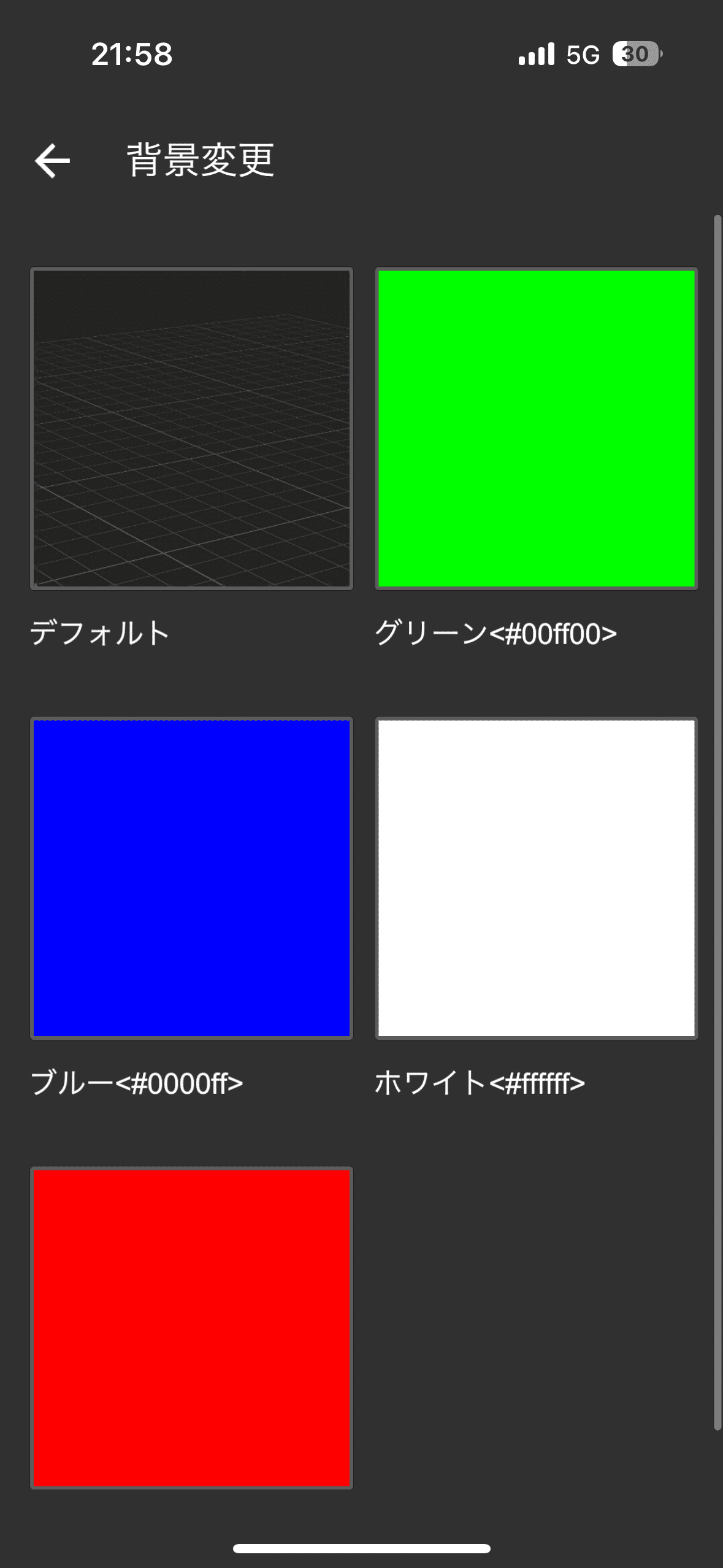

背景が5種類から選べます。

というわけで、とても簡単にできました。

6つのセンサーでセンサーをつけている箇所は手首と足首なので

ヒジやヒザにセンサーをつけていません、それでもなぜ関節の動きを補完できるかというと

これはソニーが独自で開発するアルゴリズムが深く関係しているようで、ソニーにはこれまでのゲームやアニメーション制作などで蓄積してきた膨大なモーションデータに関するノウハウがあります。そのデータを機械学習にかけることで、6つのセンサーの測定データから人の関節位置や動きの流れを予測することができるとのこと

より多くの人にメタバースの世界をお楽しみいただきたいという開発チームの想いにより、『mocopi』は、より少ない機材と軽装でのモーションキャプチャーを実現している。とのこと

また、カスタムアバター(VRMファイル)の取り込みで

アバターを取り込むこともできました!

続きはまた!

現場からは以上です!

この記事が気に入ったらサポートをしてみませんか?