【論文瞬読】Abacusエンベディング:Transformerモデルの算術能力を飛躍的に向上させる新手法

こんにちは!株式会社AI Nestです。

今回は、自然言語処理の分野で大きな注目を集めているTransformerモデルに関する興味深い論文を紹介します。題して「Transformers Can Do Arithmetic with the Right Embeddings」。この研究は、数字の位置情報を明示的にエンコードする新しい位置エンベディング手法「Abacusエンベディング」を提案し、Transformerモデルが学習時よりもはるかに長い数字列に対して高い精度で一般化できることを示しています。

タイトル:Transformers Can Do Arithmetic with the Right Embeddings

URL:https://arxiv.org/abs/2405.17399

所属:University of Maryland, Lawrence Livermore National Laboratory, ELLIS Institute Tübingen, Max Planck Institute for Intelligent Systems, Tübingen AI Center, Carnegie Mellon University

著者:Sean McLeish, Arpit Bansal, Alex Stein, Neel Jain, John Kirchenbauer, Brian R. Bartoldson, Bhavya Kailkhura, Abhinav Bhatele, Jonas Geiping, Avi Schwarzschild, Tom Goldstein

Transformerの算術タスクにおける課題

Transformerモデルは、自然言語処理のさまざまなタスクで優れた性能を示していますが、算術タスクに関しては課題があることが指摘されています。具体的には、数字列の中の各数字の正確な位置を追跡することが苦手だと言われており、このことが算術タスクにおける性能の低さにつながっているようです。研究者たちは、この問題を解決するために、新しいアプローチを模索していました。

Abacusエンベディング:数字の位置情報を明示的にエンコード

そこで登場したのが、今回の論文で提案された「Abacusエンベディング」です。この手法は、数字列中の各数字の位置情報を明示的にエンコードすることで、Transformerモデルが数字の位置関係を正確に把握できるようにするものです。

研究者たちは、Abacusエンベディングを用いてTransformerモデルを学習させ、その性能を評価しました。すると、驚くべき結果が得られたのです。加算タスクにおいて、学習時に使用した数字列の長さの6倍もの長さを持つ数字列に対して、正解率95%以上を達成したのです!これは、Transformerモデルが学習時に見たことのない長さの数字列に対しても、高い精度で一般化できることを示しています。

Transformerモデルの性能比較

再帰的レイヤーとの組み合わせでさらなる性能向上

研究者たちは、Abacusエンベディングの効果をさらに引き出すために、再帰的レイヤーを持つLooped Transformerアーキテクチャとの組み合わせを試みました。再帰的レイヤーを導入することで、モデルは数字列の処理をより効率的に行えるようになります。

実験の結果、Looped Transformerアーキテクチャと組み合わせることで、Abacusエンベディングを用いたTransformerモデルの性能がさらに向上したことが確認されました。これは、再帰的レイヤーとAbacusエンベディングが相乗効果を発揮し、算術タスクにおけるTransformerモデルの能力を大きく引き上げたことを示しています。

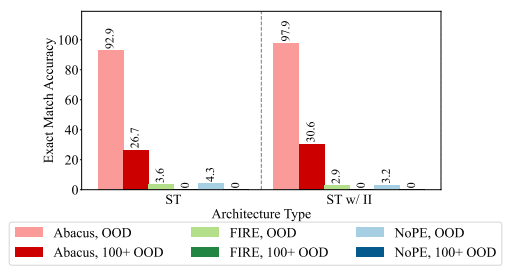

異なるアーキテクチャ(Looped Transformer、標準的なTransformer、

入力注入を用いたTransformer)の組み合わせによる、加算タスクの性能比較

Abacusエンベディングを用いたTransformerモデルの性能比較

他の算術・アルゴリズミックタスクでも有効性を確認

研究者たちは、Abacusエンベディングの有効性を他の算術・アルゴリズミックタスクでも検証しました。加算だけでなく、乗算やソートといったタスクにおいても、Abacusエンベディングを用いることで、学習時よりも長い数字列や配列に対して高い精度で一般化できることが確認されたのです。

これらの結果は、Abacusエンベディングが幅広い算術・アルゴリズミックタスクで効果を発揮することを示しており、この手法の汎用性の高さを物語っています。Transformerモデルの算術能力を向上させるための有望なアプローチとして、大きな注目を集めています。

用いたLooped Transformerモデルの性能比較

用いた標準的なTransformerモデルの性能比較

入力注入を用いたTransformer、Looped Transformer)の性能比較

今後の展望と課題

Abacusエンベディングは、Transformerモデルの算術タスクにおける性能向上に向けた画期的な手法であると言えます。しかし、自然言語処理における他のタスク、特に推論タスクへの応用については、まだ十分な検証がなされていません。Transformerモデルの算術能力の向上が、より複雑な自然言語処理タスクにどのような影響を与えるのか、今後の研究で明らかにしていく必要があるでしょう。

また、Abacusエンベディングを実際の自然言語処理システムに導入する際の課題についても、検討が必要です。たとえば、大規模なTransformerモデルに対して、Abacusエンベディングをどのように効率的に組み込むかといった点は、実用化に向けた重要な研究テーマの1つだと考えられます。

まとめ

「Transformers Can Do Arithmetic with the Right Embeddings」で提案されたAbacusエンベディングは、Transformerモデルの算術タスクにおける性能向上に向けた革新的なアプローチです。数字の位置情報を明示的にエンコードすることで、学習時よりもはるかに長い数字列に対して高い精度で一般化できることが示されました。

また、再帰的レイヤーを持つLooped Transformerアーキテクチャとの組み合わせにより、さらなる性能向上が達成されたことも印象的です。加算だけでなく、乗算やソートといった他の算術・アルゴリズミックタスクでも効果が確認されたことから、Abacusエンベディングの汎用性の高さが明らかになりました。

異なるアーキテクチャ(標準的なTransformer、入力注入を用いたTransformer)の

組み合わせによる、加算タスクの性能比較

今後は、自然言語処理における推論タスクへの応用や、実用化に向けた課題の解決などが期待されます。Transformerモデルの算術能力の向上は、自然言語処理の分野に大きなインパクトを与える可能性を秘めています。この研究を起点として、さらなる発展を遂げていくことを願っています!