Stable Diffusion 3 MediumをComfyUIで使う方法

stability AIが6月12日にStable Diffusion 3 Mediumを発表しました。

今回はStable Diffusion 3 MediumをComfyUIで使う方法について解説します。

プロフィール

自サークル「AI愛create」でAIコンテンツの販売・生成をしています。クラウドソーシングなどで個人や他サークル様からの生成依頼を多数受注。

実際に生成した画像や経験したお仕事から有益となる情報を発信しています。

詳細はこちら(🔞コンテンツが含まれます)

➡️lit.link

メンバーシップ(月額500円)に加入して頂くと、一部の有料記事が読み放題です。

https://note.com/aiaicreate/membership

Stable Diffusion 3 Mediumとは?

Stable Diffusion3は20億のパラメータから構成された最新の画像生成用のオープンモデルです。

Mediumは個人で利用できるようにした小さなモデルで、現在はComfyUIやSwarmUIで使用できます。

ComfyUIのインストール

ComfyUIはノードベースでStable Diffusionを動かせるUIです。

事前にpythonとgitをインストールする必要があります。

・Pythonの公式サイト

・Git for Windowsの公式サイト

githubページにある「Direct link to download」のリンクからパッケージをダウンロードしてください。解凍には7-zipが必要です。

解凍後、「run_nvidia_gpu.bat」を起動すれば必要なものがインストールされ、自動でUIが開きます。

ComfyUI-Managerのインストール

workflowを取り込んだときに一部読み込めないノードがあったりします。

それを一括でインストールして使えるようにできるのがComfyUI-Managerです。

Stable Diffusion 3 Mediumでも一部使えないカスタムノードがあったため、予めインストールしておきます。

まず以下のパスに移動してアドレスバーにcmdと入力し、ターミナルを起動してください。

ComfyUI_windows_portable\ComfyUI\custom_nodes以下のコマンドでComfyUI-Managerをインストールします。

git clone https://github.com/ltdrdata/ComfyUI-Manager.gitStable Diffusion 3 Mediumを使う準備

hugging Faceのアカウント登録と認証

現在Stable Diffusion 3 Mediumは利用規約に同意した方のみ使用可能です。

そのためhugging faceへログインと簡単な質問に回答する必要があります。

まずhugging faceでアカウントを作成してください。

sign upからメールアドレスで登録できます。

ログインしたらStable Diffusion 3 Mediumのページに行き、名前やアドレスを入力します。

NAME:名前

E-mail:メールアドレス

Country:国

Organization or Affiliation:組織または所属

receive~:製品情報などをメールで送っていいかどうか

I acknowledge~:非商用利用モデルであること、ライセンスについて理解していればチェック

入力後、一番下のAgree and Access~をクリックするとhugging Faceのモデルページに移動できます。

モデルのダウンロード

Filesページに移動するといくつかモデルデータがあるので、ダウンロードしてください。

clipsと付いていない無印モデルは別途テキストエンコーダが必要になります。

ファイル名右側にある矢印クリックでダウンロード可能です。

モデルは以下のパスに置きます。

ComfyUI_windows_portable\ComfyUI\models\checkpointsテキストエンコーダのダウンロード

text_encodersというフォルダにテキストエンコーダ用のデータがあるのでそちらを全てダウンロードします。

t5xxl_fp16とt5xxl_fp8はどちらかで構いません。比較したい場合は二つともダウンロードしてください。

clip_g.safetensors

clip_l.safetensors

t5xxl_fp16.safetensors

t5xxl_fp8_e4m3fn.safetensors

データは全て以下のパスに置きます。

ComfyUI_windows_portable\ComfyUI\models\clipworkflowのダウンロード

workflowも「comfy_example_workflows」フォルダ内にあるのでjsonファイルをダウンロードしてください。

・sd3_medium_example_workflow_basic.json(基本のworkflow)

・sd3_medium_example_workflow_multi_prompt.json(プロンプトが三つ使えるworkflow)

・sd3_medium_example_workflow_upscaling.json(アップスケールできるworkflow)

これらをComfyUIにD&Dすることで自動的にノードを追加できます。

ComfyUIでStable Diffusion 3 Mediumを使う方法

まずComfyUIを起動してUIを開きます。

閉じてしまった方は再度「run_nvidia_gpu.bat」を起動してください。

先ほどダウンロードしたworkflow用のjsonファイルをUIにD&Dします。

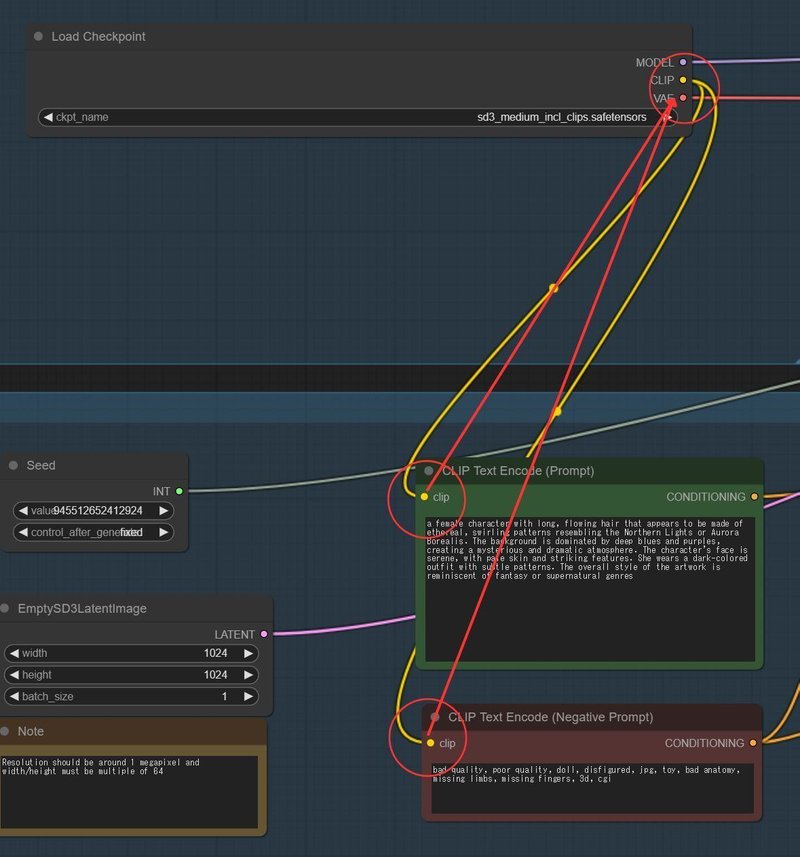

basicのjsonファイルを入れると、以下のようなworkflowが表示されます。

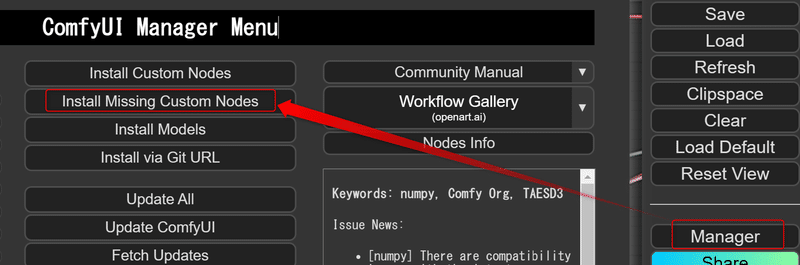

もしここで赤文字の警告が出た場合は、メニューにあるManagerからInstall Missing Custom Nodesをクリックします。

表示されたカスタムノードを全てインストールしてください。

インストール後リスタートすると、workflowが使えるようになります。

もしリスタート後も警告がでた場合は、下にあるUpdate AllやUpdate ComfyUIも試してみてください。

最初にLoad checkpointで使用するモデルを選択します。

無印のsd3_medium.safetensorsを使用する際は、テキストエンコーダが必須みたいです。

TripleCLIPLoaderでダウンロードしたテキストエンコーダを選択してください。

メニューの「Queue Prompt」をクリックすると画像生成が始まります。

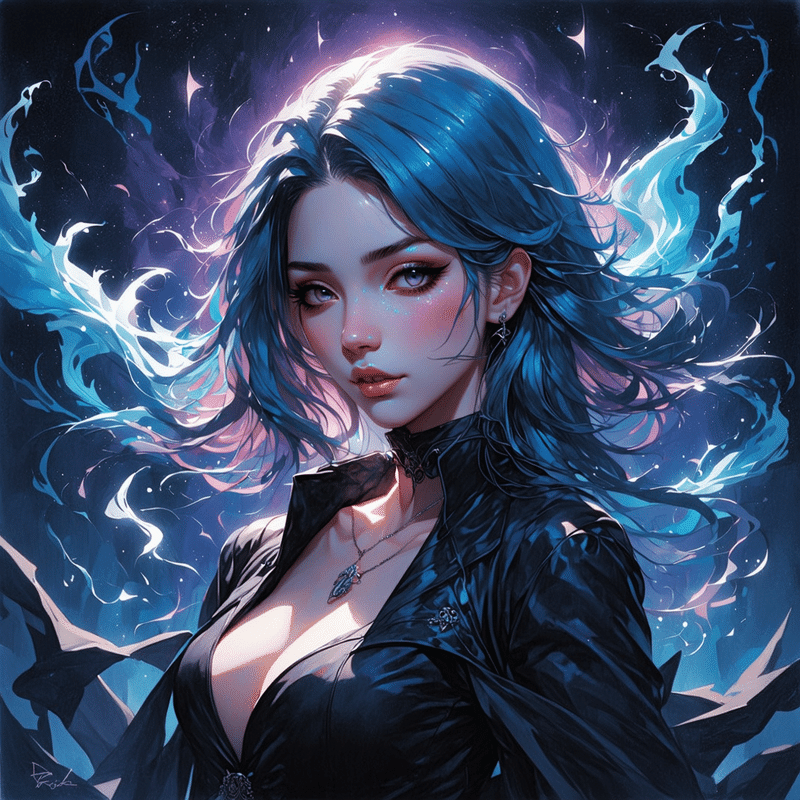

デフォルトだとこんな画像ができました。

clipsと付いているモデルは、TripleCLIPLoaderがあってもなくても生成できます。

TripleCLIPLoaderを使わない場合は削除したあと、promptとnegative promptをLoad checkpointにつないでください。

この状態で「Queue Prompt」をクリックすると画像生成が始まります。

他のworkflowも使用するモデルに合わせて、CLIPの有無を選択するだけです。

promptを三つ入力するworkflowはいまいちどういうものかわからなかったのですが、生成時間が長くなり以下のような画像ができました。

アップスケール用のworkflowで2倍にするとこんな感じです。

以上Stable Diffusion 3 MediumをComfyUIで使う方法でした。

参考になれば幸いです。

よろしければサポートお願いします! いただいたサポートはクリエイターとしての活動費に使わせていただきます!