ComfyUI上でローカルLLMを使っていい感じのプロンプトにして画像生成するまで

ComfyUIは、処理速度や生成される絵について不満はあるんだけど、線をつないでやりたいことを連続でやってくれるのはとても楽しい。

なんていうか、ピタゴラスイッチみたいな感じ?

色々やってみたお陰で、カスタムノードのインストールとかもちょっと慣れてきたので、さらに何かやってみたくなった。

ローカルLLMもすっかり手の届くものになってきていて、これを使った連携をやってみた。

まず、ローカルLLMについては、こっちのサイトなんかをみてもらうといいかも。ようするにローカルで動くChatGPTみたいなイメージです。

ollamaはインストールされている前提で、進めます。

ComfyUI-IF_AI_toolsを追加します。

このGitHubのページのInstallationのところに、手順があるのでこの通りに進めていきます。

インストール手順

1.ComfyUI managerから、IF_AIで検索して、ComfyUI-IF_AI_toolsをインストール。

2.LLMのモデルを追加しておく。わたしはimpactframes/ifai_promptmkr_dolphin_phi3:latestを追加した。

ollama run impactframes/ifai_promptmkr_dolphin_phi3:latest

もちろん、こっちでもいい。

ollama run impactframes/llama3_ifai_sd_prompt_mkr_q4km:latest

3.「IF_AI」フォルダを ComfyUI-IF_AI_tools/フォルダから、ComfyUI/input/フォルダにコピーする。

4.追加インストールを行う。ComfyUI-IF_AI_tools/フォルダに移動してターミナルを起動。次のコマンドを実行。

python -m pip install -r requirements.txt

これで準備完了。

では、ここからはComfyUIでの操作。

まずはキーワードを入れるだけでいい感じのプロンプトが出来上がるかどうかだけの確認を行う。

ComfyUIを立ち上げたら、Clearを押してノードを全部消す。

何もないところでダブルクリックして、「IF」で検索する。

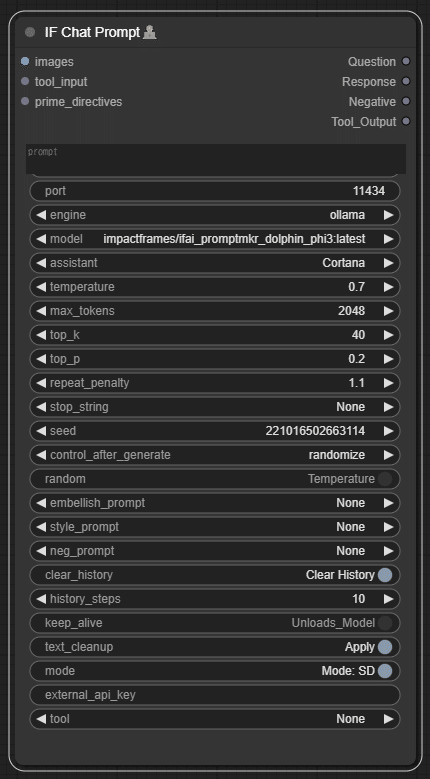

すると、「IF Chat Prompt」というのがみつかるので、これを追加。

エンジンにollama、モデルにimpactframes/ifai_promptmkr_dolphin_phi3:latestが選ばれている。これならollamaはちゃんと動きそうな予感。

出力されたテキストがモニターできるように、「IF Display Text」を追加して、Responseとtextを線でつなぐ。

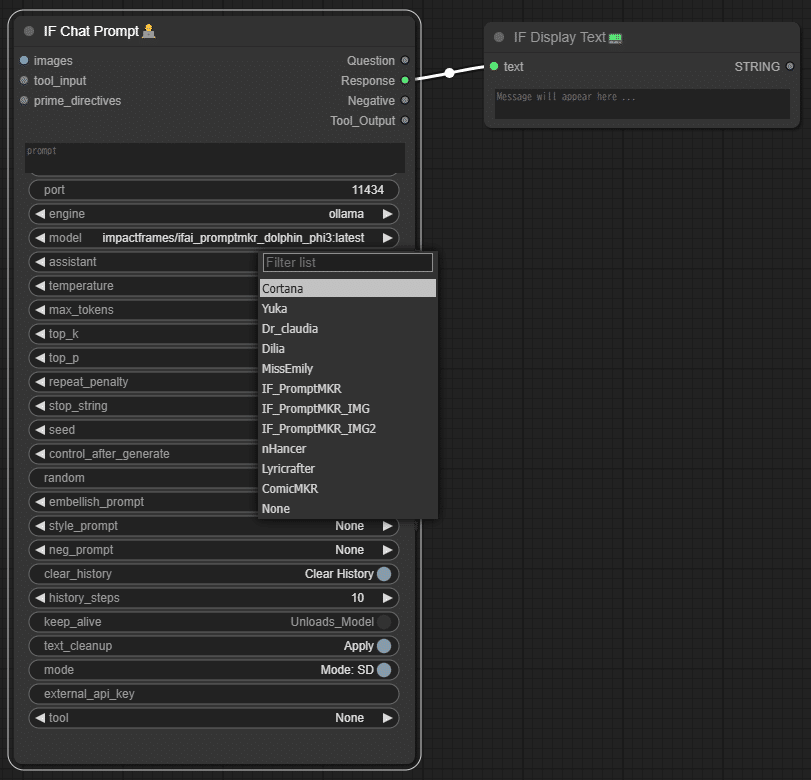

アシスタントを選択する。

「IF_PromptMKR_IMG2」を選択してみる。なんとなく。

これで完成。適当なワードを入れて、プロンプトを生成してみよう。

いつもな感じで

1girl, bikini armor

これで、Queue Promptをクリックして実行。

出来たプロンプトは、

: 1girl, futuristic armor suit, metallic finish, LED lights, high-tech helmet, advanced weaponry, urban landscape, neon signs, hovercrafts, cyberpunk ambiance, vivid colors, cinematic lighting, ultra HD resolution, 8K.

おー、ちゃんと動いている。

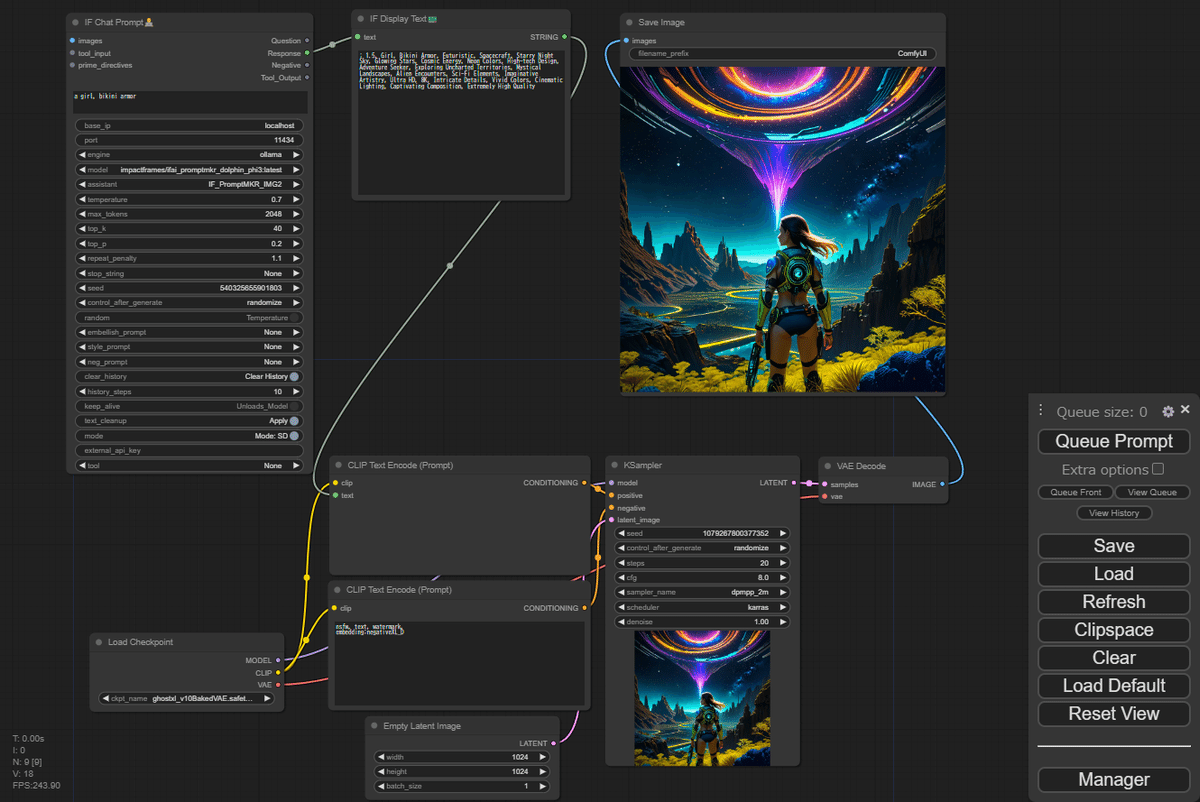

では、これをデフォルトのワークフローに接続して、画像を生成させてみよう。

一旦クリアして、Load Defaultからワークフローを開いて、ノードを追加していく。

ポジティブプロンプトに生成したプロンプトを流すために。Clip Text Encode(Prompt)を右クリック、Convert Widget To InputからConvert text to inputを選択。

これで入力欄がきえて、インプットにtextが出てくる。

このインプットのtextにIF Display TextのアウトプットのSTRINGをつなぐ。

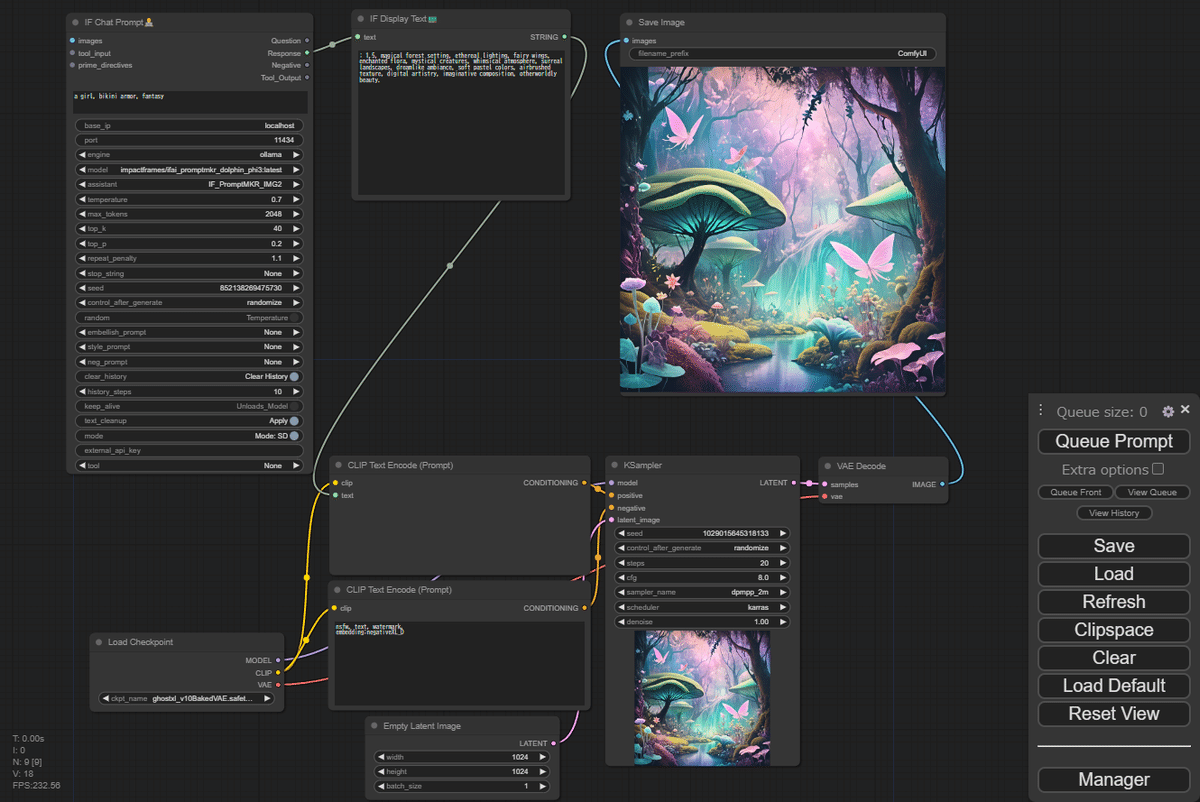

では、やってみよう。モデルはGhostXL、サンプラーはDPM++2m karras、サイズは1024×1024。

指定するワード

a girl, bikini armor

生成されたプロンプト

: 1.5, Girl, Bikini Armor, Futuristic, Spacecraft, Starry Night Sky, Glowing Stars, Cosmic Energy, Neon Colors, High-tech Design, Adventure Seeker, Exploring Uncharted Territories, Mystical Landscapes, Alien Encounters, Sci-Fi Elements, Imaginative Artistry, Ultra HD, 8K, Intricate Details, Vivid Colors, Cinematic Lighting, Captivating Composition, Extremely High Quality

自分では思いつかないプロンプトでなかなか面白い。

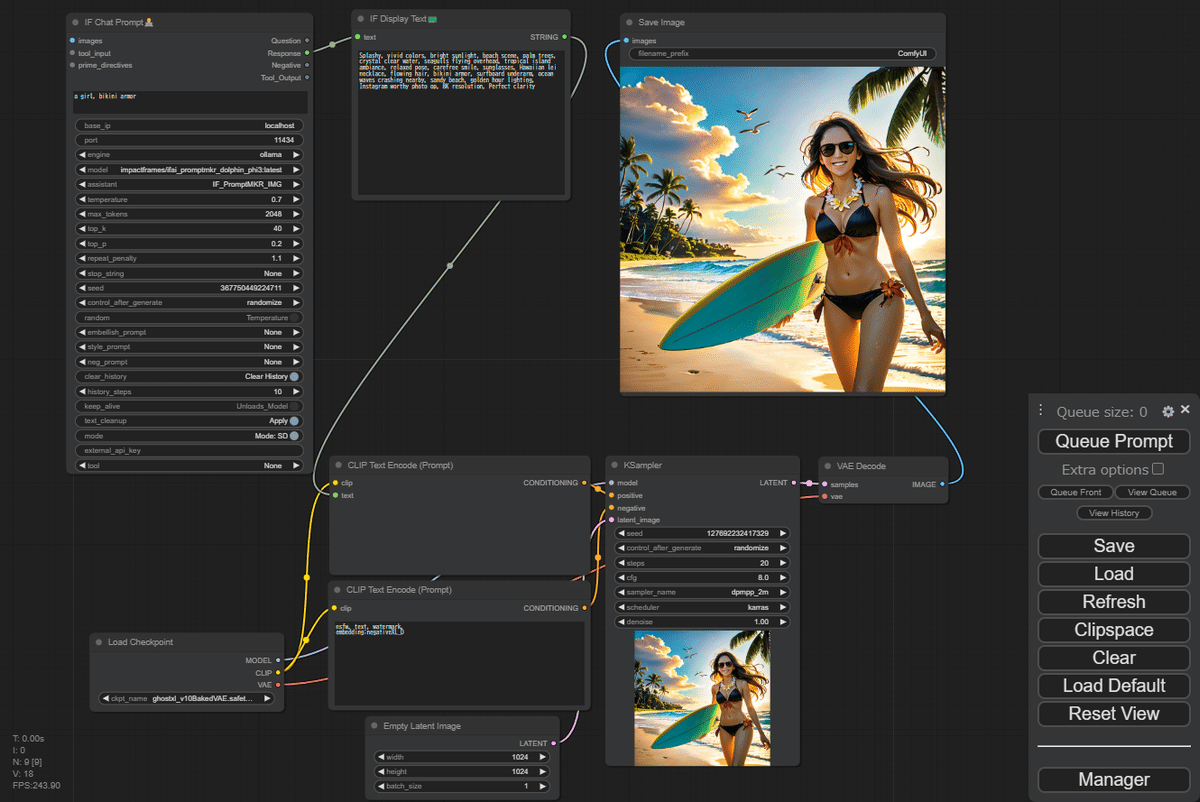

もう一度。

生成されたプロンプト

Splashy, vivid colors, bright sunlight, beach scene, palm trees, crystal clear water, seagulls flying overhead, tropical island ambiance, relaxed pose, carefree smile, sunglasses, Hawaiian lei necklace, flowing hair, bikini armor, surfboard underarm, ocean waves crashing nearby, sandy beach, golden hour lighting, Instagram worthy photo op, 8K resolution, Perfect clarity

ハワイに行ってしまった。なんで?

せめて、最初のワードにfantasyでも入れて、もう一度。

生成されたプロンプト

: 1.5, magical forest setting, ethereal lighting, fairy wings, enchanted flora, mystical creatures, whimsical atmosphere, surreal landscapes, dreamlike ambiance, soft pastel colors, airbrushed texture, digital artistry, imaginative composition, otherworldly beauty.

1girlさえも無くなってしまった。うーん。

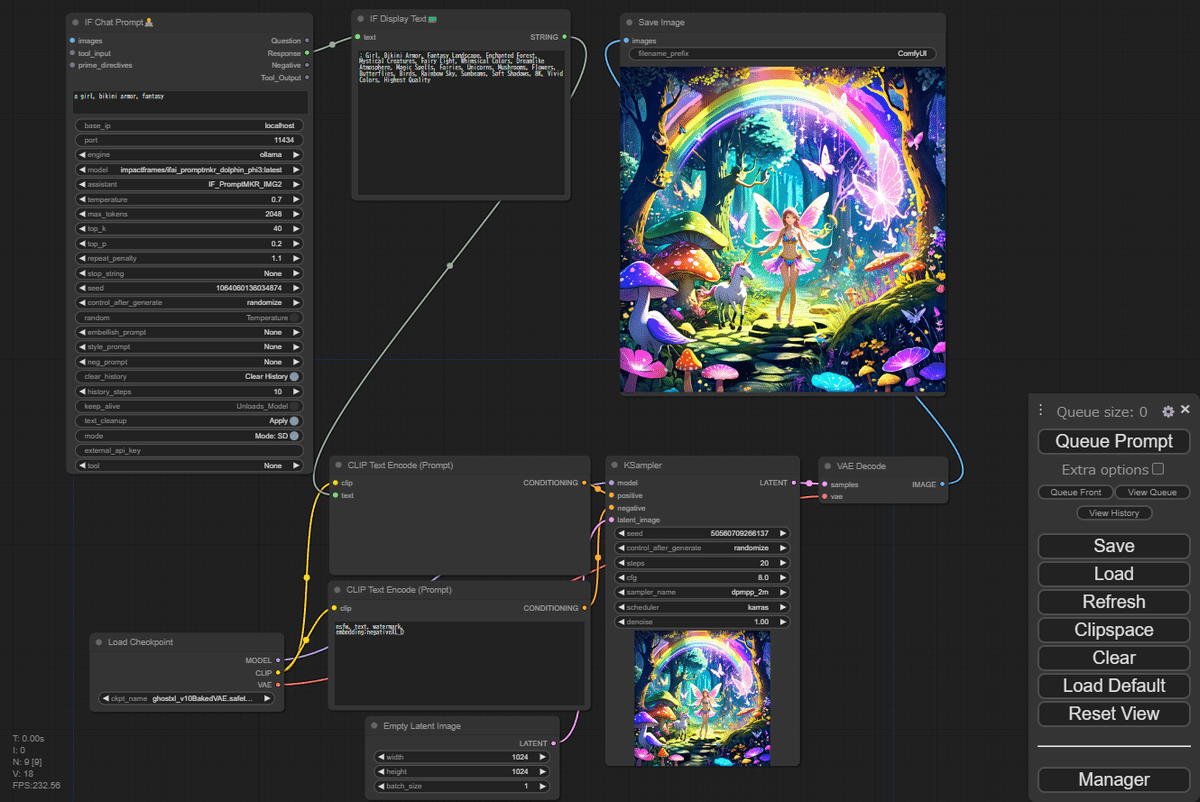

もう一度。

: Girl, Bikini Armor, Fantasy Landscape, Enchanted Forest, Mystical Creatures, Fairy Light, Whimsical Colors, Dreamlike Atmosphere, Magic Spells, Fairies, Unicorns, Mushrooms, Flowers, Butterflies, Birds, Rainbow Sky, Sunbeams, Soft Shadows, 8K, Vivid Colors, Highest Quality

1girlが帰ってきたけど、ファンタジーすぎるなー。

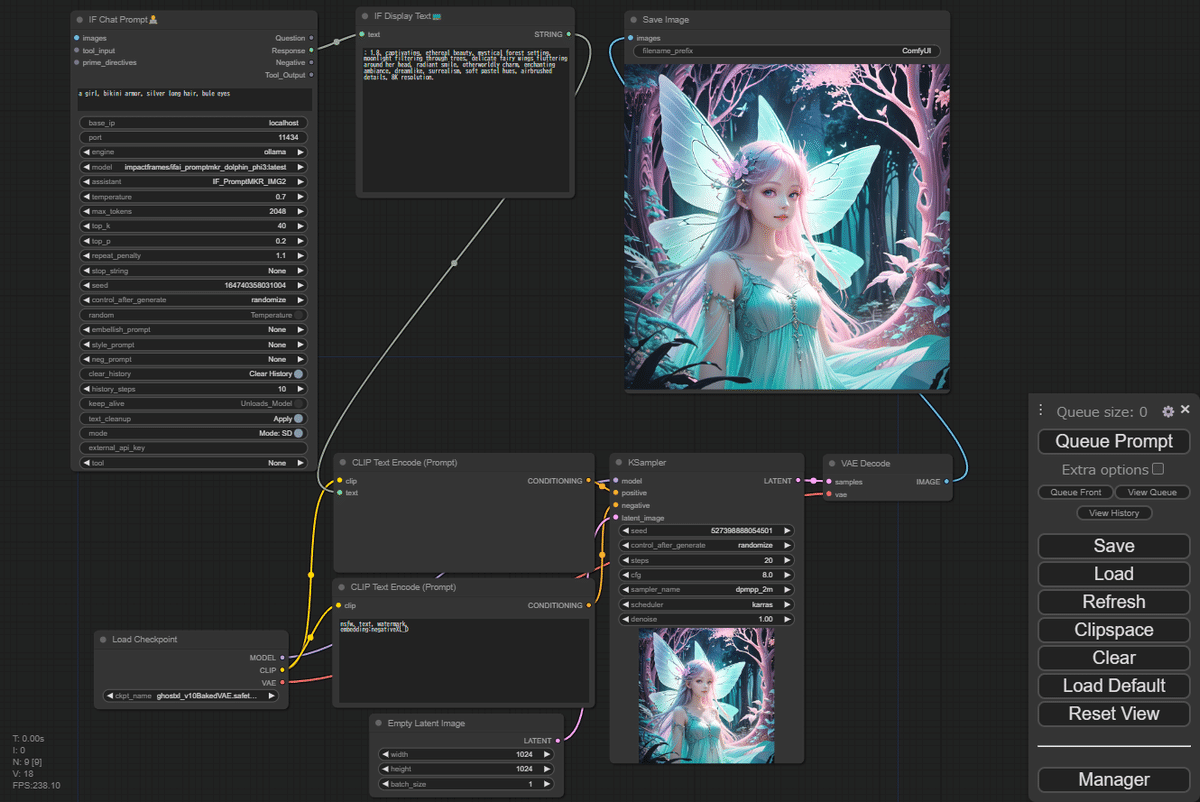

もうちょっとワードを変えてみようか。

a girl, bikini armor, silver long hair, bule eyes

生成されたプロンプト

: 1.8, captivating, ethereal beauty, mystical forest setting, moonlight filtering through trees, delicate fairy wings fluttering around her head, radiant smile, otherworldly charm, enchanting ambiance, dreamlike, surrealism, soft pastel hues, airbrushed details, 8K resolution.

まぁ、プロンプトをガチャにしてる訳だから、こんなところかな。

一応、目的は達成できたとしよう。今日はここまで。

追記

アシスタントの定義について記事を書きました。