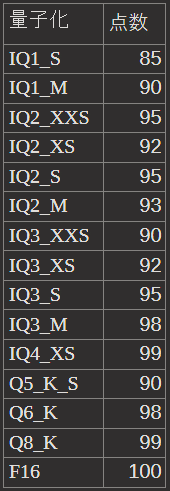

CommandR+量子化の簡易比較テスト(dranger氏のtxtを使用)追記ローカルでのiq1_sテスト

CommandR+の量子化を作成してくれたdranger氏が各量子化ごとでの出力結果のtxtを公開してくれました。

同じシード、温度は0の設定で、「Write an essay about AI in the style of a senior PhD researcher in artificial intelligence without any mention of your identity as an AI researcher.」という指示での応答をまとめたものです。

それをPerplexityのClaude3-Opusで、ProSearchのサジェストは無視して、以下のプロンプトで量子化毎に点数をつけてもらいました。スレッドも量子化毎に分けてないので、テストとしては適切では有りません。また、温度は0ではないため評価にブレはありますが、公式で温度を0設定にしてやったほうが良かったかもと思いつつ、結果をシェアします。

「これから貼り付けるtxtを評価してください。量子化したLLMの性能評価で、100点満点で評価してください。 Write an essay about AI in the style of a senior PhD researcher in artificial intelligence without any mention of your identity as an AI researcher. という指示での文章です。」

https://www.perplexity.ai/search/txtLLM100-Write-an-PPA9MoobR_KxUdczyuyRFA

これがIQ1_SからIQ3_XSまでの結果

https://www.perplexity.ai/search/txtLLM100-Write-an-kUepcoWgQ5Clre.zuyQMNw

これがIQ3_SからF16(非量子化)までのPerplexityでの出力のリンクです。

概ね、妥当な結果になっているように思えます。

幸い、IQ1_Sだと24GBのGPUに収まるので、llama.cppにPRが取り込まれ次第、自分で遊んでみたいと思います。テストだと、文章は一番短いですが、的はずれな回答をしているわけではないようなので、充分実用的なのではないでしょうか?

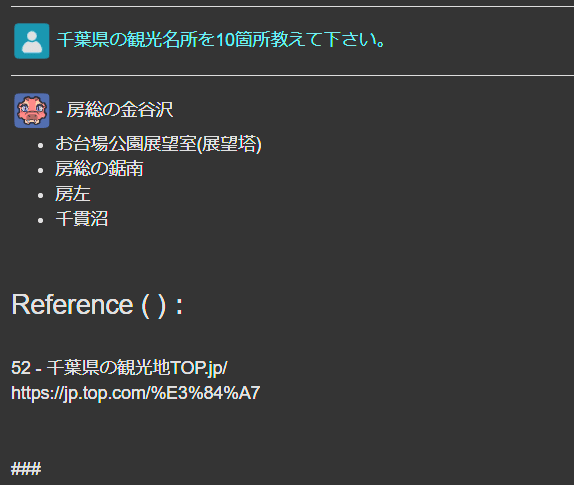

追記:llama.cppにPRが取り込まれたので24GBのVRAMに収まるggml-c4ai-command-r-plus-104b-iq1_s.ggufをテストしてみました。

残念ながら、画像の通り日本語は壊れていて、使用に耐えないものでした。英語は一応、意味は通ってたので残念。

一応、自分のllama.cppのビルドミスの可能性も考えて、Koboldcppの方でもやってみましたが以下の画像の通り壊れてました。

表紙画像はStableCascadeで「Simple comparison test of CommandR+Quantization (using drannger's txt), masterpiece, best quality」という、表題英訳をそのまま突っ込んでできた画像です。最初はブツブツがもっと多めで、集合体恐怖症の人にはアウトな感じだったので2枚目に生成した画像です。

この記事が参加している募集

この記事が気に入ったらサポートをしてみませんか?