2024年最新!LLMモデル大解剖 - 小型AIの躍進と超大型モデルの驚異

こんにちは、テツメモです。

今回は、AI業界で起きている驚きの展開、特に小型LLMモデルの急速な進化と超大型モデルの驚異的な能力についてお話しします。

大手テック企業が次々と新モデルを発表する中、AIの世界地図が大きく塗り替えられつつあります。これは私たちのAI利用にどんな影響をもたらすのでしょうか?🤔

🔗LLM Hallucination IndexRAG Special

こちらの記事をベースに解説していきます。

なぜ今、LLMモデルの選び方が重要なのか?

最近、AI評価企業のガリレオが発表した「LLM_Hallucination Indexレポート」が業界に大きな波紋を呼んでいます。このレポートが明らかにしたのは、以下の驚くべき事実です:

小型LLMモデルの急速な性能向上: 一部の小型モデルが、特定のタスクで大型モデルに匹敵する性能を示しています。

超大型モデルの驚異的な能力: Gemini 1.5 Proに代表される新世代モデルが、200万トークンという前例のないコンテキスト長をサポートしています。

コスト効率の重要性: モデルの選択が、AIプロジェクトの経済性に大きな影響を与えることが明確になりました。

これらの動向は、AIの世界に「効率」と「可能性の拡大」という新しい風を吹き込んでいます。

RAGが変えるAIの学習方法

レポートで特に注目されているのが「RAG(Retrieval-Augmented Generation)」技術です。これは簡単に言えば、AIに"参考資料"を与えて回答を生成させる方法。この技術により、小型モデルでも大型モデルに匹敵する精度の回答が可能になってきているんです。

ガリレオのレポートによると、RAGを使用することで、短いコンテキスト(5,000トークン未満)、中程度のコンテキスト(5,000〜25,000トークン)、長いコンテキスト(40,000〜100,000トークン)のいずれにおいても、モデルのパフォーマンスが大幅に向上しています。

2024年のRAGトップパフォーマー

ガリレオのレポートは、様々なLLMモデルを徹底的に評価しています。その結果、以下のモデルが特に優秀な成績を収めていることが分かりました:

Claude 3.5 Sonnet (Anthropic): 全体的に最高のパフォーマンスを示し、短・中・長のすべてのコンテキストで優れた成績を収めました。200,000トークンまでのコンテキストをサポート。

Gemini 1.5 Pro (Google): チャットボットアリーナのリーダーボードでトップクラスの性能を示し、特に中程度のコンテキストで優れた性能を発揮。最大200万トークンという驚異的なコンテキスト長をサポートしており、長文処理や複雑なタスクに非常に適しています。

Gemini 1.5 Flash (Google): Proよりも大幅に安価で、コスト効率に優れています。特に、短いコンテキストでの性能が高く評価されています。最大100万トークンのコンテキストをサポートしており、多くのユースケースに対応可能です。

Qwen2-72B-Chat (Alibaba): オープンソースモデルの中で最高の性能を示し、特に短・中程度のコンテキストで優れた結果を出しています。128,000トークンまでのコンテキストをサポート。

これらのモデルは、それぞれ異なる特徴を持っています。特筆すべきは、Gemini 1.5 Proの200万トークンという驚異的なコンテキスト長です。これは、非常に長い文書や複雑なデータセットを一度に処理できることを意味し、研究や高度な分析タスクに革命をもたらす可能性があります。

小型モデルvs大型モデル:意外な勝者

ガリレオのレポートが明らかにした驚きの事実は、一部の小型モデルが、特定のタスクにおいて大型モデルを上回る性能を示しているということです。

具体的には、Gemini 1.5 Flash(小型モデル)が、短いコンテキストRAG(SCR)タスクで0.94のスコアを獲得し、GPT-4(大型モデル)の0.96に迫る性能を示しました。さらに、中程度のコンテキストRAG(MCR)タスクでは、Gemini 1.5 Flashは完璧な1.00のスコアを達成し、大型モデルと同等以上の性能を示しています。

これは何を意味するのでしょうか?

効率的な設計の重要性: 単純にモデルサイズを大きくすれば良いわけではありません。

タスク特化型AIの台頭: 汎用性よりも、特定の目的に特化したAIの有用性が高まっています。

コスト効率の向上: 小型モデルは運用コストが低いため、ビジネス利用においても非常に魅力的です。

イノベーションの加速: 小型モデルの進化は、より多くの企業や開発者がAI技術を活用する機会を生み出します。

どのモデルを選べばいいの?

「結局、どのモデルを使えばいいの?」という疑問に対する答えは、あなたの具体的なニーズ次第です。以下のポイントを考慮して選んでみましょう:

コスト: 予算に制限がある場合は、Gemini 1.5 Flashのような効率的なモデルがおすすめです。1Mトークンあたり$0.35という低コストは、多くの企業にとって魅力的でしょう。

パフォーマンス: 最高の性能が必要なら、Claude 3.5 Sonnetを検討しましょう。短・中・長のすべてのコンテキストで優れた性能を示しています。

カスタマイズ性: 特定のニーズに合わせたいなら、Qwen2-72B-Chatのようなオープンソースモデルが良い選択肢です。

タスクの種類: データ分析、テキスト生成、質問応答など、目的に応じて選択してください。例えば、短いコンテキストでの質問応答ならGemini 1.5 Flashが優れています。

コンテキスト長: 長い文脈を扱う必要がある場合、選択肢が大きく広がりました。

Gemini 1.5 Pro: 200万トークンという圧倒的な長さをサポートしており、非常に長い文書や複雑なデータセットの分析に最適です。

Gemini 1.5 Flash: 100万トークンをサポートし、多くの長文処理タスクに対応可能です。

Claude 3.5 Sonnet: 200,000トークンをサポートしており、多くの実用的なシナリオに対応できます。

Gemini 1.5 Proの200万トークンという驚異的なコンテキスト長は、以下のようなユースケースで特に威力を発揮する可能性があります:

大規模な学術論文や技術文書の包括的な分析

複数の長文ドキュメントを跨いだ複雑な質問応答タスク

長期的な会話履歴を保持しながらのチャットボット運用

大量のコードベースの解析やリファクタリング提案

このような高度な機能は、研究機関や大規模プロジェクトでの利用に特に適していますが、コストと処理時間のトレードオフを考慮する必要があります。

RAGの進化がもたらす新たな可能性

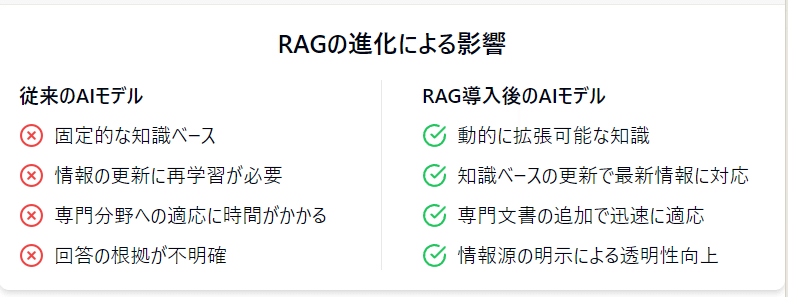

RAG技術の進化は、AIモデルの利用方法に革命をもたらしています。以下に、RAGがもたらす主な利点と、それによって開かれる新たな可能性を見ていきましょう。

知識の柔軟な拡張

従来:モデルの知識は学習時に固定

RAG導入後:外部知識を動的に統合可能

最新情報への対応

従来:再学習が必要

RAG導入後:知識ベースの更新で最新情報に対応

専門分野への適応

従来:ドメイン特化モデルの開発が必要

RAG導入後:専門文書の追加で迅速に対応

透明性の向上

従来:ブラックボックス的な回答

RAG導入後:情報源の明示が可能に

これらの進化により、AIの応用範囲が大きく広がっています。例えば、法律や医療などの専門分野でのAI活用がより容易になり、また企業の内部文書を活用した高度な意思決定支援システムの構築も可能になっています。

まとめ:AIの民主化と高度化が同時進行

小型LLMモデルの台頭と、Gemini 1.5 Proのような超大規模コンテキスト処理能力を持つモデルの登場は、AIの世界に新たな可能性をもたらしています。これは、AIの民主化と高度化が同時に進行していることを意味します。

民主化: より多くの企業や個人が、高性能なAIを手頃な価格で利用できるようになっています。Gemini 1.5 Flashのような効率的なモデルの登場により、AIの導入障壁が低くなっています。

高度化: 超長文処理や複雑なタスクへの対応が可能になり、AIの応用範囲が飛躍的に拡大しています。Gemini 1.5 Proの200万トークンという驚異的なコンテキスト長は、これまで不可能だった規模のデータ分析や文書処理を可能にします。

柔軟性の向上: RAG技術の進化により、AIモデルの知識を動的に拡張し、最新情報に迅速に対応できるようになりました。これにより、AIの実用性と信頼性が大きく向上しています。

コスト効率の最適化: 小型モデルの性能向上により、多くのタスクで大型モデルと遜色ない結果が得られるようになりました。これにより、企業はコストとパフォーマンスのバランスを取りやすくなっています。

私たちは今、AIの新時代の入り口に立っています。小型モデルの効率性と大型モデルの処理能力、そしてRAG技術の進化が相まって、AIの利用シーンはますます多様化していくでしょう。

今後の展望と課題

AIモデルの進化は止まることを知りません。今後予想される展開と、それに伴う課題について考えてみましょう。

モデルの更なる効率化: 小型モデルの性能向上が続き、多くのユースケースで大型モデルに取って代わる可能性があります。

特化型AIの台頭: 特定のドメインや業界に特化したAIモデルが増加し、より精緻な結果を提供するようになるでしょう。

エッジAIの発展: 小型で効率的なモデルの登場により、スマートフォンやIoTデバイスでの高度なAI処理が可能になります。

倫理的考慮の重要性: AIの能力が向上するにつれ、プライバシーや公平性、透明性に関する議論がさらに重要になります。

人間とAIの協業モデルの確立: AIの能力が高まる中、人間の創造性や判断力とAIの処理能力を最適に組み合わせる方法の探求が続きます。

これらの展望を踏まえ、私たちはAI技術の恩恵を最大限に活用しつつ、その影響を慎重に見極めていく必要があります。

最後に、皆さんへの問いかけです:

あなたなら、これらの新しいAI技術をどのように活用しますか?ビジネスや研究、日常生活で、どんな可能性が開けると思いますか?また、AIの進化に伴い、私たちはどのようなスキルや知識を身につけるべきだと考えますか?

コメント欄で、あなたのアイデアや思いをシェアしてください。一緒に、AIがもたらす新しい未来について考えめていきましょう!

この記事はいかがでしたか?

AIと技術の最新トレンドについて、もっと詳しく知りたい方は、毎週月曜日に発行しているニュースレター『【週刊】今日から始めるAI生活』をぜひご購読ください♪

最新の技術トレンドを楽しく、わかりやすくお届けしていきますので、フォローもお忘れなく!

この記事が気に入ったらサポートをしてみませんか?