Apple Vision ProにGPT-4Vを組み合わせて指差したものを説明してもらったり、目の前にいる人物の感情を推定させたりする

Apple Vision Proは作業環境として理想的だ。

このブログもVisionProとMacBookProで書いてる。

VisionProをかけてMacBookProを見るとMacBookProの上に「Connect」という単語が出てくる。これだけですごい。「Connect」を押すとMacの画面が消え、代わりに大スクリーンがポップアップする。圧倒的に作業しやすい。

・・・というか、これならもうMacBookAirでよくないか?わざわざProを持ち歩く必要性が・・・

まあいいか。

それはそれとして、すげー便利なんだがやはりAI機能が弱い。

あと、まだVisionProではかな漢字変換が使えない(のに、JIS配列のHHKBは認識する)。

ブログを書いたりプログラミングしたりするならMacはまだ必要だ。

でもブラウザを開いて映画を見たりするのはもうVisionProだけで充分だ。

VisionProが届く前にshi3zVisionという雑なソフトを書いたが、VisionProの画質でもどうしても試したくなった。

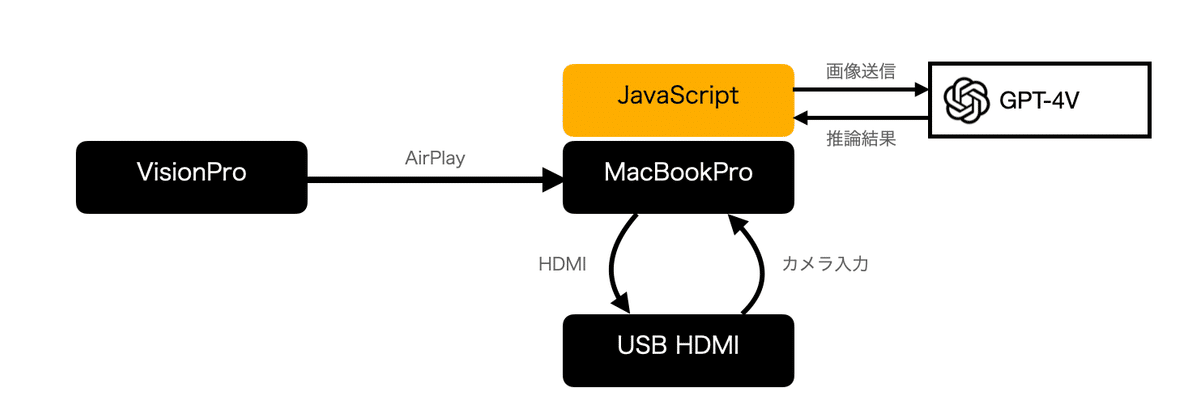

VisionProはAirPlayで見てる画面を共有できるので、その機能を使ってMacBookProにAirPlayで画像を飛ばし、MacBookProの画面出力をキャプチャして自分のカメラ入力として戻し、ブラウザ上で起動したJavaScriptからGPT-4Vを呼び出すようにしてみた。いわばshi3zVisionProである。

実際の動作はこんな感じ

AppleVisionPro + GPT4V pic.twitter.com/e7ZxTASFw5

— shi3z (@shi3z) February 8, 2024

ミソは、VisionProに与えるプロンプトで、指を指していれば指の先にあるものの説明を、人物が写っていれば人物の背格好や感情の説明をしろ、などという指示を与え、「簡潔にしろ」といってるだけ。古典的な条件分岐を組まなくてもプロンプトだけで条件分岐を指定できるのは便利だ。ここのプロンプトはもっと工夫のしがいがあるだろう。

音声の読み上げはMacBookPro側から行なっているのだが、そもそも室内で使うことが前提のVisionProはこれでも充分だ。

ちなみにVisionProを付けて秋葉原から浅草橋まで歩いてみたのだが、ウィンドウが付いてこないので、ウィンドウを持った状態で歩くと見ながら歩くことができる。これは歩きスマホより安全な気がする。近づくと自動的にウィンドウが透けるから。

ソースコードは以下