図でまとめるCNN

こちらはゼロから作るDeep learningを丸コピしたものです。

自分用、見直す用にまとめました。営利目的ではありません。

Overview

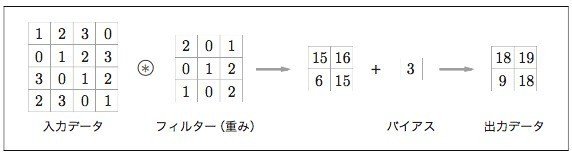

畳み込み層

パディング

:入力データの周囲に固定のデータ(0)を埋めること

出力サイズを調整するため

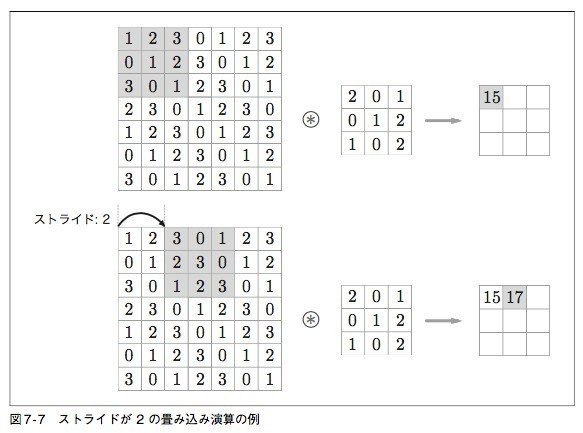

ストライド

:フィルターを適用する位置の感覚

入力サイズを (H, W )、フィルターサイズを (F H, F W )、出力サイズを (OH, OW )、パディングを P 、ストライドを S とする。

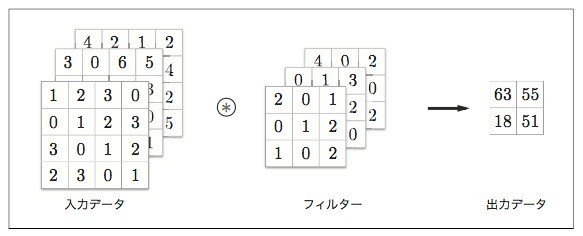

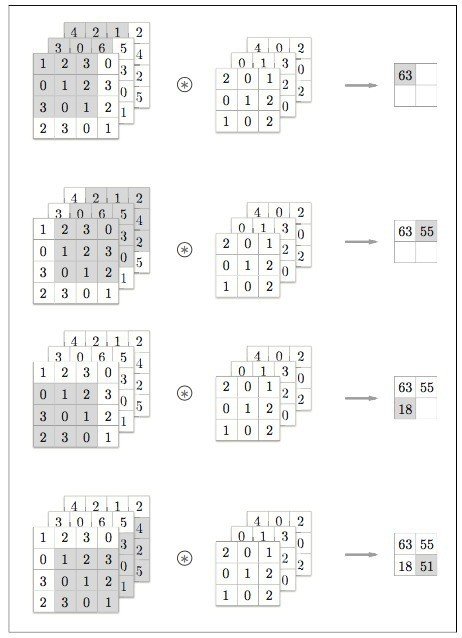

3次元データの畳み込み

ブロックで考える

バイアス

バッチ処理

プーリング層

:プーリングは、縦・横方向の空間を小さくする演算

「Max プーリング」とは最大値を取る演算

プーリングの特徴

:学習するパラメータを持たない

:チャンネル数は変化しない

:微小な位置変化に対してロバスト(頑健)

4次元配列:レイヤは4次元(n data, channel, height, width)

x = np.random.rand(10, 1, 28, 28)

x[0].shape # (1, 28, 28)

x[1].shape # (1, 28, 28)im2colによる展開

:フィルター(重み)にとって都合の良いように入力データを展開する関数

3次元を2次元にする

im2col によって入力データを展開してしまえば、その後にやることは、畳み込 み層のフィルター(重み)を 1 列に展開して、2 つの行列の積を計算するだけ

これが畳み込み層の流れです

Convolutionレイヤの実装

import sys, os

sys.path.append(os.pardir)

from common.util import im2col

x1 = np.random.rand(1, 3, 7, 7)

col1 = im2col(x1, 5, 5, stride=1, pad=0)

print(col1.shape) # (9, 75)

x2 = np.random.rand(10, 3, 7, 7) # 10 個のデータ col2 = im2col(x2, 5, 5, stride=1, pad=0) print(col2.shape) # (90, 75)

class Convolution:

def __init__(self, W, b, stride=1, pad=0):

self.W = W

self.b = b

self.stride = stride

self.pad = pad

def forward(self, x):

FN, C, FH, FW = self.W.shape

N, C, H, W = x.shape

out_h = int(1 + (H + 2*self.pad - FH) / self.stride)

out_w = int(1 + (W + 2*self.pad - FW) / self.stride)

col = im2col(x, FH, FW, self.stride, self.pad) col_W = self.W.reshape(FN, -1).T # フィルターの展開 out = np.dot(col, col_W) + self.b

out = out.reshape(N, out_h, out_w, -1).transpose(0, 3, 1, 2)

return out

Pooling

class Pooling:

def __init__(self, pool_h, pool_w, stride=1, pad=0):

self.pool_h = pool_h

self.pool_w = pool_w

self.stride = stride

self.pad = pad

def forward(self, x):

N, C, H, W = x.shape

out_h = int(1 + (H - self.pool_h) / self.stride)

out_w = int(1 + (W - self.pool_w) / self.stride)

# 展開 (1)

col = im2col(x, self.pool_h, self.pool_w, self.stride, self.pad)

col = col.reshape(-1, self.pool_h*self.pool_w)

# 最大値 (2)

out = np.max(col, axis=1)

# 整形 (3)

out = out.reshape(N, out_h, out_w, C).transpose(0, 3, 1, 2)

return out

Pooling レイヤの実装は、図7-22 に示すように、次の 3 段階の流れで行います。

1. 入力データを展開する

2. 行ごとに最大値を求める

3. 適切な出力サイズに整形する

SimpleCNNの実装

class SimpleConvNet:

# initialization of convolusion layer

def __init__(self, input_dim=(1, 28, 28),

conv_param={'filter_num':30, 'filter_size':5,

'pad':0, 'stride':1},

hidden_size=100, output_size=10, weight_init_std=0.01):

filter_num = conv_param['filter_num']

filter_size = conv_param['filter_size']

filter_pad = conv_param['pad']

filter_stride = conv_param['stride']

input_size = input_dim[1]

conv_output_size = (input_size - filter_size + 2*filter_pad) / \

filter_stride + 1

pool_output_size = int(filter_num * (conv_output_size/2) *

(conv_output_size/2))

# 重みの初期化

self.params = {}

self.params['W1'] = weight_init_std * \

np.random.randn(filter_num, input_dim[0],

filter_size, filter_size)

self.params['b1'] = np.zeros(filter_num)

self.params['W2'] = weight_init_std * \

np.random.randn(pool_output_size,

hidden_size)

self.params['b2'] = np.zeros(hidden_size)

self.params['W3'] = weight_init_std * \

np.random.randn(hidden_size, output_size)

self.params['b3'] = np.zeros(output_size)

self.layers = OrderedDict()

self.layers['Conv1'] = Convolution(self.params['W1'],

self.params['b1'],

conv_param['stride'],

conv_param['pad'])

self.layers['Relu1'] = Relu()

self.layers['Pool1'] = Pooling(pool_h=2, pool_w=2, stride=2)

self.layers['Affine1'] = Affine(self.params['W2'],

self.params['b2'])

self.layers['Relu2'] = Relu()

self.layers['Affine2'] = Affine(self.params['W3'],

self.last_layer = SoftmaxWithLoss()

# predict

def predict(self, x):

for layer in self.layers.values():

x = layer.forward(x)

return x

# loss

def loss(self, x, t):

y = self.predict(x)

return self.lastLayer.forward(y, t)

# back propagation

def gradient(self, x, t):

# forward

self.loss(x, t)

# backward

dout = 1

dout = self.lastLayer.backward(dout)

layers = list(self.layers.values())

layers.reverse()

for layer in layers:

dout = layer.backward(dout)

# 設定

grads = {}

grads['W1'] = self.layers['Conv1'].dW

grads['b1'] = self.layers['Conv1'].db

grads['W2'] = self.layers['Affine1'].dW

grads['b2'] = self.layers['Affine1'].db

grads['W3'] = self.layers['Affine2'].dW

grads['b3'] = self.layers['Affine2'].db

return grads1層目の重みの可視化

階層構造による情報抽出

代表的なCNN

- LeNet

- AlexNet

different from LesNet

● 活性化関数に ReLU を用いる

● LRN(Local Response Normalization)という局所的正規化を行う層を用

いる

● Dropout(「6.4.3 Dropout」参照)を使用する

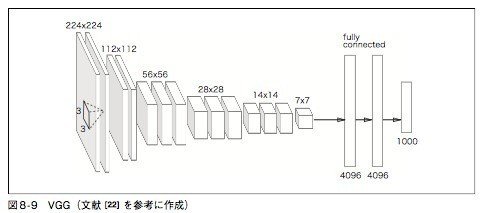

- VGG

VGG は、畳み込み層とプーリング層から構成される“基本的”な CNN

重みのある層(畳み込み層や全結合層)を全部で 16 層

(もしくは 19 層)まで重ねてディープにしている点が特徴

3 × 3 の小さなフィルターによる畳み込み層を連 続して行っている

畳み込み層を 2 回から 4 回連続し、プー リング層でサイズを半分にするという処理を繰り返し行います。そして、最後に全結 合層を経由して結果を出力

- ResNet

スキップ構造を導入することで、層を深くすることに比例し て、性能を向上

転移学習

学習済みの 重み(の一部)を別のニューラルネットワークにコピーして、再学習を行いま す。たとえば、VGG と同じ構成のネットワークを用意し、学習済みの重みを 初期値とし、新しいデータセットを対象に、再学習(fine tuning)を行います。 転移学習は、手元にあるデータセットが少ない場合において、特に有効な手法 です。

まとめ

● CNN は、これまでの全結合層のネットワークに対して、畳み込み層と プーリング層が新たに加わる。

● 畳み込み層とプーリング層は、im2col(画像を行列に展開する関数)を用 いるとシンプルで効率の良い実装ができる。

● CNN の可視化によって、層が深くなるにつれて高度な情報が抽出されて いく様子が分かる。

● CNN の代表的なネットワークには、LeNet と AlexNet がある。

● ディープラーニングの発展に、ビッグデータと GPU が大きく貢献して

いる。

この記事が気に入ったらサポートをしてみませんか?