Green500 測定レベル3の電力だけでは PEZY Shoubu system B は熱で壊れてしまう

一番大事なこと

発表資料13枚目 FORMULA は Formura です.大文字小文字の違いはよくわかりませんが,Formura は開発した村主崇行氏の名前にもとづく Muranushi の Fortran なので l と r の違いは訂正して下さい.お願いします.

Green500 測定レベル3の結果は「冷却設備を含まない欠点がある」との批判の返答にならない

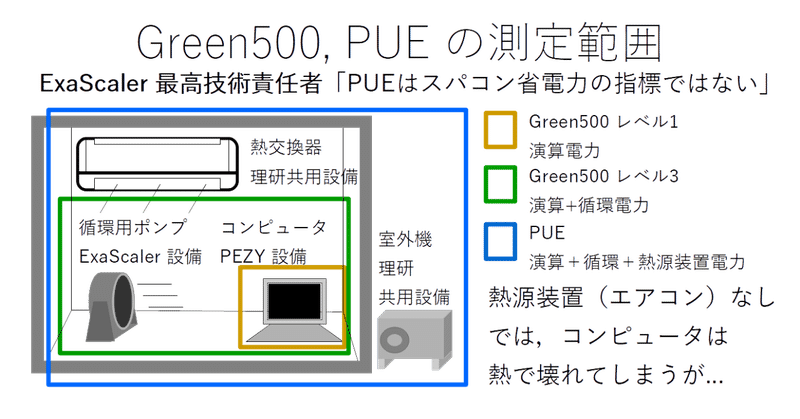

電力あたりの LINPACK (high performance LINPACK, HPL) 演算量で順位付けされる Green500 が昨年11月に更新され,その結果を紹介する記事(マイナビ,日経 xTECH)が公開されています.その記事から,測定方法が Green500 レベル3 の電力だけでは冷却ができず,PEZY Computing, ExaScaler の Shoubu system B が壊れてしまうことがわかります.そのことなどについて,次の4つの項目に分けます.

Green500 レベル3 の電力はシステムに必要な分より少ない.

1. Green500 レベル3で測定された電力では,Shoubu system B を冷却できず,熱で壊れてしまう.

PUE は性能指標として有効

2. ExaScaler 取締役 CTO(最高技術責任者) 鳥居淳氏の主張「PUEはスパコンシステムの性能の指標ではない」に反する実例が複数ある.

3. PUEを性能指標から外すことは,鳥居淳氏による招待論文や招待講演で示された PEZY Computing の目標に反する.

4. PUE の測定は本来長期(数か月から1年)だが,短期間の測定しか行っていない.

5. ただし,PUE も指標の1つでしかなく,工夫して数字を低くすると不適切になることがある.

測定時の電力最適化は調整と大差ない

6. Green500 2-4位の電力は optimized (クロックと電圧の最適化)だと指摘しているが,Shoubu system B もクロックを調整している可能性があり,最適化と大差ない.

電力効率測定の課題が変われば,演算効率も変わる

7. 演算性能重視の HPL ではなく,メモリバンド幅が影響する HPCG や,その2つの平均に対する電力効率を推定すると,Shoubu system B は HPL に偏っている.

(最後の項目は長くなるので,別の記事にまとめました.)

これらは日経 xTECH の記事にある

「PEZYの計測方式は冷却設備を含まず、非省エネのスパコンが上位になり得る欠点がある」との批判に応えたものだ。

とは異なり,測定方式を Green500 レベル3としたときの結果では批判に応えられないことを意味します.それは冒頭の図にあるように,

Green500 レベル3の電力 = 冷却電力+演算電力< 全消費電力

と両辺が等号で結ばれないよう「冷却設備」,「冷却電力」の定義を狭めているからです.そこで説明のために冷却電力の種類を表す言葉を定義します.

冷却電力の種類を表す言葉の定義

冷却電力について,次のように区別します(以下の循環電力,熱源設備電力は説明のために導入したこの記事独自の用語です).

循環電力 コンピュータを冷やす冷媒(液体や気体)を循環させるための電力

熱源設備電力 冷媒の温度を下げる(ための冷水を製造する)のに使う電力

オフィスをエアコンで冷やすとき,サーキュレーターは循環電力,空気を冷やすエアコンの電力は熱源設備電力に,それぞれ該当します.発表資料の12枚目にあるように Shoubu system B については,冷媒を循環させるポンプを動かす電力が循環電力,HOKUSAI などほかのシステムと共同利用している冷却水をつくる設備の電力が熱源設備電力に,それぞれあたります.

1. Green500 レベル3 は室外機の電力を測定しない

発表資料の5枚目にあるように,循環ポンプの電力が含まれる一方で,熱交換器(右中央の HX, heat exchanger)に供給される冷水をつくるための電力は,Green500 レベル1 だけでなくレベル3 でも除外されています.つまり,Shoubu system B における Green500 レベル3 の測定に循環電力は含まれていますが,熱源設備電力は含まれません.鳥居氏が「冷却設備」と呼んでいる設備から冷却水をつくる設備は除外されています.冷却設備というより循環設備と呼ぶ方が実態に合っています.

冒頭の図でいえば,室内のサーキュレーターだけが冷却設備であり,エアコンは冷却設備から除外されます.このとき,エアコンの電力がどれだけ多くなっても,Green500 レベル3 の測定結果,順位は変わりません.

熱源装置により冷やされた冷水が熱交換器に供給されなければ,冷媒の温度は下がらず,その冷媒を循環させてもプロセッサなどを冷却できず,冷媒の温度は上がり続けます.Green500 レベル3 の電力だけでは,Shoubu system B は熱で壊れてしまいます(後で説明するように,Green500 レベル3の電力だけにする例外的な方法として,北海道石狩市のような,常に冷たい外気で冷却できるところへの移転があります).

鳥居氏による冷却設備の定義では除外されている,システムの動作に必要な設備(熱交換器に使う冷却水を作る設備)の電力は無視できない大きさです.発表資料の12枚目から,循環電力が0.5kW であるのに対して, 熱源設備電力はおよそ 12kW と(PUE の値から)推定されます.システムの冷却に不可欠な冷却水をつくる多くの電力を除外して,そのおよそ 1/20 の循環電力だけを考慮する Green500 レベル 3 の結果では,「PEZYの計測方式は冷却設備を含まず、非省エネのスパコンが上位になり得る欠点がある」との批判に応えられません.

2. スーパーコンピュータの指標としての PUE の事例

Green500 レベル3とは異なり,PUE は循環電力と熱源設備電力の両方を含む指標です.しかし,鳥居氏は PUE について次のように述べています.(強調は引用者による)

PUEを出してほしいという要望があり、この値を出したとのことであるが、PUEはデータセンターの冷却のエネルギー効率を示すもので、スパコンシステムの性能の指標ではない。産業技術総合研究所のABCIのように専用のデータセンターで1台のスパコンしか設置されていない場合は、ある程度の意味はあるが、空調を北斎などの複数のシステムと共有する理研の和光本所の計算センターのような環境で、個別のスパコンシステムのPUEを出すことは意味がない。

一方,東大サステイナブルキャンパスプロジェクトによるスーパーコンピュータ省エネガイドライン(コンピュータサーバ室設備設置及び運用のガイドライン)の第I-7節 省エネルギー目標の I-7-1 に PUE が挙げられています(I-7-2 は消費電力当たりの性能です).そこから引用します.

PUE は、コンピュータサーバ室あるいは施設全体が消費する電力とスーパーコンピュータ装置が消費する電力の比率であり、できるだけ小さいことが望ましく、理想的には1となる。

またこのガイドラインの I-7-2 には次のような説明があります.

前節の PUE と本節のこの指標(注:Green500 にあたる消費電力あたりの性能)を理解する上で重要なことは、前節の PUE 値とこの指標の間に相関はあるが独立であることである。

PUE は電力の時間積分である電力量で規定される一方、本節の指標は電力で規定される。スーパーコンピュータ装置の消費電力は時間と共に変化するので、二つの指標を単純に掛け合わせても意味のある指標にはならない。また、省エネルギーで目指すべき目標は消費電力量当たりでスーパーコンピュータ装置が処理可能な計算量であるが、スーパーコンピュータの本来の目的は「高い性能」そのものであり、本来の目的を達成しながら省エネルギーを目指す必要がある。

これらでは, PUE は独立したスーパーコンピュータの省エネルギー指標であるとはっきり書かれています.鳥居氏の主張とは正反対であることから,鳥居氏の主張が正しいのか疑問が残ります.少なくともその主張の根拠が必要でしょう.

また,東大医科学研究所ヒトゲノム解析センターで実働して(いた)いるスーパーコンピュータ (Shirokane3)Shirokane4 の冷却性能のページでは次に引用するように PUE を指標としています.

冷却効率は、PUE という指標で評価します。(略)

仮に冷却に関わる消費電力 (上述 W2 ) が 0 になれば、 PUE は 1 となることからわかるように、PUE が 1 に近ければ近いほど、冷却効率が高いことを示します。一般的なデータセンターでは、PUE は、1.2 程度でも極めて高い効率といえますが、Shirokane3 では、1.2 を下回っています。 (略)

2015年7月は、日本初導入の Oasis が、日本の高温多湿の真夏を初めて迎え、システム調整に多くの時間を費やしました。冷却の調整・最適化を強力に推進した結果、8 月には、計算サーバの消費電力が設計値の半分程度であっても、PUE は 1.2 を下回ることが出来ました。

さらに2017年3月から8月までの消費電力と PUE のグラフも公開されています.

さらに,Top500 1位の Summit もその省エネルギー指標として PUE を使っています.Faces of Summit: Creating a Green Summit から引用します.

During Summit’s 4-hour HPL run, Rogers and his team also collected around 180,000 power measurements from 12 devices. The team measured the machine’s power usage effectiveness (PUE) during the run as 1.03, which means that for every dollar spent on electricity, only 3 cents goes toward removing heat. A traditional air-cooled data center typically has a PUE of about 1.8, requiring nearly 80 cents to remove heat for every dollar spent.

Summit による4時間の HPL の実行の間,ロジャース氏と彼のチームは12のデバイスからおよそ 180,000 の電力測定を集めました.そのチームの測定により,その実行における Summit の PUE は 1.03 であることがわかりました.(コンピュータの)電気料金に100円使う度に,冷却用電気料金は3円だけで十分ということです.伝統的な空冷のデータセンターでは PUE が 1.8, つまり100円電気に使う度に冷却に80円必要になります.

この説明では,PUE に関してデータセンターとスーパーコンピュータに区別がなく,(根拠が示されていない)鳥居氏の主張と矛盾します.

これらの事例から,PUE がスーパーコンピュータにとって意味があると考える研究機関や関係者は少なくないでしょう.

3. 「PUE はスーパーコンピュータの指標ではない」と PEZY Computing の目標の食い違い

これまで見てきたように,鳥居氏の主張「PUE はスーパーコンピュータの指標ではない(Green500 レベル3 が指標である)」は,熱源設備電力の節電を無視することと同じです.しかしこの主張は,鳥居氏による招待論文,招待講義の内容と食い違います.招待論文「グリーンスーパーコンピュータ ZettaScaler の技術と今後の展望」5.2 コピー機のようなスパコン実現に向けて,から引用します(強調は引用者による).

ZettaScaler シリーズの液浸システムは,室内では無音無風かつ室温での運用が可能である.したがって,オフィスなどの居室に,コピー機のようにスパコンを設置することが原理的に可能となる.(略)

軽量化が実現し,併せてコスト低減,電力低減を実現できれば,オフィスにコピー機と同じようにスパコンを設置して,自由に技術計算,シミュレーションができる.これが真の意味でのスパコンの民主化であり,誰もが使える強力なツールとなることを意味する.

京都大学 情報学領域概論科目「情報通信技術のデザイン」実施報告(平成29年度)から引用します.

【スーパーコンピュータのデザイン (鳥居淳先生)】

(略)近年は、性能だけでなく、このようなコストも考慮した評価がされており、PEZY Computingでは小型化・高密度化・低消費電力化によりスパコンの民主化(高性能な大型計算機センターから誰もが気軽に使えるオフィスでの設置)を目指しているという点が印象的であった。(略)これらにより、オフィス設置では欠かせない高性能と低消費電力、低騒音と室温動作を実現している。

コンピュータをオフィスに設置したとき,(エアコンにあたる)熱源設備の電力は設置機関が負担しなければいけません.熱源設備電力を含まない Green500 レベル3 で順位が高くても,熱源設備電力を含む全消費電力が低くなる保証はありません.

また,5. で後述するように液浸冷却はオフィスのある温暖地域ではなく,寒冷地域に設置してメリットが出ます.

4. PUE の測定は本来長期(数か月から1年)

PUE と Green500 レベル3 の違いとして,熱源設備電力を含めるかどうかを挙げましたが,もう1つ違いがあります.それは,Green500 レベル3 の測定が HPL を実行する数時間だけなのに対して,PUE は数か月間から1年と長期間で測定する値だということです.長期間測定の特徴として,次が挙げられます.

1. 特定演算の消費電力ではなく,実際に実行されたバリエーションのある演算の消費電力に基づく値になる.

2. 実働するシステムの,外気温などの年間を通した変動に対する値になる(例えば,夏は冷却するための消費電力が増加する).条件の厳しい時期を避けて測定することができない.

3. 特定演算 (HPL, HPCG) では使われないストレージなどの電力も,長期間に実行された演算内容に応じ,実際に即してカウントされる.

(長期間測定に関して,Summit の PUE 値は HPL 実行時の短期間に限られていたため,年間の PUE 値は不明です.Shoubu system B の PUE = 1.2(発表資料12枚目)も同様に年間を通した値ではありません)

Shoubu system B の温度変化(発表資料10枚目)を見ると,開始時は20度で,HPL 実行とともに35度まで温度が上昇しています.HPL 実行のときだけ35度に設定し,それ以外は常に20度にしているのかどうか,Green500 レベル3では区別できません.冷媒を常に20度に保つなら PUE は増加しますが,省電力のために冷媒を常に35度に保つなら,PUE は減少します.しかし,PUE を下げるために 35度で保つと,20度のときよりプロセッサなどの消耗や故障率が増加するかもしれません.

5. PUE も指標の1つでしかない

工夫により,Shoubu system B の PUE を1に近づける方法が 3つあります.

1. HPL 測定時の PUE だけ下げれば良いなら,大量の冷媒を測定前に十分冷やしておきます.そして測定中は,プロセッサの熱で温まった冷媒を事前に冷やした冷媒と入れ替えます.冷媒を熱交換器で冷やさないので,HPL 測定時における熱源設備電力は 0 になります.この欠点は,短期間の測定にしか使えないこと,測定前に電力を使っているので実際の節電にはなっていないことです.この方法に近いのが,測定開始を20度にして,35度を冷却設定温度にした今回の測定です.

2. 十分冷却された水による熱交換から,(Summit などのように)常温冷却水による熱交換に変更します.省電力性能を強く打ち出して,温暖地域(埼玉県和光市の理化学研究所,茨城県つくば市の高エネルギー加速器研究機構 (KEK),神奈川県横須賀市の海洋研究開発機構 (JAMSTEC) )にシステムを設置するなら,常温水冷却に変更する方が節電にメリットがあり,PUE を下げられます.しかし,プロセッサの熱を受けた銅板を常温水で冷却するのに比べ,常温水でフロリナートを冷却し,フロリナートでプロセッサを冷却するという2段階冷却では温度勾配が緩やかになり,冷却効率が落ちるかもしれないのが欠点です.

3. さくらインターネットの石狩データセンターの区画を借りて,Shoubu system B を設置します.石狩データセンターはほぼ通年の外気冷房が可能で,PUE 値を 1.0x に抑えています.冷却水ではなく,外気で冷媒を(電気を使わずに)冷却すれば,Shoubu system B の PUE 値は発表資料12枚目にあるように 1.01 に近くなるでしょう.Summit など常温冷却水を使う省電力スーパーコンピュータの PUE 値 1.03 と同程度になるかもしれません.石狩だけではなく,寒冷地域や山岳地域も設置候補地です.

この方法の欠点は,良い PUE 値のシステムを再現する場所が限定されることです.ExaScaler の冷却システムを導入しても,その設置場所が石狩より温暖な地域であればあるほど,省エネルギー性能は落ちていき,関東地域(理化学研究所,KEK,JAMSTEC)への設置ではメリットは失われます.さらにその限定される寒冷,山岳地域に開発者やメンテナンスの技術者に移住してもらわなければ,システムの維持,運用は無理であることも欠点です.

つまり,省電力なシステムを組むために,フロリナートに浸ける冷却の Shoubu system B と常温水冷却の Summit のどちらを参考にするかは,PUE だけでなく,設置場所に大きく影響されます.Green500 レベル3 での比較だけで省電力性能が決まらないように,PUE 値だけでシステムの優劣が決まるとは限りません.複数の指標や要因から,システムの省電力性能を考えることが必要です.

3 で説明したように,PUE が低くても優れたシステムとしてどこにでも導入できるとは限りません.このことが,Green500 レベル3では熱源設備電力を含まない理由になっているかもしれません.つまり,熱源設備電力を含まないことで,設置した国や地域の場所を Green500 の順位に影響させないようにできます.赤道付近のシステム A と北海道石狩市のシステム B を比較するときに,熱源設備電力まで含めてしまうと,A が不利です.Top500 や Green500 の順位は国別の比較も行われるため,国や地域の場所に依存しない公平性を確保しているのかもしれません.

6. Shoubu system B がクロックを調整している可能性

Green500 - 理研の菖蒲システムBが連続して1位を獲得から引用します(強調は引用者による).

ちょっと話が横にそれるが、Green500ではOptimizedという測定も認めている。Optimizedの場合は、クロックと電源電圧を下げて、性能は下がるが性能/電力が最高になる条件での測定値を提出することができる。

実は今回のGreen500の2位~4位のシステムはOptimized測定である。2位のSaturn V VoltaはOptimized測定では15.133GFlops/Wであるが、Top500の測定条件では11.031GFlops/Wである。同様に、3位のABCIは12.054GFlops/W、4位のTSUBAME3.0は10.258GFlops/Wである。これらと比べると、Top500の測定条件で17.604GFlops/Wを出している菖蒲システムBのエネルギー効率はGreen500の表で見るよりも高いものがある。

これに関して,2018年前半の記録に関する記事 スパコンのエネルギー効率を競うGreen500 - 理研のシステムが連覇から引用します(強調は引用者による).

PEZY-SC2の演算性能は倍精度浮動小数点演算では4.1TFlops(1GHzクロック時)で、消費電力は計算値であるが200Wとなっているが、これは1GHzクロックの時の値である。Green500測定は、700MHzのクロックを使用し、菖蒲システムBの512チップの内の400チップを使用して行っている。この時のシステム全体の消費電力は47kWであり、PEZY-SC2チップ1個あたりの消費電力は117.5Wと計算される。

そして,販売代理店であるHPC システムズのページではクロックを 1GHz と明記して PEZY-SC2 を販売しています.鳥居氏による招待論文の表4でも PEZY-SC2 の動作周波数を 1GHz と明記しています(注釈はありません).

これらに対して,発表資料11枚目のグラフのキャプション4行目では「PEZY-SC2 @ MHz」と,意図的なのか偶然なのか,測定時のクロックがわからなくなっています.2017年11月の発表,2018年6月の発表(測定は2017年12月)ではどちらも 700MHz でした.

1GHz と 700MHz の違いの理由として,次の2つが考えられます.

1. 1GHz を700MHz に下げて測定しているのは,成績を上げるための調整.

2. 1GHz を 700MHz に下げているのでなく,700MHz が最大クロック.

1ならば調整と最適化の間に大差はありません.2ならば過去から現在まで 1GHz だと明記してきたクロックが誤りであり,PEZY Computing が公表している各種の数字の信頼性が大きく揺らぎます.

NVIDIA GPU の最適化について,NVIDIA Tesla V100 最大効率モードという説明があります.

新たな「最大効率モード」によりデータセンターの電源容量はそのままに、ラックあたり計算性能を最大40%向上させられます。このモードのTesla V100 は最大性能の80%を、最大消費電力の半分で実現します。

この説明から,もし Shoubu system B が 700MHz で測定したのならば,NVIDIA Tesla V100 の最適化と違いがほぼなく,Green500 の表で見るより Shoubu system B のエネルギー効率が高い,という主張は実際を反映していません.つまり,他が optimized であることに対する優位性はありません.

7. 電力効率測定の課題が変われば,演算効率も変わる

Green500 は HPL の演算回数をもとにしていますが,HPL はメモリ性能にほとんど影響されません.メモリ性能に影響される HPCG と HPL の平均を基準にした電力効率では,Shoubu system B は HPCG に関するデータを提出したシステムの上位10%に入りません.これは長くなったので,別の記事にしました.

まとめ

Green500 レベル3の結果では,PEZY Computing, ExaScaler が「冷却設備を含まない欠点がある」との批判に返答できないことを示しました.ExaScaler 取締役 CTO(最高技術責任者) 鳥居淳氏の主張は実際とは食い違っています.(エアコンのような)温度を下げる設備の電力はカウントせず,(サーキュレーターのような)冷媒を循環させる設備の電力だけをカウントするのは,設置機関の省電力につながりません.エアコンの電力を含む PUE がスーパーコンピュータの指標にならないという主張には,代表的な機関による反例があるため,強い根拠が必要ですが,何も示されていません.

ExaScaler は冷却装置を扱っていると思っていましたが,実際は外部で冷やされた冷媒を循環させる装置しか扱っておらず,冷媒の温度を下げるための電力は省電力に無関係だと主張しているのは驚きでした.研究機関に無料で提供しているだけにも関わらず,導入実績があるという記事がいくつも出ていたことに驚かされたときのようです.

ここまでは,PUE に関する Shoubu system B の省電力性能の疑問点を示しました.Green500 が HPL に基づく順位であることから起きる疑問は,次の記事に示しました.スーパーコンピュータの省電力性能に興味がある方はあわせてご覧ください.

この記事が気に入ったらサポートをしてみませんか?