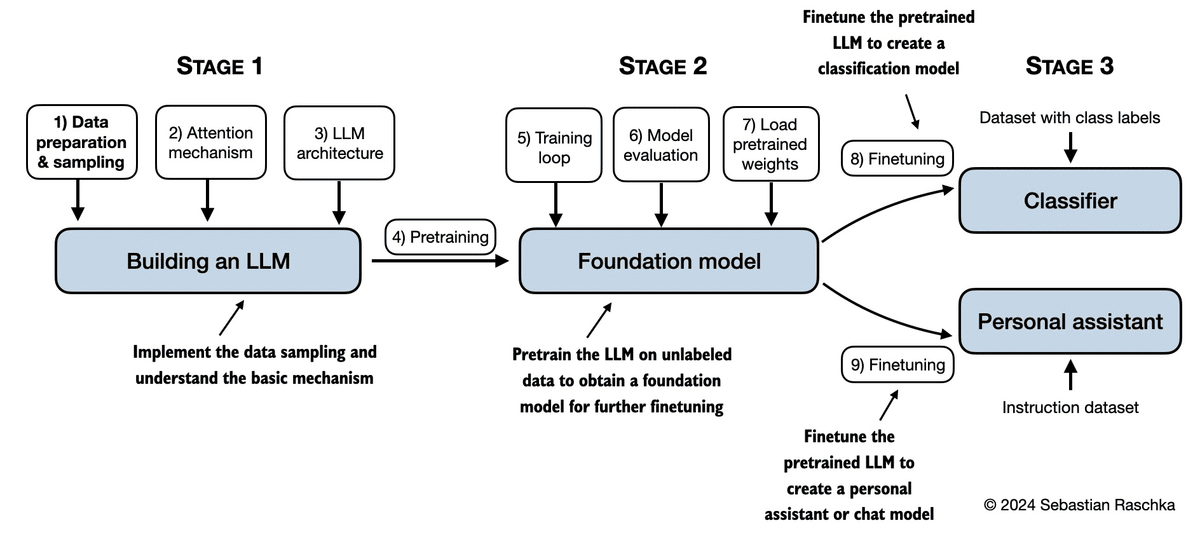

「LLMs-from-scratch」で学ぶLLMの基礎から応用まで

GitHubリポジトリ「LLMs-from-scratch」は、セバスチャン・ラシュカ著の「Build a Large Language Model (From Scratch)」の公式コードを格納しており、GPTのような大規模言語モデル(LLM)の開発、事前学習、ファインチューニングのための詳細なコードを提供しています。23.8kのスター数と2.5kのフォーク数が示す通り、このリポジトリは非常に人気があり、LLMの内部構造を理解し、ゼロから自分のモデルを構築する方法を学ぶための絶好のリソースです。

リポジトリの概要

リポジトリ名: LLMs-from-scratch

所有者: 人気AIリサーチャーのrasbt氏(https://twitter.com/rasbt)

スター数: 23.8k

フォーク数: 2.5k

コントリビューター数: 21 (+7 contributors)

使用言語: Jupyter Notebook (79.1%), Python (20.9%)

リポジトリの構成

各章の内容と対応するコードファイルがリストされています。

ハードウェア要件: 一般的なラップトップで妥当な時間内に実行できるように設計されており、特殊なハードウェアは必要ありません。また、GPUが利用可能な場合は自動的に使用されます。

ボーナス資料:

Pythonのセットアップ

データローダー

アテンションメカニズム

FLOPS分析

追加のファインチューニング実験

各章ごとに対応するコードファイルが詳細にリスト

第1章: LLMの理解

コードなし

第2章: テキストデータの取り扱い

ch02.ipynb

dataloader.ipynb

exercise-solutions.ipynb

第3章: アテンションメカニズムのコーディング

ch03.ipynb

multihead-attention.ipynb

exercise-solutions.ipynb

第4章: GPTモデルのゼロからの実装

ch04.ipynb

gpt.py

exercise-solutions.ipynb

第5章: ラベルなしデータでの事前学習

ch05.ipynb

gpt_train.py

gpt_generate.py

exercise-solutions.ipynb

第6章: テキスト分類のためのファインチューニング

ch06.ipynb

gpt_class_finetune.py

exercise-solutions.ipynb

第7章: 指示に従うためのファインチューニング

ch07.ipynb

gpt_instruction_finetuning.py

ollama_evaluate.py

exercise-solutions.ipynb

付録A: PyTorch入門

code-part1.ipynb

code-part2.ipynb

DDP-script.py

exercise-solutions.ipynb

付録D: トレーニングループへの追加機能

appendix-D.ipynb

付録E: LoRAによるパラメーター効率の良いファインチューニング

appendix-E.ipynb

LLMs-from-scratchリポジトリの目的と利用方法

誰に役立つのか?

AI研究者とエンジニア:

LLMの基礎から応用までを深く理解したい。

大規模言語モデルの開発と実装のスキルを向上させたい。

新しいモデルの研究や開発を進めたい。

大学生および大学院生:

AIと機械学習の授業や研究プロジェクトで使用するための実践的なリソースが欲しい。

GPTのような大規模モデルの内部構造とトレーニングプロセスを学びたい。

データサイエンティスト:

実際のプロジェクトでLLMを活用し、ビジネス上の課題を解決したい。

LLMのファインチューニング技術を習得し、特定のタスクに最適化されたモデルを作成したい。

どのように役立つのか?

実践的な学習リソース:

各章に対応したコードと詳細な解説により、理論だけでなく実践的なスキルも習得可能。

サンプルコードを通じて、モデルの構築、トレーニング、評価のプロセスを理解できる。

ハードウェア要件:

特殊なハードウェアを必要とせず、一般的なラップトップで実行可能なコードが提供されているため、多くのユーザーが手軽に試すことができる。

追加資料とサポート:

Pythonのセットアップ、データローダー、アテンションメカニズム、FLOPS分析、ファインチューニング実験など、様々な追加資料が用意されており、深い理解を助ける。

質問やフィードバックを共有できるDiscussionsフォーラムや、問題を報告するためのIssue提出が可能。

結論

GitHubリポジトリ「LLMs-from-scratch」は、LLMの基礎から応用までを学ぶための貴重なリソースです。セバスチャン・ラシュカの著書と連携しており、PythonとPyTorchを使用して、GPTのようなモデルをゼロから構築するための詳細なガイドとコードを提供しています。興味がある方は、リポジトリをチェックし、自分のLLMを構築してみてください。