Lec10: 重回帰分析②重回帰モデルの仮定とOLS推定量

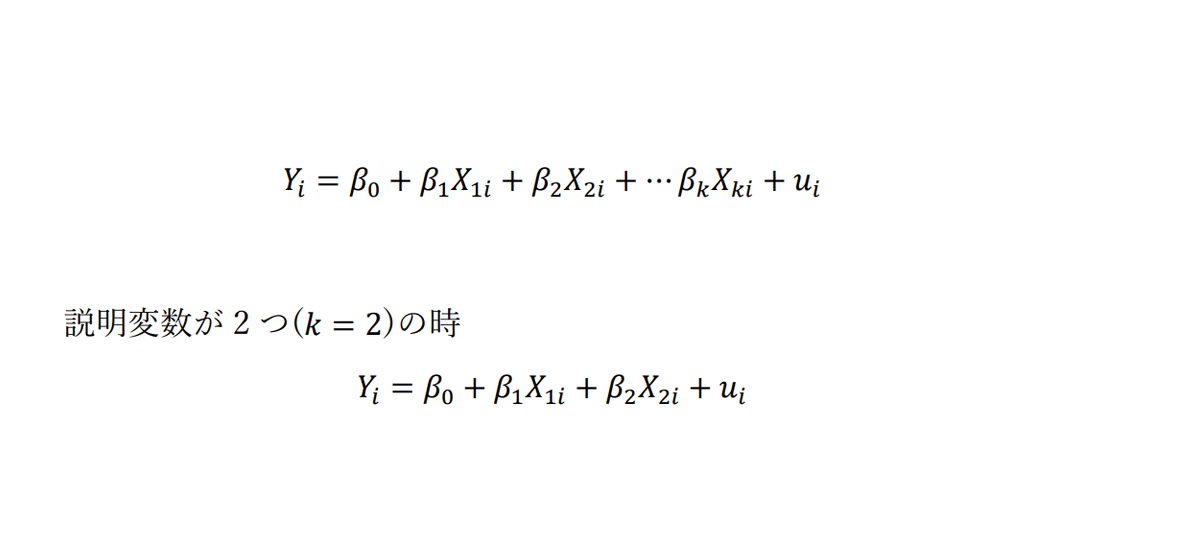

みなさんこんばんは。単回帰分析が一通り終了し、いよいよ先週から重回帰分析に入っていきました。重回帰分析とは、説明変数が複数あるモデルのことでしたよね。

説明変数を複数入れることで、誤差項の仮定Ⅳに反する内生性の問題を回避しやすくするというのが、重回帰モデルのメリットでした。今回は、重回帰モデルが説明変数ー被説明変数間の因果関係を厳密に描写するための仮定条件である誤差項の仮定とOLS推定量、決定係数についてお話します。いずれの内容も、単回帰分析の内容が分かっていれば全く問題なく理解できると思いますので、最後までお付き合いください。

1. 誤差項の仮定

重回帰モデルにおける誤差項の仮定は以下の通りです。

基本的には単回帰分析の時と変わりありませんが、仮定Ⅱのみ変更点があります。仮定Ⅱの説明変数同士は完全相関ではないとは、説明変数同士が完全相関(お互いが全く同じ動きをしている状態)だった場合、具体的な係数βの値を求めることが出来なくなりますので、説明変数はお互い独立関係でなければいけないということを記載したものになります。やはりこの中でも最も大切なのは、仮定Ⅳの誤差項の条件付期待値は0になるというものです。モデルを組み立てていく中で、常に意識しておく必要があります。また、結果に対するDiscussionの項目で、必ず内生性の問題が発生していないか、単回帰分析の時と比較して内生性の問題は改善されたかといった点については明記してください。卒論レベルだと、別に結果が要求されるわけではありません。分析の結果、統計的に有意なものが一つも得られなくても構いません。それ以上に、自身の作り上げたモデルに関して、内生性の問題はなかったのか、あるとすればどのような点なのか、改善するには今後どうすればよいのか(あるいは改善することが出来ないのか)、などといった点について丁寧に言及できていれば、もうそれは立派な卒論です。個人的な意見として、卒業論文はこれまで学んできたことの集大成なわけですので、結果の有無以上に、それに至るまでの過程を大切にしてほしいかなあと思っています。

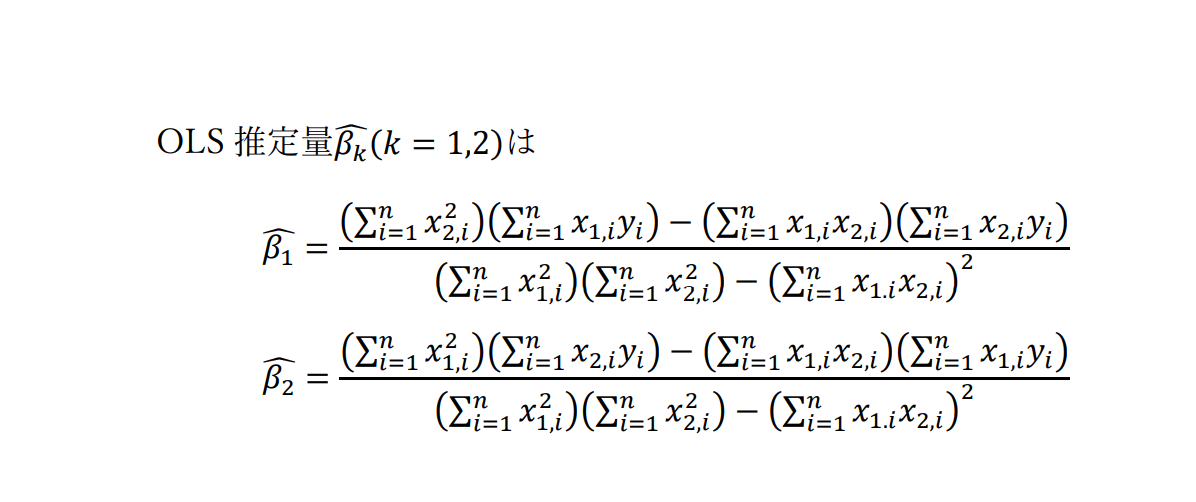

2. OLS推定量

やっていることは単回帰分析のときと全く同じです。ただし、計算が非常に煩雑になります。余力のある人は、説明変数が2個のケースの時の最小二乗推定量の導出はやってみてもいいかもしれません。(OSIPPの講義では宿題として出されました)。ここでは説明変数が2この場合の結果のみを記載しておくに留めます。

まあ、こんなものを手計算でする必要は基本的には無いわけですが、最小二乗法の原理だけはしっかりと抑えておいてくださいね。

3. 決定係数

モデルが実際のデータにどれくらい当てはまっているかを表す指標として、決定係数と呼ばれるものがありました。(Lec6参照)

ただし、この決定係数の弱点として、説明変数の数が大きければ多いほど決定係数の値が高く出てしまうという点が挙げられます。そこで、説明変数の数を考慮した上で計算された新しい決定係数を考慮することがあります。この決定係数のことを自由度修正済み決定係数(Adjusted R-square)と言います。

kは説明変数の数を表します。式を見比べたらわかる通り、自由度修正済み決定係数の方は決定係数と比較して(説明できない部分の変動)/(Yの総変動)の部分に(n-1)/(n-k-1)を掛けたものとなっています。明らかに(n-1)/(n-k-1)>1ですから、自由度修正済み決定係数は決定係数よりも低い値を取ります。また、場合によっては負の値を取ることもあるのが特徴です。重回帰分析においては、自由度修正済み決定係数の方もしっかり見るようにしましょう。(ただし卒業論文執筆の際は必ずしも言及する必要はありません。結果のみ記載しておけば十分でしょう。)

いかがでしょうか。重回帰分析の場合であっても、基本的には単回帰分析と変わりません。もし今日の内容で不安な点がございましたら、もう一度単回帰分析の方を見直して頂くと良いかもしれません。来週は説明変数や被説明変数の対数変換、ダミー変数、二乗項について説明した後、説明変数間で起こってしまう多重共線性について解説していきます。来週もどうかよろしくお願いいたします。

この記事が気に入ったらサポートをしてみませんか?