まえがき AdobeのFireflyのBetaが配信されてますますAI絵の凄さがAI絵を触ってない人にも伝わってきたように思います。

VRAM問題の解消法 私はRTX3080の10GBを使用してるのですがそれでも始めてからずっと生成に思ったよりも時間がかかったり、生成中にエラーが出たりしてました。

いつも生成時に9.8GBくらいメモリを使ってた 明らかになにかおかしいなぁって思いながらもサイズをいじったりしてなんとか動かしてたんですけどある日たまたま別件のエラーでTiled Diffusionを使用したときにError Value: float32~って感じのエラーが出てきたんですね。

まず全表示 ctrl+Fでfloatって検索してチェックを外す 設定を適用を押す(念のためUIの再読み込みをしておく) ControlNet(1.1) 私の中で最強の拡張機能ControlNetを紹介したいと思います。

インストール方法 を書きたいところなんですけど説明が面倒くさいし先人がいらっしゃいますのでそちらを確認してください。

また、1.1になりモデルが増えてますのでこちらも先人の方のやりかたを参考にしながら入れてください。

あとはControlNetを複数使う場合もありますのでその設定をします。

設定画面のControlNetタブを開く Multi ControlNet: 最大モデル数 (再起動が必要)という部分を3か4くらいにしておく おめー他人のブログに頼りっきりで結局なにも教えてねーじゃねえかって声が聞こえてきそうですけど私が紹介したいのはインストール方法ではなくその使い方やその活用方法ですので許して。。。

Tileモデル 私が個人的に一番お世話になってるのはTileモデルです。

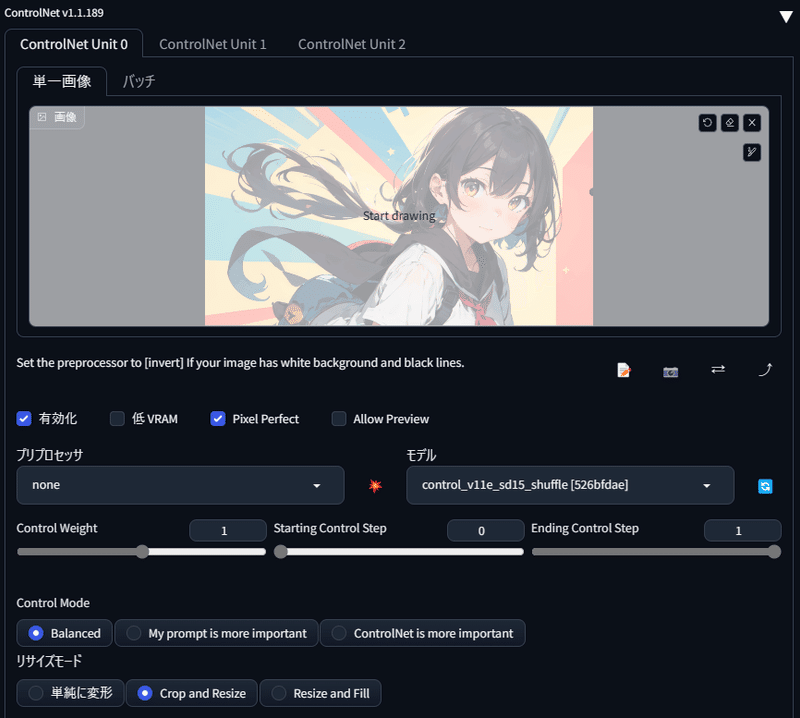

1girl, bowing, dynamic pose, coloful background, yellow theme, red theme, Negative prompt: easynegative Steps: 20, Sampler: DPM++ SDE Karras, CFG scale: 7, Seed: 3982442397, Size: 910x512, Model hash: a4ffd69ea9, Model: BreakDomainAnime_breakdomainanime_A0440, Clip skip: 2, Version: v1.2.1 そしたら、t2iのタブのままでいいのでwebuiを下にスクロールするとControlNetの項目があるのでクリックして開きます。

プリプロセッサはtile_resampleでもnoneでもいい 改めてControlNetの有効化にチェックが入ってるかを確認してから再度全く同じプロンプトや設定でいいので生成開始。

1girl, bowing, dynamic pose, coloful background, yellow theme, red theme, Negative prompt: easynegative Steps: 20, Sampler: DPM++ SDE Karras, CFG scale: 7, Seed: 3479762544, Size: 910x512, Model hash: a4ffd69ea9, Model: BreakDomainAnime_breakdomainanime_A0440, Clip skip: 2, Version: v1.2.1, ControlNet 0: "preprocessor: none, model: control_v11f1e_sd15_tile [a371b31b], weight: 1, starting/ending: (0, 1), resize mode: Crop and Resize, pixel perfect: True, control mode: Balanced, preprocessor params: (512, 64, 64)" なんということでしょう…。なんか書き込み量(ディテール)が増えてる感じがしますよね?この絵の場合は書き込みが少ないほうが味があるのでちょっと悪い例な気もしますがこんな感じに書き込み量を増やしたい場合にはとても有効です。

My prompt is more important Shuffleモデル 本当はControlNet1.0のころからあるopenposeとか1.1からできたlineartとかも紹介したいんですがそちらは絵師とかの人ほど嬉しい機能で私みたいに絵が描けない人からすると便利なのはわかるけどそもそもそれに使うようの絵を持ってないんだよなぁってなります。

モデルをshuffleに変えただけ そしたら、プロンプトは適当にcat girlにでもして猫娘にでもしてもらいますか。これで生成開始!

cat girl, Negative prompt: easynegative Steps: 20, Sampler: DPM++ SDE Karras, CFG scale: 7, Seed: 874243303, Size: 910x512, Model hash: a4ffd69ea9, Model: BreakDomainAnime_breakdomainanime_A0440, Clip skip: 2, Version: v1.2.1, ControlNet 0: "preprocessor: none, model: control_v11e_sd15_shuffle [526bfdae], weight: 1, starting/ending: (0, 1), resize mode: Crop and Resize, pixel perfect: True, control mode: Balanced, preprocessor params: (512, 64, 64)" すると何枚か作ってみるとわかりますがなんか雰囲気入れた画像と似てませんか?

プリプロセッサShuffle+Shuffleモデル 先程はプリプロセッサをNoneでやってましたが今回はプリプロセッサをShuffleにしてモデルはそのままShuffleでやってみましょう!

cat girl, Negative prompt: easynegative Steps: 20, Sampler: DPM++ SDE Karras, CFG scale: 7, Seed: 1508107673, Size: 910x512, Model hash: a4ffd69ea9, Model: BreakDomainAnime_breakdomainanime_A0440, Clip skip: 2, Version: v1.2.1, ControlNet 0: "preprocessor: shuffle, model: control_v11e_sd15_shuffle [526bfdae], weight: 1, starting/ending: (0, 1), resize mode: Crop and Resize, pixel perfect: True, control mode: Balanced, preprocessor params: (512, 64, 64)" 後ろの猫ちゃんがちょっと潰れてますけどあらあらいい感じの絵ができましたね!しかも背景もそれっぽいペイントアートみたいになってます!

ぐにゃんぐにゃんになった使用した絵 この2つのモデルを利用してプロンプトだけでは作りにくい絵を作ってみよう! ではここでちょっとした自分のこの2つの機能を使用したアイデアの出し方について紹介します。

生成を押してから中断させた絵 そしたらこれをControlNetに入れて再度プリプロセッサShuffle+Shuffleモデルで動かしてみてください。

モザイク絵をいれる すると失敗する絵も多いかもしれませんがときどきいい感じの構図になることがあります。

cat girl, Negative prompt: easynegative Steps: 20, Sampler: DPM++ SDE Karras, CFG scale: 7, Seed: 1143712726, Size: 910x512, Model hash: a4ffd69ea9, Model: BreakDomainAnime_breakdomainanime_A0440, Clip skip: 2, Version: v1.2.1, ControlNet 0: "preprocessor: shuffle, model: control_v11e_sd15_shuffle [526bfdae], weight: 1, starting/ending: (0, 1), resize mode: Crop and Resize, pixel perfect: True, control mode: Balanced, preprocessor params: (512, 64, 64)" 左上や左下、右上なんかはいい感じではないでしょうか(cat girlって言ってるのに猫が出るけど強度を変えたりプロンプト優先とかにしてみましょう)

None+Tileにしてスタート cat girl, Negative prompt: easynegative Steps: 20, Sampler: DPM++ SDE Karras, CFG scale: 7, Seed: 3825093830, Size: 910x512, Model hash: a4ffd69ea9, Model: BreakDomainAnime_breakdomainanime_A0440, Clip skip: 2, Version: v1.2.1, ControlNet 0: "preprocessor: none, model: control_v11f1e_sd15_tile [a371b31b], weight: 1, starting/ending: (0, 1), resize mode: Crop and Resize, pixel perfect: True, control mode: Balanced, preprocessor params: (512, 64, 64)" すると結構また味が違う絵ができましたよね?

今度はこっち 構図的にはいいんですけどちょっと顔がつぶれてしまってますね…。

cat girl, Negative prompt: easynegative Steps: 20, Sampler: DPM++ SDE Karras, CFG scale: 7, Seed: 316484214, Size: 910x512, Model hash: a4ffd69ea9, Model: BreakDomainAnime_breakdomainanime_A0440, Clip skip: 2, Version: v1.2.1, ControlNet 0: "preprocessor: none, model: control_v11f1e_sd15_tile [a371b31b], weight: 1, starting/ending: (0, 1), resize mode: Crop and Resize, pixel perfect: True, control mode: Balanced, preprocessor params: (512, 64, 64)" 諦めずにやってみようプロンプトをcatに変更して再チャレンジ cat Negative prompt: easynegative Steps: 20, Sampler: DPM++ SDE Karras, CFG scale: 7, Seed: 807913616, Size: 910x512, Model hash: a4ffd69ea9, Model: BreakDomainAnime_breakdomainanime_A0440, Clip skip: 2, Version: v1.2.1, ControlNet 0: "preprocessor: none, model: control_v11f1e_sd15_tile [a371b31b], weight: 1, starting/ending: (0, 1), resize mode: Crop and Resize, pixel perfect: True, control mode: Balanced, preprocessor params: (512, 64, 64)" あら、いい感じじゃないかしら?

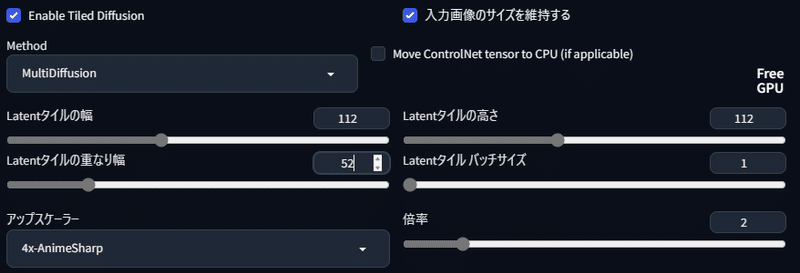

アップスケールして仕上げ できた絵をimg2imgに転送します。

img2imgに転送を押す そしたらサンプリングとかを適当に選びます。0.35 くらいまで下げることとTiled DiffusionをONにすることです。

ノイズ除去は沼なので上の感覚でいじってみよう Tiled Diffusionはアップスケーラーくらいの設定で十分 Tiled Diffusion内のRenoise strengthもノイズ除去と同じような項目なのだがとりあえずはいじらず、ノイズ除去強度で調整していい

cat Negative prompt: easynegative Steps: 20, Sampler: Euler, CFG scale: 7, Seed: 1760671747, Size: 1808x1024, Model hash: a4ffd69ea9, Model: BreakDomainAnime_breakdomainanime_A0440, Denoising strength: 0.35, Clip skip: 2, Version: v1.2.1, Tiled Diffusion upscaler: 4x-AnimeSharp, Tiled Diffusion scale factor: 2, Tiled Diffusion: "{'Method': 'MultiDiffusion', 'Tile tile width': 96, 'Tile tile height': 96, 'Tile Overlap': 48, 'Tile batch size': 1, 'Upscaler': '4x-AnimeSharp', 'Upscale factor': 2, 'Keep input size': True, 'NoiseInv': True, 'NoiseInv Steps': 10, 'NoiseInv Retouch': 1, 'NoiseInv Renoise strength': 1, 'NoiseInv Kernel size': 64}" ちびねこが生成されてしまった…。

数値の横に出てくる↑を1クリックずつしていく cat Negative prompt: easynegative Steps: 20, Sampler: Euler, CFG scale: 7, Seed: 1476441406, Size: 1808x1024, Model hash: a4ffd69ea9, Model: BreakDomainAnime_breakdomainanime_A0440, Denoising strength: 0.35, Clip skip: 2, Version: v1.2.1, Tiled Diffusion upscaler: 4x-AnimeSharp, Tiled Diffusion scale factor: 2, Tiled Diffusion: "{'Method': 'MultiDiffusion', 'Tile tile width': 112, 'Tile tile height': 112, 'Tile Overlap': 52, 'Tile batch size': 1, 'Upscaler': '4x-AnimeSharp', 'Upscale factor': 2, 'Keep input size': True, 'NoiseInv': True, 'NoiseInv Steps': 10, 'NoiseInv Retouch': 1, 'NoiseInv Renoise strength': 1, 'NoiseInv Kernel size': 64}" 見事ちびねこも消えて全体的にもいい感じなったのではないだろうか!

あとがき 今回の表紙絵はドラグノイドというテーマで作成した。

parameters mecha dragon, Over the city, explosion, bombing, hologram, glowing eye, Negative prompt: EasyNegativeV2, watermark, Steps: 20, Sampler: Euler, CFG scale: 7, Seed: 751310082, Size: 3616x2048, Model hash: f183384556, Model: BreakDomainRealistic_breakdomainrealistic_R2333, Denoising strength: 0.55, Clip skip: 2, Version: v1.2.1, Tiled Diffusion upscaler: 4x-UltraSharp, Tiled Diffusion scale factor: 2, Tiled Diffusion: "{'Method': 'MultiDiffusion', 'Tile tile width': 128, 'Tile tile height': 128, 'Tile Overlap': 56, 'Tile batch size': 1, 'Upscaler': '4x-UltraSharp', 'Upscale factor': 2, 'Keep input size': True, 'NoiseInv': True, 'NoiseInv Steps': 10, 'NoiseInv Retouch': 1, 'NoiseInv Renoise strength': 1, 'NoiseInv Kernel size': 64}" 次回は地味にControlnetの本命に近いreference-onlyのプリプロセッサについて紹介したいと思いますので楽しみに待っていてほしい。