Unreal Engine リアルタイムフェイシャルキャプチャ

ここ2年ほど3DCGの学び直しとして、Unreal Engineの自己学習を続けているが、結構めげている。途中で挫折しないように、興味があるものの範囲から取り組むのだ!と、今回 公式のサンプルデータとツールを使って、リアルタイムフェイシャルキャプチャを動かせた(涙)というのも、リアルタイムフェイシャルキャプチャは数年前にリリースされていたが、簡易的とはいえiOSの開発を行う必要があり、それがハードルとなっていたのだが、最近アプリをリリースしてくれたので、連携するだけでOKとなったのである!

その作業成果?をここに記したい。

UEの入っているPCとiPhoneをつなぐ

PCのIPv4アドレスをチェックする

iPhone(iPad)にLive Link Faceをインストール

Live Link Face for Unreal Engine

AppStoreには、iOS13以降と書いてあったけれど、TrueDepthカメラを持つiPhone・iPadでしか動かないと思われます。ちなみに私が使用したのは、iPhoneXです。

Live Link Face Appの設定

左上の設定のアイコンから、LiveLinkをタップ、サブジェクト名はデフォルトでは自分で設定したiPhone端末の名前になっているが、特に変更が必要ではない。続いて、サブジェクト名をタップして開いたターゲット情報のIPアドレスに、先程チェックしたPCのIPv4アドレスを入力して設定完了。

Unreal EngineのFace AR SampleシーンとiPhoneをリンクさせる

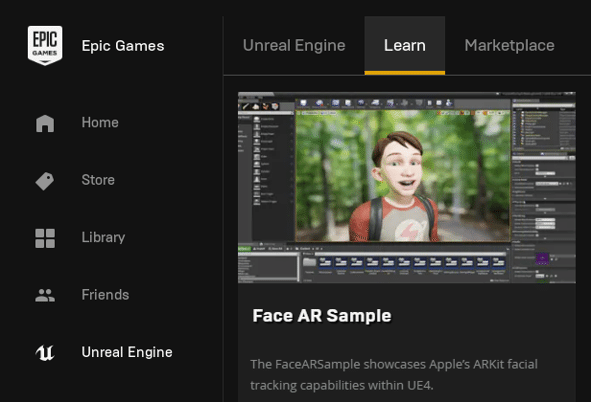

Face AR Sampleは、Learnから入手するのが簡単です。マケプレに飛ぶので、マケプレからも入手できるはずだけれど、なぜか検索に出てこない…。

シーン作成直後の事前準備

Edit >Plugin Built-inカテゴリに、Apple ARKit Apple とARKit Face Support のチェックボックスがONになっているかを確認。またGUIにLiveLinkウィンドウを追加しておく。iPhoneの接続状態が見れるのであると便利です。

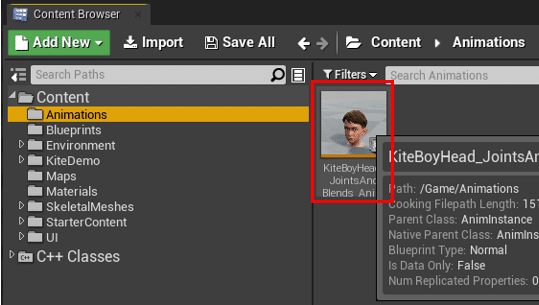

iPhoneを繋げるAnimBP

まず躓くのが、BPフォルダにない!どこのBPいじるんじゃ!です。そもそもはBPでも、アニメーションBPなので、ここを見るべきだったんですね。

Content>Animation>KiteBoyHead_...をダブルクリック

Live Link Poseのプルダウンリストから、リンクさせたい端末を選んで、このAnimBPをCompileする

LiveLinkウィンドウから、選んだ端末の名前が出て緑のランプが付けば完了!

注意

ここまで何事もなく上手く行った訳ではなく、実際このBP設定で端末の名前が出ず、めちゃくちゃ手こずってしまったのです。細かい設定の説明を端折っている動画やサイトが多く、Bluetoothも繋がっているし、WIFIも同じネットワークなのに、これ以上どうすんねん!と机に突っ伏しました。

で、どう解決したのかは、セキュリティソフトの「ネットワーク保護(ファイヤーウォール)」の解除でした。初歩的なことかもですが、何時間も違う箇所の設定をやり直していたので、これが原因だと分かって、即iPhoneが現れた時は脱力しました。

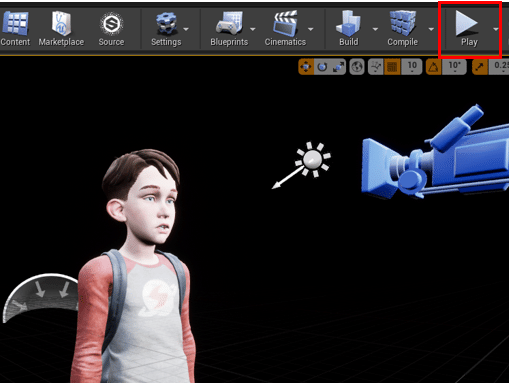

LevelでPlayする(シーンで実行)

先程のBP上でも、iPhoneと繋がったらプリビューでカメラを使った動作確認できていましたが、実際のシーンでも動かしてみましょう。

シーンを開いたときにすでに開いていたLevelでPlayボタンを押して実行、上記で繋げたLiveLinkアプリを使って少年の表情を操作します。

でかい画面で見ると、瞳がHDRIの背景なのか写り込みが結構リアルに感じて、感動しました。操作は、普段の自分の表情筋が動いていないのもあり、結構頑張って表情をつけないと、キャラクターの表情が薄くなってしまいます。普通アニメの表情は、豊かだったり、デフォルメ表現というセオリーや今までの視聴経験があるので、そこに標準を持っていくには、人間もそれくらい表現できなきゃ、CG結果も物足りなくなると思われます。そういう意味ではデフォルメしやすいように、CGの表情やパラメータを調整すればいいのだろうけど、アクターの出したいさじ加減があるとしたら、現場でのカスタマイズ・調整というところなのかな。

後はTipsというほどでもないけれど、Level内のカメラは近すぎるので、ちょっと離してやるといいかもです。

次はやっぱり自作キャラに、この仕組を使いたくなるということなんだけど、UE Japanの中の人が以下にやり方やツールを書いてくださっています。

【UE4】Live Link Face for Unreal Engineを使って、あなたのキャラクタの表情を動かす方法

【UE4】フェイシャルキャプチャ時における、Live Link Remap アセットを使ったカーブ名の再マッピングについて

ここに至る概念は分かっていたとしても、その前にキャラモデリングとフェイシャルエクスプレッションのセットという作業が待ち構えている。その前にVRCのアバタから入ったほうがいいのかも…と、気持ちが迷走しはじめている。とにかくまずやるのは、Blenderでキャラモデリングや!(多分続く)

参考Youtubeはこちら

iPhoneとUE4でVTuberになろう♪

iPhone Facial Capture with Unreal Engine | Unreal Fest Online 2020(英語)

Live link Face App Unreal Engine 4(英語)

情報化時代あらゆる物がオンラインに転がっているとはいえ、UEの最新ツールの紹介で初心者に向けて懇切丁寧なものは、少ないのも事実。初心者に毛が生えかけているレベルの者は、その差分を埋めるのにヒーヒー言って、検索に次ぐ検索をやっているのであった。

その程度で困っている人向けに今回記事をアップしてみました、よかったら「いいね」ください!(^o^)

コーチとして学ぶための書籍の購入と、noteの有料記事の購読にあてたいと思っています。