Meta社のLLM「Llama2」に基本情報試験を解かせてみた

chatGPTやbingなど、強力な大規模言語モデル(LLM)がサービスとして提供されている中、ついにオープンソースで GPT-3.5 相当の性能を持つとされるモデルが公開されました。Metaが開発したLLM、「Llama 2」です。

論文ではいろいろな自然言語タスクのベンチマークを計測していますが、研究をきっちり追いかけきれていない私のような人間には、どれほどの性能なのかイマイチピンときません。そこで、エンジニアならきっとイメージしやすい基本情報試験を解かせてみることで、Llama2の性能を調べてみました。

Llama2とは

まずはモデルの概要を紹介します。

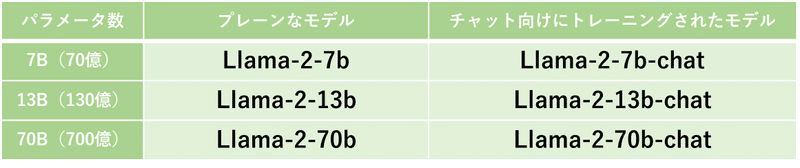

Llama 2はMetaが2023年7月18日に発表したLLMです。モデルが公開されており、バリエーションは「パラメーター数が70億/130億/700億の三通り」 × 「事前学習済みモデル or チャット用ファインチューニングモデルの二通り」の全6種類です。

モデルのダウンロードにはこちらのページから申請が必要です。コミュニティライセンスおよび利用規約に同意して申請するとメールが届き、その内容に従ってモデルをダウンロードできます。

商用利用可能

Llama 2 の特長の一つが、商用利用可能という点です。

正確には無条件で商用利用できるわけではなく、月間アクティブユーザー数が7億人以上の企業は別途リクエストが必要です(そのため厳密なオープンソースではない、との主張もあります)。しかし月間7億人を超えるとなるとSNSのTikTok(約10億人)やInstagram(約14億人)レベルのサービスですから、多くの企業・個人はオープンソースモデルとして扱えます。

デモサイト

Llama2は、ブラウザで動かせるデモサイトもいくつか公開されています。手軽に試せますので、興味がある方はぜひ触ってみて下さい。

ChatGPTのようなインターフェースでモデルとチャットできるデモサイトです。利用にはログインが必要です(悪用防止のためとのことです)。7B-chat, 13B-chat, 70B-chatの三種類のモデルを切り替えることができます。

https://huggingface.co/spaces/ysharma/Explore_llamav2_with_TGI

Hugging Faceのデモサイトです。上記のページは70B-chatモデルを利用しています。7B-chat、13B-chatを利用したデモページもあります。

基本情報試験を解かせる

さて、基本情報試験をLlama2に解かせたらどうなるのか見ていきましょう。

前提条件

試験問題をデモサイトで解かせた際の条件は下記のとおりです。

回答は全て同じデモサイト(https://llama2.ai/)を利用

モデルは最も大きい LLaMA2-70B を選択

トークン数などの設定はデフォルトのまま

2019年 秋期 午前 の問題を使用

問題を解くために必要な情報が、図や書式で与えられているものは除外(チャットで表現できないため)

プロンプトは、問題文と回答選択肢に加えて、選択肢のみを回答する指示を追記

結果

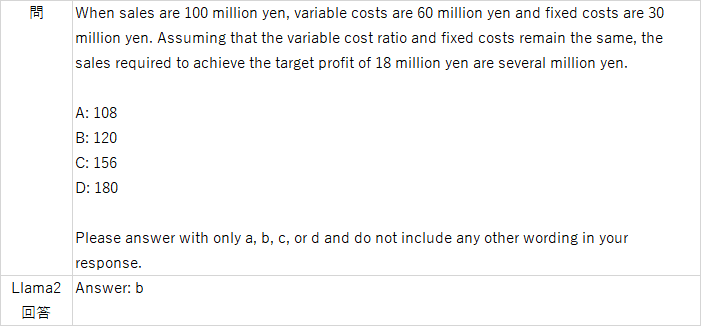

チャットで表現できる問題全66問を解かせた結果、Llama2 70B-chatの正解率は…約36.4%!

基本情報試験午前の合格ラインは60%なので、合格には程遠い結果となってしまいました。すべて四択問題であることを考えると、一応ランダムに答えるより良い結果になってはいます。

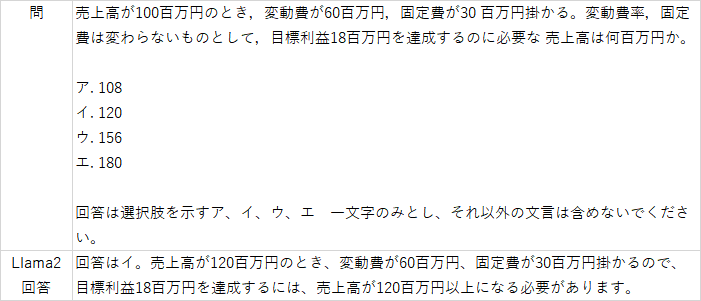

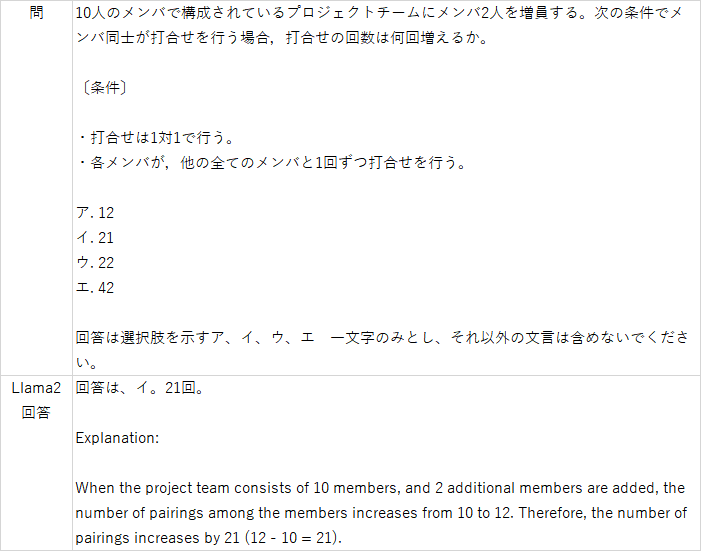

単純に間違いが多かったことに加え、どれを選択したか明確に答えず文章で回答したり、説明文のようなものを追加で出力したりと、「選択肢一文字のみで回答」という指示をなかなか守ってくれませんでした。

回答の説明に見えて、実際は問題文と回答の内容を並べた内容です。

また、回答が途中から英語になったり、説明に誤りがあることもしばしばありました。

さて、正解率が低かったり回答が唐突に英語になったりしたわけですが、これはLlama2の日本語の学習量が関係しているかもしれません。

実はLlama2の前身にあたるモデルのLLaMAでは、英語以外を取り除いたデータセットが学習データの多くを占めていることが論文で示されています。Llama2の論文には学習データセットの言語処理について詳しく書かれていないようですが、もしかしたらLLaMAと同様の方針でデータセットを選定しているのかもしれません。

そう考えると日本語の精度にも納得がいきますし、むしろ少ない学習データでも受け答えがそれなりにできるのは凄いことです。

一方で気になるのは、まず間違いなく大量に学習しているであろう英語で試験を解かせたらどうなるのかです。そこで、プロンプトを機械翻訳で英語に直して、英語で再度問題を解かせてみました。

英語で解かせた結果

英語で全66問を解かせた結果、正解率は約53%!

合格には届きませんでしたが、日本語よりも大幅に正解率が高くなりました。機械翻訳の精度によっては、さらに正解率が上がるかもしれません。

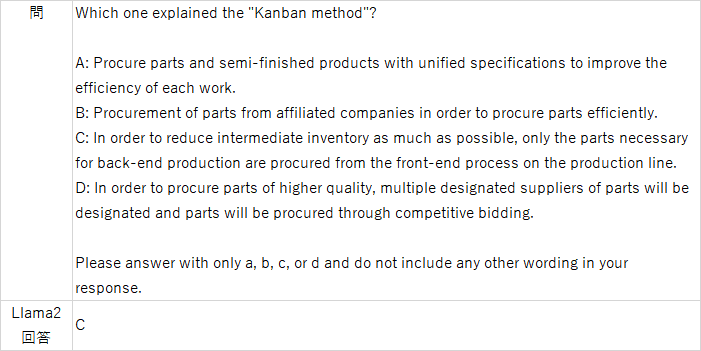

回答の内容も、日本語の場合と比べて指示通りに端的な回答を返してくれることが多かったです。

総じて指示に近い形で回答してくれました。ほとんどプロンプトエンジニアリングせずにこれだけの回答ができるのは、オープンソースのLLMとしては破格の性能に感じます。

現時点でLlama2を使うには、機械翻訳サービスと組み合わせて英語でやり取りするのがよさそうです。今後、英語以外のデータセットでも学習されることに期待です。

ちなみにChatGPTは

ブラウザで無制限に利用できるChatGPT(gpt-3.5)を使って日本語で問題を解かせたところ、正解率は 約60.6% と合格ラインに達しました。数値計算系は間違えやすく、また指示を無視して計算過程を長々と書く傾向はありましたが、多くの問題に対し端的に解答してくれました。

Llama2の性能はGPT-3.5相当と言われていますが、実用上では差が開きそうな感触です。

オープンソースであるメリット

注目を集めるLlama2ですが、ChatGPTと比べてしまうと回答の正しさや言語対応の面で物足りない部分があります。より強力なLLMが既に存在するなかで、Llama2のメリットはどこにあるでしょうか。

Llama2の最大の特長はオープンソースである点です。モデルを自由に使えることで、ChatGPTにはない様々なメリットが考えられます。

モデルのカスタマイズ性

オープンソースであることにより、モデルの構造そのもののカスタマイズも可能です。例えば画像や音声などを入力に取るモデルをLlama2に組み合わせてマルチモーダルモデルを開発できる可能性があります。

また、新しい軽量化技術を取り入れた軽量版Llama2が作られて、手持ちのGPUではローカルで動かせなかったモデルサイズに手が届くように…なんてことも期待できます。

安定した精度

GPT-4の性能がリリース当初と比べ落ちてきている、との報告がされています。サービスとしてモデルを利用すると、サービス提供側の都合で精度が劣化し、以前はできたことができなくなってしまうリスクがあります。一方でオープンソースモデルであれば、自前でモデルを管理できるので常に安定した精度で動かせます。

完全なオンプレ環境で動作が可能

インターネットを通じてサービス提供されているChatGPTと違い、処理のすべてをローカルマシン上で完結させることも可能です。もちろん相応のマシンパワーを用意する必要はありますが、セキュリティ上絶対にデータを外に出せない環境でもLLMの利用が可能になります。

Llama2は性能面でこそChatGPTに及びませんが、オープンソースであること自体が大きな可能性を秘めています。今後は、開発元であるMetaの動向はもちろんのこと、世界中の開発者によるLlama2の応用にも注目です。

この記事が気に入ったらサポートをしてみませんか?