【第4回】テキスト分類とクラスタリング:自然言語処理の教科書

1. 概要 (Overview)

テキスト分類とクラスタリングは、大量の文書やテキストデータを分析し、関連性やカテゴリーに基づいて整理するための重要な手法です。これらの技術は、ウェブページの分類、ニュース記事のトピック分析、顧客のフィードバックの感情分析など、多岐にわたるアプリケーションで使用されます。

TF-IDFの理解と実習

TF-IDF (Term Frequency-Inverse Document Frequency) は、文書中の単語の重要度を評価するための統計的手法の一つです。TF-IDFは、文書内の単語の出現頻度 (TF) と、文書集合全体でのその単語の出現頻度 (IDF) の逆数を乗算することで計算されます。この手法は、ある単語が特定の文書内でどれだけ重要かを評価するのに役立ちます。

具体的には、TFは単語が文書内で出現する頻度、IDFはその単語が他の文書でどれだけ出現するかの逆数を示しています。したがって、TF-IDFの値が高い単語は、その文書において重要であると考えられます。

基本的なテキスト分類アルゴリズムの実習

テキスト分類は、与えられたテキストをあらかじめ定義されたカテゴリやラベルに分類するタスクです。テキスト分類の一般的なアプローチには、ナイーブベイズ、サポートベクターマシン、ロジスティック回帰、ニューラルネットワークなどがあります。これらのアルゴリズムは、特徴としての単語やフレーズの出現頻度に基づいてテキストを分類します。

それでは、TF-IDFの実習と基本的なテキスト分類アルゴリズムの実習に進みましょう。

2. なぜプロンプトエンジニアの専門知識なのか

テキスト分類とクラスタリングの知識は、プロンプトエンジニアとしての役割において極めて重要です。以下に、この知識がどのように役立つのか具体的なシナリオを示します。

1. 生成AIの理解深化

プロンプトエンジニアは、生成AIの背後にある仕組みを理解する必要があります。多くの生成AI、特にLLM(Large Language Models)は、テキストデータの大量のサンプルを元に学習を行います。このデータセット内のテキストの「分類」や「クラスタリング」は、モデルが言語のパターンを学ぶ上での基盤となります。TF-IDFのような手法は、モデルが特定のトピックやキーワードの重要性を評価する際の基盤となるため、これを理解することで、エンジニアは生成AIの出力の質や構造をより深く理解できるようになります。

2. 高品質なプロンプトの作成

プロンプトエンジニアの主な役割の一つは、AIに対する高品質なプロンプトの作成です。テキスト分類の知識は、特定のレスポンスを引き出すためのプロンプトを設計する際のガイダンスとなります。例えば、特定のカテゴリの情報を求める場合や、特定の感情やトーンでのレスポンスを望む場合など、テキスト分類の原則を利用してプロンプトを最適化することができます。

3. 生成AIの出力の評価と選択

生成AIからの出力を評価し、最も適切なレスポンスを選択する能力は、プロンプトエンジニアにとって重要です。テキスト分類とクラスタリングの技術を使用することで、出力されたテキストがどのカテゴリに属するのか、またどのようなトピックや感情を持っているのかを迅速に評価することができます。これにより、エンジニアはより適切なレスポンスを迅速に選択することができるようになります。

総じて、テキスト分類とクラスタリングの知識は、プロンプトエンジニアが生成AIとの相互作用を最適化するための鍵となります。これらの技術を理解し、適切に活用することで、エンジニアはより高品質なプロンプトを作成し、生成AIの出力を評価・選択する能力を向上させることができます。

3. 具体的な定義・原理 (Definitions & Principles)

TF-IDF (Term Frequency-Inverse Document Frequency)

定義:

TF-IDFは、文書中の単語の重要度を評価するための統計的手法です。

原理:

TF (Term Frequency): ある単語が特定の文書内での出現頻度。文書内のその単語の出現数を文書の総単語数で割ったもの。

IDF (Inverse Document Frequency): 単語がどれだけ珍しいかを示す指標。全文書数をその単語が出現する文書数で割ったものの対数。

TF-IDFの値は、TFとIDFの積として計算されます。

この値が高ければ高いほど、その単語はその文書にとって重要であると言えます。

テキスト分類

定義:

テキスト分類は、与えられたテキストを事前に定義されたカテゴリやラベルに分類するタスクです。

主要なアルゴリズムと原理:

ナイーブベイズ: 確率的な手法で、各カテゴリが与えられたテキストを生成する確率を計算し、最も確率が高いカテゴリを選択します。ベイズの定理に基づいています。

サポートベクターマシン (SVM): データを高次元の空間にマッピングし、カテゴリ間の最適な境界を見つけることを目的とするアルゴリズム。

ロジスティック回帰: 与えられたテキストの特徴に基づいて、テキストが特定のカテゴリに属する確率を計算するアルゴリズム。

ニューラルネットワーク: 多層のニューロンモデルに基づく深い学習アルゴリズム。大量のデータと計算能力が必要ですが、高い精度を持つ場合があります。

これらのアルゴリズムは、テキストの特徴、例えばTF-IDFのような単語の重要度や単語の出現頻度などを基にして動作します。

4. 具体例 (Examples)

例1: TF-IDFの実例

文書A: "猫はかわいい動物だ。猫は毛が柔らかい。" 文書B: "犬は忠実な動物だ。犬は走るのが速い。"

ここで、単語「猫」のTF-IDFを文書Aについて計算しましょう。

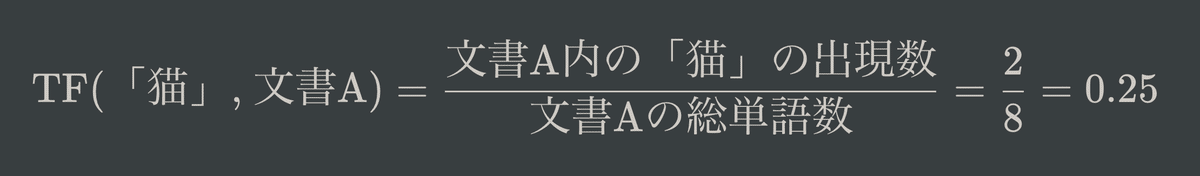

TF:

IDF:

TF-IDF:

この値が示すのは、単語「猫」が文書Aにとってどれだけ重要かということです。

例2: ナイーブベイズを用いたテキスト分類

ニュース記事を「スポーツ」と「政治」の2つのカテゴリに分類するとしましょう。ある記事に「選手」「試合」「得点」などの単語が多く含まれていれば、その記事は「スポーツ」カテゴリに分類される可能性が高いです。一方、「選挙」「政府」「議員」などの単語が多く含まれていれば、「政治」カテゴリに分類される可能性が高いです。ナイーブベイズは、これらの単語の出現確率を基にして、記事がどちらのカテゴリに属するかを判断します。

例3: ロジスティック回帰による感情分析

映画のレビューを「ポジティブ」と「ネガティブ」の2つのカテゴリに分類するタスクを考えます。ロジスティック回帰は、各レビューの単語の出現頻度やTF-IDFなどの特徴を入力として、そのレビューが「ポジティブ」か「ネガティブ」かの確率を出力します。たとえば、「素晴らしい」「感動」「最高」などの単語がレビューに含まれていれば、そのレビューは「ポジティブ」である確率が高くなるでしょう。一方、「退屈」「最悪」「がっかり」などの単語が含まれていれば、「ネガティブ」である確率が高くなります。

5. 応用例 (Applied Examples)

例1: 情報検索エンジンの改善

問題: オンライン書店で、顧客が関心を持つであろう書籍を効果的に検索・推薦する必要がある。

応用: TF-IDFを利用して、ユーザーが入力したキーワードと各書籍の内容の間の関連性を評価します。高いTF-IDFスコアを持つ書籍は、ユーザーの検索クエリに関連性が高いと判断され、検索結果の上位に表示されます。

例2: ソーシャルメディアの感情分析

問題: あるブランドや製品に関するソーシャルメディアのフィードバックを分析し、顧客の感情や意見を把握したい。

応用: テキスト分類アルゴリズム(例えば、ロジスティック回帰)を用いて、ソーシャルメディアのコメントやレビューを「ポジティブ」、「ネガティブ」、「ニュートラル」のカテゴリに自動的に分類します。これにより、ブランドの評判や製品の質に関する顧客の意見を迅速に把握し、必要に応じて対応を行うことができます。

例3: オンラインニュースの自動カテゴリ分類

問題: 大量のオンラインニュース記事を迅速に適切なカテゴリに分類する必要がある。

応用: ナイーブベイズやニューラルネットワークなどのテキスト分類アルゴリズムを使用して、ニュース記事を「スポーツ」、「政治」、「エンターテインメント」などのカテゴリに自動的に分類します。これにより、読者にとって関心のあるトピックのニュースを効果的に提供することができます。

6. 手法・技法 (Methods & Techniques)

テキスト分類とクラスタリングを行う際には、さまざまな手法や技法が存在します。以下では、その中から代表的な3つの手法を取り上げ、具体的に解説します。

1. Bag of Words (BoW)

定義:

BoWは、テキストの特徴を抽出するための最も基本的な方法の一つです。この手法では、テキストを単語の「袋」として扱い、各単語の出現頻度や存在を特徴として使用します。

方法:

テキストのコーパス全体でのユニークな単語のリスト(語彙)を作成する。

各テキストを、この語彙に基づいてベクトルとして表現する。ベクトルの各要素は、対応する単語の出現頻度や存在(0 or 1)を示す。

2. TF-IDFベクトル化

定義:

TF-IDFベクトル化は、テキストを数値ベクトルとして表現するための手法です。BoWとは異なり、単語の重要度を考慮してベクトル化します。

方法:

全文書の単語のTFとIDFを計算する。

各テキストを、TF-IDFの値に基づくベクトルとして表現する。

3. Word Embedding (単語埋め込み)

定義:

Word Embeddingは、単語を低次元の密なベクトルとして表現する手法です。このベクトルは、単語の意味的な関連性を捉えることができます。

方法:

大量のテキストデータを使用して、単語の共起関係や文脈を分析する。

単語を固定長のベクトルとして表現する。このベクトルは、単語の意味的・文脈的な情報を反映しています。

代表的な手法には、Word2Vec, GloVe, FastTextなどがあります。

これらの手法や技法は、テキストデータの前処理や特徴抽出の段階で使用されることが多く、テキスト分類やクラスタリングのアルゴリズムの入力として利用されます。適切な手法を選択することで、テキストの情報を効果的に捉え、高い性能のモデルを構築することができます。

7. 演習問題 (Exercises)

問題1: TF-IDFの変動

大規模なテキストデータセットにおいて、ある特定の単語のTF-IDFスコアが非常に高いことが分かったとします。この単語のTF-IDFスコアを低くするためには、データセットにどのような変更を加える必要がありますか?

問題2: 感情分析の混同

テキスト分類モデルを使用して、映画レビューの感情分析を行っています。モデルは、「これは素晴らしい映画で、最悪のシーンもない」というレビューを「ネガティブ」と分類しました。このような誤分類の可能性の原因として考えられるものを3つ挙げ、それを解決するための方法を提案してください。

問題3: Word Embeddingの解釈

Word2VecやGloVeなどのWord Embedding手法を用いて、単語のベクトル表現を取得しました。2つの異なる単語、例えば「王」と「男」と「女」のベクトルを持っています。次の数式が意味することを解釈してください。

vec("王")−vec("男")+vec("女")

これに関連する有名な結果とは何ですか?

これらの問題は、単純な知識の再生ではなく、理解と応用の深いレベルでの考察を必要とします。これにより、学習者はNLPの知識をより深く理解し、実際の問題解決に役立てることができるようになります。

8. 解答・模範解答 (Solutions & Model Answers)

問題1: TF-IDFの変動

模範解答: TF-IDFスコアを低くするためには、以下の方法が考えられます:

TF (Term Frequency) を減少させる: 該当の単語が文書内での出現頻度を減少させることで、TF値が低くなります。

IDF (Inverse Document Frequency) を減少させる: 該当の単語が他の多くの文書にも頻繁に出現するようにすると、IDFの値は低くなります。これは、その単語が一般的であると見なされ、特定の文書にとっての重要度が低下することを意味します。

問題2: 感情分析の混同

模範解答:

可能性の原因:

モデルは「最悪」という単語を重要な特徴として捉え、ネガティブな感情を示す指標として解釈した。

訓練データには、類似の文脈で「最悪」という単語がネガティブなレビューとして使われていた可能性がある。

モデルが文の全体的な文脈や否定語を適切に捉えることができなかった。

解決方法:

モデルの訓練データを増やし、多様な文脈での「最悪」の使用例を学習させる。

文脈や否定語をより適切に捉えることができるモデル構造(例: LSTMやTransformer)を採用する。

モデルの訓練時に、誤分類のペナルティを増やすなどの正則化手法を試す。

問題3: Word Embeddingの解釈

模範解答: 数式は、単語「王」から「男」の意味を引いて、「女」の意味を足すことを示しています。これは、性別に関するアナロジーを表現するための一般的な方法で、有名な結果として、この計算が「女王」のベクトルに非常に近くなることが多いです。これはWord2VecなどのWord Embedding手法が単語の意味的関係を捉える能力を示す一例として知られています。

別解:

単語埋め込みの技術は、単語の意味的・文法的な関係性を低次元のベクトル空間内で捉えることができる。このため、上記のようなアナロジーのタスクで高い性能を示すことが多い。

参考となる別問題とその模範解答:

問題: Word2Vecのモデルを訓練する際の「スキップグラム」と「CBOW」の2つのアプローチの違いを説明してください。

解答:

スキップグラム: 中央の単語からその周囲の単語を予測するアプローチ。例えば、"the cat sat on the" というフレーズが与えられた場合、"cat" から "the", "sat" などの単語を予測します。

CBOW (Continuous Bag of Words): 周囲の単語から中央の単語を予測するアプローチ。上記のフレーズを例に取ると、"the", "sat", "on", "the" から "cat" を予測します。

9. 補足 (Supplementary Information)

テキスト分類やクラスタリングは、NLPの中心的なタスクの一部ですが、他の技術や手法とも深く関連しています。以下は、テキスト分類やクラスタリングと関連性の深い3つの技術やタスクを紹介します。

1. トピックモデリング (Topic Modeling)

関連性:

トピックモデリングは、大量の文書から潜在的な「トピック」を自動的に特定する手法です。テキスト分類とは異なり、トピックモデリングは教師なし学習の一形態であり、事前にラベルを必要としません。

代表的な手法:

LDA (Latent Dirichlet Allocation): 文書が複数のトピックの組み合わせから生成されると仮定し、各トピックの単語の確率分布を推定します。

2. 文書の類似度計算 (Document Similarity Computation)

関連性:

文書のクラスタリングを行う際、文書間の類似度や距離を計算する必要があります。この計算は、文書の内容やテーマがどれだけ似ているかを定量的に評価するためのものです。

代表的な手法:

コサイン類似度 (Cosine Similarity): 二つのベクトル間の角度のコサインを用いて、文書間の類似度を計算します。

3. シーケンスモデリング (Sequence Modeling)

関連性:

テキスト分類タスクでは、文書や文のシーケンスの情報を考慮することが重要です。シーケンスモデリングは、時間的な順序や前後関係を持つデータをモデル化するための技術です。

代表的な手法:

RNN (Recurrent Neural Network) と LSTM (Long Short-Term Memory): 過去の情報を現在の入力と組み合わせて処理する能力を持つニューラルネットワークの一形態。

これらの技術やタスクは、テキスト分類やクラスタリングと組み合わせることで、より高度なNLPアプリケーションの構築や、深いテキスト解析の実現が可能となります。

最後に:他のSNSでも発信しています

この記事が気に入ったらサポートをしてみませんか?