word2vec

・word2vec:機械翻訳では、単語を数値ベクトルへ変換してニューラルネットワークに与えることが必要がある。word2vecがその変換の役割を担うアルゴリズムである。

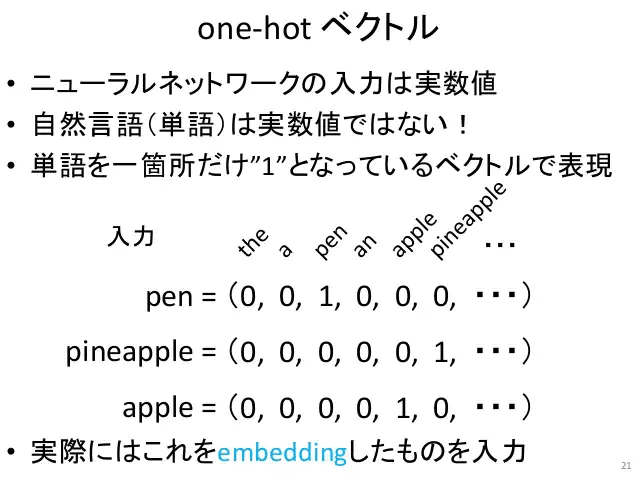

・one-hot ベクトル:

英語のone-hotベクトルは数万単語があり、ベクトルとして大きすぎて、それにそのほとんどが0である。実用性に欠ける。このベクトルを圧縮できるのがword2vecである。

・word2vecの使用:word2vecの正体は二次元行列である。

one-hotベクトル ・ word2vec行列 = [0.2 , 0.11, 0.55, ... ]

ニューラルネットワークの x ・ w = y に似ている。実質上、この重みwはword2vecの正体である。

考察

・word2vecの導入はone-hotベクトルの問題点を有効に解決できるが、長い間でその重みwをどう学習するかが問題であった。極端な話ではランダムなwでも変換はできるが、その変換結果は「辞書」の役割として正しいかも問題であった。以下がCBOWモデルの学習の一例で、Winがword2vec行列である。

この記事が気に入ったらサポートをしてみませんか?