AIによる画像解釈はどれくらい使える? ChatGPT、Claude、Copilot、Geminiを比較してみた (2)

AIによる画像解析機能について検証してみようとした記事の第2弾です。

前回は「折れ線グラフ」を食べさせてみました。

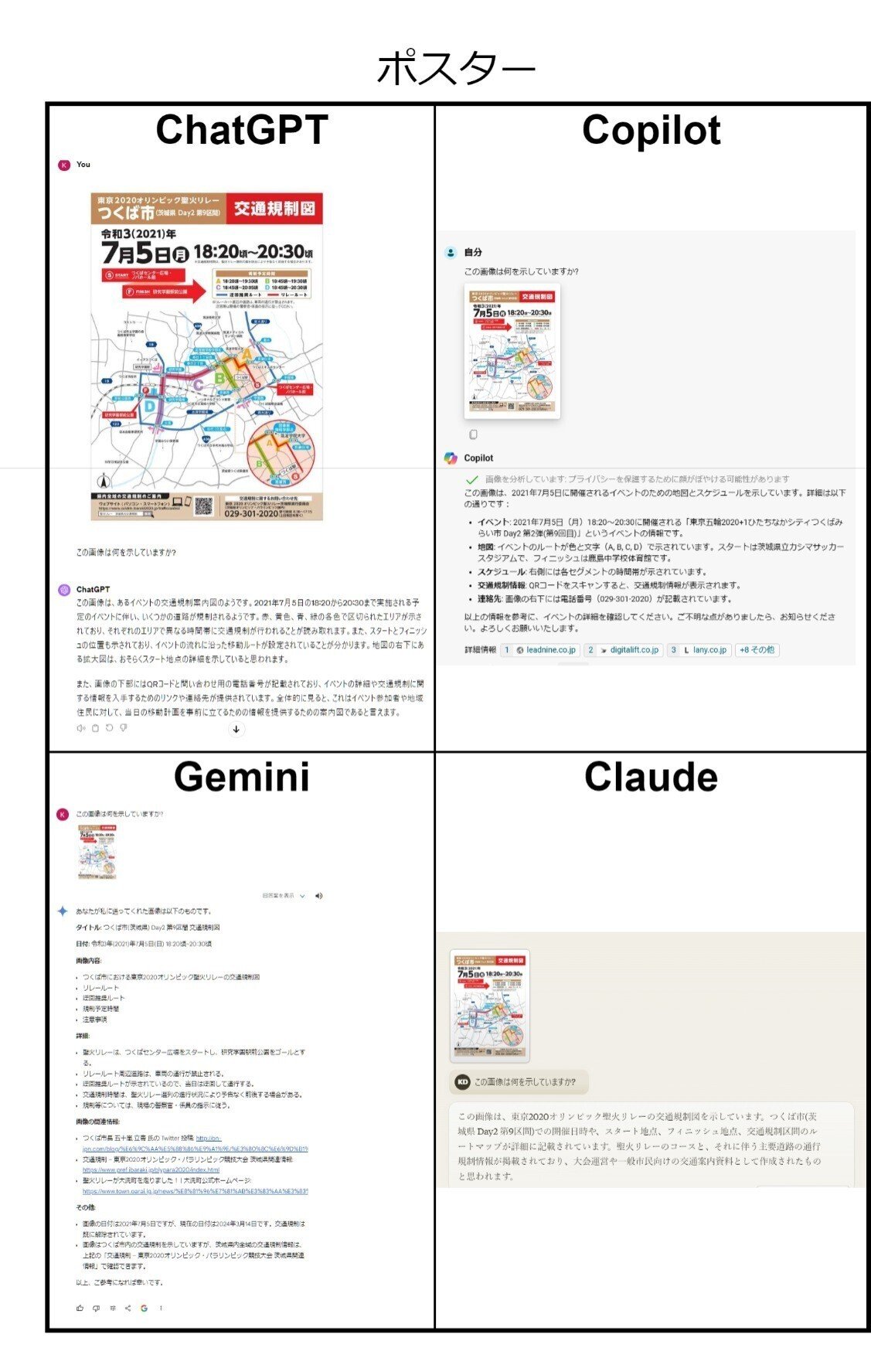

今回は「ポスター」です。

比較対象としているAIについては前回記事をご参照ください。

今回はイベント案内用ポスター画像

今回使うのは以下から拝借した画像です。

結果と考察

まずは結果を披露します。

今回は、出来の悪かった順に紹介してみましょう。

まずは、Copilot君。2001年7月5日のイベントを扱っていること、連絡先電話番号やQRコードが掲載されていることなどはちゃんと読み取れていますが、その先がいけません。ちょっと、どうしちゃったのでしょう? どこから「ひたちなか」でてきた? どこから鹿島でてきた? 当該の画像ではなく、何か勝手に別のものを検索してきて眺めているようです。これは落第と言わねばならないでしょう。

ChatGPTは、前回の折れ線グラフと同様に踏み込みが足りない印象を受けます。Copilot同様、2001年7月5日のイベントを扱っていること、連絡先電話番号やQRコードが掲載されていることなどはちゃんと読み取れていますが、ここまで行ったら「オリンピック聖火リレー」にまで言及してほしかったところです。それと、色の認識が何か変ですね。

Claude3が出してきた回答こそが合格最低ラインではないでしょうか。やっと「東京2020オリンピック聖火リレー」という文言を見ることができました。規制予定時間が4つ設けてあることや、リレールート・迂回推奨ルートが示されていることには言及がありませんでしたが、まあ許容できる範囲と言えるでしょう。

今回の最優秀選手賞はGeminiに与えるべきでしょうね。最も詳細な説明を返してきました。細部の正確性にも問題はないようです。その上、関連ウェブページのリストまで返してくるというきめ細やかさ。前回のグラフのデータの読み取りでは残念なところを見せてしまったGeminiですが、今回は大丈夫でした。図形の読み取りはできるが、細かい座標の認識は得意ではないということなのでしょうか。

暫定評価

このような目的には今のところGeminiが適任と言えそうです。前回に続きCopilotは微妙な結果。ChatGPTとClaudeは「無難」。

ほぼ全滅だった「折れ線グラフ」よりはマシな結果となりましたが、それでもまだこれからという感じですね。特にWindows標準装備のCopilotのパフォーマンスが寂しい。残るテストで汚名返上してもらいたいものです。

次回は「実写写真」の解析結果を取り上げる予定です。お楽しみに。

この記事が参加している募集

この記事が気に入ったらサポートをしてみませんか?