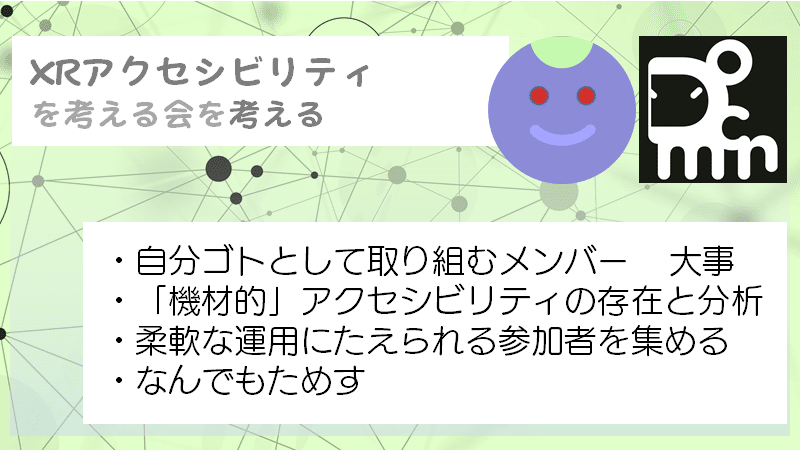

「VRChat Meetup #5」でアクセシビリティを考える会を考えた話

こんにちは、じゅんです。

Scientist/Developer Relationsとして、xR関係の開発者の発信の助けになることをしながら自然科学の研究者との橋渡しもしています。

5/28にTnohitoさん主催の「VRChat Meetup #5」開催のお手伝いをさせていただき、また色々考えたことがありましたので備忘録代わりに書いておきます。動画アーカイブ・togetter・資料など順次まとまっていますので内容についてはそちらを観て頂くのが良いと思います。後半は裏方のお話です。考える会を考えるというメタメタしたタイトルですが誤植ではありません。

「VRChat Meetup #5」

5/28の夜に、VRChatの中でVRChat Meetup #5を開催しました。4組のメインセッションと6名のLTの構成で行いました。メインセッションでは、身体的にハンディキャップを抱えた人がVRなどの表現技術と関わるときに開発側が考える事・かかわった時に何が起きたかなどのテーマを中心にそれぞれの事例を共有しあう会になりました。IT全般・VRChat・HoloLens・現実(ハードウェア)とそれぞれ異なるプラットフォームでの具体例が続きました。特に登壇・運営者側に、学びの多い会になったと思っています。

クリーヴァさんにYoutube配信を協力いただき、VRChat以外の人にも観てもらえるようになりました。VRChat会場にいると、オンライン配信でよくあるスクリーンショットの実況が少なくなっちゃうところがあるので、Youtube配信の併設は非常に助かります。

EqualEntryさんのトークではアクセシビリティを改善する事で人生が救われる人々の存在を印象付けられました。VoxelさんのVRのアプローチは、それ自体は直接ハンディキャップを改善するものではないけど、視え方などを再現して人に体験してもらう事で認識の差を持ってもらうための取り組みとして強いという話でした。ホロ元さんの、空間音響を使ったロービジョンのアシストについては、ウェアラブルコンピューティングで人体機能の代替を提示できることの意義を感じました。実践的な片手UIの設計などもとてもよかった。かめおかさんはハードウェアの領域の人なので、VR活用などで得た人間の認知メカニズムを応用して、より人にやさしい補助機器の設計に活かしていくんだろうなという期待があります。皆さん、駆動力が個人の体験に紐づいていて、本当に自分の事として取り組んでいるのが重要なポイントでした。本編を見てね('ω')

開催の経緯と考えた事

4/26くらいにTnohitoさんから会の開催について突然相談があり、1分でOKして、翌日にはメインのトマスさんの登壇OKが取れたとの事だったので、テーマの方向性がアクセシビリティになることが決まりました。そこから最近の事例でアクセシビリティに関連の深い事例を他で発信している人を思い出しながら順次声掛けをさせて頂くようになり、今回の4組が決まって行きました。(今回のお話以外にも、Xboxアダプティブコントローラ活用事例や、HoloLens空間音響を使った視覚障がい者向けマルチプレイゲーム体験などの開発者へのアプローチを行いました。)

28日には日時が決定してconnpassページがサクッと公開されており、告知が始まりました。今月は別の技術者コミュニティでのLT登壇が結構あったのでそこに告知ページ1枚挟んでおくくらいの控えめな感じの告知からスタートしました。VRChat会場が人数キャパ的に非常に狭いので、本当にこのテーマに興味のある方に入場・交流してもらいたいと思っているためこの方式にしました。去年の #盛夏音祭 と同じ作戦です。

粛々とVRChat会場参加者エントリーを集めて行って、会場のキャパくらいまで入ったあたりでバッサリ打ち切って、以降はYoutube配信の存在を広く広く触れ回る告知方針に切り替えました。結果的にはVRC会場・Youtube配信視聴者ともにバランスよく参加頂けました。ありがとうございます。

VRChat内イベントには風物詩ともなりつつある事後のワールド遠足もひっそりと計画を進めておきました。以前より話題になっていたVoxelKeiさんの近眼・遠視・乱視・色覚特性体験ワールドへの体験ツアーを快諾いただけたので配信終了後に参加者みんなでそちらの体験・説明を受ける時間にしていただきました(正直これが楽しいからイベント企画をサポートしてる部分があるw)。特定のテーマで集まってるので、テーマならではっていうワールドにそのみんなで行って何かを考えることこそが今回の重要ポイントでもあります。深夜に及びましたが、ワイワイ意見交換できる時間になって楽しかったです。

ミートアップ登壇後にみんなで色覚ワールドへ行ってからの三国峠へ行きました。#VRChat pic.twitter.com/OowtjeKGXt

— VoxelKei (@VoxelKei) May 28, 2021

裏テーマ:「機材的」アクセシビリティ-PCVR⇔Questの行き来チャレンジ-

そんなこんなで告知系の計画は従来の手法を倣う形で進んでいったのですが、今回はもう一つのチャレンジがありました。Quest対応です。

結果から書くと、メインスピーカの柳川さん・ホロ元さんは会場内の動画コンテンツはゴーグル内で一切視えても聴こえてもいなかった状態で今回のプレゼンを終えました(他にも本番での同期トラブルの影響でからすまくろさんはプレゼンスクリーンそのものが自分自身で視えていませんでした)。

本番1週間前の5/21に「やながわさんはメイン機がWinでなくPCVR環境を持っていない Quest2がある」という想定外のニュースをもらい、それまでわりと余裕モードで準備を進めていた我々に衝撃が走りました。17日に別件での問い合わせがあって、Oculus Quest参加は非対応であるとアナウンスしたばっかりだったのでした(スライド・動画再生・アバターすべてギミックが動かない事を確認)。しかもお二人VRChatは初めてという事で、その使い方も理解してもらわないといけない(動かないかもしれないのに)。あと、TnohitoさんはQuest2持ってないので、どこに不具合があるのか本人が確認することができない。かくして我々は、言語的アクセシビリティ(トマスさんの日本語)、プラットフォーム的なアクセシビリティ(VRCの導入)、機材的なアクセシビリティ(Questで登壇できるのか?)な3重の問題を同時に抱える事になりました。うける。ここから考える事が膨大になりました。

作業編

とりあえずワールドデバッグをしなければいけないので、私がQuest2でTnohitoさんの作成したワールドに入り、動かない箇所の確認をする方法の確立をしました。こないだ書いたHoloの視界を高fpsで送る方法を流用して、Quest2の視界をzoomでTnohitoさんに送る方式をとり、「なにが視えているのが正常なのかわからない私(Quest)」「なにがどう動いていないのか自分では確認できないTnohitoさん(PCVR)」の線をつなぎました。(ちなみに柳川さん・トマスさんへのPCVR使用法の最初の打ち合わせも、zoomで4人繋がって、私とTnohitoさんがそれぞれの主観操作映像を送る方式で行いました。)

#VRCミートアップ の打ち合わせです('ω')

— じゅん@6/14 顕微鏡学会参加 6/16XRミートアップ (@jun_mh4g) May 26, 2021

zoomなのにお互い何故かVRCの主観映像を送りあってる謎構図w

明後日開催にむけて運用がなんとかまとまりそうで光がみえてきた pic.twitter.com/YABqxjACaK

プレゼンのための舞台装置のだいたいの要素が希望通りに動かないという絶望を共有した後、Tnohitoさんがワールドギミックの差し替えに回り、確認のために私が呼ばれることになりました。また、スピーカの柳川さんにも空き時間とかにQuest対応状況を適宜確認してもらわねばならないので、無人ワールドでも任意に入ってもらえる方法などを募ったりしました。三十個(みそこ)さんが教えてくれなければここで詰んでた。ありがとうございます。

#VRChat を #OculusQuest2 のスタンドアローンで楽しんでいる方に質問です!

— Tnohito@6/5 VR演劇「ほんとうのわたし」 (@Tnohito1) May 21, 2021

いわゆる起動リンク - VRChatのホームページからワールドを選んでLAUNCH WORLDをクリックしてVRChatのワールドへ飛ぶやつ - を使って入ることって出来るのですか?https://t.co/z7K9ra4N3I

👆こういうやつです

公式サイトにログインした状態で出来ます!

— 三十個(みそこ) (@0ne_chan) May 21, 2021

自分でインスタンス建てたり、フレンドの居るFriendオンリー/+/Publicインスタンスになら、

下の「invite me」で自分からインバイト飛んでくるので、それを承認する形で! pic.twitter.com/dNXI9ugF95

次にアバター統一問題に取り掛かりました。VRChat内は負荷がかかりすぎると落ちる人が出始めるため、今までのミートアップ・音祭イベントでは統一アバターの着用を案内して、観戦者増加による負荷の悪影響を最小限に留める努力をしていました。そもそもアバターもPC対応版しかなかった(透過処理が確立してなかった)ため、これも今回Quest向けに作ることになったようです。sakusakuさんから知見を分けてもらい、それっぽいアバターはなんとか出来てすごかったのですが、チェックタイムでは残念ながらQuest実機では期待した透け方が得られなかったためサクっと諦めました(おしい)。Quest・PC両対応のアバターを一個会場内に配置し、これをfor Questのアバターとして着替えてもらうアナウンスをして、Questの視界からは統一したアバターが視えるように調整しました。VRC慣れしている参加者の協力が得られて助かりました。

以前からQuest対応の観客アバターを考えていたのですが、透明表現が出来ないのがあって頓挫してたんですが…

— Tnohito@6/5 VR演劇「ほんとうのわたし」 (@Tnohito1) May 24, 2021

「あ、この手があった!」

(SakuSaku.@ssaku530 さんごめんなさい…)

#VRChat pic.twitter.com/rTXllS11Aa

次に音声問題がありました。Equal Entryは二人組登壇で、質問とかが技術的な話だったらトマスさんに聞かなければいけない状態です。英語翻訳役のやながわさんと状況共有ができないとこれができないので、(ワールド内の映像の同期が一番厳しいのとは別に)音声セッションは死守しなければなりませんでした。VRCに接続しているのと別にZoomで繋がる方式(疑似Syncroom方式)を検証しました。当初考えていたのは、4人でzoomに繋がっておいて、VRChatとの音声の出し入れをする係を一人決めます。その係のアバターから4人分の声が適宜出るみたいにしておいて、必要な視覚情報は私が眼になる(前段の方法)。みたいな感じでした。この際、マイク入出力のバーチャルミキサーの取り扱いが必要になります。福岡XR部のながみねさんが、Hubs⇔ZoomのI/FをXRミーティングで確立しているので、それのZoom⇔VRChatモデルを考えて、設定なども教えてもらいました。ちょっと音が回る問題の解決まであとちょっと、というところまでは確認しましたが、後述の条件緩和に伴い、zoom接続はトマスさん(眼の役)⇔やながわさんの二名だけの運用で済むようになり、現実には4人zoom体制は発動しませんでした。疑似SyncRoom方式の発想には盛夏音祭2020で学んだ知見が使われています。

福岡Hubs会場は今回からPC1台でZoom/Hubsを繋げてます。こんなかんじで色々立ち上げてるので混乱する。特に音声まわり #XRMTG #福岡XR部 pic.twitter.com/xaH0mZibSm

— ながみね (@KzoNag) January 20, 2021

柳川さんサイドからも講演構成に関する歩み寄りがものすごい得られました。当初、パワポを使いながら適宜Youtubeを放映し、一時停止をかけてパワポに戻り、再びYoutubeを進めてまた違う事例紹介に移る、という打ち合わせをしました(PCVRでは問題ないけど、Questだとそもそも動かなかったり操作すらできなかったり)。一週間の間Quest対応の取り組みを共有しているうちに、形態が変わったものを改めて提案して頂きました:

①動画を一本ではなく複数に分けて提出・ワールドに予め組み込んでしまってTnohitoさんが操作して参加者に見せる。キビシイときはYoutubeをTnohitoさんが呼ぶ。

②動画には予めナンバリングをしておき、パワポでも番号表示があるのでTnohitoさんはそれを頼りに再生していく。

という方式です。これであれば、動画が正しく流れているかどうかのチェックだけPCVRのトマスさんから情報がいけば柳川さんが記憶を頼りに説明できる形になります。音声共有が運営側の最大の懸念点だったので、演者側からこういう負担軽減案が自然に出てきたのは感動でした。我々二人で「たすかったー!」って喜んでました。

消し忘れたQuadが…😖😖😖 pic.twitter.com/FfE96rFsqD

— Tnohito@6/5 VR演劇「ほんとうのわたし」 (@Tnohito1) May 28, 2021

こうしてQuest装着状態のメインスピーカーが喋れる状態をなんとか作った後、最終リハを当日に設置して各自の環境とワールドの動きを他の登壇者にも確認してもらって本番に臨んだのでした。テキストの消し忘れとかはゆるしてくださいm(__)m

結果

そんなような事を裏で延々、時間ギリギリまでやっていたので、確実な動作検証は取れていませんでした。本番時はあらゆる困難が起きたような気がしますが、うまくやり過ごしながらの知見共有と交流という最大の目的は果たされたように思います。今回のYoutube配信をご覧になった方は今までの#4までの配信に比べ違和感があったんじゃないかと思いますが、運営としては大満足です。柳川さんが進行不能になってしまった場合に我々は敗北だったのですが、今回は柳川さんが回線落ちする事もなく、そして実は動画が視えていない事を周囲に悟られることもなくプレゼンが終わったのでとても安心しました。

「なかなか不慣れな中でTさんもすごいいろいろ皆さん手取り足取りとてもありがたいです」というコメントを講演終了直後に頂きましたが(結構異例)、「いろいろ」の部分はたぶん、これらの取り組みについてのコメントだったと(私が勝手に)思っています。

「最初からQuest対応しとけよ」という声もありそうですが、描画の制限などを今以上に参加者負荷としてかけるような変更はあんまり望んでいません。なので、今回もQuest対応は最初想定してなかったのですが(会場のコントロールが2プラットフォームになって大変なんだもの)、メインスピーカーがそんなことになってるという事がキッカケになり、これもなんかの縁ってことで気軽に変更しました。Tnohitoさんがよくワールド再構築したと思います。

あらためて配信を観ると結構すごくて、出てくる人みんなトラブってるんですけど(w)、何故か自力で原因にたどり着いて進行の影響が最小限になるように動いてくれてるんですよね。ブラインドでしゃべる羽目になっても、会場の誰かが何かしらスライドの視え方とか聴こえ方とか教えてサポートしてくれてる。トラブった人の切り捨てをしない結果、終了時刻だけが多少延びました。XRアクセシビリティを体現したような場になっていたんじゃないですかね。

最後のVRChat遠足も実はXRアクセシビリティに配慮した事をやっていて、本編の配信を終了したクリーヴァさんに、もう一度ストリーム配信を始めてもらい、Youtube生配信の映像をQuestのやながわさんに見てもらう事で、処理負荷の大きい視覚特性体験ワールド(PCVRのみ参加可能)の様子をリアルタイムで疑似体験してもらうようにしてみました。全編通してどんなふうに視えていたのかは今度聞いてみようとおもいます。

questっていうのは難しいんですね... 終始すごいことになってました...

— KenjiYANAGAWA (@Kenji_yngw) May 28, 2021

なんでやってんのかという話

まず第一に、アクセシビリティと聞いて、その一単語だけで面白いなと私が思ったからです。利便性を上げる話がアクセシビリティの分野とXR分野で共通していることは、以前に超福祉展に行ったりした時に分かっていました。「できないことができるようになる」という事について、「業務効率アップ・エンタメのために」そうなるのがXR活用のDXで、「生存・幸福度アップ」のためにそうなるのがアクセシビリティの得意ポイントだと思っています。普段アクセシビリティの側にはいない自分ではありますが、この領域からの知見(UIの作り方・見せ方)などは多分健常者サイドの便利UIの設計にもいい影響があるだろうと思って参加することにしました。

#超福祉展 で .@sotongshi の自動運転WHILLを体験してきました! pic.twitter.com/V31mJaNYsa

— じゅん@6/14 顕微鏡学会参加 6/16XRミートアップ (@jun_mh4g) September 3, 2019

あとこのテーマは案外他人事では無くて、以前恩師との意思疎通をどうにかするためのあれこれを個人的にやっていたことがあって、その時は、HoloLens 2の視線入力装置が本当に必要でした。

今回の登壇者は、ハンディキャップについての個人的エピソードと開発モチベーションが連動している方が多かったように思いますが、私も近いものを抱えているというのも理由の一つです。周囲の音全部拾う耳が付いていて全部等ウェイトで聴いてる感じです。

似たような人が集まるとたのしいよね(そこか)。でもガヤガヤに超弱いので大人しくしてます。

やりたかったこと pic.twitter.com/DTPuvqQ5IR

— じゅん@6/14 顕微鏡学会参加 6/16XRミートアップ (@jun_mh4g) September 12, 2019

不運にも利き手じゃ無い方以外麻痺になってしまった先生に、左手首までの操作だけで文字書ける仕組みを300円で作ってみたけど、これで意思疎通できるようになるといいな。

— じゅん@6/14 顕微鏡学会参加 6/16XRミートアップ (@jun_mh4g) September 13, 2019

まとめ

今回は、想像以上にうまく行ったと思っています。一週間前に仕様変更が始まってもへこたれない運営・運営に協力的な登壇者の皆さん・緊急の会場やイレギュラー対応があってもついてこられる参加者の皆さんの協力的な空気のお陰で楽しく交流できてよかったです。教えてくれた外の人達も重要でした。ありがとうございました('ω')

学んだことは、

当事者感のある人の集まりが場全体のアクセシビリティを高める。

です。言葉にするとあたりまえだね!以上です('ω')

#VRCミートアップ#VRCMeetup

— じゅん@6/14 顕微鏡学会参加 6/16XRミートアップ (@jun_mh4g) May 28, 2021

パネルトークは今回は省略!

質問ハッシュタグを投げといてくれれば非同期で答えます('ω')

クロージングコーナー

イベント開催にあたっての協力者のみなさん

ほんとうにありがとうございます!

次回は数か月後

配信係のクリーヴァさんも登場 pic.twitter.com/CSdWZmUL7L

↑重要。

おまけ

NearSighted Classroomにみんなで行った時の配信は、後日追加します(たぶん)。また、記事公開後のTnohitoさんのコメント。毎回試行錯誤にまみれているので、今回こそはライトに!と思ったけど結局試行錯誤にまみれた(気にしてない)

「VRChat Meetup #5」

— Tnohito@6/5 VR演劇「ほんとうのわたし」 (@Tnohito1) May 31, 2021

「久し振りではあるけれど5回目だしね!」と思っていた時期もありました…

今回はガッツリじゅん.@jun_mh4g さんに関わって貰って本当に助けて貰いました!

(でも不純なのですが問題解決してるのって楽しかったりするのです…その先が見えていれば…w)

#VRCミートアップ https://t.co/kRsT38pjO3

(2021/5/30 6330字)