サラウンド音響システムにおける備忘録

はじめに

九州大学芸術工学部 学生団体「CBAproject」にて、複数台のスピーカーを用いたサラウンド音響システムに取り組んだ内容に関する記事です。

昨今、プロの現場ではDollby atmos、6.1chサラウンド (サカナクションが導入したことで有名ですね) など、サラウンド音響が激アツな状況ですが、ハウツーとしてインターネットから得られる情報には限りがあり、アマチュアが導入するには未だにハードルが高い状況が続いているように思います。

実際、自分もサラウンドを導入するにあたって情報収集には苦労しましたし、別件ではありますが、コロナ禍によってノウハウの継承が途絶えたことで苦しい思いを強いられた経験などがあるので、団体内でのクローズドな継承にとどまらず、オープンなインターネットの場に今回の経験を放流しておこうと思い至った次第です。

おそらくこれを見るのは知り合いが大半でしょうが、一応弊サークルのことを知らない人が閲覧しても理解できるように書いているつもりです。

どれだけの人の目に留まるかは分かりませんが、ネットの肥やしになればいいなぁと思います。

「CBAproject」の概要

CBA Projectは、九州大学芸術工学部の有志による、

エンターテインメントファッションショーを行うサークルです。

映像、音効、舞台美術、広報、照明、衣装、演出、モデルの全てを

学生の力だけで0から作り上げ、既存のファッションショーとは

異なるショーを芸工祭で披露します。

CBAproject (シーバプロジェクト) は九州大学の学園祭「九大祭」(芸術工学部では他大学からの併合の歴史で「芸工祭」と呼ばれる) にてエンターテインメントを行うサークルです。

サークルの概要を紹介するにあたって「ファッションショー」という言葉で表すのが相対的に近いのですが、従来のファッションショーとは大きく異なり、モデル・衣装はもちろんのことながら映像・照明・音楽等を用いて一つの「世界」を演出する「総合芸術」と解釈するのがいいと思っています。

サラウンド音響システムを用いた今年度の公演のほか、過年度の公演もYouTube上にアップロードされています。

また、サークルを取り巻く背景として、九州大学芸術工学部には音響工学を専攻する「音響設計コース」が存在するほか、軽音サークルのPAや他の音楽系サークルの録音等を行う「TRP (テープ・レポート・プレイ)」という学生サークルが存在しており、弊サークルの音響機材のほとんどはこのTRPより借用していることを追記しておきます。

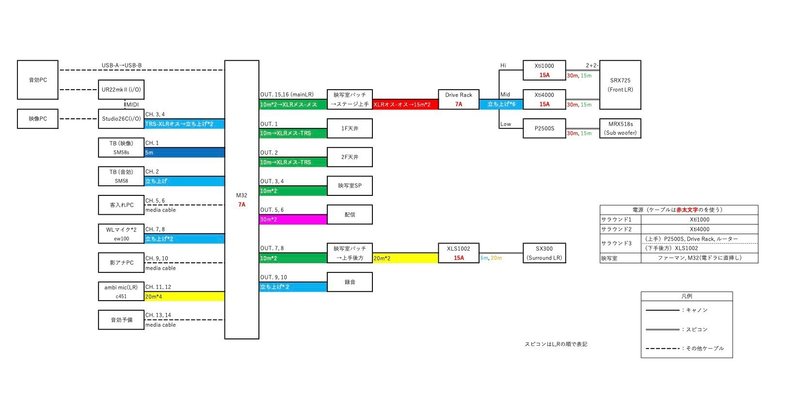

システムの配線と各機材の解説

公演に使用したのは弊学の施設「多次元実験デザイン棟」で、2Fの映写室と呼ばれる部屋にミキサーや再生用のPCを置き、1Fのホール内のスピーカーを操作する という形を取っています。

スクリーン横にツィーターが置かれている。ウーファーは中段スクリーンの下に滑り込ませている

上方にあるのが映写室で、ミキサーやPC等はそこに設営されている

システム設計における前提

第一にサラウンド音響システム とは言いながらも 厳密な5.1chのサラウンドシステムとはかけ離れた仕様となっています。

前述の通り弊サークルはファッションショーを行うサークルであるため、前方に舞台があり、中央にスピーカーを設置するのが困難である点や、機材を借用したTRPの所持している機材の都合、会場設営・リハーサルにかけられる時間を考慮した結果、「ステレオ+飛び道具として左右後方にミニスピーカー」という解釈のもとで設計を行なっています。

スピーカー

・ツィーター 「JBL SRX725」

・ウーファー 「JBL MRX518s」

・後方スピーカー 「Electro-Voice SX300」

https://www.soundhouse.co.jp/products/detail/item/33918/

前提の通り、前方にはパワーの強いスピーカー、後方はそれに対して小さめのモニタースピーカーを採用しています。

ミキサー

・Midas M32-LIVE

PC周りの出力

・音効PC

メインのPCです。MacBook ProでPro Toolsを立ち上げて再生しました。ミキサー(M32-LIVE)にはオーディオインターフェースとしての機能があるためUSB経由で5.1chのwav音源を流しています。

前述の通り、出力は4系統なので、5.1chのうちセンターとサブウーファー(LFE)はミキサーでフロントのLRに分岐して流しています。

公演はYouTubeで配信もされるのですが、YouTube上では(言い換えればiPhoneのスピーカーでは)もちろんサラウンドは流せないので、配信用の音源は映像PCより流しています。

5.1chのファイルをミキサーで2chにダウンミックスして配信に送ることも可能でしたが、元々が5.1chで聞くことを考慮してミックスされた音源なわけですから、それを2chに圧縮する段階でバランスの不均衡性は多かれ少なかれ生まれるわけで、個人的にはあまり支持できません。

公演で舞台に投影する映像(およびその映像に付随する配信用の音源)とは別のPCとなるので、

Pro ToolsでMIDIトラックを作成し、再生開始位置にC4のMIDIノートを置く

→別途用意したオーディオインターフェース(UR22mk2)からMIDI Outでノートを送信

→映像PCに接続したオーディオインターフェース(Studio 26c)のMIDI Inに受信

→受信したC4ノートをトリガーにして映像を再生するショートカットを組む

という形で同期を図りました。

本当はタイムコード等を用いた同期の方がいいのでしょうが、調べても設定方法がわからなかったですし、再生開始さえ一致すれば公演終了まで手を加えることはないので問題なく同期できると思い、この手法を採用しました。

十分な検証はできていませんが、オーディオインターフェースを2つ接続する関係でWindowsのPCでは代用できない可能性がありますが、Macであればマルチチャンネル対応のDAW(Cubase, Logic等)で互換できると思われます。

・映像PC

型番は知りませんがWindowsのデスクトップPCです。使用ソフトはResolume Arena。

Resolumeがマルチチャンネルオーディオに対応していなかったので、PC2台の同期などというクソめんどくさい方法を採っていますが、VJソフトや再生ソフトでマルチチャンネルの音源が再生できるのであれば1台のPCでまとめた方がいいと思います。サラウンドの検討の過程で没にしましたが、7.1chまで対応しているのであれば、5.1chの余った2chに配信用にステレオミックスした音源を入れておいてミキサーの出力設定でどうにかする みたいな芸当も多分できます。

ちなみにMacのQuick Time Playerは5.1chの音源は余裕で再生できますし、M32-LIVEのオーディオインターフェースは32chまでアウトプットできます。

設定としては

Preference→Audioでオーディオ出力とMIDI入出力をオーディオインターフェースに設定

→メニューバー「Shortcuts→Edit MIDI」をクリック

→ショートカットをアサインしたいスイッチをクリック

→MIDIの信号を受信するとそのノートがショートカットとして対応する

→Shotcuts→Edit MIDIをもう一度クリックで元の編集画面に戻る

という要領で映像の再生のショートカットをMIDIにアサインしました。

前述の通り、映像側にも音源が付随しており、そちらはオーディオインターフェースのOutputを経由して配信に流れるようになっています。

あと、Preference→MIDIの(→)ボタンを押すとMIDIの受信を確認できるのも覚えておくと役に立ちます。

Resolume ArenaのMIDIショートカットに関しては以下のページを参考にしています。

まとめると

会場 → 音効PCの5.1ch音源 + 映像PCの投影映像

(両者は独立したシステムだが、MIDIによって開始タイミングは同期されている)

配信 → 映像PCのステレオ音源 + 映像PCの投影映像(をカメラで撮ったもの)

(音源と映像は同一のシステムから流れている)

となっています。めんどくさいですね。

・予備PC

各種PCが落ちた場合のバックアップです。基本的には音効PCが落ちた場合、映像側の音源を会場で流すことができるので、映像PCと音効PCの両方が使用不能となり、本当にどうしようもない時の予備です。

今回は機材の都合で2chの予備となっていますが、6ch出力のオーディオインターフェースがあればサラウンド出力の予備音源としての運用も可能かと思われます。

音源制作にあたって

第一に、マルチチャンネルでのミックス、書き出しに対応しているDAW(2022年12月現在)は

・Cubase (Pro以上, 上位種のNuendoでもおそらく可能)

・Pro Tools (Studio以上)

・Logic

・Reaper

・Audition

が確認できています。

一応、Davinci Resolve (無償版)でも5.1ch, 7.1chの編集および書き出しができると確認できたのですが、厳密にはDAWではないので、一旦候補から排除します。

弊サークルの従来(2ch音源作成)でのワークフローでは、公演を演出単位で区切り、各演出に別々の制作担当が配置されますが、冒頭にも述べた通り、弊サークルは "学生団体" なので、制作にあたるのは全員、弊学に所属している大学1~3年生です。もちろんプロの人間ではないし、音楽に対しての取り組み方もそれぞれで、著者のような重課金DTMerもいるにはいますが、Garage Bandを用いて作曲をしている人も多く見られるような環境です。

サラウンドでの音源作成が可能なDAWは大半が有償ですが、サークルとして金銭の投資を強要することはできないですし、技術的な問題も付き纏うので、

従来と同じ形式での音源作成を全体で行う → 各音源のステムを回収し、限られたメンバーでマルチチャンネルのミックスを行う

という形式を取りました。

また、その限られたメンバーにも「制作環境を統一するためにLogicを買え」とか言えないので、各自で最も取り組みやすい環境でミックスを行うことにしました。

13の音源に対して6人でサラウンドミックスを行いましたが、使ったDAWは

Logic3人, Pro Tools2人, Reaper1人 といった感じでした。

システムで述べた通り、マルチチャンネルとは別にステレオの音源も用意する必要があったので、最終的に

①ステレオでの音源制作

②ステレオのミックス

③各トラックにエフェクトをレンダーした状態でステムを回収

④5.1chのフォーマットでフェーダー、パン、リバーブのミックス

+ステレオのマスタリング

といった作業工程となりました。

システムの出力が4chに対して5.1chでのミックスを行なったのは、単に各DAWで4chのテンプレートのフォーマットがなく、相対的に最も都合が良かったからです。

発生したトラブルとその反省

①作業環境と再生環境の不一致

何度も述べた通り、ステージの音響システムは4chだったのに対して、制作のフォーマットは5.1chであり、サラウンドミックス中のモニターが大して役に立たなかったのはかなり痛手でした。

本来の5.1chでは5つのスピーカーは同型のスピーカーあるいはほぼ等しいパワーのスピーカーであることが想定され、DAW等に付属しているサラウンドシミュレーター等もその前提のもと設計されているはずですが、本番のシステムは前方スピーカーと後方スピーカーのパワー差が大きく、またセンターとLFEがフロントのLRに振られている関係もあり、「家のヘッドホンでモニターしていたら良く聞こえたのに、現地で聞いたら微妙」ということが多発しました。

いわゆる5.1chの礼儀に則ったシステム構築をしていれば起きえなかったトラブルではありますが、ステージがあり、横に広がった観客席において、限られた機材で観客に最大公約数的な音を届けるには前方スピーカーを偏重する構成にはせざるを得ず、これの対策はサラウンドミックスした音源を現地で十分に確認できる時間を取る しかないように思います。

②映像・配信との音ズレ

現地では投影されている映像と音源が違うPCから再生されており、またそれらは冒頭の再生位置しか同期されていないため、途中でのトラブル(過負荷によるドロップアウト、予期せぬ停止)によって一度タイミングがズレると、復帰が不可能でした。

また、これはヒューマンエラーであることが否めませんが、書き出しの段階で、音源と映像が上手く合っておらず、ドタバタしました。

サラウンド音源と映像の同期は

公演全体の映像のファイルをもらう

→映像ファイルに付属している2chの音源(配信で流す用)の波形を見ながら、5.1chの音源のタイミングが合うように各音源を繋げる。

→映像ファイルを削除(あるいはミュート)して公演全体の5.1ch音源を書き出す

という手法を取っていたのですが、その見ながら合わせていた波形がそもそも映像とずれていて、それに本番直前まで気づかなかったので、書き出したものを一度通しで見て(聞いて)確認するという作業はマジで大事だと思います (←実は後輩に一番引き継ぎたいこと)。

また、配信は映像と音源が同一のファイルから流れているので、書き出しのミスがなければ音ズレはしないのですが、今回は現地の音をマイクで録って配信に載せようと試みていたので、現地の音ズレが配信に入り混んで音が二重になる事態になりました。リハの段階で発覚したので、本番はマイクの入力を切りました。

③CPUのオーバーロード

本番は作成した5.1chのwavファイルをPro Toolsで再生していましたが、プロジェクトファイル内に20ほどクリップ(?)を溜め込んでいたらCPU過負荷で止まりました。当たり前ではあるのですが、予想以上に5.1ch wavの負荷はデカいです。再生時には書き出して一つのファイルにすることと、余計なファイルはプロジェクトから削除することを強く推奨します。

サラウンドで感じられたメリット

①迫力がすごい/表現の幅が大きい

従来のサラウンドで言われていることそのままです。 "音に包まれる"といった表現がよくされますが、ステレオの場合と比べて臨場感がケタ違いに上がりますし、パニングが1次元から2次元になるので、かなり表現に遊びを持たせることができます。

個人的に多く使ったのはフロントでメインの音楽を鳴らしながらリアでSEを鳴らすといった手法ですが、人によってはドラムのパンを振り切る みたいな芸当もしていました。

あと、スピーカーが分散することでマスキングの影響が減るので、それもかなりありがたかったです。

②マスタリングが要らない

マスタリングが要らないはさすがに言い過ぎ。

これはサラウンドのメリットというより、現地で再生する音源と配信で流す音源が分かれていることのメリットで、配信で流される音源である以上、さまざまな聴取環境を想定しなければいけないわけで、「現地のウーファーで聴いたらめちゃくちゃ気持ちいいだろうけど、iPhoneのスピーカーだったら低音全然聞こえないからな…」などと思いながらマスタリングでローエンドをめっちゃ下げたりとかすることもしばしばあるのですが、今回のシステムでは現地の音源は現地でしか流れないので、現地のスピーカーで気持ちよく聴ければあとは何でもいい という割り切ったミックスができたのはかなり楽でした。

おわりに

総じて、サラウンド音響は修羅の道だったな というのが取り組んでみた感想です。

サラウンドにしかない魅力もあるんですが、それに付き纏う労力やリスクもあるので、無条件で勧められるものでもないと思います。

とりあえず、大学生でもサラウンド音響はできた ってのとそのノウハウの共有がこの記事の趣旨なので、使えそうであれば上手く使ってやってください。

何かあればhttps://twitter.com/hamu_gt?s=21 に連絡もらえれば答えると思います、多分。

この記事が気に入ったらサポートをしてみませんか?