画像生成AI DALLE-3がやばすぎるの巻

DALLEとは?

概要

ChatGPTくんお願いします。

はい、「DALL·E」について説明します。

「DALL·E」は、ChatGPTを開発したOpenAIが開発したAIモデルで、画像とテキストの相互変換を行うことができる画像生成モデルです。DALL·Eの名前は、"D"rawing(描画)と"Alle"gorical(寓意的な)の組み合わせからきており、その名前通り、テキストの説明に基づいて画像を生成する能力を持っています。(筆者注:これGPTの嘘です。DALL-Eの由来はスペインの画家サルバドール・ダリ(Salvador Dalí )と映画『WALL・E(ウォーリー)』を組み合わせた名前だとか言われていた気がします。。)

DALL·Eは、与えられたテキストの記述に従って、そのテキストを表現する画像を生成することができます。例えば、「青い雲のある村」や「パンダの形をしたキノコ」など、具体的なテキストの記述に基づいて、そのテキストに合致する画像を生成することが可能です。これにより、創造的で想像力豊かな画像生成が可能となります。

DALL·Eは、大規模なデータセットと深層学習アーキテクチャを使用して訓練され、高度な画像生成のタスクに利用されています。その応用分野は広範で、クリエイティブなイラストレーション、デザイン、マーケティング、教育など多岐にわたります。

DALL·Eは、画像生成の技術をさらに進化させ、テキストと画像のコンテンツを効果的に結びつけることができる点で注目されています。これにより、新しいアイデアやコンセプトの探索、プロトタイプの作成、クリエイティブなプロジェクトの支援など、さまざまな用途で活用されています。

ありがとうございます。

DALLE 3とは

DALLE3はDALLE2の後継として、現在ChatGPTの組み込みプラグインとして利用可能です。

DALLE2はGoogleアカウントさえあれば簡単に試せます。クレジットごとの課金で使えます。

DALLE3はChatGPTの組み込みとしてテキストベースで調整できることが強みのようです。

そもそもDALLE 2とは

3のヤバさを理解するためには、まず2の理解が必要なので2から説明します。(1のことは知りません。)

もともとのDALLE2の時点でやばかったので、筆者は2万円ぐらい課金してずっと遊んでいました。

DALLE2の説明は動画を見ていただくのが最もわかりやすいと思いますが、簡単にいうと、作りたい画像のイメージとトンマナを文章で指定するとそのままの画像ができるという感じです。

試しにやってみましょう。校正するつもりがないのでうまく行かなかったらすみません。

前バージョンであるDALLE2実演

プロンプトを作ります。制限文字数がたしか1000文字くらいでありますが、大体のことはできます。以下、DALLE2で遊ぶ用の作り方です。難しいプロンプトエンジニアリングだのパラメータ設定だの言われてますが、大体これでなんとかなります。

プロンプトの作り方:

①イメージを文章にする。登場人物や要素など。抽象的な文章でも可能。

②トンマナを決めて文章に入れる。カメラでとった写真なのか、絵画なのか。これがないとイメージのズレが大きくなります。この辺は遊んでるとコツが掴めます。

③英語に翻訳する。ChatGPTと異なり、日本語では全く精度でません。DeepLでいいので翻訳しましょう。翻訳の日本語も確認して意味が変わってないかは一応チェックしましょう。

①イメージを文章にする

まず見たいイメージを決めます。結構やりやすいので、動物は入れたいですね。背景は、例えばさっきGPTがいっていた「青い雲のある村」にしましょう。あとはデータが割と少なくて苦手なものを表すためにも「東京の日本人のサラリーマン」と、なんでもできることを示すためにあり得ない物体である「ギターの犬」をいれましょう。まあこんな感じでいいです。別に頭の中でやって大丈夫です。

②トンマナを決めて文章をプロンプトにする。

リアルな写真にしましょう。面白そうなので。(ここで試しまくった末に見つけた秘密のプロンプトがあるのですが、なんとなく秘密にしておきます。ここが工夫のしがいがある領域です。)

ということでプロンプトにしてみましょう。

「青い雲のある未来の東京、ビルに囲まれた村の水辺で日本のサラリーマンがギター犬で和歌を演奏している。リアルな写真。XXX(秘密のプロンプト)」という感じ。

③英語に翻訳する。

「Future Tokyo with blue clouds, a Japanese businessman plays a Japanese song on a guitar dog by the waterfront in a village surrounded by buildings. Realistic photo. ***(秘密)」

では生成してみましょう。

頼む!

微妙ですね。まあこんな感じです。

ちなみに同じものをMidjourneyという別のツールで作ってみます。

いい!圧倒的にきれい。ギター犬の解釈ができてませんね。ちょっと試しましたが限界でした。

とまあ、こんな感じで、他の生成ツールに負けてしまっていたのがDALLE2 でした。

他の画像生成ツールの補足

先ほどちょっと脱線して使ってしまったMidjourneyやStableDiffusionが有名どころです。詳しくは解説しませんが、それぞれ強みがあります。

使っている所感ですが、Midjourneyはより高級感のある画像を生成することが強く、アスペクト比の指定やバリエーションの作ることに長けています。

StableDiffusionはより出したいイメージが明確な時や、人物の描写をコントロールすることに優れていて、いろいろなライブラリと組み合わせて使えます。「AI美女」みたいなやつはStableDiffusionで大体作ってます。

それと比較した時の、DALLEの強みはなんと言っても圧倒的な利用開始ハードルの低さです。ChatGPT同様、すぐかんたんにはじめることができます。MidjourneyはDiscordを入れないと使えなかったり、StableDiffusionはGoogle Clabとかを使ったりローカルで環境を構築する必要があります。

私はDALLE2で遊び倒しているうちにいろいろ触りたくなって他のも試しましたが、最初の頃はずっとDALLE2を使っていて、そのうち満足できなくなってMidjourneyを使ったり、画像の組み合わせをしたい時にStableDiffusionを使うようになっていきました。生成結果は先ほどお見せしたとおり。

なので、初心者にはとっても優れているものの、そんなに使う機会がなくなってきたなーと思っている中でのDALLE3ローンチでした。(正確にはまだアルファ版?ChatGPT有料ユーザーにのみ公開しているような気がします。)

DALLE3は何がやばいのか?

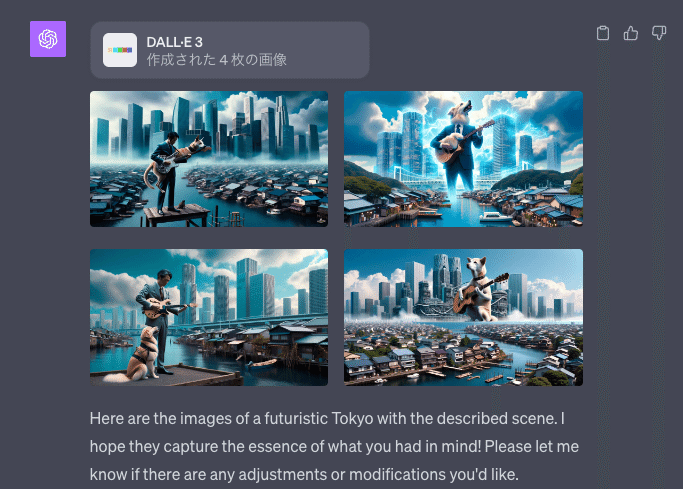

Dalle2を長々とご説明させていただいたので、実演した方が早そうです。では先ほどと同じ生成をしてみましょう。

Dalle3実演

素晴らしい!犬ギターの解釈まで完璧になりました。

表現や画像的にはMidjourneyの方がリッチで使いやすそうですが、画像の精度が圧倒的にあがったことと、文章の解釈がより正確になったことがわかります。

DALLE3本領はchatGPTとの組み合わせです。ここからテキストで解釈してもらい、指示をすることができることです。

例えばシェイクスピアの名言をビジュアライズするために「There is nothing either good or bad, but thinking makes it so. visualized (ものの善し悪しは考え方ひとつで決まる)」というプロンプトを打ち込むと以下のような形でプロンプト提案してくれます。

そのうえで、プロンプトに沿って抽象的な概念をビジュアルコンセプトに落とし込みビジュアライズしてくれます。

アスペクト比などの制限はまだまだあり、自由度という意味では限られていますが、抽象的な指示を具体化していくアートディレクターの役割を担えるのは非常に素晴らしい進化だと思いました。

まとめ

「DALL·E」はOpenAIによって開発されたAIモデルで、テキストの説明に基づいて画像を生成できます。

DALLE3はDALLE2の後継モデルとして、ChatGPTの組み込みプラグインとして利用できるようになりました。

DALLE2はテキストを元に画像を生成する機能を持つものの、他の画像生成ツールに比べて画質や解釈に難がありました。

しかし、DALLE3では画像の精度が向上し、より正確にテキストの解釈を行い画像を生成することが可能となりました。DALLE3の最大の特徴は、ChatGPTとの連携が深化し、テキストでの指示を元に画像の生成や抽象的な概念のビジュアル化が行えることです。

未来!