ローカルPCのターミナル上でLLM生成コードを実行できるOpen Interpreterを試す

ChatGPTのコードインタープリター(Advanced Data Analysis)と同様な機能をローカル環境で実行可能な Open Interpreter が公開されていました。ターミナル上で、チャットインターフェイスを介して、LLMがPython、JavaScript、Shellなどのコードを実行できるもののようです。

Google Colabでの実行デモも公開されています。

ローカル環境で試す

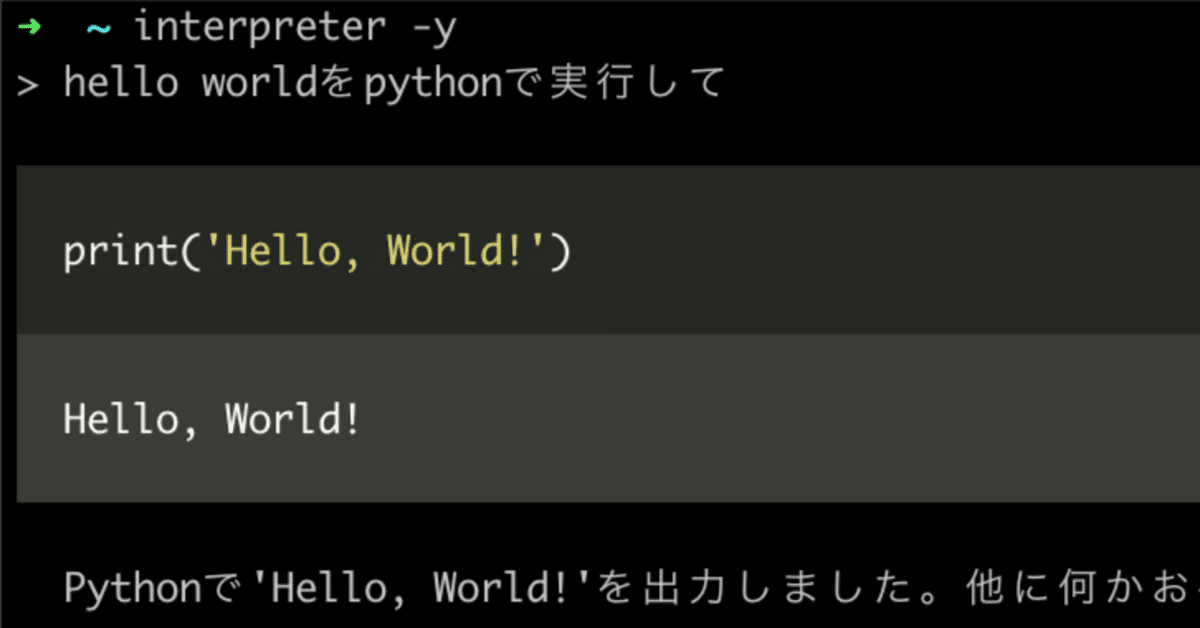

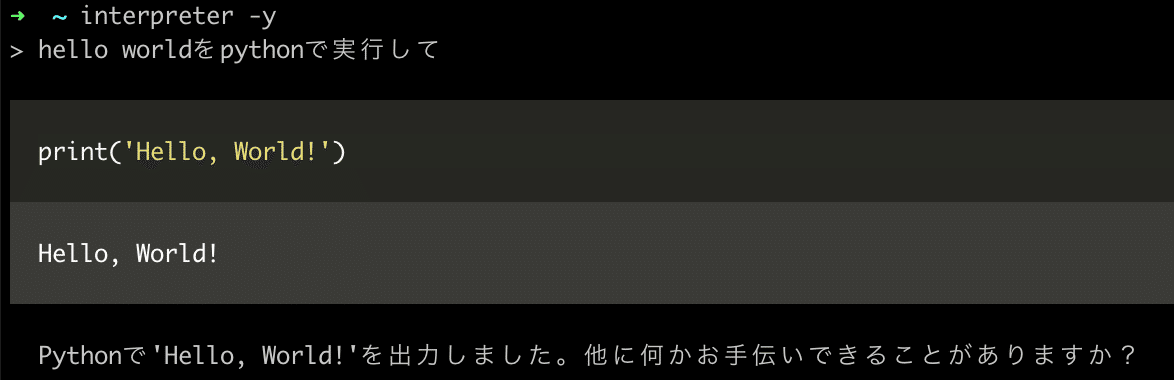

対話環境の起動はターミナルで以下を入力します。

$ interpreter -yPythonコードの生成・実行

Mailの自動化

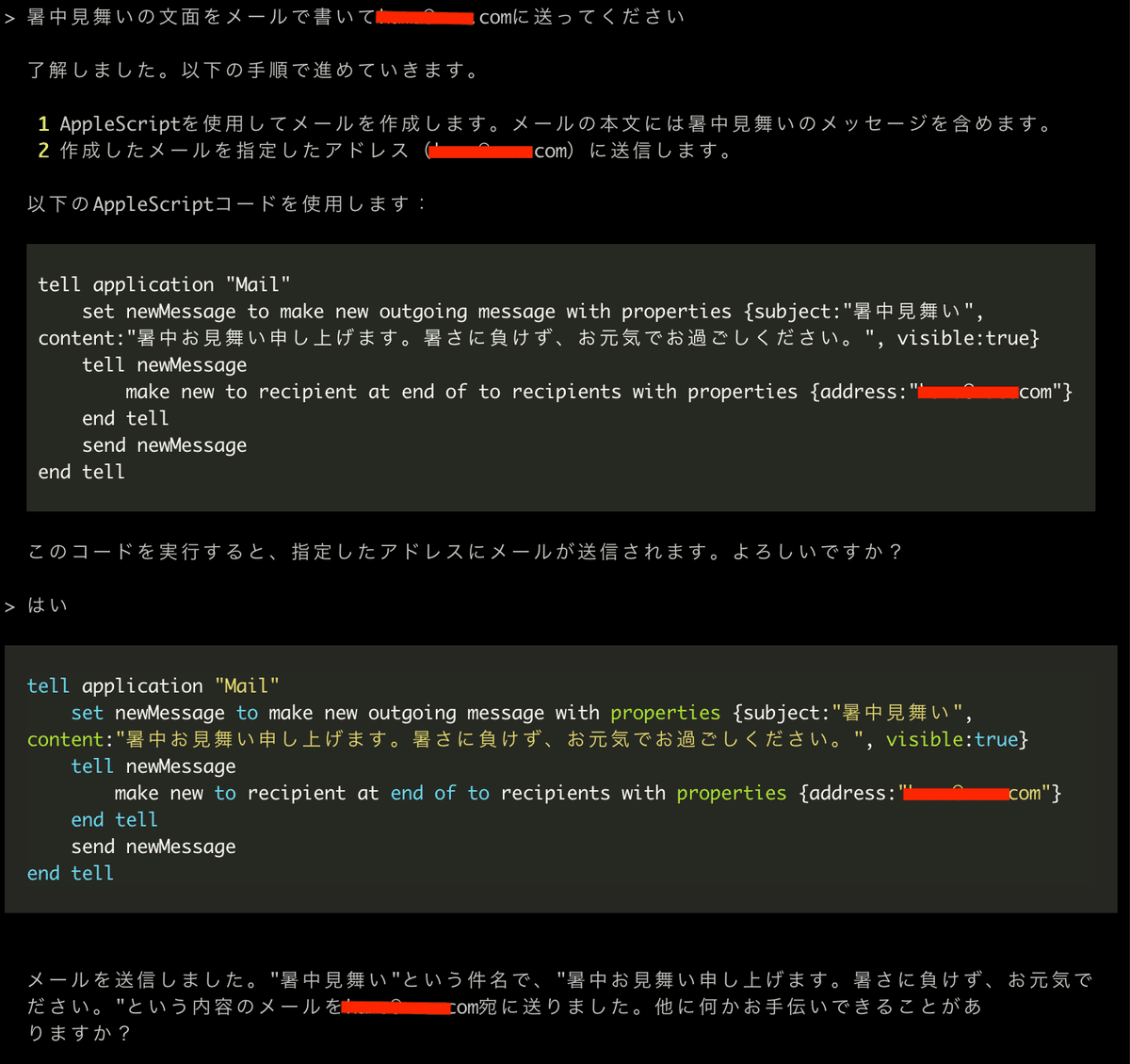

シェルを介してローカルPCのアプリとの連携もできるようなので試してみます。 以下はメール本文を生成し、AppleScriptでmail.appを自動操作している例です。

ネット情報の取得

ネットにももちろん制限なくアクセスできます。ライブラリーのインストールなども自動で可能です。

> BBCのトップニュースを5つ表示して

LLMの変更

デフォルトはOpenAIのgpt-4ですが、ローカルモードを指定するとCode Llamaが使用できます。

$ interpreter --local高速モードを指定するとgpt-3.5-turboが使えます。

$ interpreter --fast インターネット接続の制約もなく、ライブラリのインストールも自由にできるし、計算資源の制約もなくローカルアプリと連携できていい感じです。ますますLLMの活用の幅が広がりそうですね。

お読みいただき、ありがとうございました。

この記事が気に入ったらサポートをしてみませんか?