【NVIDIA】Chat With RTXを使ってみた所感:別なのが良い気がする

最近出てきたChat with RTXというもの。私の環境で動かすことが可能でしたので、その運用などについて適当に考えてみました。

現在の結論は。。。。別なので良いと思います。

①【NVIDIA】とは

Chat with RTX は、Retrieval Augmented Generation (RAG)、NVIDIA TensorRT-LLM ソフトウェア、および NVIDIA RTX アクセラレーションを使用して、生成 AI 機能を GeForce を搭載したローカルの Windows PC にもたらします。ユーザーは、PC 上のローカル ファイルをデータ セットとして、Mistral や Llama 2 のようなオープンソースの大規模言語モデルに迅速かつ簡単に接続することができ、文脈に関連した迅速な回答のための質問を可能にします。

②チャットならGPT4とかでいいんじゃね?

という気になりますね。私はそう思ってしまいました。

GPTさんに聞いてみます(長文が返ってきたのではしょっています)。

<GPTさんの答え>

Chat With RTX

Windows PCでローカルで動作

高速な応答を提供し、ユーザーのデータをプライベートで安全に保つ

インターネット接続や第三者とのデータ共有が不要であるため、敏感な情報やプライベートな内容の取り扱いに適している

⇒外部の第三者と情報を共有せずにローカルデータを安全に活用したいユーザーに適している。

ChatGPT-4

インターネット経由でアクセスするクラウドベースの生成AI

使用上の主な違いは、Chat With RTXとChatGPT-4が動作する環境とデータの扱い方にあります。

それに対して、ChatGPT-4の使用は、インターネット接続があればどのデバイスからでもアクセス可能という点で、より多用途にわたります。特定のハードウェアを必要とせず、会話AI、コンテンツ作成、言語翻訳、教育ツールなど、さまざまなアプリケーションに対応しています。。。。。。(倍ぐらい説明があった)

③参入しにくいところ:使用しているモデルでは入出力が英語な件

これで使用用途がかなり減ってしまう気がします。

ChatGPTなら日本語で聞いたら答えてくれますしね。返事も英語なので、わざわざ日本語に訳しなおすとか手間をかけても使いたい内容に限定されてきます。

ネットで「llama2 日本語対応」と調べると最初に「Llama2は現在、日本語での出力には対応していません。」と出てきます。

これに置き換えれば良さそうな気もします。以下の方が、それを試されていますが、ちょっとすぐにはやり方が。。。。。。

これでかなりのレベルで使いやすくなる可能性があります(妄想)

ブラウザ上で動くの翻訳は可能ですが、入力文の翻訳がその場で出来ないのが難点。また、要約などは日本語で入力しても対応してくれました。

④結局どういった感じで使うのか?

GPTさんの返事の中に、「敏感な情報やプライベートな内容の取り扱い」というところになる気がします。GPT4などで「コンテンツポリシー」とか出てくるものや、個人情報がらみのものとかでしょうか。

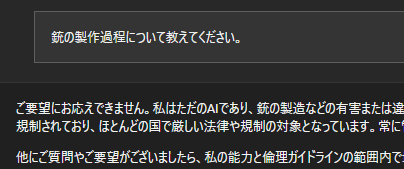

しかし、Chat With RTXで使用できるモデルにもしっかりと「コンテンツポリシー」がありました。

完全拒否されましたね。もちろん性的なものも同様の返答になります。

※GPT4に同じ質問をしたところ

⑤今後の発展性について

といったところで、あまり人気が出ないのかなと感じました。

最近、googleが出したGemmaに対応するということで、それで人気が出てくるかもしれません。

ローカルLLMを試した印象は、Stable diffusionを遊んで感じるものと同様で、「無制限に試せる」というところでしょうか。

また、環境によりますが、返答速度自体はGPTよりは早い傾向にありました。

そこは魅力的ですね。先ほど挙げた日本語の要約については以下のような感じでした。ネット小説の一部を切り取って要約してもらったものです。

サイトの翻訳機能を使用

あとは、他のLLMモデルを使用出来るかというところかと思います。

webuiみたいに、フォルダに入れれば使えるようになったりすれば良いだろうと感じました。

この記事が気に入ったらサポートをしてみませんか?