LLM+ComfyUIの「LaVi-Bridge」 vs 「ELLA diffusion」 vs 「通常生成」を比較する

2024/5現在ですが、以前の記事で紹介したこともある「ELLA-diffusion」がありますが、そこのGithubでも言及されていますが、「LaVi-Bridge」というものもあります。

Title: Bridging Different Language Models and Generative Vision Models for Text-to-Image Generation

Year of Publishing: 2024

どんなもの?

この論文は、異なる言語モデルと生成視覚モデルを統合し、テキストから画像を生成する方法について述べています。特に、LaVi-Bridgeという新しいパイプラインを提案し、多様な事前学習済みの言語モデルと生成視覚モデルを組み合わせることで、より高度なテキストから画像生成を実現します。

先行研究と比べてどこがすごい?

LaVi-Bridgeは、既存のテキストから画像生成モデルに対して、事前学習済みの異なる言語モデルと視覚モデルを柔軟に統合する能力を提供します。これにより、各分野で進化した最先端のモデルを組み合わせることで、テキストの意味理解や画像品質が向上する可能性があります。また、元のモデルの重みを変更することなく統合できる点が革新的です。

技術や手法のキモはどこ?

LaVi-Bridgeの核心は、LoRA(Low-Rank Adaptation)とアダプターを用いて、言語モデルと視覚モデルの間に橋渡しをする点にあります。これにより、各モデルの元の重みを保持しつつ、新しいモデルを統合できます。また、小規模なデータセットを用いてこれらのモデルを微調整することが可能です。

どうやって有効だと検証した?

LaVi-Bridgeの有効性は、様々な言語モデルと視覚モデルの組み合わせを用いて検証されました。具体的には、テキストと画像の整合性や画像品質の評価指標を用いて評価されました。短いプロンプト、長いプロンプト、複合プロンプトなど、異なる条件下での性能を測定し、LaVi-Bridgeが高度なモデル統合によって性能向上をもたらすことを示しました。

議論はある?

LaVi-Bridgeは、柔軟なモデル統合を可能にする一方で、新しいモデルの統合による性能向上の程度や、具体的なアプリケーションでの適用可能性については、さらなる研究が必要とされています。また、元のテキストから画像生成モデルに対して直接適用した場合、性能が必ずしも向上しないケースもあることが指摘されています。

上のサイトにおいて、ELLA-diffusionとLaVi-Bridgeと通常生成を比較するフローが公開されていました。

参考までに下に貼っておきます。

追加でインストールするものは、LaVi-BridgeのComfyUIのノードのみでした。

生成してみた結果

使用したプロンプト

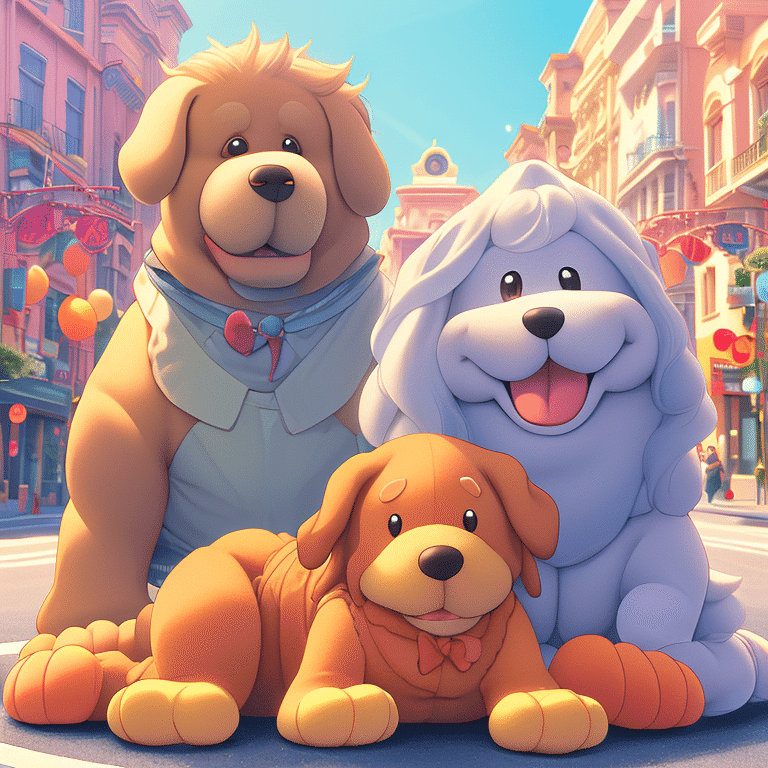

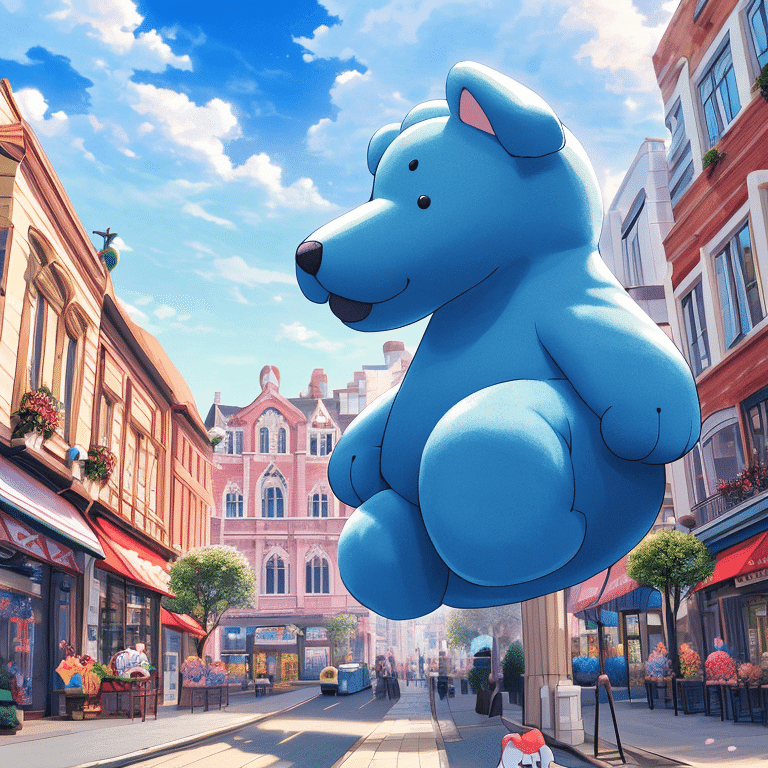

A large stuffed dog sits in a peaceful atmosphere. The large stuffed dog is shaped very much like a real dog. The stuffed dog has a large mouth. The stuffed dog is on a main street in the city, and the atmosphere is cheerful. The sky is clear, best quality, extremely detailed, 4k resolution

大きな犬のぬいぐるみが穏やかな雰囲気の中に座っている。大きな犬のぬいぐるみは本物の犬によく似た形をしている。ぬいぐるみの犬の口は大きい。犬のぬいぐるみは街の大通りにいて、明るい雰囲気です。空は快晴、最高品質、非常に詳細、4K解像度

①ELLAの画像

②LaVi-Bridgeの画像

③通常生成

比較用のプロンプトが合っているかどうかが難しいところですが以下のような印象になりました。

ELLA>>LaVi>=通常

ということで、現段階ではELLAが第一選択になりますが、残念なことにGithubサイトにてELLAはSDXL対応しないと表明しているようで、本家ではこれ以上の進歩は得られない可能性が出ています。

LaViに関しては、SDXLについての対応は今後予定はあるかもみたいな記載があるので、将来的にはこちらの方が良くなる可能性もあります。

この記事が気に入ったらサポートをしてみませんか?