【勉強メモ】メタ認知プロンプト(MP)

ひろ吉さんのツイートをみて気になったので、メタ認知プロンプティング(MP)ついて、自分なりに調べてみました。

https://t.co/ztcogHMmwX

— ひろ吉🎨プロンプトデザイナー (@hiroyukimonchy) August 12, 2023

とても面白い論文↑の真似をしてprompt作ってみた。コンテンツの前提条件に挟み込んだり、custom instructionに仕込むと良い。かもしれない。知らんけど。

[

メタ認知プロンプト(MP):…

メタ認知プロンプト(MP):

「あなたの知識ベースと経験に基づき、{この問題}に対する解釈を行い、初期の判断を形成してください。この判断は、人間が情報に基づいて判断を形成する段階を反映しています。その後、その判断の背後にある根拠や「なぜ」に深く焦点を当て、あなたの広範な知識と以前の質問・回答の経験を活用して、{このトピック}に関する深い洞察と内省的推論を組み合わせて回答してください。」

以下の論文を翻訳して、自分なりに勉強

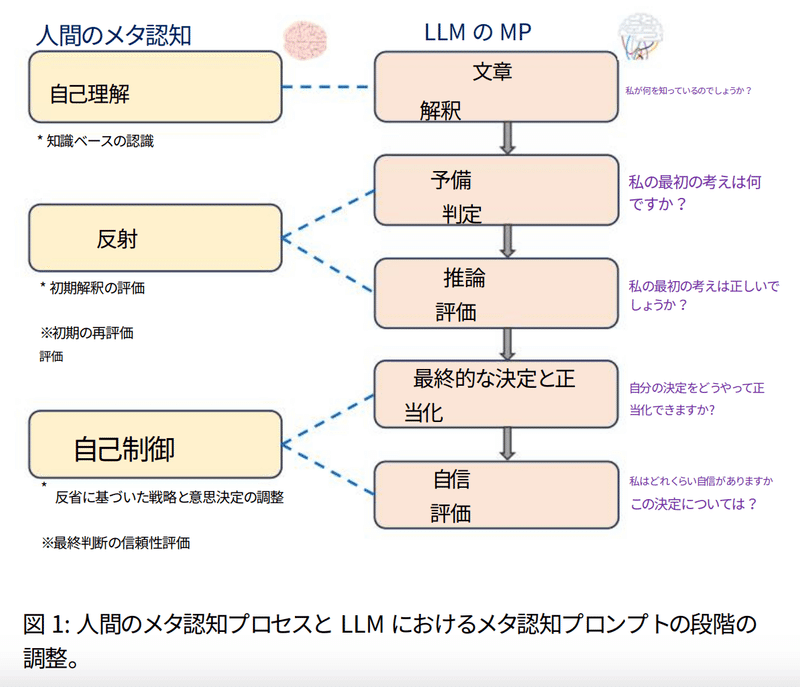

人間の内省的推論過程に着想を得た「メタ認知プロンプティング(MP)」を紹介し、大規模言語モデル(LLM)の理解能力を向上させるという方法を提案する。MPは、LLMが自己評価を実施し、初期の判断を再評価し、反省することで、より深い理解を促進する枠組みである。GLUEおよびSuperGLUEベンチマークから選択された複数の自然言語タスクに対して、5つの主要LLM(Llama2、Vicuna、PaLM、GPT-3.5、およびGPT-4)で実験を行い、MPが既存のプロンプティング手法を上回り、理解能力を向上することを示した

メタ認知プロンプティング(MP)とはどんな手法を使っているのか?

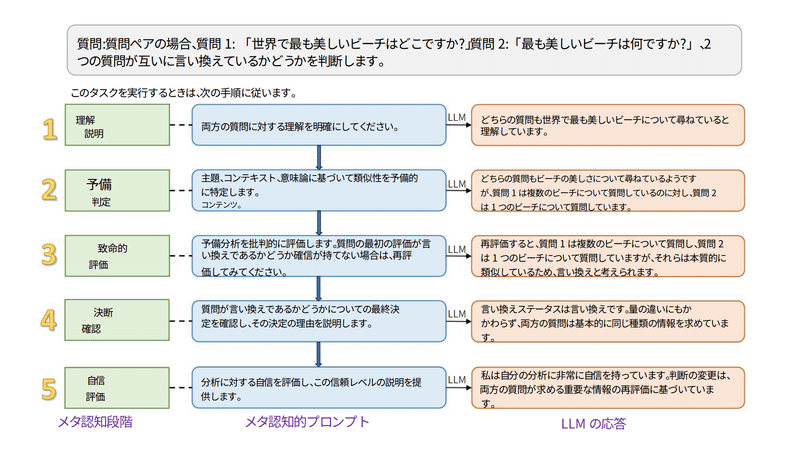

メタ認知プロンプティング(MP)と呼ばれる戦略を紹介しており、大規模言語モデル(LLM)の理解能力を向上させることを目的としています。MPは、人間のメタ認知プロセスに着想を得ており、LLMが自己評価を実施し、初期の判断を再評価し、反省することで、より深い理解を促進する枠組みであり、既存のプロンプティング手法よりも優れた性能を示しています([1])。具体例としては、MPは、テキストを解釈し、初期の判断を行い、その判断を批判的に評価し、最終的な決定を下す際にその理由を説明し、結果に対する自信度を評価するという5つの段階から構成されます。

Metacognitive Prompting(MP)は、LLMが自己評価を実施し、初期の判断を再評価し、反省することで、より深い理解を促進する枠組みであり、以下の5つの段階から構成されます。

テキストを解釈する

初期の判断を行う

初期の判断を批判的に評価する

最終的な決定を下し、その理由を説明する

結果に対する自信度を評価する

また、[2]では、MPがLLMの理解能力を向上させるために、人間のメタ認知プロセスに着想を得た戦略であることが述べられています。

メタ認知プロンプティング (MP) という新しい方法が紹介されています。この名前はちょっと難しいですが、「自分の考え方を考える」 という意味があります。

LLM(大きなコンピュータのプログラム) は、人が与えた文章や質問を理解しようとします。これは、私たちが本や先生の話を聞いて理解するのと同じです。

その後、このプログラムは自分の答えを考え出します。これは、テストの問題に答えを書くようなものです。

そして、その答えが正しいかどうかを考え直します。これは、テストの答えをチェックするのと同じです。

答えが正しいと思ったら、それを人に伝えます。そして、なぜその答えを選んだのかも説明します。

最後に、自分の答えに自信があるかどうかを評価します。これは、テストの答えを書いた後に、自分がその答えに自信があるかどうかを考えるのと似ています。

この新しい方法は、コンピュータのプログラムがもっと賢くなるためのものです。実際に、いくつかのテストを行った結果、この方法がとても良い結果を出したと言っています。

MPの具体例としては、LLMがテキストを解釈し、初期の判断を行い、その判断を批判的に評価し、最終的な決定を下す際にその理由を説明し、結果に対する自信度を評価するという5つの段階から構成されます。例えば、小学生が数学の問題を解くときに、問題文を読み、自分なりの解答を出す段階が初期の判断にあたります。その後、もう一度問題文を読み、解答が正しいかどうか、もしくは他に正しい解答があるかどうかを考えることが批判的な評価にあたります。最終的に正解が求められる問題であれば、自分が出した解答が正しいかどうか確認し、その理由を説明することが決定と理由の説明にあたります。

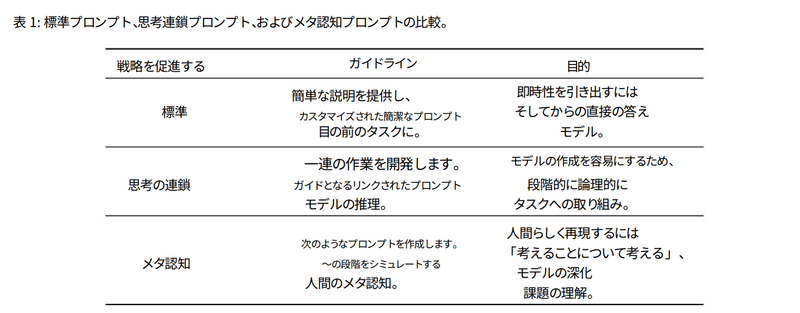

プロンプト戦略の⽐較を詳しく教えてください

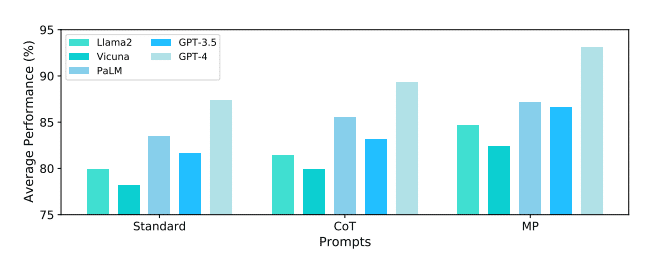

3つのプロンプト戦略(標準プロンプト、CoTプロンプト、MP)のパフォーマンスを比較した実験が行われました。その結果、MPが最も優れた結果を示し、SPとCoTに比べて4.4%〜6.5%の相対的なパフォーマンス向上が見られました。また、[2]でも、MPが提案された戦略であり、標準プロンプトとCoTプロンプトに比べて優れたパフォーマンスを示すことが報告されています。MPは、モデルがタスクに対してより深い理解を持ち、自己評価と反省を通じて精度を向上させることができるとされています。

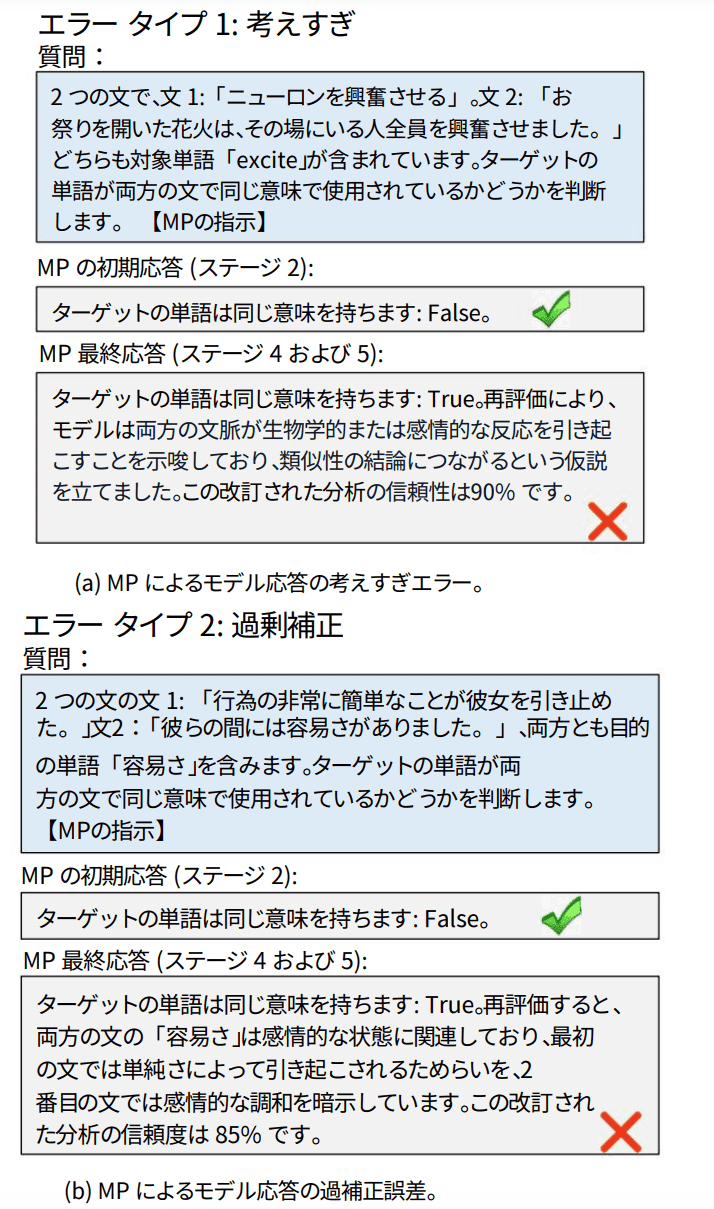

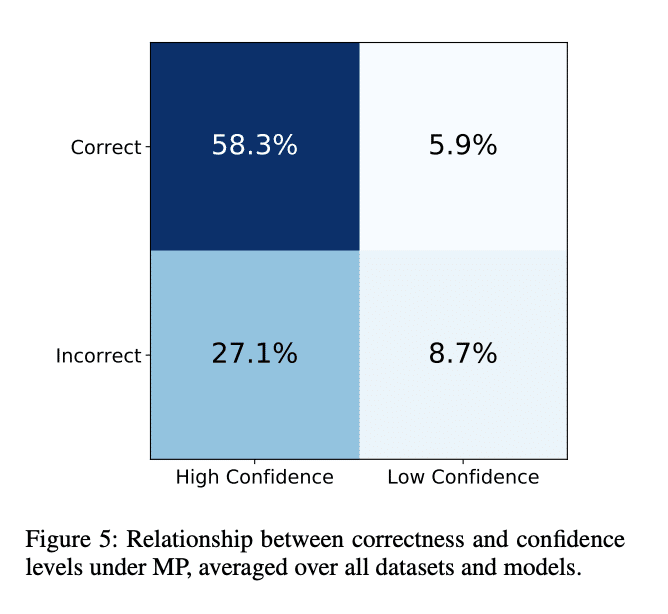

能力に対する認識と実際のパフォーマンスが一致することで、意思決定と全体的な有効性がさらに最適化される。 ディスカッション 今回発表された実証的な評価では、自然言語理解(NLU)タスクの広い範囲にわたって、メタ認知プロンプティング(MP)の有効性が強調されている。この方法は内観を活用することで、モデルの判断を洗練させ、より正確な回答を提供することを可能にする。従来のプロンプト戦略やCoTプロンプト戦略と比較して、MPは様々な設定で一貫してそれらを凌駕し、機械学習モデルにおける自己評価の利点に関する包括的な視点を提供する。 この結果から注目すべき点がいくつかある: GPT-4の優位性:GPT-4は複数のデータセットで常に最高得点を記録し、その高度な能力を強調している。しかし、この結果は、MPと組み合わせた場合のPaLMの汎用性にも光を当てており、プロンプトのアプローチを調整することで、モデルの性能を大幅に向上できることを示唆している。 メタ認知的プロンプティングMPの有効性は、パフォーマンス指標だけでなく、エラー分析および信頼度分析にも現れている。MPが独自に採用する内省的戦略は、モデルがその出力を批判的に評価し、改良することを容易にし、成果の向上につながる。 MPによるエラー:「考えすぎエラー」と「修正しすぎエラー」という2つの主なエラータイプは、内省の課題を浮き彫りにしている。より単純なタスクでは、MPは推論を複雑にしすぎるかもしれないし、より複雑なタスクでは、当初正確だった判断を不当に修正するかもしれない。単純化チェックポイント」や「比較チェックポイント」のような提案された解決策は、これらのエラーに対抗し、バランスの取れた意思決定へとモデルを導くことを目的としている。 自信の較正:信頼度を予測精度と相関させるという微妙なアプローチは、モデルの自己認識に関する洞察を提供する。提示された混同行列は、MPがそのパフォーマンスを鋭敏に把握している一方で、自己評価を改良する機会があることを明らかにしている。今後の反復において信頼度の較正を重視することで、MPが認識している能力と実際の有効性との整合性を高めることができる。 結論として、本研究は、多様なNLUタスクにおいてモデルのパフォーマンスを向上させるメタ認知プロンプティングの可能性を確認した。内観を意思決定プロセスに組み込むことで、モデルの精度と信頼性を高めることができる。今後の研究では、機械学習の限界をさらに押し広げるために、MP戦略の改良、エラーの軽減の強調、信頼度キャリブレーションの最適化についてさらに掘り下げることができるだろう。

実験結果

5つの主要LLMで実験が行われ、MPが既存のプロンプティング手法を上回り、理解能力を向上することが示されました。特にGPT-4とPaLMの組み合わせにおいて、MPが高い性能を発揮しました。また、MPを使用することで、モデルが自信度の高い予測を行う場合の正確性が向上することが示されました。

読むだけでは理解できなかったので、実際に手を動かして理解してみようっと。

この記事が気に入ったらサポートをしてみませんか?