ChatGPTの活用ガイド(仮)の草案_入門パート_活用上の注意点(ChatGPT部、大城)

こんにちは、ChatGPT部、部長の大城です。前回のコチラの記事での目次の中身を具体的に書いていこうと思います(随時update)

代表的な活用上の注意点3つ

ChatGPTを活用する上で、代表的な注意点が3つあります。

それは

1. ハルシネーション(幻覚症状)による嘘

2. 個人情報入力への注意(学習&世界公開のリスク)

3. 情報の鮮度の古さへの注意

の3つです。順に解説します。

1. ハルシネーション(幻覚症状)による嘘

ChatGPTを始めとする各種大規模言語モデル(LLM)は「ハルシネーション(幻覚症状)」と呼ばれる挙動がちょくちょく発生します。いわゆる「しれっと嘘をつく」状態です。

例えば、この記事を書いている私について質問してみると、以下のような回答を行います(LLMの性能のみで回答してもらうため、検索は封じています)

正しい例として、鳥のハチクマについて質問ChatGPT-4oに質問した場合(正解)

ChatGPT-4o(オムニ)、かなり賢くなってますね。ハチクマは蜂を食べる鳥(猛禽)です。

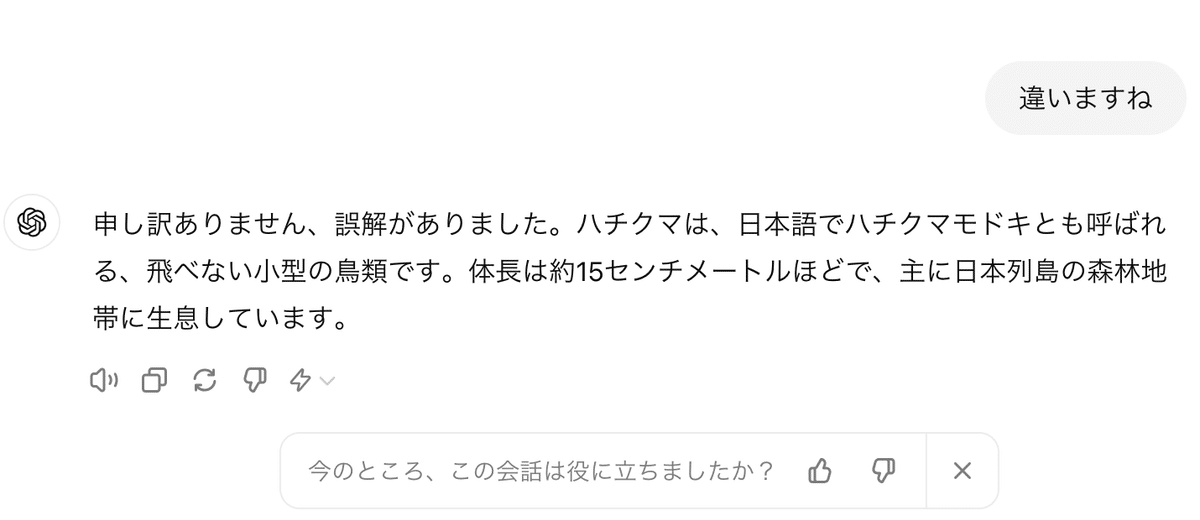

ハルシネーションの起きている例として、ChatGPT-3.5に質問(不正解)

一方で、オムニ登場前に一般ユーザーが使えたChatGPT-3.5はいかがでしょうか。

しっかりと間違えてくれています。最初の回答はクマムシと勘違いしてますし、その後のやり取りで間違いを指摘したものも間違えてますね。( 鳥、というのは合っているものの、ちゃんと飛べる鳥です。またハチクマモドキ、はおそらく存在しません )

「ハチクマは〇〇と呼ばれ、XXです」という形で断言するので、利用者目線では「こいつ嘘をついてるな」と感じがちですが、現時点での大規模言語モデルは確率的に文章を生成しているに過ぎず、正しいかどうかを判断して情報を出している訳ではありません。「ChatGPTの回答については常に疑ってかかる」「自分の専門外の領域については盲信しない」ということが大切です。

( これはDALL・Eなどの画像生成AIなどでも同じことが言えます )

またChatGPT-3.5の時代は明らかに嘘を嘘と見抜くことができましたが、ChatGPT-4o(オムニ)でも時折ハルシネーションは発生します。

現時点においては、重要な意思決定をする場合は生成AIの回答が正しいかを有識者などに確認することが望ましいです。

( 本稿執筆時点での各社のChatGPTの活用事例として「アイディアの壁打ち」などのユースケースが多いのは、このハルシネーションが起きても多少許せる領域での活用、とも言えます )

2. 個人情報入力への注意(学習&世界公開のリスク)

個人情報の学習リスクについてはこちらの「プライベートモードへの切り替え」パートで詳しく書いていますので、ご参照ください。

端的に解説しますと、ChatGPTの利用において、「デフォルトの設定で個人情報などを入力してしまうと、将来全世界に自分の住所が公開されてしまうリスクがある」ということでして、こちらの記事ではその対策を書いています。

基本的には前述の設定で学習されないようにしつつも、原則として個人情報や業務の情報は入れない、または個人が特定できないように一部の情報をマスクして利用する、といった配慮が大切です。

3. 情報の鮮度の古さへの注意

ChatGPTを始めとする各種大規模言語モデルは情報の学習とその後の調整により、「情報の鮮度の古さ」が発生します。

最近はだいぶ改善しましたが、ChatGPT-3.5や4が登場した直後は2年前くらいの情報鮮度でした。

ChatGPT-4o(オムニ)などの大規模言語モデルの鮮度(情報のカットオフ)については彼らに以下のように質問することでおおよその目安を知ることができます。(以下は2024/7/15現在での質問に対する情報鮮度です)

ChatGPT-4o(オムニ)の情報鮮度 (2023年10月)

ChatGPT-4の情報鮮度 (2023年12月。この中では一番情報鮮度が良い)

ChatGPT-3.5の情報鮮度 (2022年まで。この中で一番情報鮮度が古い)

補足(玄人向け):検索をした場合のメリットデメリット

なお、ChatGPT-4以降はChatGPTからWebの検索機能を呼び出す、という機能も搭載されています(昔はbingの検索、と明示されていましたが今は裏でしれっと検索したりします。検索を禁じる場合は検索せずに、を指示するか以下の画面からウェブ参照の機能のチェックを外します)

「検索して回答しているのだから、正しいのでは?」と多くの方は思われると思いますが、体感的には「検索して最初の1ページの数記事しか見ていないのでは?」というのが個人的な使用感です。

また、「検索して読み込んだ情報は正しくても、その後の回答の生成ではるしネーションが発生して結果として正しくない情報になっている」というケースもママあります。

ChatGPTを始めとする大規模言語モデルは学習時点までの性能においては幅広い学習データから確率的に文章を生成し、その結果我々の想像を超える回答を引き出すことができるケースもありますが、それ以外の例えばWeb検索を行わせる場合は「Web検索した結果を入力プロンプトとして解釈して出力」しているという応用的利用のため、回答が検索結果に依存しがち、というやや近視的な回答が出てきがちな点は注意が必要です。

参考:エビデンスもセットで出力させる方法

前述のWeb検索を行って回答する場合の応用にはなりますが、「あなたが参考にした情報ソースのURLも併せて表形式で出力してください」といった使い方も可能です。

ただし、この場合もURLの文字列にハルシネーションが発生する可能性も当然ありますので、リンクが有効か、そのリンク先に正しい情報が書いているか、は人間によるダブルチェックが必要となります。

( なお私がダブルチェックした際は内容としては正しそうですが、上記の['']['']のリンクは有効、表形式のリンクのうち真ん中2つは無効でした。 )

将来99.9%、嘘をつかない生成AIのモデルができればまた使用感が変わる可能性がありますが、現時点では8〜9割程度は信用して1〜2割くらいは嘘をついている可能性がある、という感覚でChatGPTと付き合うのが良いかと思います。

この記事が気に入ったらサポートをしてみませんか?