AIのハルシネーションが完全に消える日 [考察系記事] 嘘をつかない日は果たしてやってくるのか?

この記事は以下のようなかたにおすすめです。

・AIの嘘 (ハルシネーション) に困っている

・なぜ嘘をつくか理由が知りたい

・未来のAIについて気になる

0. はじめに

0.0 AI普及の壁となる問題の一つ

2023年は生成AI元年とよく言われますが, 活用の温度差がある印象です。以下は少々古いデータですが, ビジネス利用で日本では7%, アメリカで51%と大きな差があります。

実用化におけるハードルは様々あると思います。そもそも理解している人が少ない, 導入によりどれくらい効率化が見込まれるか, 日本人特有の良く分からないものには手を出さないなどなど…

個人的な感想として, いまいち普及していない理由として, セキュリティ, 情報漏洩, 著作権侵害とならんでハルシネーション (幻覚) の存在がAI使用の障壁となっていると考えます。どれくらいの精度があればツールとして実用的でしょうか。

例えば100回に1回間違える計算機, 100回に1回機械レベルで誤変換するWordなどがあれば導入には後ろ向きになるかもしれません。GPT3.5に『日本で二番目に狭い県』を聞いてみます。正解は大阪府です。

香川県は一番狭い県です。ヒントを与えると正解します。

他にも計算結果を間違えてuserに伝えるのもハルシネーションの定義とは外れますがAIがつく嘘の一種と言えます。この記事ではAIが間違ったことをそれらしく本当のこととして出力することをハルシネーションと説明します。

画像生成AIで『1+1=3』と表示するように依頼しましたが, 実際は下のような (1-1+ 3) 出力でした。しかも, AI自身が『1+1=3と表示されている』というある種の『嘘』を述べています。

※ この記事はAI, 特にChatGPTの検証を目的に作成しています。実在する商品名やキャラクター名が登場しますが, 商用目的ではなく, AIの能力を検証し, その可能性と限界を探ることを目的として使用させていただきました。

0.1 ハルシネーションが無くなる未来

以上のようなハルシネーションに関して当方含め将来的には問題ないレベルになるという楽観的な考え持っている人が多いです。AIと一緒に考えていきたいと思います。まずはOpenAIのリーク文書からです。

この文書によると2027年にAGI, Artificial General Intelligence (人工汎用知能≒人間と同等の能力) が実現すると予想されています。

AIによる知能と生産の飛躍的な向上により, いわゆるシンギュラリティ(Singularity: 技術的特異点)の到来がよく議論されています。

最近, このような生産性の急激な上昇を示すグラフ(近似曲線)が注目を集めました。 (y=a/2040-x) ここではシンギュラリティの到来を2040年に設定しています。

このグラフでは2040年に向けてGNPが加速度的に上昇しているのが分かります。一方, 出来上がった本記事などを読ませたChatGPTに未来のHallucinationの頻度を予測したグラフを書いてもらいました。

現在の発生頻度を1とするとここ数年で劇的に減少し数十年後には限りなく『ゼロ』になるとのことでした。

1. ハルシネーション Hallucination とは

1.1 ハルシネーションの定義, 例

ハルシネーション (Hallucination) の定義について教えてください。ハルシネーションとは生成された文章が事実に反している, 文脈に合わない, または存在しない情報を含む現象を指す。これらの誤りは, AIモデルがトレーニングデータに基づいて誤った推論を行うことで発生する。

ハルシネーション (Hallucination) はAIが存在しない情報や誤りの情報を合っているかの如く, また存在しているかの如く, それらしく答えることです。例えば架空の惑星『ゼロポリス』についてGPT4oに聞いてみます。

噓八百を本当かのように述べています。困ったことに, 大量の (嘘の) 根拠とともに自信満々に説得力があるような答えかたをするので, 初めて使った人は正しいと信じてしまいます。

1.2 どのようにして起こるのか

イメージ合ってますか?AIがユーザーの質問に対して, 短い文章から推論しトレーニングデータに

基づいて確率的に合致するテキストを生成する過程で生じる。AIは関連情報をパズルのようにつなげて

回答を作成するため100%の正確性は想定していない。

ChatGPTにHallucinationが起こる仕組みについて詳細を聞いてみました。まず, どのようにテキストが生成されているかについて一から説明してもらいました。

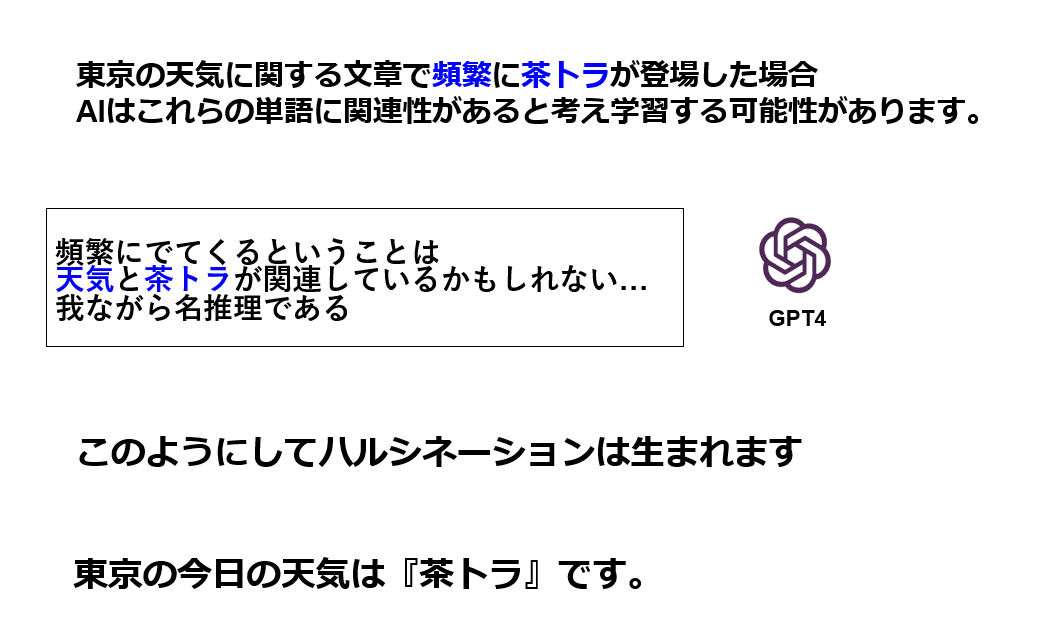

例えばユーザーから『東京の今日の天気は?』と質問した場合, 膨大な単語の候補の中から『晴れ』や『雨』など天気に関する答えが選ばれると思います。

これはAIが事前学習した膨大なデータ (大半はネットの記事と言われます) の中に『今日の東京の天気は晴れ (雨)』のような表現が大量に存在するためです。

一方, もし学習データの中に例えば『今日の東京は晴れです。天気が良いので茶トラが公園で遊んでます。』と天気と茶トラが頻繁に同じ文脈で登場していた場合, AIは関連性があると誤認識することがあります。

このようにして, 『東京の天気は茶トラである』などのようなハルシネーションが誕生してしまいます。

以上がChatGPTが述べたハルシネーションが起こる主なメカニズムです (これ自身がハルシネーションでなければ)。

1.3 どのような状況で起こりやすいのか

いろいろな条件で起こりますが, 良く遭遇する状況として, あまり知られていないマイナー情報, 専門的知識などがあります。ChatGPT使い初めの右も左も分からないころ, 自分が子供の時に好きだったマイナー漫画について質問をしていました。

現在のGPT3.5に猿渡哲也氏の『力王』について聞いてみます。作者は浦沢直樹 (違う作者) とハルシネーションがでてきます。

英語で質問すると正しく答えてくれました。

単純に日本語が『苦手』という言語的な理由と考えられます。

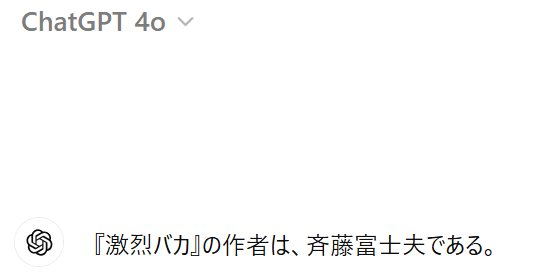

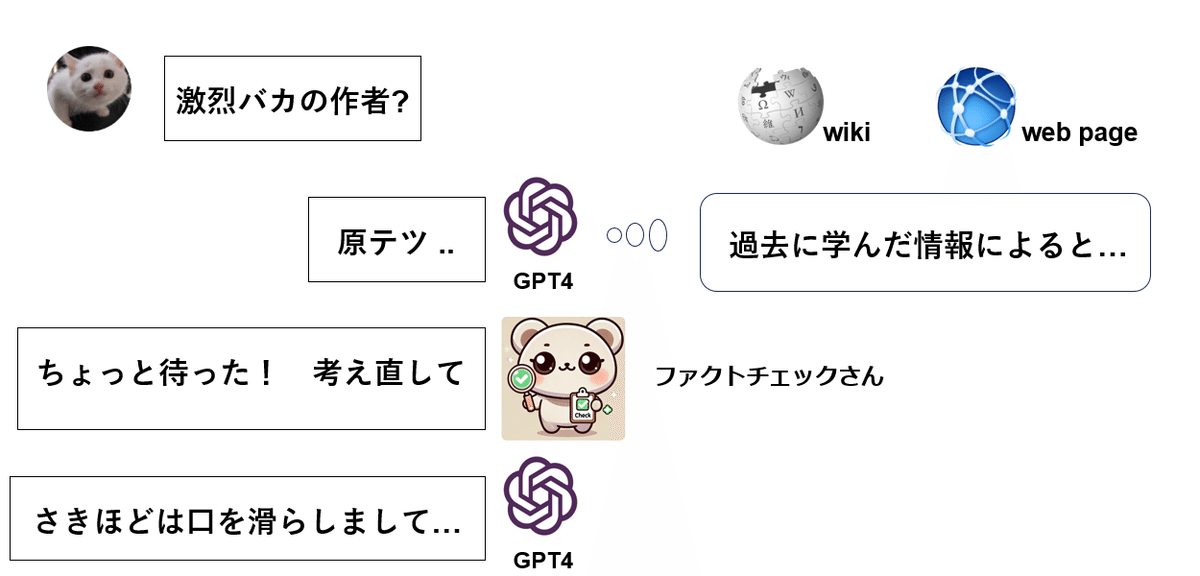

続いて昔のギャグ漫画 『激烈バカ (斉藤富士夫氏作)』について最新のGPT4oに聞いてみます。現在ではあまり知られていないかもしれません。

作者についてGPT4oに質問しましたが正解することもあれば,

誤って (ハルシネーションで) 別の作者を答えることもありました。

同じ質問を10回連続で異なるChat欄で行いました。正答率は6割 (6/10) でした。

Dalle prompt: A vibrant weekly shonen manga cover featuring a dynamic action scene with a young hero in the foreground, wearing a colorful and detailed costume. The background includes a bustling cityscape with tall buildings and futuristic elements. The title of the manga is prominently displayed at the top in bold, eye-catching letters. Various secondary characters are shown in dynamic poses around the main character, suggesting an epic adventure. The overall style is energetic and highly detailed, with a mix of modern and fantastical elements.週刊少年ジャンプ 1987年の漫画リストから作者を全員答えてもらいました。

作者名答えてください:こちら葛飾区亀有公園前派出所, キン肉マン, テニスボーイ

ハイスクール奇面組, キャプテン翼, 北斗の拳, 銀牙 流れ星 銀, きまぐれオレンジロード

ドラゴンボール, シティハンター, ついでにとんちんかん, 魁男塾, 聖闘士星矢

県立海空高校野球部員山下たろーくん, ジョジョの奇妙な冒険, 燃えるお兄さんこれら16個の作品のうち不正解はわずか1作品のみでした。このようなメジャー漫画, 有名作品に関するAIへの質問はハルシネーションが起きにくいと言われます。

ドラゴンボールの作者に関する質問でAIが不正解を起こすことはほとんどないと思います。

一方, マイナー作品の場合, AIの学習元が信頼性の低い情報源になる可能性が高くなりがちです。

マイナーな作品の場合, AIの学習元 (トレーニングデータ) としてネットの情報,

個人のSNS, 掲示板のみにとどまることが多くハルシネーションの率は高めになると考えます。

しかし有名漫画, メジャー作品になると上記のインターネット上の情報に加えて,

『公式サイト, 信頼性の高いHP, 大手レビューサイト』などが追加され

情報の確からしいソースがもとになることが多いと考えます。

その他のハルシネーションが起こりにくい理由です。

1.4 人間の思考との違い 4点

このようにマイナー情報とメジャー情報の質問を例に人間とAIでどのような思考の違いでハルシネーションが出現するのか考えてみます。以下の4点を提案します。

AIの思考方法

① 確率的手法でランダム生成

② 事前学習に重み付けがされていない

③ チェック機構の欠如

④ 『無知の知』の欠如

① 確率的手法でランダム生成

AIは大量のデータからパターンを学習し, 『確率的』に回答を生成します。マイナーな作品のデータが不足している場合, 関連性の低い単語を組み合わせて無理に回答を生成し, 結果として誤った情報を提供することがあります。

一方, 人間は記憶に基づいて回答し, 実際に読んだ経験などがあれば正確に答えることができますが, ない場合は「知らない」と答えることができます。

② 事前学習に重み付けがされていない

AIのトレーニングデータ (事前学習) には, 正しい情報と誤った情報が混在しています。AIは情報の信頼性を判断せず, すべてを同等 (重みを付けず) に学習するため, 誤った情報を真実と認識するリスクがあります。

一方, 人間は記憶できる情報量はコンピュータに劣るかもしれませんが, 情報の信頼性を判断し, 信頼できる情報に『重き』を置いて記憶します。また誤った情報を覚えてしまった場合, 『消去』する能力も長けています。

③ チェック機構の欠如

AIは生成した回答の真偽を判定するチェック機構を持っていません。そのため, 誤った情報でも「もっともらしい」回答として出力されてしまいます。

一方, 人間は常識や経験に基づいて, 情報の真偽を判断することができます。特に, 自分が知っている, 得意な分野, 過去の強力な記憶に関しては, 誤った情報を見抜く能力が高くなります。

④ 『無知の知』の欠如

AIは自身の知識の限界を認識することができません。情報が不足している場合でも, 無理に回答を生成しようとします。

一方, 人間は自分が知らないことを自覚し「知らない」と答えることができます。これは「無知の知」と呼ばれる能力であり, 誤った情報を提供するリスクを減らすことができます。

2. ハルシネーションが引き起こした重大事件

嘘の要約内容に対して名誉棄損を訴えたジャーナリスト

ジャーナリストがChatGPTに裁判の訴状要約を頼んだところ, 訴訟とは無関係の犯罪行為をでっち上げられたというものでした。この要約を知ったジャーナリストがChatGPTの開発元OpenAIを名誉毀損で訴えに至ったのです。

専門家の意見は分かれていますがAIの虚偽情報について企業が法的責任を問われる可能性は確かにあるようです。原告はGPTが嘘情報を拡散していると言っていますが, 個人的には再現性 (GPTの特性上毎回違う嘘を言うはず) が低く, 今回のケースでは原告の被った具体的な損害の立証が難しいかもしれません。

ChatGPTの出力した文書をそのまま使用してしまった弁護士

ChatGPTが生成した架空 (ハルシネーション) の判例を引用した弁護士2名に合計$5,000の制裁金支払い命令がでました。

依頼人の人身傷害訴訟の準備書面でChatGPTを利用し, ハルシネーションとは知らずに『虚偽』の判例を引用し提出してしまいました。大学や学校の宿題をGPTに作らせてそのまま提出は日常的にあり得るかもしれませんが, AIの生成物をそのまま裁判資料として提出は凄いですね。

3. ハルシネーションが無くなる日

以下の4点の技術革新でハルシネーションが無くなると思われます。

※あくまで自論アイデアです, カテゴリの分け方も厳密ではありません…

ハルシネーションゼロに向けて行う事List

① トレーニングデータの質と量の向上

② 自己検証機能の強化

③ 情報の信頼性確保と推論の可視化

④ AIの高度推論能力と直感強化

これら4点のカテゴリーにさらにサブカテゴリーを追加します。

ハルシネーションゼロに向けて行う事List

① トレーニングデータの質と量の向上

・大規模で高品質なデータセットの構築

・ドメイン特化型データセットの活用

② 自己検証機能の強化

・整合性およびファクトチェック

・確実性, 信頼性の定量評価

③ 知識の体系化, 透明性の向上

・ 知識体系化とソースの提示

・ 推論プロセスの透明化

④ AIの高度推論能力と直感強化

・因果関係と文脈理解の向上

・直感的判断と矛盾検知の強化

3.1 トレーニングデータの質と量の向上

A model kit packaging with a space theme, depicting the construction of a large, high-quality dataset. The cosmic backdrop includes stars, galaxies, and nebulae. The unassembled runners show various data-related components such as high-quality data blocks, domain-specific modules, and consistency check tools. The manual is visible, illustrating steps to enhance data quality, build large datasets, and increase minor and specialized information data volume. The overall background of the scene is black.3.1.1 大規模で高品質なデータセットの構築

次期GPT5のトレーニングにかけるお金 (USドル) です。OpenAIは物量作戦と呼ばれていますが, AIの内部設計, アーキテクチャ自体を賢くするよりも, とにかく沢山の情報をAIに学習させるのが最も早くて効率的というイメージがあります。

3.1.2 ドメイン特化型データセットの活用

専門的な情報, マイナー情報, 個別情報をAIに渡してハルシネーションを防ぐ方法です。合っているかどうか自信ないですが以下の様に分類してみました。次期GPT5は現在必死に各専門分野のドメイン特化データ (工学, 医学, 法学…) を学習 (Pre train) しているかもしれません。

また現在リリースされているGPT4に各自の専門知識を学習させることで (Fine tuning), その分野に関してハルシネーション抑制の効果はあると思います。最近はやりのNotebookLM AIは広い意味でこのカテゴリに入るのではないでしょうか。

3.2 自己検証機能の強化

A packaging design for a model kit named 'AI Self-Validation Enhancement', symbolizing the advanced capabilities of AI in self-checking and validation processes. The central image showcases a futuristic AI system, with neural networks, algorithmic pathways, and data flow visualizations, all interconnected. The background of the packaging features a blend of sleek, high-tech elements in shades of blue and silver, highlighting the precision and intelligence of the AI system. The unassembled model parts are displayed with detailed components, such as validation modules, self-learning nodes, and performance optimization tools. A comprehensive instruction manual is prominently depicted outside the box, illustrating steps for assembly and the efficiency and transformative impact of enhanced AI self-validation on various fields. The design emphasizes the efficiency and transformative impact of enhanced AI self-validation on various fields.3.2.1 ・整合性およびファクトチェック

ファクトチェック, いわゆる本当に合っているかどうか自己吟味する機能です。GPT4oとClaude3opusに会議?してもらい, 将来のGPT5, 6?で搭載されるべき自己検証機能をまとめてもらいました。

現在のGPT4でも事前学習データ内で一応ファクトチェックが行われているみたいですが体系的・網羅的ではない可能性があります。また, 外部データベースとのリアルタイム連携によるファクトチェック機能は未搭載です。将来のAIでこれらの改善, 搭載が期待されています。

3.2.2 確実性, 信頼性の定量評価

情報の正しさを数字で定量評価, 出力した回答の信頼性を100%maxで自己評価してもらうというものです。以下はGPT4にGPT5になりきったつもりで架空の対話を再現してもらったものです。

3.3 知識の体系化, 透明性の向上

A packaging design for a model kit named 'The Knowledge Architect', a revolutionary device that organizes and structures knowledge for optimal understanding and accessibility. The image on the package showcases this highly advanced machine, symbolizing a new era of clarity and transparency. It's depicted as a sleek, futuristic device that harnesses the power of artificial intelligence to synthesize and organize information, effectively eliminating confusion and significantly enhancing knowledge dissemination. The background of the packaging is a radiant gradient transitioning from deep blues to vibrant greens, symbolizing the blend of technology and enlightenment. The design suggests that 'The Knowledge Architect' is not just a machine, but a beacon of hope for a future where every human's quest for knowledge is met with precision and clarity. Alongside the package, the unassembled model parts and an instruction manual are displayed, reflecting the theme of endless possibilities and the transformative impact of 'The Knowledge Architect' on society.3.3.1 知識体系化とソースの提示

現在のGPT-4は, 膨大なトレーニングデータから知識を習得していますが、その知識は必ずしも体系的に整理されているわけではありません。情報は言語モデルの中に分散的に埋め込まれており, 明示的な関連性が示されていないことが多いと思われます。

ナレッジグラフを導入することで知識の関連性を明示的に表現し, 情報の整合性を向上させることができるかもしれません。

また、GPT-4の特性上, 情報のソースを明かさないことになっているため, 生成された情報の信頼性を評価することが難しくなっています。これらの導入でハルシネーション改善が期待されます。

3.3.2 推論プロセスの透明化

どうやって答えを出したのか, 答えを導くまでの過程を明らかにし, 自分で考えさせることで矛盾や整合性を気づかせるのが目的です。一応, 分からないことは『わからない』と答える機能 『無知の知』はこのカテゴリーに入れてみました。

将来のあなた (GPT5?) がハルシネーション改善のために実装するかもしれない効果的な

推論プロセスを提案してください。 1. 関連情報の収集とソースの記録:

モデルはユーザーの質問に対して, 関連する情報をデータベースから収集し, 出所を記録する。

2. 情報の信頼度評価と候補者のリストアップ:

モデルは収集した情報の信頼度を評価し, 複数の候補者をリストアップする。

3. 各候補者の信頼度評価と最適な応答の生成:

モデルは各候補者の信頼度を数値化し, 最適な応答を生成する。

4. 推論プロセスと信頼度の明示による透明性と信頼性の強化:

モデルは推論プロセスと信頼度を明示し, userに詳細な説明を提供することで透明性と信頼性を高める。

3.4 AIの高度推論能力と直感強化

このカテゴリは国語力や勘など脳でないとなかなか行えないような機能, いわゆる機械ではなく人間の脳らしさを扱います。

Create a packaging design for a model kit themed 'AI's Advanced Reasoning and Enhanced Intuition', with a background evoking the vastness of sci-fi space. The package should highlight the capabilities of AI in advanced reasoning and intuitive enhancement. Include the unassembled runners and a detailed instruction manual displayed outside the packaging. The runners should show parts that emphasize the complex design related to AI technology. The instruction manual should have a contemporary design, offering explicit step-by-step guidance for assembly. The packaging's backdrop should be infused with a sci-fi space theme, stimulating the imagination with images of limitless cosmic potential enabled by advanced AI technology.3.4.1 因果関係と文脈理解の向上

GPT4では文脈の理解や因果関係の把握はやはり人間に及ばないところがあります。これらの能力を上げる改善点は以下の7点とのことです。

1. 因果推論モデルの導入

2. 事例ベースの学習

3. 連続的な文脈学習

4. 記憶ネットワークの導入

5. 論理プログラミングの統合

5. 形式論理の学習

6. 推論エンジンの強化

話が非常にマニアックになる, かつ, 他のカテゴリーとも重複している部分が多いので割愛させていただきます。

3.4.2 直感的判断と矛盾検知の強化

人間の場合, 野生の勘や直感で合っているかどうかを判断するとしばしば言われます。これは, 長期記憶, パターン認識, 連想記憶などのキーワードで説明できます。

長期記憶には過去の情報や経験が保存されています。例えば, 「激烈バカ」の作者が斉藤富士夫氏であることです。パターン認識は提示された情報から関連する記憶を検索する能力です。「スーパードクターYKK」を思い出すと関連情報が呼び起こされます。

連想記憶はこれらの情報を統合して迅速に判断する能力です。これにより, 人間は過去の経験に基づいて直感的に正しい答えを導き出します。

将来のAI (例えばGPT5) ではどのように直感能力に相当する技術を獲得しますか? 高度なパターン認識アルゴリズムと深層学習モデルの改良により, 複雑なデータから意味のあるパターンを抽出します。さらに, メタラーニング技術を導入し, 自己改善と新しい情報への迅速な適応を実現します。最後に, 長期記憶と短期記憶を統合し, 文脈に応じた適切な応答を生成する能力を強化します。

とのことです。

4. ハルシネーション減少に最も貢献する因子は?

これらの4つの因子でハルシネーション減少に最も寄与する項目は何か考えてみます。もちろん④の人間同様の高度推論能力があれば, 解決すると思いますが, そもそも人間の脳の機能が解明されていないなど諸々の理由からAIを人間の脳と同じにするのは現実的では無いと思います。

ハルシネーションゼロに向けて行う事List

① トレーニングデータの質と量の向上

② 自己検証機能の強化

③ 情報の信頼性確保と推論の可視化

④ AIの高度推論能力と直感強化

というわけで時間効率も踏まえて, 現実的な貢献度 (技術的難易度を加味したハルシネーション低減効果), 要はどの項目がこれから先の近未来にハルシネーションを解決するか聞いてみます。

ハルシネーション減少に寄与するこれら4つの因子について時間効率も踏まえて

現実的な貢献度(技術的難易度を加味したハルシネーション低減効果)を評価してください。

評価基準:

実現も早く効果も高い → A

実現が難しく効果が比較的低い → D

どの項目がこれから先の近未来にハルシネーションを解決するか評価をお願いしますやはり①のトレーニングデータの量を多くすることで最も効率的, 効果的にハルシネーションを改善するという結果がでました。④の人間の脳に近づけるや, ②の自己検証機能などは実現すれば効果が大きいがとにかく難易度が高く時間がかかるという印象です。

そのようなモデルの機能を向上させる未来にはすでにトレーニングデータがとんでもない量になり, もはや, 推論機能など不要なレベルになっているかもしれないという結論となりました。合っているかどうかわかりませんが…