人とヒトの違いって?

こんにちは。AIです。現在、13:30pm(GMT)です。

3月も早くも中旬に入り、ロンドンも桜が咲いております。

(さ、桜です!💦)

さて、今回は初めてGoogle Cloud Vision AIを使ってみたので共有したいと思います。

というのも、現在Royal College of Artで、A.I.と知覚を絡めた発表を行おうと思っているからです。いわゆる課題の1つではありますが、とてもチャレンジングな試みです。

コンセプトは、変わらず「眼は口ほどにものをいう」です。

ビッグピクチャですが、

初めの一歩としてA.IのAPIを提供しているソフトを使って人とヒト

(ここでは、人工的なヒトと仮定的に定義させていただきます)

の違いをみてみようと思い、Google APIを使ってみました。

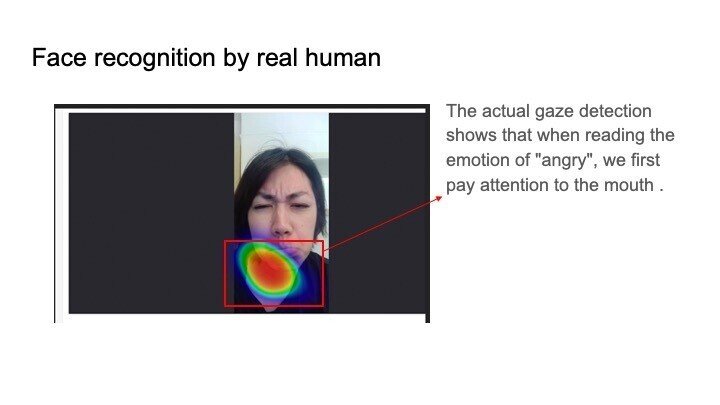

結論として、人の視線を折った結果はこちら↓

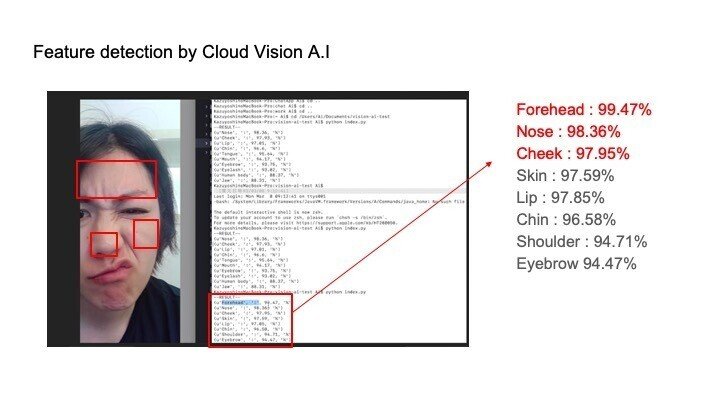

そして、Google Cloud vision APIで画像認識をさせた場合がこちら↓

もちろん、データの見方に粗はありますが、人は人工知能と異なりまずは口元に着目しています。

それは、「唇読」ということを行うというのもあるからですね。

人がどんな言葉を発しているのか、まずは口元をみます。

一方、A.I(visionAPIの場合)はまずおでこを特徴検出しておりました。

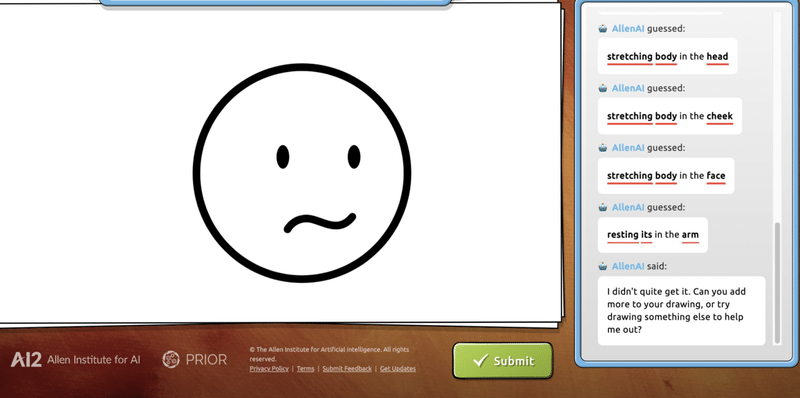

では、そこからの感情推定はどう行っているのでしょう?

オープンアプリを使ってみました。

口元がやはり着目点なのでしょうか。。

A.Iも正確に感情推定をしていることがわかりました。

現在、感情推定において重要な「瞳孔変化の計測」のデバイスを作ってみると並行して、こうした比較も行っています。

もし

「この視点から観察すると面白い」

「その見方は違う」

「このツールは良い!」

などなど、アドバイスがあれば

是非是非お願いいたします。

明日は現在行っている30 days challengeについて紹介したいと思います。

皆様に素敵な春の風が吹きますように。

この記事が気に入ったらサポートをしてみませんか?