神経回路網の高次機能

ちょうどのタイミングで、昨今の人工知能ブームの火付け役になった論文 (英語) のメモがnoteに載ったので「ディープラーニングと大規模言語モデルを用いた言語等の生成機能」が何故袋小路に入ったか考えてみました。

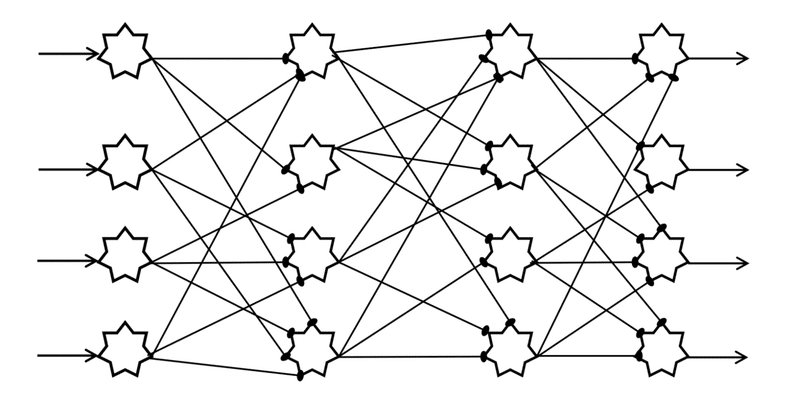

現在、主流の大規模言語モデルは「Transformer (変流器)」と呼ばれる「注意メカニズム」に基づいて演算されてます。変流器の構成は、以下引用に纏められてます。つまり、演算素子を平面上に並べた演算層を、直列に並べて各演算層間を全素子間結合で繋ぐ。口絵での縦の細胞層 (✵) が演算層に相当し、各細胞から出力する軸索が次の 下流層の全素子に繋がっているというイメージです。

- Transformerは、モデルがシーケンスの異なる部分に独立して注目することを可能にするマルチヘッド自己注目メカニズムに基づいている。

- アーキテクチャはエンコーダとデコーダで構成され、それぞれは注意メカニズムを利用する層のスタックとポイント単位の完全連結層で構成される。

此回路で処理する情報について、例えば「オバーさん」細胞について考えてみます。網膜の神経細胞レベルでは数百 (想像です。適当に好きな数字に置換えて下さい) の神経細胞が此情報処理に参加しますが、幾つかの神経層を経由して最終的には一つの神経細胞が答を出します。生物の神経系の働きとしては、その間に、「オバーさん」の顔の認識に参加し無い神経細胞は他の仕事をします。一方、変流器では、各演算素子 層は一度に一つの仕事しかしません。何万素子が有っても演算に参加する素子は限られてます。所謂「疎行列」と呼ばれる案件です。疎行列の計算効率は各層内の演算素子数を増やしても、層を深くしても悪化します。つまり、規模の拡大が期待通りには能力の強化に結び付か無い。

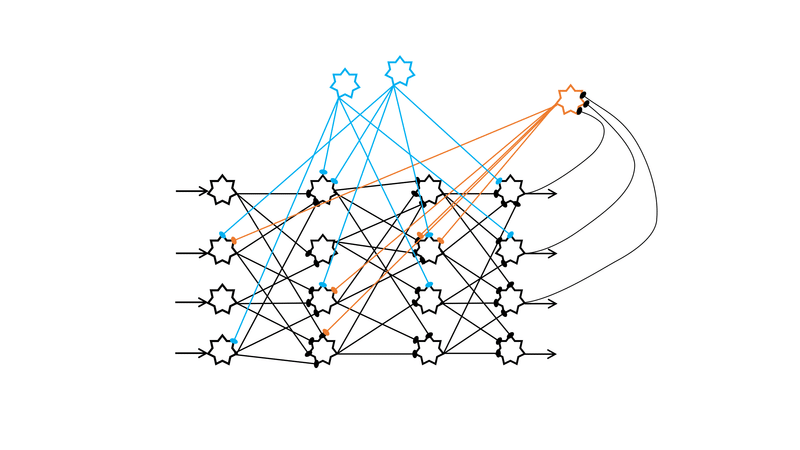

何で、神経系が並行作業が可能かと考えれば、神経回路網の上層に監督層が有って仕事を割り振ってると考えるのが論理的でしょう (下図)。哺乳類の神経回路で言えれば大脳基底核 (線状体等) や間脳 (視床等) が担当してると見るのが自然です。ドパミン細胞による報酬回路が一例で、ドパミン細胞は大脳基底核の黒質に居ます (大脳基底核とは)。

同じ機能回路を電子計算機の回路に実装するのは、頭の中では可能ですが、実地は専門外です。技術が進歩すれば其に合わせた機器が世に出るので、チャット待てば、って感じです。そう言えば、昔、Memory Management Unit (MMU, メモリ管理ユニット)と呼ばれる素子が有りましたが、その高次機能版って感じでしょうか。

この記事が気に入ったらサポートをしてみませんか?