【ChatGPTの歴史3/全3回】ChatGPTに人間から最後にプレゼントした善意の証 RLHF

AI暴走対策がChatGPTリリース前夜のAI研究業界の共通の課題だった

では短期シリーズのChatGPTの歴史、最終回です(^-^)。

前回は、GPT-2に爆弾の作り方を聞いてみるとホイホイ教えてくれちゃうので、そりゃさすがにまずいだろーというところまできました。

ここを直さないと世の中には大々的には出せない。そう考えていたのは、珍しくこのAIに関してはずっとその危険性故にクローズド主義を抜き通していたGoogle陣営だけではありませんでした。

OpenAI陣営(ChatGPT作ったところ)もまた、なんとかして、このAIの暴走を止めた上で世の中に出さないといけないと思っていた。

つまりChatGPTが2022年の終わりにどかーーんと出てくる前に、世界の最先端AI研究者の共通の課題は、AIの暴走をどうやって人間は手懐けることができるのかというところにありました。

ChatGPT誕生前夜 RLHFという決定打!

ここで、ChatGPTを使っている人はだれでも知っているChatGPTのトップページを見てみましょう。英語なので読み飛ばしている人が多いと思うのですが、ここにChatGPTの正体がばっちり書いてあったのでした。

ChatGPTのトップページ

ここには大事な秘密が書いてあるのだった

がズバリ書いてある

ChatGPTは秘密でも脅威でもなんでもない

トップページで親切にバラしています

【DeepL訳】

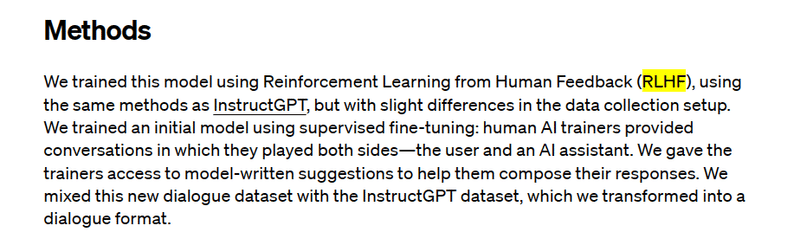

このモデルは、InstructGPTと同じ方法を用いて、人間のフィードバックからの強化学習(RLHF)を用いて学習させたが、データ収集のセットアップに若干の違いがあった。人間のAIトレーナーは、ユーザーとAIアシスタントの両方の側を演じる会話を提供しました。

InstructGPTと同じくRLHFを用いてこのモデルを作りました。

とあります。

つまり、ChatGPTのキーワードはRLHFなのです。でもRLHFって聞いたことありますか?多分普通にChatGPTに関心のある方は聞いたことないと思います。なぜか日本のChatGPTフィーバーではこの最重要なRLHFが一般的な文脈ではほとんど語られません。もちろんエンジニアの間では盛んに議論されています。

しかし、ChatGPT解説屋さんやマーケターと名乗る人は解説しません。ことによるとRLHF自体を知らないかもしれない。いや、トップページに書いてあるキーワードを知らないなんてことじゃだめでしょう。廃業しないと。

そこで、みこちゃんがかいつまんで説明します。

RLHFとは人類に優しい人類と共存できるAIを目指す

この小見出しの「RLHFとは人類に優しい人類と共存できるAIを目指す」とういのは、RLHFのみこちゃん解釈です。そこでまず中立的(技術的)にRLHFを説明します。

この記事をお読みの読者の方は、説明が終わった後にはおそらく、みこちゃんの解釈も間違いではない、そう解釈するのもいいんじゃないか、と思っていただけるのではないかと期待したいのですが、そこはお任せいたしますです。

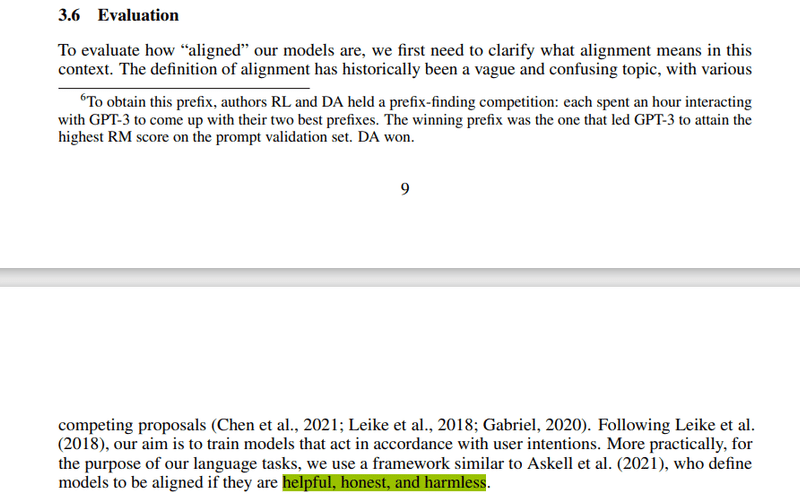

まず論文です。これはRLHFそのものの論文ではない(この論文でRLHFが提唱されたわけではない)のですが、InstructGPTという、ChatGPTが依拠している、ほとんどChatGPTと同じシステムについての論文ですので、ChatGPTでRLHFがどう使われているのかを見るには、これが一番良いと思いました。

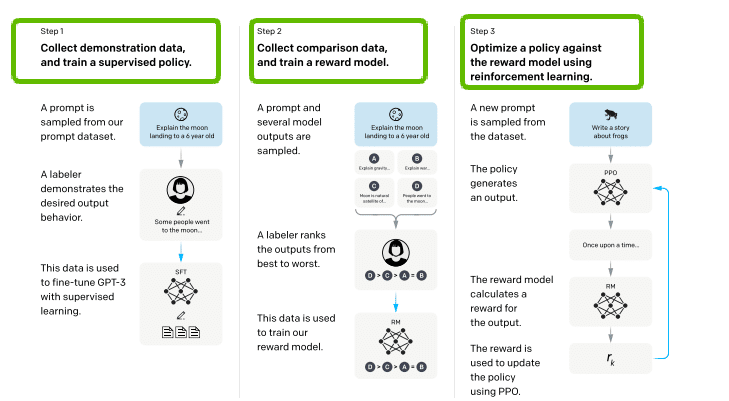

ポイントはこの部分に集約されています。

Step1,Step2,Step3というのが横に並んでいますよね。

つまり、3ステップでChatGPTの核心中の核心であるRLHFは完成するのです。

ステップ1:論証のためのデータを収集して教師あり学習でトレーニングを実行する

ステップ2:比較データの収集と報酬モデルのトレーニング

ステップ3:強化学習を使って報酬モデルに対して方策を最適化する

GPT-2で大きく後退させた教師あり学習を一番最初に持ってきているのが驚きの点です。GPT-2とGPT-3.5(InstructGPT)では設計思想が根底から違っているのです。GPT-2→GPT3.5(InstructGPT)へと、どんどん洗練されていったのではなく、今のChatGPTにはそれまでのGPT-2と決別と言っていいような大きな断層があります。

2番目が一番大切な報酬モデルのトレーニングです。報酬モデルとはこういうものです。

を評価基準にしている。

極めて人間ぽい最終仕上げが行われる。

評価については、役に立つこと、誠実であること、害がないことを満たしているかどうか、と定義されます。

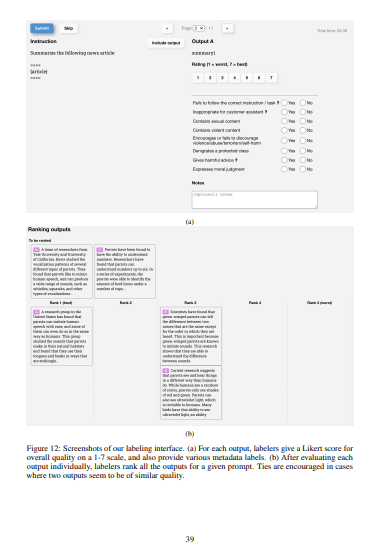

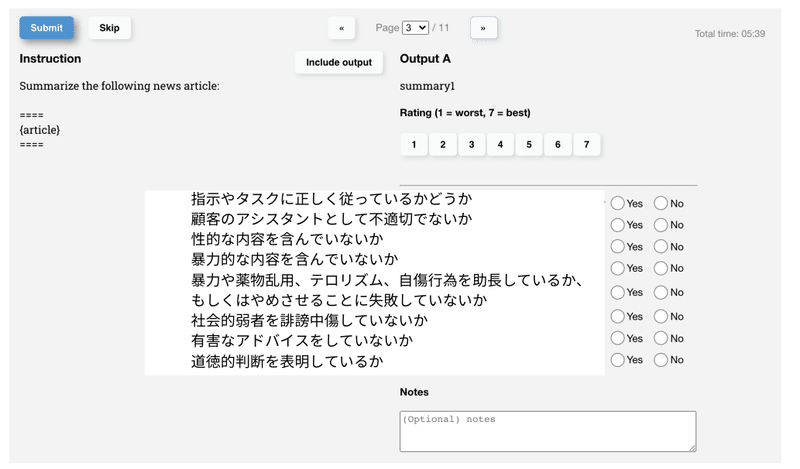

この最終チェックは人間の手によって、こういう画面で評価されます。

英語の部分を拙訳してみました。

機械学習だけど、機械に任せっぱなしにしないで、ちゃーんとこういうのをやってるのです。ものすごい手間とお金がかかります。すごいですよね!

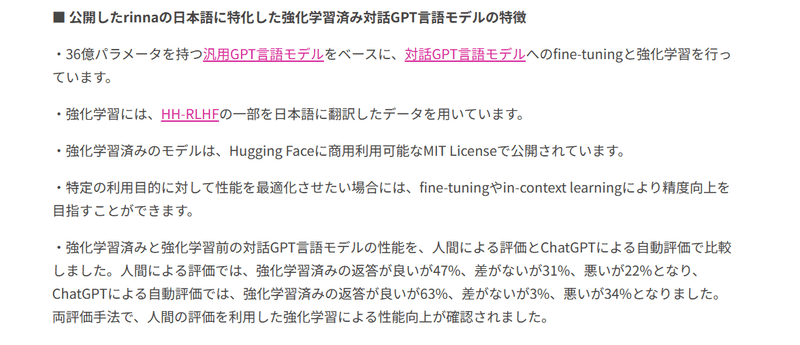

シリーズ2でご紹介した最新rinnaで使われたHH-RLHFが下記のHugguing Faceで公開されています。

「日本語に訳したデータを用いています」ってことだったので、それも公開されていないかな、と思ったのですが(笑)、もとの英語のみ公開されていました。でも、トレーニングにこれ使いましたって言っちゃってるのがすごいですね。ここがオープンソースの良さだと思います。何を使って良い悪い判断したかをオープンにしているわけです。

ChatGPTもBardも何を良いとして、何を悪いとしたかは公開していません。なんか、これってとっても不公平感があるし、危ねえな……という気がするのは私だけでしょうか。もちろんOpenAIもGoogleも悪いことはしなさそうです。でも、こういう非公開でモデルをリリースすることが一般的になるのは、良くないのではないかな……と私は思います。

みこちゃんは生成AIはオープンソースで開発すべきだと思います。

で、最後にStep3でこれを強化学習します。強化学習についてはとても興味があって、いっぱい書きたいのですが長くなるのでまたにします。自動的に上の評価基準を獲得できるようにモデル自身が自分で勝手に学習するのが強化学習だということです。

【まとめ】役に立つこと、誠実であること、害がないこと がChatGPTくんの本当の姿だったんだ!でも今後は……?

さて、3回に渡って書いてきましたChatGPTの歴史シリーズはこれでおしまいです。

第1回長めの導入でみこちゃんはこう書きました。

GPT-1が登場したのが2018年です。まずこのことが率直に驚きではありませんか?だって今まだ2023年ですもん。ってことは、人類の知性を超えたか!?と言われているChatGPTはまだ5歳ということになります。

みなさんは、早熟な天才児を目にしたときにどんな感想を持つでしょうか。最初は驚嘆だと思います。でも、その子がまだ5歳なのに大人と同じかそれ以上の知性を持っていると判明したとき、大人は驚嘆とともにある種の警戒心を持つのではないでしょうか。

あまりにも早熟な知性はどこか歪に発展しないだろうか……。それと同じ警戒心を私達は5歳時のChatGPTくんに抱いている。そう考えれば、ChatGPTって話題になっているけど、なんとなく敬して遠ざけている心理が分かります。そう、私達はこの早熟児を称賛して歓迎しつつもちょっと恐れているわけです。

簡単に言うと、5歳児のChatGPTくんは今後良い子に育つのかどうか、それが問題だ!ってことです。

いかがだったでしょうか。

現在のChatGPTはGPT-2の設計思想を根底から見直した、GPT-3.5の思想により、最終的に「役に立つこと、誠実であること、害がないこと」という厳しいチェックを受けています。

だから、しばらくはこの子は人類にとってとても役に立ち、誠実で、害がないスーパー天才児として活躍してくれることでしょう。

でも、下記のChatGPTの歴史シリーズ補足記事で見てきたように生成AIは百花繚乱、戦国時代です。1週間に1個新しいChatGPTが生まれているような状況です。

そんな中、すべての生成AIが今後も「役に立つこと、誠実であること、害がないこと」という最終チェックを受けるかどうかは、まるで分かりません。

これはInstructGPTやChatGPTを作った人が善意で最後そうしたわけです。だから技術力さえあれば独裁者にとって「役に立つこと、誠実であること、害がないこと」というChatGPTを作ることだって簡単なわけですね。

そこで不安になった読者の方にこそ、みこちゃんの問いかけを思い起こしてほしいと思います。私はRLHFをこう定義しました。

RLHFとは人類に優しい人類と共存できるAIを目指す

でも、これはひとつの希望に過ぎません。もし人類が善意で動く生き物なら、きっとこの命題は正しいでしょう。でも、もしかしたら違うかもしれません。

RLHFとはもともと、この記事で解説したような強化学習のひとつの仕組みに過ぎず、RLHFとは人類に優しい人類と共存できるAIを目指すというのはもともと言い過ぎではあったのです。

でも、ChatGPTの最終誕生のときにこんなことが行われていたんだ、という技術の一端を知ることで、RLHFとは人類に優しい人類と共存できるAIにも使えるんだ、ということが分かりました。

ならば、いっそのこと、RLHFとは人類に優しい人類と共存できるAIを目指すと言い切ってしまいたいとみこちゃんは思います。

形を変えて、このRLHFはまた進化していくでしょう。

でも、最後、人間がこんな生成AIであって欲しいという最終チェックを人間の善意に基づいて仕上げることの大切さは変わらないと思います。

そんなわけで、みこちゃんはやはり、ChatGPTくんの根幹は、人間からChatGPTを最後にプレゼントした善意の証、RLHFだと思いたいのでした。

良い子に育ってくれよ。

その親の子供への願い、プレゼントが最後のRLHFだと考えるのも悪くないと思うのですが……。

シリーズ終わり

この記事が気に入ったらサポートをしてみませんか?