Photo by

featurecompass

ローカルLLMを動かすOllamaをGoolge Colabで動かす方法

Ollamaの紹介

Ollamaとは、ローカルLLMをローカル環境で動かすためのコマンドツールです。今回、Google ColabでOllamaを動かす方法を見つけましたので、紹介していきます。

こちらの記事を参考にさせて頂きました。

OllamaをGoogle Colabで動かす方法

今回は、Google Colabで、ランタイムはTPUv2を選択します。ローカルLLMはllama3を使用します。

!curl https://ollama.ai/install.sh | sh

!echo 'debconf debconf/frontend select Noninteractive' | sudo debconf-set-selections

!sudo apt-get update && sudo apt-get install -y cuda-drivers

import os

# Set LD_LIBRARY_PATH so the system NVIDIA library

os.environ.update({'LD_LIBRARY_PATH': '/usr/lib64-nvidia'})次に、Ollamaサーバを起動します。

!nohup ollama serve &次に、ローカルLLMのLlama3をダウンロードします。

!ollama pull llama3次に、ollamaをインストールします。

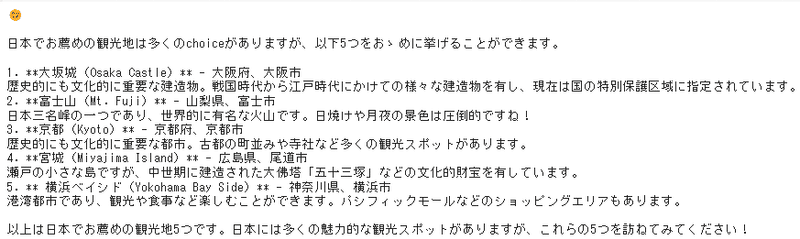

!pip install ollama次に、コードを実行します。今回は、日本語で回答して下さいと付け加えております。

import ollama

response = ollama.chat(model='llama3', messages=[

{

'role': 'user',

'content': '日本でお薦めの観光地を5つあげてください。日本語で回答してください。',

},

])

print(response['message']['content'])

この他にも、ローカルLLMを扱うことができるツールに関して記事を書いていますので、興味がありましたら参考にしてください。

LM Studioは、GUIでローカルLLMを操作したい人向けとなります。

こちらは、自宅のPCでOllamaを使いたい人向けとなります。

この記事が気に入ったらサポートをしてみませんか?