NIST - AI Risk Management Frameworkのまとめ

今月はAIガバナンス関連で学んだ内容をアウトプットしたいと思います。対象はタイトルの通り、NIST(National Institute of Standards and Technology (アメリカ国立標準技術研究所))が2023年1月に発表した「AI Risk Management Framework(”AI RMF”)」です。

AI RMFは、2023年10月末に出された大統領令に従い、2024年7月末までを目途に、生成AIを考慮した追加リソースが作成・公表される見込みになっています。その前提としても、またAIリスクマネジメント対応の基本を理解するという意味でも、有用なドキュメントかと思い、学習対象にしてみました。

以下はAI RMFの原文を読み、サマリにしたものです。(英語の原文を無理やり日本語に直している箇所もあり、読みづらい点もあるかもしれませんがご容赦ください。)

Executive Summary

AI技術は多大な可能性を持っている一方で、個人や環境へのネガティブな影響も及ぼすリスクも存在する。これらのリスクは様々な形態や規模で現れ、期間としては長期/短期、確率も高低があり、影響範囲も局所的であったり広範であったりと、様々である。

適切なコントロールがなければ、AIシステムは個人やコミュニティにとって不平等や望ましくない結果を増幅・維持・悪化させる可能性があるが、適切なマネジメントによって、これらの不平等な結果を緩和・管理することが可能。

Part 1: Foundational Information

1. Framing Risk

AIリスクは発生可能性と結果影響の大きさから複合的に測定すべきである。

AIのリスク管理では、人間が「AIシステムはあらゆる状況でうまく機能する」と思い込む可能性があることを考慮する必要がある

AIリスクのコントロールのために、他のリスクと異なる対応が必要となる理由は、バリューチェーンが長くステークホルダーが多いこと、AIシステムの与える影響がエンドユーザーに留まらずその先のコミュニティ・社会と広がっていく可能性があること、AIシステムそのもののメカニズムの複雑さから想定できる範囲も限定的であること、などが挙げられる。

AIリスクの許容度は政策や社会的規範の影響を受ける。さらに時間が経つにつれ、変化していく可能性が高い。

AIリスクの完全的な除去は不可能である。AIリスクマネジメントへの非現実的な期待はリソースの無駄使い等につながるおそれがある。そのため目的に応じたリソース配分が必要。

AIリスク対応は他から独立したものではなく、既存の会社としてのリスクマネジメント戦略に組み込まれるべきものである。(新たにゼロからリスクマネジメントの枠組みを立ち上げる必要性は乏しい)

2. Audience

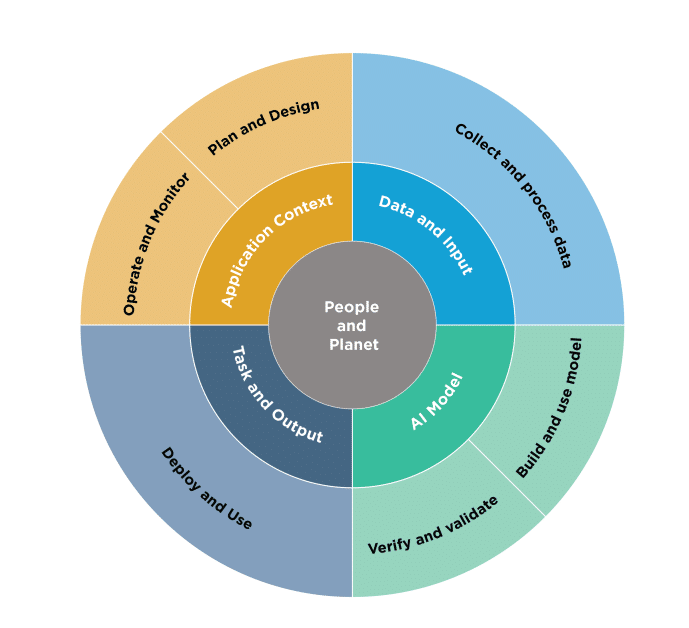

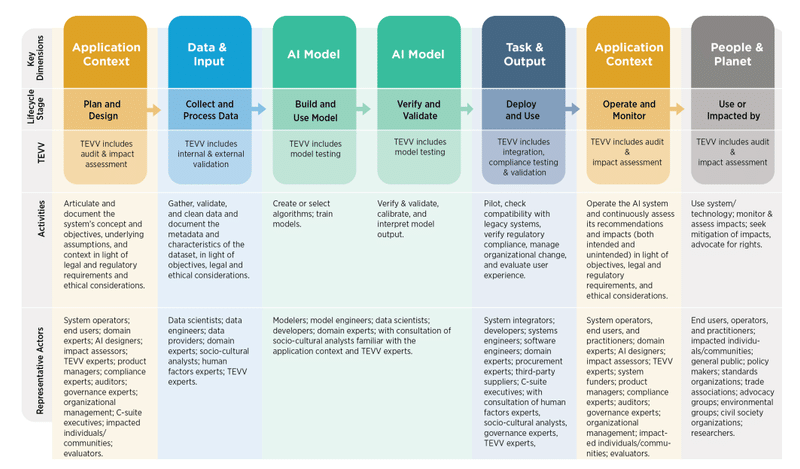

OECDがAIライフサイクルの分類のために、5つの要素・側面に沿ってフレームワークを作っており、NISTでアレンジを加えたものが以下の図。

各ステップにおけるTEVV(test, evaluation, verification, and validation=テスト、評価、検証、妥当性確認)の実施がリスクマネジメント上は重要なポイントになる

このバリューチェーンの長さ、関係するステークホルダーの多さがAIリスクマネジメントを複雑にする要因。この全体像を理解したうえで、自身のポジション・関わるステップ・果たすべき役割を理解することが、AIリスクマネジメントの基本となる。

3. AI Risks and Trustworthiness

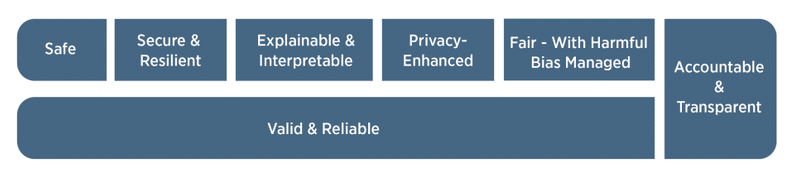

AIの信頼性(Trustworthiness)を高めることがネガティブなAIリスク低減につながる。そのために必要な要素が7つある。

7つの要素を個別に判断するのではなく総合的に考慮する必要がある。これは要素間でトレードオフが生じたり、状況によって要素ごとの重要性も変動したりするため。

Valid and Reliable(有効性 / 信頼性)

正確性(Accuracy)と堅牢性(Robustness)が有効性に寄与する要素。

検証方法として、意図されたとおりに挙動するかという観点だけでなく、想定されていない形での利用がなされてもリスクの程度が抑えられているかという観点の検証も必要である。その意味で機械的なテストだけではなく、人間が介入して検証を行う必要がある。

Safe(安全性)

安全性リスクへの対処は、できる限り早期から検討されることが望ましい(Safety by Design)

具体的な対応策は、厳しいシミュレーション、In-domainのテスト、リアルタイムモニタリング、必要に応じてシステム停止・改善できる状態の維持、人間の介入が考えられる対応策

Secure and Resilient(セキュリティと回復力)

セキュリティにおける脅威は、敵対的サンプル(*AIに間違った予測をさせるためのサンプル)、データ汚染、モデル・トレーニングデータ・IP等の窃取。

SecurityとResilienceは関連はするが区別はされるもの。Resilienceは予期せぬイベント等があっても元の機能を回復できることを指し、セキュリティの一部に含まれるもの。

Accountable and Transparent(説明責任と透明性)

Transparency(透明性)とは、AIシステムやそのアウトプットに関する情報が提供されていることを指す。AIライフサイクルのステージや関係者の知識レベルに応じて、適切なレベルの情報開示が必要。

トレーニングデータ等の出どころを把握し続けることが透明性確保に必要。

Explainable and Interpretable(説明可能かつ解釈可能)

Explainability(説明可能性)

AIシステムのメカニズムを表示・表現できること

これがあることでユーザーの納得感につながり、また適切なリスク把握にも役立つ。

Interpretable(解釈可能性)

想定された利用環境下における、AIシステムのアウトプットが持つ意味を理解できること

Transparencyとの関係

Transparency: What happened in the system

Explainability: How a decision was made in the system

Interpretable: Why a decision was made in the system and its meaning or context to the user

Privacy-Enhanced(プライバシー保護)

プライバシーは、セキュリティ・バイアス・透明性と相互関係にあり、他の要素とトレードオフになり得る。例えば、データに含まれる個人に関連する情報を匿名化するなどプライバシーを高めることで、正確性や公平な意思決定等の他の要素に影響を与えることがある。

Fair - with Harmful Bias Managed(公平性 - 有害なバイアスの管理)

公平性の基準は、文化間で異なり、変化していくものでもあることから、複雑かつ定義困難なもの。

考慮・管理されるべき主なバイアスとして3つを挙げる(これらは差別の意図がなくても起こり得る)

Systemic: AIデータセット、組織のAIシステムライフサイクルにおける規範・実務・プロセス、社会に存在するもの

Computational, Statistical: AIデータセット、アルゴリズムのプロセスに存在するもの。多くの場合、サンプルデータが不適切であることに起因するもの。

Human-cognitive: AIシステムの利用者がAIシステムの情報をどのように認識して意思決定を行うか、不足している情報を補うか、目的や機能についてどのように捉えるかに関係する。

4. Effectiveness of the AI RMF

NISTはAI RMFの有効性評価を継続的・定期的に実施する

AI RMFを利用する者も、AI RMFによってAIリスクマネジメントが向上しているかは定期的に評価することが奨励される。

Part 2: Core and Profiles

5. AI RMF Core

AIリスクマネジメントはAIライフサイクルを通じて実施されるべきもの。社外を含む、複数かつ多様な視点による検討を反映させるべき。

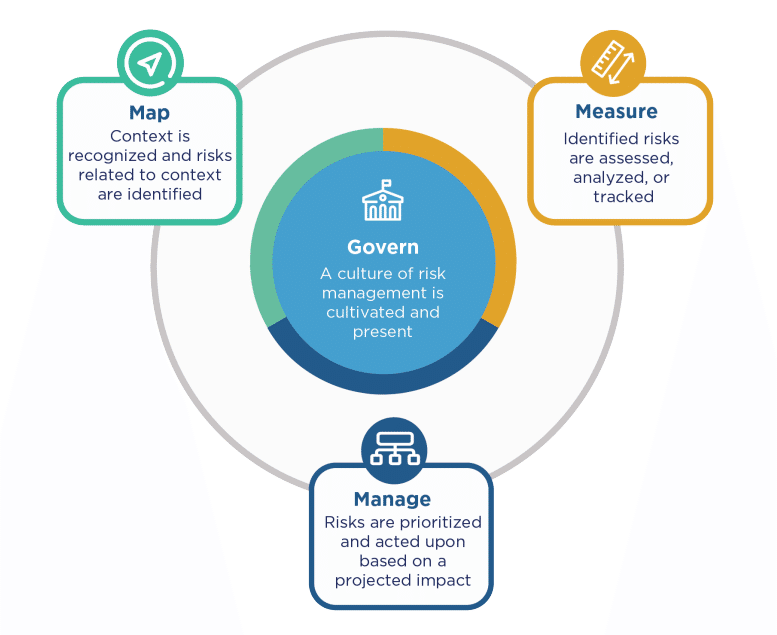

そのAIリスクマネジメントの核となる要素は4つ。

Govern

Governの機能

リスクマネジメント文化を醸成し、具体的アクションにつなげる。

プロセス・文書化・組織におけるリスク予期・検知・管理の大枠を決める。

経営戦略に沿ったリスクマネジメントのための枠組みを作る。

AIライフサイクルの全工程におけるリスクに対する対応を行う。

Governの効果

Governの主管部門は、企業理念・ミッションに即したリスクマネジメント方針を決定することができ、経営層のリーダーシップの下で、リスクカルチャーの醸成をより促進することができる。

Documentation(文書化・明文化)によって透明性を高め、Accountability(説明責任)を強化することができる。

組織内における仕組みを整えた後は、リスク把握・管理に注力し、Purpose-drivenカルチャーから利益を得ることができる。

Map

Mapの機能

Contextを理解するための能力を向上させる(思い込みの除去含む)

AIシステムの有効な機能のさせ方、また機能していない場合はその事実を認識する

その利用方法として意図されていたか否かを問わず、AIシステムの有するリスクを認識する

Mapの効果

上流の(=より開発に近い段階の)Actorが下流(=よりエンドユーザーやその先の影響を受けうる社会に属する人たち)と対話をすることが、上流におけるリスク把握・対処すなわちシステム全体のリスク低減に寄与する。

Mapを通じて収集される情報が、MeasureやManageの基礎(それらのステップにおける判断材料)となる。

社内外の多様な視点(社外は専門家に留まらずエンドユーザーや影響を受けるコミュニティの人たちを含む)を取り込むことで、能動的なリスク対策を可能にする。

Measure

Measureの機能

Mapで得られた情報を活用し、定量・定性の両面から、AIリスクを分析・評価・監視する

AIシステムの機能及び信頼性について、またソフトウェアのテスト、指標と比較した性能評価、その結果の文書化を含む

Measureの手法は、科学的、法的、倫理的であり、透明性に従ったものである必要がある

Measureの効果

内部的なバイアスや潜在的な利益相反に関するリスクを低減できる。

Measureによって対策のための情報整理を行うことができる(TEVVが実行され、その結果が文書化されている)

Manage

Manageの機能

Map・Measureされたリスクに対して、Governで定義されたとおりに、リスク資源を配分すること

Mapで収集した情報は、Manageにおいてリスクの発生可能性を低減するために活用される

MapとMeasureを通じて文書化された情報が、透明性と説明責任を強化することにつながる

Manageの効果

リスクの優先順位付け、定期的なモニタリング及び改善活動に関する計画が定められる

評価・優先順位付けの結果に基づいて、リスク管理に必要なリソースの配分・投下を実施できるようになる

6. AI RMF Profiles

Profile(ユースケース、特定の分野・業界等におけるAI RMFの当てはめ結果を示すもの)の集積及び分析により、アクションプラン策定につなげられる。

特にユースケースごとのProfileは、当該案件への理解を深め、リスク対策の手段についての洞察を提供することができるため有用。

最後に

ここまでNISTのAI RMFを読んで内容をまとめましたが、AI RMF Core(Govern, Map, Measure, Manage)については、より詳細な「AI RMF Playbook」というドキュメントが用意されています。

https://airc.nist.gov/AI_RMF_Knowledge_Base/Playbook

より詳細かつ具体的な対応検討においては、こちらのPlaybookも参考にできるものと思いますので、適宜参照しながら企業内での対応に取り込んでいくことが良いかと思います。

以上です!AIガバナンス関連で何かおすすめありましたら是非教えてください!(今のところはIAPPのAI Governance Professionalが気になっています…)

この記事が気に入ったらサポートをしてみませんか?