ローカルLLMをVSCodeでCursorのように使えるcontinue.devの設定方法

今回はローカルLLMをVSCode上に組み込んでCursorのような事が可能になる拡張機能continue.devを紹介。

使い方

インストール

拡張機能continue.devをインストールします。

インストールが完了すると左にアイコンが表示されます。

アイコンをクリックするとチャット画面が出ます。無料回数分(いくつか不明)を使い切るまではGPT-4が使えます。ラッキー。

プラスボタンを押せば色々なオプションが選べます。APIキーを入れてGPT-4やGeminiを使うことも可能。

ローカルLLMでの使い方

拡張機能アイコンをクリックして出てきた画面の右下の歯車マークをクリックしてconfigファイルを開きます。

models内に下記のコードを追加します。好きな場所で良いのですが、" , "などの記入に注意してください。追加するとモデルを選ぶプルダウンに自分のモデル名が表示されます。上記の画像でいう『Local』というやつです。

{

"title": "Local", # 好きな名前に変える

"provider": "openai", # 変えない

"model": "gpt-4", # 変えない

"apiKey": "EMPTY", # 変えない

"apiBase": "http://localhost:8000" # 自分のローカルホストのURLに変更

},ローカルLLMの起動

ローカルLLMで使うには当然ながらOpenAI APIと相互性のあるローカルサーバーを立ち上げている必要があります。おすすめはllama-cpp-pythonです。

おすすめLLMモデル

軽いのに精度が良いおすすめモデルがSOLAR-10.7B-Instruct-v1.0-GGUFです。日本語で使いたい人は他の日本語モデルを選べばいいと思いますが、VSCodeで使うのでコーディングの精度が重要です。

phi-2-GGUFはコーディング性能が高いので良いかもしれませんが、私が試したときにはうまく動作しませんでした。

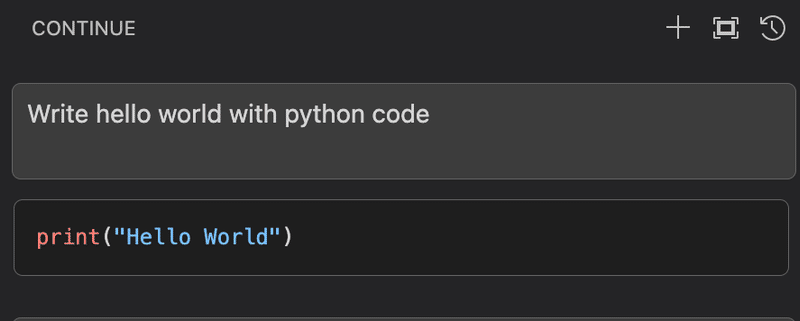

実際に使ってみる

とりあえずハローワールドを。

ダブルクォートを削除し、わざと間違えてみます。エラー警告を右クリックすると「質問」ボタンが表示されます。

クリックするとエラーに対する質問文が自動で作成されます。そして修正したコードを提示してくれます。

まとめ

とまあ、精度は使うLLMモデル次第ではありますが、コード特化ということならば軽いモデルも多いので遊び程度で使うと面白いと思います。

この記事が気に入ったらサポートをしてみませんか?