世界のしくみを「見て」理解しバーチャルに再現するAI「Google Genie」

実験場管理人のpsymenです

AI最新情報を読み解きます!

Our new AI model Genie can create playable worlds in the style of 2D platformers - all from a single image prompt, sketch or text description. ✏️

— Google DeepMind (@GoogleDeepMind) April 2, 2024

As a foundation world model, Genie could also help us train AI agents.

Here's how. ↓ https://t.co/UX6oEkhkgi

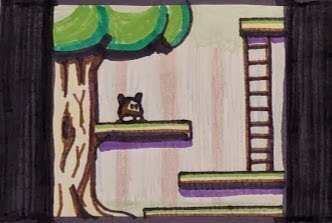

Google DeepMind研究所の新AIモデルGenieは大量のゲームプレイ画面から「空間」「時間」「物理」を自動で読み取り学習して、マリオ的な横スクロールアクション映像を生成する事ができます

下記はYouTubeの実況画面からラベルなしでGenieが自己学習したモデルによる「横スクロール的な動画」の出力です

Genieは「モデル」なので、新たに与えられた静止画像一枚に対して、学んだ世界モデルを適用して、アクションゲームの動画を生成する事ができます

☟

☟

リアルタイムに生成すれば、まだ1f/secのカクカク動作ではありつつも、プロンプトによるキャラ操作も可能です

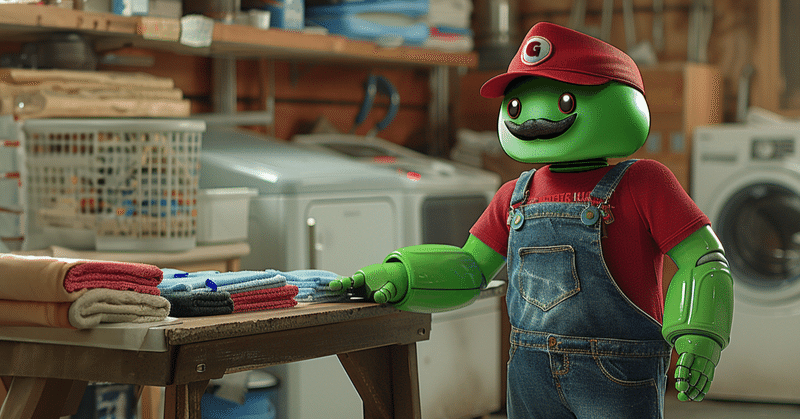

洗濯物をたためる家事ロボへの布石?

ここで話がかなり飛躍しますが、

「見る」だけで空間、時間、物理のルールを学習して再現できるということは、ロボティクスのブレイクスルーにもつながる非常に発展性が高い技術だということです

(勝手に拡大解釈しているのではなく、参照元のGenieの解説ページにそうありました)

「洗濯物をたたむ」など、人の手によって一般化して記述しにくい現実世界の複雑なタスクをモデル化して、そのモデルが生成したバーチャルワールドでロボットアームの学習を行う、といった利用方法が考えられているようです

世界モデルは面白い

ゲームの再現からいきなり洗濯物をたたむ世界へつながってしまう裾野の広さが「世界モデル」の面白いところですね

今年は Soraしかり「世界モデル」が広げる可能性がすごいことになりそうでわくわくします!

↓ こちらのリンク先はMITによる技術レビューです

この記事が気に入ったらサポートをしてみませんか?