<検証>アリババが発表した高性能リップシンク「EMO」はどのぐらいエモいのか?【モナリザの微笑】

🌏Hello World…!!

実験場管理人のpsymenです

最新情報をクリエイターの視点から発信しています

2/27にアリババの研究所から発表された「EMO」は、人物のポートレート画像から表現豊かなリップシンク動画を生成する技術です

「リップシンク」ってなんぞ?という方はこちらの記事を御覧ください

<検証>

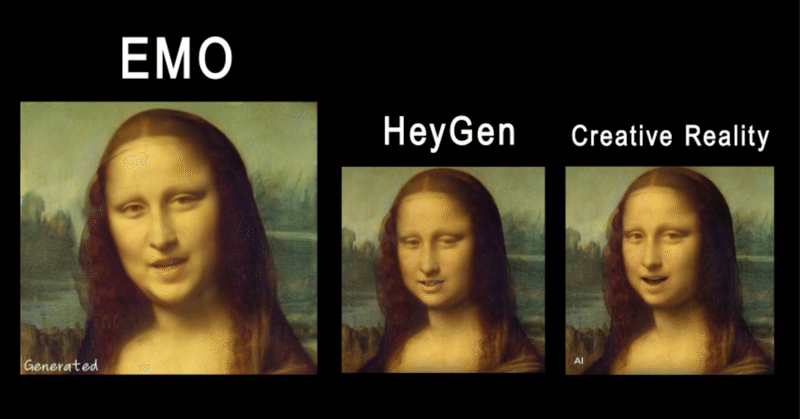

「表情豊か」だと噂の「EMO」がどれぐらい名前通りにエモいのか、既存のアバター生成サービス、HeyGen、CreativeRealityと比較しました

(▶ボタンで動画を再生してください)

※ 著作権に配慮して使用されていた音源は削除してあります

音声つきVer.を聞きたい方はこちら、EMOのgitページから確認できます

既存サービスと比較すると

目がちゃんと演技してる

表情筋が発声の抑揚に一致

口周りの顔ハメ感がない

身体もある程度動いている

といった進歩が見られます

psymenとしては特に、口の形が元の画像をしっかりと参照しているのがポイントが高いと思いました

既存サービスだと、他人の口を無理やりハメているように見える事がありますが、EMOの生成結果は比較的自然に見えます

▲ こちらはdreamshaper XLで生成されたリアル・モナリザさんがEMOで歌唱する様子

上の比較に使った原画モナリザより更にダイナミックに動けています

技術面

gitのレポートを参照すると、

「リファレンス アテンション」「オーディオ アテンション」による人格の維持と 「時間モジュール」による表情のタイミングのコントロールがキーになっているようです

↑ こちらのリンク先、gitのページから生成例を観察すると、発声する前の呼吸の「タメ」など細かい動きがあるのが確認できます

比較の結論

現状のアバターサービスの口元まわりの「顔ハメ」感がかなり低減されているので期待大ですね

技術反映されるのが待ち遠しいです!

X(Twitter)で

AIニュースをポストしています

フォロー頂けると嬉しいです!

note @note_PRで、AIの考察/検証/コンテンツ実験の眺めの記事を書いていますhttps://t.co/3ijSKrZdsE#note pic.twitter.com/mexlhvbudS

— psymen @AI CREATOR (@PsymenJ) March 14, 2024

この記事が気に入ったらサポートをしてみませんか?