NVIDIAの生成AI研究 #SIGGRAPH2023

東工大時代に指導させていただいて渡米→現在NVIDIAにいる研究者Koki Naganoが、3D lifting ですごいの作った…SIGGRAPHで見に行きたい

AI-driven 3D lifting has huge potential! Choose your favorite AI tool to generate/customize an avatar and bring it to life in 3D – something not possible with 3D scanning-based systems.

— Koki Nagano (@luminohope) May 4, 2023

If you come to @SIGGRAPH, try a live demo as part of Emerging Technologies #SIGGRAPH2023 https://t.co/y2NnMtkMif pic.twitter.com/0ajdP7etBj

AKに紹介されてる…これはプロの驚き屋さんが驚くやつだ…。

そもそも次のSIGGRAPH2023、NVIDIAだけで19件も論文採択されている…!

せっかくなので公式ブログの翻訳をおおくりします。

Take a sneak peek at what @NVIDIAAIDev has planned to share at #SIGGRAPH2023 👀 and stay tunned for more exciting conference program updates coming soon! #AI https://t.co/3qeDGKk6Ch

— ACM SIGGRAPH (@siggraph) May 8, 2023

最新のNVIDIAグラフィックス研究が、ジェネレーティブAIの次のフロンティアを前進させる

NVIDIAは、1年で最も重要なコンピュータグラフィックス会議であるSIGGRAPHにおいて、約20の研究論文を発表します。

Latest NVIDIA Graphics Research Advances Generative AI’s Next Frontier

NVIDIA will present around 20 research papers at SIGGRAPH, the year’s most important computer graphics conference.

2023年5月2日 by AARON LEFOHN

NVIDIAは、開発者やアーティストが、静止画や動画、2Dや3D、超リアルやファンタジックなど、自分のアイデアに命を吹き込むことを可能にする最先端のAI研究の波を紹介しました。

米国、ヨーロッパ、イスラエルの12以上の大学との共同研究を含む、ジェネレーティブAIとニューラル・グラフィックスを推進する約20のNVIDIA Research論文は、8月6日から10日までロサンゼルスで開催される主要なコンピュータ・グラフィックス会議であるSIGGRAPH 2023に向けられたものです。

論文には、テキストをパーソナライズされた画像に変える生成AIモデル、静止画像を3Dオブジェクトに変換するインバースレンダリングツール、AIを使って複雑な3D要素を驚くほどリアルにシミュレーションするニューラル物理モデル、AIを駆使したリアルタイムの視覚詳細を生成する新しい機能を開放するニューラルレンダリングモデルが含まれます。

NVIDIAの研究者によるイノベーションは、定期的にGitHubで開発者と共有され、メタバースアプリケーションを構築・運用するためのNVIDIA Omniverseプラットフォームや、最近発表されたビジュアルデザイン用のカスタム生成AIモデル用のファウンドリであるNVIDIA Picassoなどの製品に取り入れられています。NVIDIAの長年のグラフィックス研究は、最近リリースされた 世界初のパストレーシングされたAAAタイトルである Cyberpunk 2077 Ray Tracing「Overdrive Mode」のような、映画スタイルのレンダリングをゲームにもたらすのに役立ちました。

今年のSIGGRAPHで発表された研究の進歩は、開発者や企業がロボット工学や自律走行車のトレーニングのためのバーチャル世界を構成する合成データを迅速に生成することを支援します。また、アート、建築、グラフィックデザイン、ゲーム開発、映画などのクリエイターが、ストーリーボード、プリビジュアライゼーション、さらにはプロダクションのために、より迅速に高品質のビジュアルを作成することも可能になります。

パーソナルなタッチのAI: カスタマイズされたテキストから画像へのモデル

テキストを画像に変換するジェネレーティブAIモデルは、映画、ビデオゲーム、3Dバーチャルワールドのコンセプトアートやストーリーボードを作成するための強力なツールです。テキストから画像に変換するAIツールは、「子供のおもちゃ」というプロンプトを、ぬいぐるみ、ブロック、パズルなど、クリエイターがインスピレーションを得るために使えるほぼ無限のビジュアルに変換することができます。

しかし、アーティストには、ある特定のテーマがある場合もあります。例えば、玩具ブランドのクリエイティブディレクターは、新しいテディベアの広告キャンペーンを企画し、テディベアのティーパーティーなど、さまざまなシチュエーションでテディベアをビジュアル化したいと考えるかもしれない。生成AIモデルの出力にこのレベルの具体性を持たせるために、テルアビブ大学とNVIDIAの研究者は、モデルが迅速に学習する画像例をユーザーが提供できるようにする2つのSIGGRAPH論文を発表しました。

1つの論文では、出力をカスタマイズするために1つの画像例を必要とする技術について説明しており、NVIDIA A100 Tensor Core GPU1つでパーソナライズ処理を数分からおよそ11秒に加速し、これまでのパーソナライズ手法の60倍以上高速化しています。

2つ目の論文では、Perfusionという非常にコンパクトなモデルを紹介しています。このモデルは、一握りのコンセプト画像を用いて、ユーザーが複数のパーソナライズ要素(特定のテディベアやティーポットなど)を組み合わせて、AIが生成した1つのビジュアルにすることができます:

3Dで奉仕する:インバースレンダリングとキャラクター制作の進歩

クリエイターが仮想世界のコンセプトアートを思いついたら、次はその環境をレンダリングして3Dオブジェクトやキャラクターを配置する必要があります。NVIDIA Researchは、この時間のかかるプロセスを加速するために、2Dの画像や動画を自動的に3D表現に変換し、クリエイターがグラフィックアプリケーションに取り込んで編集できるAI技術を発明しています。

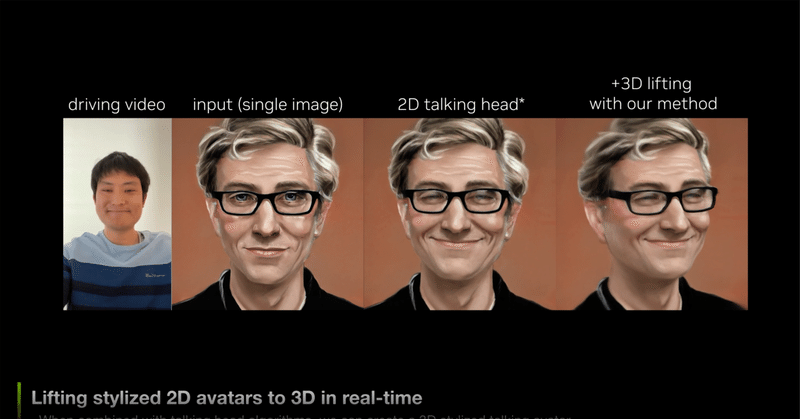

カリフォルニア大学サンディエゴ校の研究者と共同で作成した3番目の論文では、1枚の2Dポートレートから写実的な3Dヘッドアンドショルダーモデルを生成してレンダリングする技術について論じています - 3Dアバター作成と3Dビデオ会議をAIで可能にする大きなブレークスルーです。この方法は、コンシューマー向けのデスクトップ上でリアルタイムに動作し、従来のウェブカメラやスマートフォンのカメラのみを使用して、写実的または様式化された3Dテレプレゼンスを生成することができます。

スタンフォード大学との共同プロジェクトである4つ目のプロジェクトは、3Dキャラクターに実物そっくりの動きをもたらすものです。研究者たちは、実際のテニス試合の2Dビデオ記録からさまざまなテニススキルを学習し、このモーションを3Dキャラクターに適用できるAIシステムを作成しました。シミュレーションされたテニスプレーヤーは、仮想コート上の目標位置に正確にボールを打つことができ、他のキャラクターと長時間のラリーをすることもできます。

この論文は、テニスというテストケースにとどまらず、高価なモーションキャプチャデータを使用せずに、リアルな動きで多様なスキルをこなす3Dキャラクターを制作するという難しい課題に取り組んでいます。

ビデオ https://blogs.nvidia.com/wp-content/uploads/2023/05/Tennis.mp4?_=1

一本の毛も生えない(Not a Hair Out of Place): リアルなシミュレーションを可能にする神経物理学

3Dキャラクターが生成されると、アーティストは髪の毛などのリアルなディテールを重ね合わせることができます。

人間の頭髪は平均10万本あり、それぞれが個人の動きや周囲の環境に応じてダイナミックに反応します。従来、クリエイターは物理計算式を使って髪の毛の動きを計算し、利用可能なリソースに基づいてその動きを単純化したり、近似的に表現したりしてきました。そのため、大作映画のバーチャルキャラクターは、リアルタイムのビデオゲームのアバターよりもはるかに詳細な頭髪を持つことになります。

5つ目の論文では、現実世界で物体がどのように動くかを予測するためにニューラルネットワークに教えるAI技術であるニューラル・フィジックスを用いて、数万本の髪の毛を高解像度でリアルタイムにシミュレーションする方法を紹介しています。

実物大の毛髪を正確にシミュレーションするための研究チームの新しいアプローチは、特に最新のGPUに最適化されています。CPUベースの最新ソルバーと比較して大幅に性能が向上し、シミュレーション時間を数日から数時間に短縮するとともに、リアルタイムで可能な毛髪シミュレーションの品質を向上させました。この技術により、物理ベースのヘアグルーミングの正確性とインタラクティブ性を両立することが可能になりました。

リアルタイムグラフィックスに映画並みのディテールをもたらすニューラルレンダリング

環境にアニメーション化された3Dオブジェクトやキャラクターを配置した後、リアルタイムレンダリングは、仮想シーンで光が反射する物理現象をシミュレートします。最近のNVIDIAの研究では、テクスチャ、マテリアル、ボリュームに関するAIモデルが、ビデオゲームやデジタルツイン向けに、映画品質のフォトリアリスティックなビジュアルをリアルタイムで実現する方法を示しています。

NVIDIAは20年以上前にプログラマブルシェーディングを発明し、開発者がグラフィックパイプラインをカスタマイズできるようにしました。これらの最新のニューラル・レンダリングの発明では、研究者は、NVIDIAのリアルタイム・グラフィックス・パイプラインの奥深くで動作するAIモデルでプログラマブル・シェーディング・コードを拡張しました。

SIGGRAPHの6番目の論文で、NVIDIAは、GPUメモリを追加することなく最大16倍のテクスチャ詳細を提供するニューラルテクスチャ圧縮を発表します。ニューラル・テクスチャ圧縮は、3Dシーンの臨場感を大幅に向上させることができます。下の画像は、ニューラル圧縮されたテクスチャ(右)が、テキストがぼやけたままの従来のフォーマット(中央)よりも鮮明なディテールを捉えていることを示すものであります。

昨年発表された関連論文では、煙、火、雲、水などのボリュームデータを表現するために必要なメモリを100倍減少させるAI対応のデータ圧縮技術であるNeuralVDBとして早期アクセスできるようになりました。

NVIDIAはまた、直近のNVIDIA GTC基調講演で示されたニューラルマテリアル研究の詳細も本日発表しました。この論文では、フォトリアルの多層マテリアルから光がどのように反射するかを学習し、これらのアセットの複雑さをリアルタイムで実行される小さなニューラルネットワークにまで減らし、最大10倍高速のシェーディングを可能にするAIシステムについて説明しています。

その他の生成AIとグラフィックスの研究

これらはハイライトに過ぎません。SIGGRAPHにおけるすべてのNVIDIAの論文について、詳細をお読みください。また、NVIDIAは、パストレーシング、テレプレゼンス、生成AIの拡散モデルなどのトピックで、6つのコース、4つの講演、2つのEmerging Technologiesセッションでのデモをカンファレンスで発表する予定です。

NVIDIA Researchは、世界中に数百人の科学者とエンジニアを擁し、AI、コンピュータグラフィックス、コンピュータビジョン、自動運転車、ロボティクスなどのトピックに焦点を当てたチームを擁しています。

Koki Naganoは2件採択

SSIF: 一貫したテクスチャパラメータを持つシングルショット暗黙のモーフィング可能フェイス

SSIF: Single-shot Implicit Morphable Faces With Consistent Texture Parameterization

Connor Zhizhen Lin, Koki Nagano, Jan Kautz, Eric R. Chan, Umar Iqbal, Leonidas Guibas, Gordon Wetzstein, Sameh Khamis SIGGRAPH 2023

'SSIF: Single-shot Implicit Morphable Faces with Consistent Texture Parameterization'. Fantastic single-image to fully animatable and UV-mapped 3D face output. Even better the textures and meshes can be extracted to traditional 3D workflows.https://t.co/z8lQqfygEy pic.twitter.com/DNT9Esm6Xj

— Ben Ferns (@ben_ferns) May 8, 2023

ライブ3Dポートレート

単一画像のポートレートビュー合成のためのリアルタイム輝度フィールド

Live 3D Portrait: Real-Time Radiance Fields for Single-Image Portrait View Synthesis

Alexander Trevithick, Matthew Chan, Michael Stengel, Eric R. Chan, Chao Liu, Zhiding Yu, Sameh Khamis, Manmohan Chandraker, Ravi Ramamoorthi, Koki Nagano

ACM Transactions On Graphics (SIGGRAPH 2023)

Abstract:1枚のポーズなし画像(例:顔写真)からフォトリアリスティックな3D表現を推論し、リアルタイムでレンダリングするワンショット手法を提示する。RGBの入力があれば、我々の画像エンコーダは、ボリュームレンダリングによる3Dを意識した新しいビュー合成のための神経輝度フィールドの正準三面表現を直接予測する。本手法は、民生用ハードウェアで高速に動作し(24fps)、テスト時間の最適化を必要とする強力なGAN変換ベースラインよりも高品質な結果を得ることができます。トライプレーンエンコーダパイプラインを訓練するために、合成データのみを使用し、事前に訓練された3D GANからフィードフォワードエンコーダに知識を抽出する方法を示しています。技術的な貢献としては、Vision Transformerベースのトライプレーンエンコーダ、カメラデータの増強戦略、合成データトレーニングのためのうまく設計された損失関数があります。最先端の手法とのベンチマークを行い、現実世界の厳しい環境において、ロバスト性と画質が大幅に向上したことを実証しました。私たちは、顔のポートレート(FFHQ)と猫のポートレート(AFHQ)での結果を紹介しますが、私たちのアルゴリズムは、将来的に3Dを意識した画像生成器を用いて他のカテゴリーにも適用することができます。

詳細: https://research.nvidia.com/labs/nxp/lp3d/

Web抄録より参考翻訳

本手法は、ポーズをとっていないRGB画像を条件として、ボリュームレンダリングのための正統的な3平面表現を直接予測する。また、Vision-Transformer(ViT)レイヤーを組み込むことで、2Dピクセルと3D表現の間の高変数かつ複雑な対応を学習できるようにすることを提案する。我々は、モデルの訓練に厳密な合成データを使用するが、実世界での汎化には、合成データをより実世界に近づけるために、幾何学的なカメラパラメータを(EG3Dのように一定に保つのではなく)分布からサンプリングする必要があることを発見した。このような設計上の決断の重要性をビデオで紹介します。

ViTベースエンコーダ

ViT層がない場合、本手法は被写体の詳細を捉えることはできないが、首尾一貫した3D表現を予測する能力は保持している。* は同じ学習時間を示す。

幾何学的なカメラパラメーターのサンプリング

焦点距離、主点、カメラロールのサンプリングがないため、本手法は実画像に一般化できず、誤った形状や非現実的な画像を予測することになります。* は同じ学習時間であることを示す。

1枚の肖像画から3D再構成を行う際に、ノベルビュー画像と予測されるジオメトリを比較し、最先端の手法と比較しました。本手法は、より忠実な画像と、より詳細なジオメトリを生成することができます。

単一画像の結果:ジオメトリ可視化

インタラクティブなジオメトリビューアを提供します。左の列は入力画像で、右はピクセルアライメントされたレンダリングと斬新なビューからのジオメトリです。セパレータをドラッグすると、ピクセルアライメントされたジオメトリを見ることができます。

FFHQとAFHQの追加映像結果

また、FFHQとAFHQにおける単一画像反転の追加結果も紹介する。

スタイライズされた画像を3Dに持ち上げる(Lifting Stylized Images to 3D)

本手法を用いてStyleGAN2が生成したスタイライズ画像のリフティングを展示します。本手法は様式化された画像で学習したことはありませんが、人間の顔の絵画や描画を驚くほどうまく扱うことができます。

動画におけるフレームごとの結果

被験者が話しているRGB映像に対して本手法をフレーム単位で適用したところ、フレーム単位で独立した手法を適用しているにもかかわらず、高い時間的整合性が得られた。

引用

@inproceedings{trevithick2023,

author = {Alex Trevithick and Matthew Chan and Michael Stengel and Eric R. Chan and Chao Liu and Zhiding Yu and Sameh Khamis and Manmohan Chandraker and Ravi Ramamoorthi and Koki Nagano},

title = {Real-Time Radiance Fields for Single-Image Portrait View Synthesis},

booktitle = {ACM Transactions on Graphics (SIGGRAPH)},

year = {2023}

}この記事が気に入ったらサポートをしてみませんか?