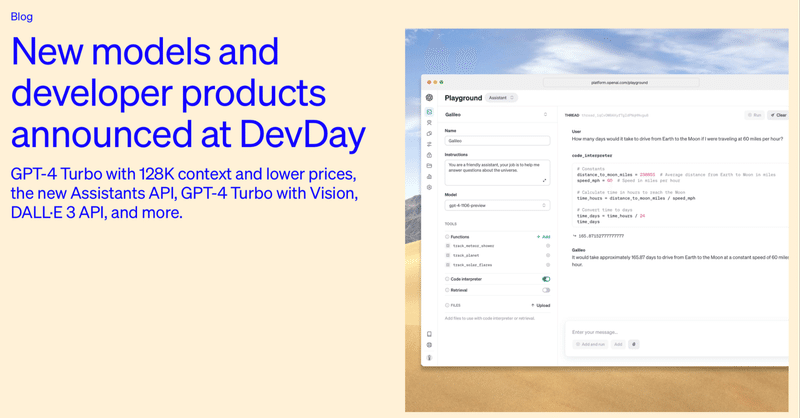

OpenAI DevDay で発表された新モデルと新開発ツール まとめ

以下の記事が面白かったので、かるくまとめました。

1. GPT-4 Turbo

「GPT-4 Turbo」は、「GPT-4」より高性能です。2023年4月までの知識と128kのコンテキストウィンドウを持ちます。さらに、「GPT-4」と比較して入力は1/3、出力は1/2の安い価格で提供します。

開発者はモデルID「gpt-4-1106-preview」で試すことができます。今後数週間以内に、安定した実稼働モデルをリリースする予定です。

1-1. Function Calling の更新

「Function Calling」に、単一メッセージから複数のFunction (「車の窓を開けてエアコンをオフにする」など) を呼び出す機能などが追加されました。精度も向上しています。

1-2. 構造化データ出力 の改善

「GPT-4 Turbo」は、特定形式の生成 (「常に XML で応答する」など) の指示追従において、精度が向上しています。また、新しい「JSONモード」もサポートされており、「response_format」パラメータでJSON出力を制約できます。

1-3. seed と log probabilities

「seed」パラメータで、モデルが一貫したレスポンスを返すようにすることで、再現可能な出力が可能になります。このベータ機能は、デバッグや単体テストなどに役立ちます。

また、今後数週間以内に、「GPT-4 Turbo」および「GPT-3.5 Turbo」によって生成される可能性が最も高い出力トークンの「log probabilities」を返す機能を開始します。これは、検索エクスペリエンスのオートコンプリートなどの機能の構築に役立ちます。

1-4. GPT-3.5 Turbo の更新

デフォルトで16Kコンテキストウィンドウをサポートする新しい「GPT-3.5 Turbo」もリリースします。指示追従、 JSONモード、並列 Function Callingをサポートしています。

開発者はモデルID「gpt-3.5-turbo-1106」で試すことができます。モデルID「gpt-3.5-turbo」を使用するアプリは、12月11日に新しいモデルに自動的にアップグレードされます。

2. Assistants API ・ Retrieval ・ Code Interpreter

「Assistants API」は、開発者が独自のアプリ内でエージェントのようなエクスペリエンスを構築できるようにするための最初のステップです。アシスタントは、特定の指示を持ち、追加の知識を活用し、モデルやツールを呼び出してタスクを実行できる専用のAIです。「Assistant API」は、カスタム指示やツールなど、新しいGPT製品と同じ機能に基づいて構築されています。

このAPIで導入された重要な変更点は、永続的で無限に長いスレッドです。これにより、開発者はスレッド状態管理をOpenAIに引き渡し、コンテキストウィンドウの制約を回避できるようになります。

アシスタントは、必要に応じて次のような新しいツールを呼び出すこともできます。

・Code Interpreter : サンドボックス化された実行環境でPythonコードを作成して実行し、グラフやチャートを生成し、さまざまなデータと形式を含むファイルを処理できます。これにより、アシスタントはコードを繰り返し実行して、難しいコードや数学の問題などを解決できるようになります。

・Retrieval : 独自のドメイン データ、製品情報、ユーザーから提供されたドキュメントなど、モデルの外部からの知識でアシスタントを強化します。これは、ドキュメントの埋め込みを計算して保存したり、チャンキングや検索アルゴリズムを実装したりする必要がないことを意味します。「Assistants API」は、ChatGPTで知識の検索を構築した経験に基づいて、使用する検索手法を最適化します。

・Function Calling : アシスタントが定義した関数を呼び出し、関数の応答をメッセージに組み込むことができます。

「Assistant API」はベータ版であり、今日からすべての開発者が利用できるようになります。「Assistant Playground」にアクセスすると、コードを書かずに試すことができます。

3. マルチモーダルAPI

3-1. GPT-4 Turbo with Vision

「GPT-4 Turbo」は、「Chat Completions API」の入力として画像を受け入れることができ、キャプション生成、現実世界の画像の詳細な分析、図のある文書の読み取りなどを可能にします。

開発者はモデルID「gpt-4-vision-preview」でこの機能にアクセスできます。安定版リリースの一環として、メインの「GPT-4 Turbo」にVisionサポートを展開する予定です。

3-2. DALL-E 3

「Images API」にモデルID「dall-e-3」を指定することで、「DALL-E 3」 を利用できます。

3-3. Text-to-speech (TTS)

「Text-to-Speech API」は、テキストから人間レベルの音声を生成できるAPIです。6つのプリセット音声、「tts-1」「tts-1-hd」の2つのモデルを提供します。

4. モデルのカスタマイズ

4-1. GPT-4のファインチューニング

「GPT-4」のファインチューニングのための実験的なアクセスプログラムを作成しています。予備的な結果では、「GPT-3.5」のファインチューニングで実現された大幅な改善と比較して、「GPT-4」のファインチューニングは、ベースモデルに対して意味のある改善を達成するために、より多くの作業が必要であることを示しています。「GPT-4」のファインチューニングの品質と安全性が向上するにつれて、「GPT-3.5」のファインチューニングを積極的に使用している開発者には、「Fine-tuning Console」内で「GPT-4」に適用するオプションが提示されます。

4-2. カスタムモデルプログラム

ファインチューニングでは実現できないさらに多くのカスタマイズが必要な組織 (特に、数十億トークン以上の大規模な独自のデータセットを持つドメインに適用) のために、選ばれた組織にカスタムモデルを使用する機会を提供します。。 これは開始するには非常に限定された (そして高価な) プログラムになります。興味のある組織はここから申し込むことができます。

5. 価格とレート制限

5-1. 価格の引き下げ

「GPT-4 Turbo」の入力は「GPT-4」より3倍安い $0.01、出力は2倍安い $0.03 です。

「GPT-3.5 Turbo」の入力は以前の16Kモデルより3倍安い $0.001、出力は2倍安い $0.002 です。「GPT-3.5 Turbo 4K」を使用していた開発者は、$0.001で入力トークンが 33% 削減されるというメリットがあります。これらの価格は、本日導入された新しい「GPT-3.5 Turbo」にのみ適用されます。

ファインチューニングされた「GPT-3.5 Turbo 4K」の入力は 4倍安い $0.003になり、出力は 2.7 倍安い $0.006 になります。 新しい「GPT-3.5 Turbo」では、ファインチューニングにより4Kと同じ価格で16Kコンテキストもサポートされます。 これらの新しい価格は、ファインチューニングされた「gpt-3.5-turbo-0613」にも適用されます。

5-2. レート制限の緩和

「GPT-4」の有料開発者に対して1分あたりのトークン制限を2倍にします。 新しいレート制限は、レート制限ページで確認できます。また、レート制限の自動引き上げを決定する使用量階層も公開しています。アカウント設定から使用制限の引き上げをリクエストできるようになりました。

6. Whisper v3 と Consistency Decoder

6-1. Whisper v3

パフォーマンスが向上したオープンソースの自動音声認識モデルの最新版「Whisperlarge-v3」をリリースしました。近い将来、APIで 「Whisper v3」をサポートする予定です。

6-2. Consistency Decoder

「Stable Diffusion VAE デコーダ」のドロップイン代替品である「Consistency Decoder」もオープンソース化しています。このデコーダは、「Stable Diffusion 1.0+ VAE」と互換性のあるすべての画像を改善し、テキスト、面、直線が大幅に改善されます。

関連

この記事が気に入ったらサポートをしてみませんか?