Llama.cpp で Command R+ を試す

「Llama.cpp」で「Command R+」を試したので、まとめました。

・M3 Max (128GB)

1. Command R+

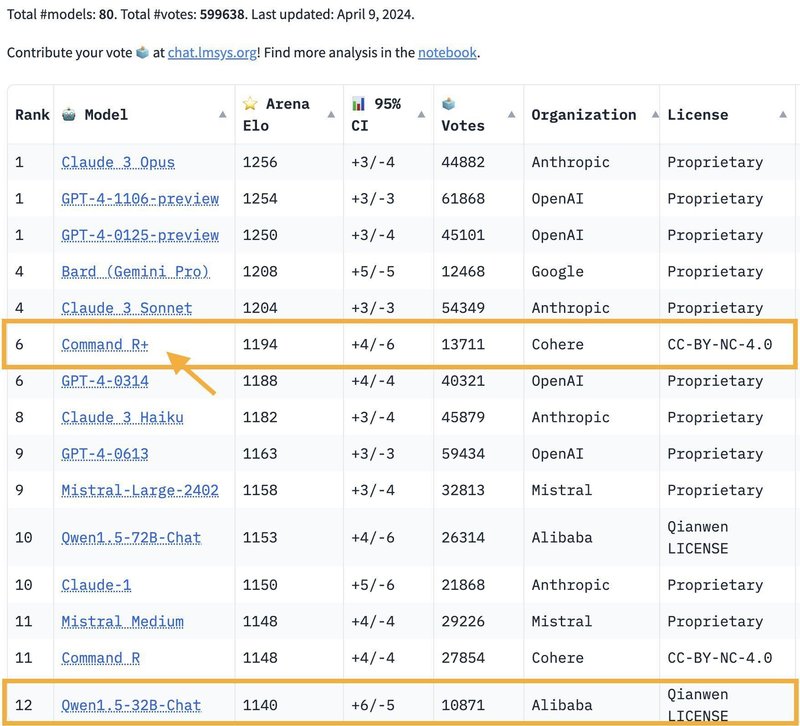

「Command R+」は、「RAG」や「Tool」などの長いコンテキストタスク向けに最適化された104BのLLMです。CohereのEmbeddingおよびRerankと連携して動作するように設計されており、RAGアプリケーションに最高クラスの統合を提供し、エンタープライズユースケースで優れています。

特徴は、次のとおりです。

・RAGとToolの使用に関する高い精度

・低遅延、高スループット

・128Kコンテキスト長

・10の主要言語に対応 (日本語含む)

・研究・評価のためにHuggingFaceでウェイトを公開

「Chatbot Arena」でも高い能力を示しています

3. Llama.cppでの実行

Llama.cppでの実行手順は、次のとおりです。

(1) Xcodeのインストール。

「Llama.cpp」は、インストール時に環境にあわせてソースからビルドして利用するため、MacではXcodeのビルドツールが必要になります。

(2) リポジトリのクローン。

$ git clone https://github.com/ggerganov/llama.cpp

$ cd llama.cpp(3) ビルド。

$ make(4) モデルをダウンロードして「llama.cpp/models」に配置。

今回は、「Q4_K_M」(command-r-plus-Q4_K_M-00001-of-00002.gguf と command-r-plus-Q4_K_M-00002-of-00002.gguf) を配置しました。

(5) 推論の実行。

$ ./main -p "<|START_OF_TURN_TOKEN|><|USER_TOKEN|>ままどか☆マギカとPSYCHO-PASSを通じて虚淵玄は功利主義の観点から何を伝えたかったのでしょう。<|END_OF_TURN_TOKEN|><|START_OF_TURN_TOKEN|><|CHATBOT_TOKEN|>" --color -m ./models/command-r-plus-Q4_K_M-00001-of-00002.gguf --temp 0.3Llama.cpp で Command R+ をお試し中。

— 布留川英一 / Hidekazu Furukawa (@npaka123) April 9, 2024

Q4_K_M・M3 Max (128GB)

5.22 tokens per secondhttps://t.co/ci5q7ID9k4 pic.twitter.com/8ckNL8j1NJ

関連

この記事が気に入ったらサポートをしてみませんか?