バズるSNS投稿を量産する魔法を唱えよう🧙

はじめに

こんにちは!Taiyo | AIで遊ぶ大学生 です!!

「AIで遊びたい」のリプライありがとうございます🔥

今回はAI時代における便利なSNS投稿草案の自動作成フローについてお話ししようと思います。特に、ソーシャルメディアのデータを効率よく収集して再利用する方法に焦点を当てます。

普段は、Bubble、Flutter Flow ,Makeなどのノーコードと生成AIを活用して受託開発をしています!是非ご気軽にご相談ください〜⭐️

最終成果物は下記になります!

毎日Xの投稿を考えるのが面倒くさいので、自動化しちゃった

— Taiyo | AIで遊ぶ大学生 (@Taiyo_AiAA) May 2, 2024

毎日全自動で、

1️⃣海外でバズっている投稿をスクレイピング

2️⃣それらを自分なりの文章にアレンジし、意見を加える

3️⃣スプレッドシートに投稿案を無限生成🚆… pic.twitter.com/XBHXcxRxHd

make.comとApifyを使ったプロセスをご紹介します。これにより、特定のユーザーの投稿をスクレイピングし、ChatGPTで内容を新しく書き換えた後、それをGoogle スプレッドシートに自動的に入力することができます✨

自動化の魅力は、「時間の節約」と「効率の向上」にありますが、このフローではさらに一歩進んで、次のようなステップを組み込んでいます⏬

Apifyを使用したデータスクレイピング:気になるユーザーの投稿をキャッチ!

make.comでのフロー設定:データを一つのプロセスでスムーズに処理。

ChatGPTでのコンテンツリライト:テキストをアップデートして、より魅力的な内容に。

スプレッドシートへのデータ入力:全てをきれいに整理して、後で見返しやすく!

この記事を通じて、少しでも日常業務がラクになれば嬉しいです。それでは、Apifyでのスクレイピング設定から詳しく見ていきましょう🔥

Apifyの設定

まずApifyってなに?

Apifyは、Webスクレイピング、データ抽出、オートメーションのためのクラウドベースのプラットフォームです。

ユーザーはこのプラットフォームを利用して、Webサイトから情報を自動的に収集し、それを様々なフォーマットで保存することができます!!

このApifyを使って特定のユーザーの投稿をスクレイピングするのは、思ったよりも簡単です。まずはApifyのアカウントを持っていない場合は、サインアップから始めましょう。

サインアップ後、Apifyダッシュボードにログインし、新しいタスクを作成することからスタートします。

ステップ1:タスクの作成

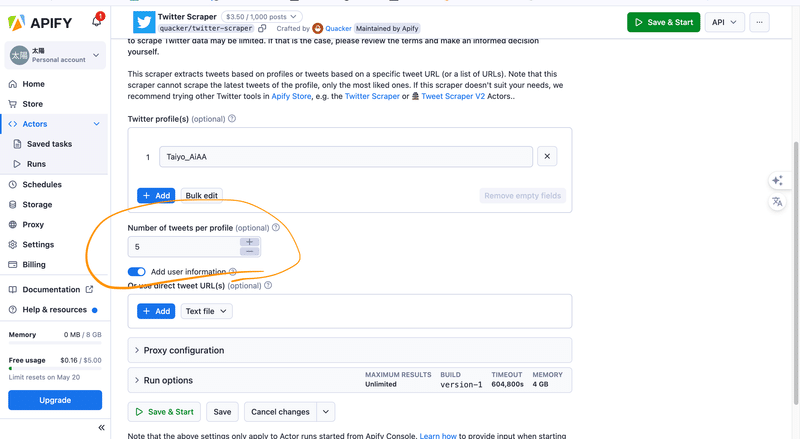

タスクの作成:「Store」をクリックし、スクレイピングするタスクを選択します。今回は「Twitter Scraper」を選びましょう!

参考にしたいXユーザー名を設定:スクレイピングしたいソーシャルメディアのプロフィール名を「Twitter profile(s)」に入力します。複数のユーザーを追加することも可能です。※参考にするユーザーは、自分のアカウントと発信内容が似ているものを選ぶと、バズる可能性が高くなります。

1人のユーザーから取得するツイートの数を設定:「Number of tweets per profile」の欄に数字を入力します。例えば、参考にする2人のユーザーを選択し、ツイート数を5に設定すると、合計10個のツイートが生成されます。

ステップ2:実行とテスト

テスト実行:設定が完了したら、「Start」ボタンを押してテスト実行します。これで、指定したプロフィールからデータが正しく抽出できているか確認できます。

データの確認:抽出されたデータをプレビューして、全てが期待通りであることを確認します。

ステップ3:API tokenをコピー

make.com上で連携をする際にAPI tokenを使用するのでコピーしておいて下さい!

これで、Apifyを使ったデータのスクレイピング設定は完了です!次は、このデータをどう使うか、ということをmake.comの自動化フローで見ていきましょう⏬

make.comでの自動化フローの構築

makeってなに?

make.comは、異なるアプリケーション間でデータを移動させたり、複雑なタスクを自動化するのに非常に便利なツールです。

ここでは、ApifyでスクレイピングしたデータをChatGPTでリライトし、最終的にGoogle スプレッドシートにデータを入力するフローを設計する方法を説明します。

まずはmakeのアカウントを持っていない場合は、サインアップから始めましょう。

ステップ1: フローの作成

新しいフローを作成:make.comのダッシュボードで「Create new scenario」をクリックし、新しいフローを始めます。

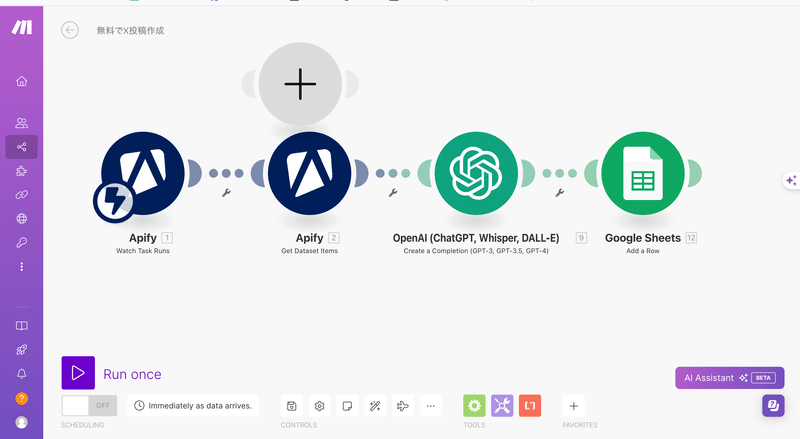

モジュールの選択:Apify、ChatGPT、Google スプレッドシートの各モジュールをフローに追加します。モジュール一覧は私の方でご用意したので、下記jsonファイルをダウンロードして下さい!

ダウンロード方法は下記になります!

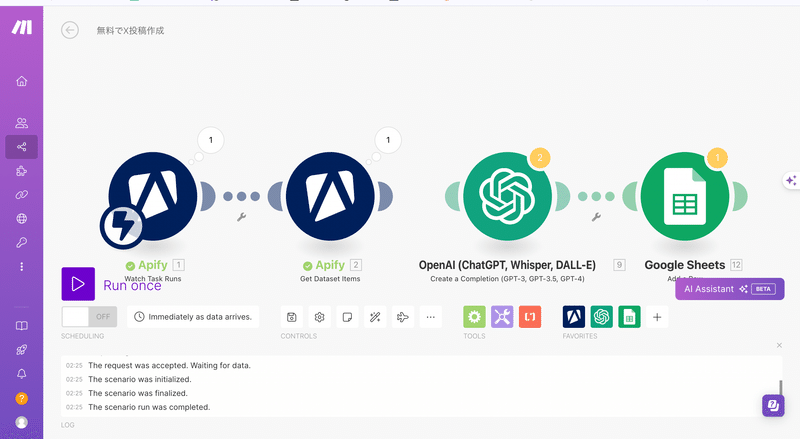

下記のような表示になっていれば成功です🔥あとはポチポチしていくだけで完成になります笑

ステップ2: Apifyとの連携

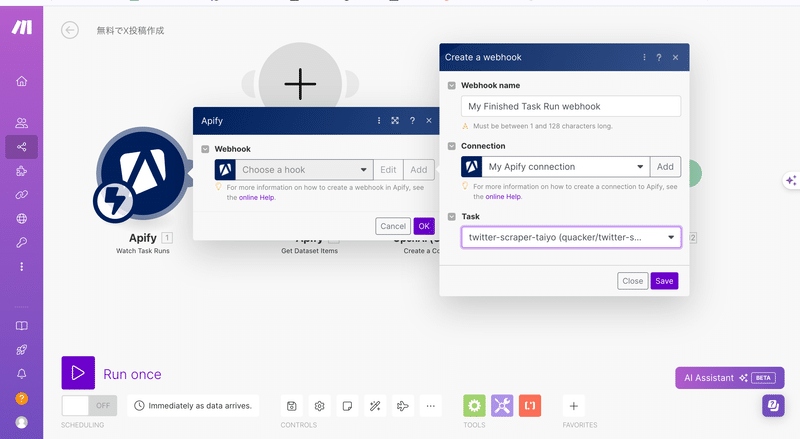

先ほどコピーしたAPI tokenを下記動画の手順で入力します。

そして、「Task」の箇所には今回使う、Twitter-scraperの名前を選択し、「Save」を押します。

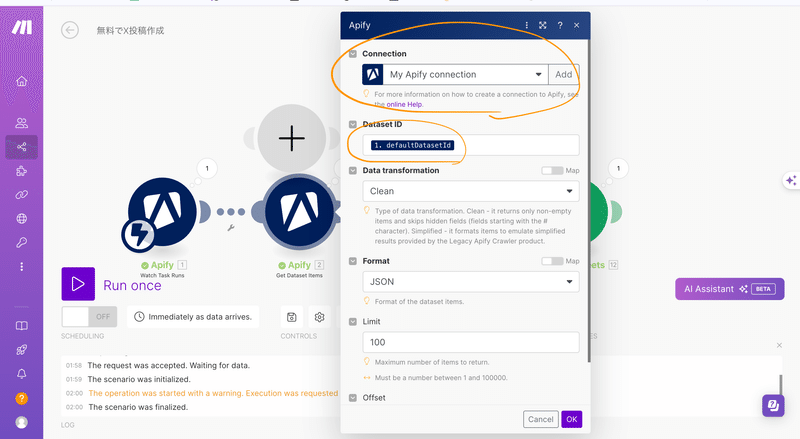

2個目のApifyモジュールの設定:「Apify: Get dataset items」モジュール(2個目のモジュール)にApifyからの「Dataset ID」を指定します。今回は、1個目のモジュールの「defaultDatasetId」を選択します。※インプットをクリックすると候補として出てくるので「defaultDatasetId」を探します。

一旦、Run onceを選択して、実行してみます。実行すると、実際の値がこのmake.com上に返されます。

手順としては、下記です。

2個目と3個目の接続を切る:まだ1個目と2個目しか設定していない状態でテストをするので3個目以降はエラーが返されてしまうからです。

2個目と3個目をつなぐ線上を右クリックして、「Unlink」を選択!

「Run once」を選択して、make.com起動!

Apifyの「Start」を選択して、Apify起動!

1分くらい待って、下記のようにアイコンの下の文字が緑色になっていたら成功です!

ステップ3:ChatGPTによるコンテンツのリライト

まず前提として、ChatGPTのAPI tokenを入手しましょう!APIの設定に関しては、下記サイトがわかりやすいためそちらを参照して下さい!

早速、自動化フローの一環として、ChatGPTを活用してスクレイピングしたコンテンツをリライトする方法を紹介します。このステップでは、オリジナルのテキストをさらに魅力的かつ新しい視点で表現するために、AIを利用します。

まずは、先ほど作成したモジュールとChatGPTのモジュールを接続&スプレッドシートモジュールとの接続を切る⏬

API tokenの設定:先ほど取得したChat GPTのAPI tokenをmakeのモジュールに設定します⏬

モデル選択:OpenAIのAPIを使用し、適切なGPTモデルを選択します。現在のところ、GPT-4が最も高度なモデルで、多様なテキストスタイルと深い理解を提供します。

プロンプトの設計:リライトするテキストの内容と、どのような視点やスタイルで書き換えるかを定義します。例えば、よりカジュアルなトーンや特定の観点からの解説を加えることができます。今回は、1ヶ月で1500フォロワーを伸ばした私の投稿を分析したプロンプトを記載しておきますのでよしなに使用して下さい⏬

プロンプト:

「前述の文章からチャットGPTを用いて、最新のAI技術を紹介し、その具体的な利用方法や効果をユーモアを交えて説明するツイートを作成してください。技術名は架空で革新的なものにし、リアルな使用シナリオを提供すること。さらに、視覚的な興味を引くために、関連する画像リンクを含めてください。」

具体的な使用例:

技術紹介: 「発表!最新AI『DreamCoder』が登場。コーディング作業を半自動で支援、あなたの半分はAIが担当します!」

利用方法と効果: 「『DreamCoder』利用シナリオ:もうデバッグに時間を浪費しない。このAIはあなたの書いたコードをリアルタイムで解析し、最適な修正案を提示。コードレビューがこれで一気に楽に!」

ユーモアと驚き: 「エラーが減るほど、コーヒーブレイクも減るかも?『DreamCoder』で、開発者の新たな悩み事が増えるかもしれませんね(笑)」

視覚的な要素: 「興味が湧いたら、こちらのリンクで『DreamCoder』の魅力を動画でチェック![動画リンク]」

このようなプロンプトを使うことで、具体的かつ魅力的なツイートが生成され、フォロワーの興味を引き、高いエンゲージメントを得られる可能性が高まります。

Apifyでスクレイピングした返り値をChatGPTに組み込ませる:設定したプロンプトの直前をクリックして、検索窓から、「full text」を検索して、出てきた内容をクリックします⏬

上記で、ChatGPTの設定は完了です!

テキストの生成の実行

「Run once」を選択して、make.com起動!

Apifyの「Start」を選択して、Apify起動!

1分くらい待ってアイコンの下の文字が緑色になっていたら成功です✨

ステップ4:Google スプレッドシートへのデータ入力の詳細

もうあとは正直消化試合です笑

リライトされたコンテンツやスクレイピングしたデータをスプレッドシートに整理する際に、各データポイントをどの列に入力するかは重要です。

まずはスプレッドシートモジュールを他のモジュールとくっつけて、gogoleアカウントと連携をします。「sign in google」を選択します。

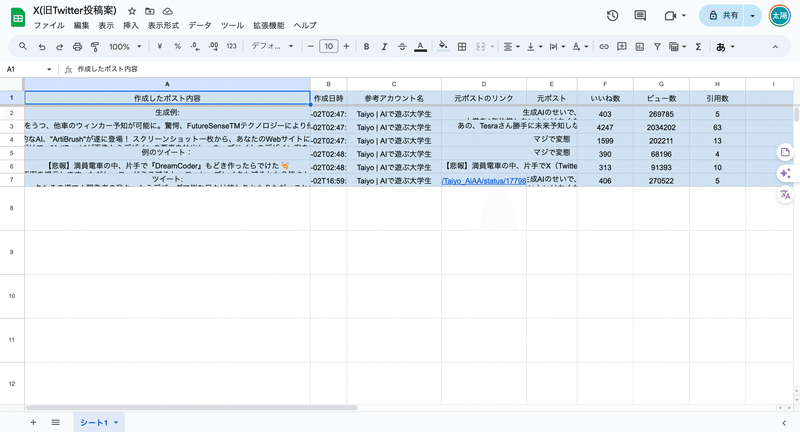

スプレッドシートの列の設計

スプレッドシートを新規で作成し、各列に入れたいデータのタイトルをつけます。下記は例になります。参考ファイルはこちらから

列A -作成したポスト内容:ChatGPTによってリライトされた投稿内容。

列B - 作成日時:Apifyでスクレイピングした投稿の日付。

列C - 参考アカウント名:投稿者のユーザー名。

列D - 元ポストリンク:元のポスト内容を含むリンク。

列E - 元の投稿内容:元の投稿内容になります。

列E - いいね数:投稿が受けた「いいね」の数。

列F - ビュー数:投稿に対する試聴数。

列G - 引用数:投稿に対する引用数。

作成した、SpreadsheetIDとSheet Nameを設定します⏬

make.comでのデータマッピング

最後に、make上で、今までApifyやChatGPTで出力した内容をスプレッドシートの各項目に紐づけます。

お疲れ様です!!よく頑張りました!これで全ての設定は終わりです。最後にテストをしましょう!

テストと調整

データの入力テスト

すべてのマッピングを設定した後、テストデータを使って一度フローを実行し、各列に正しいデータが入力されているかを確認します。

「Run once」を選択して、make.com起動!

Apifyの「Start」を選択して、Apify起動!

スプレッドシートに入力した内容に投稿が作成されていたら、完了です!!

お疲れ様でした!他にもインスタグラムやWebスクレイピングを実行したり、make上でもっと他のアプリを連携したりなどをして拡張することができます!

まとめ

このブログを通じて、make.com、Apify、ChatGPT、そしてGoogle スプレッドシートを使用した一連の自動化プロセスを詳しく解説しました。

これらのツールを組み合わせることで、ソーシャルメディアのデータを効率的に収集・加工し、新たな価値を生み出すことが可能です。自動化は単に作業を楽にするだけでなく、データの整理と分析を容易にし、より戦略的な意思決定をサポートします。

本記事が示したフローは、技術的な背景がある方にもない方にも理解しやすいように設計されています。また、各ステップでの具体的な設定方法や、プロセスの運用時に役立つヒントも提供しました。こ

の自動化ガイドを参考に、ぜひ自分の業務やプロジェクトに応用してみてください。それにより、日々の作業がどれだけスムーズかつ効果的に変わるかを体感いただけるはずです。

何か自動化に関する質問や、特定のツールの使用方法についてさらに知りたいことがあれば、お気軽にお問い合わせください🔥

この記事が気に入ったらサポートをしてみませんか?