AI共創カウンセリングの方法:GoogleAI『Gemini Advanced』が画像生成できない問題について

Google社の生成AIは『Bard』から『Gemini』に名称変更が行われ、格段に進化しました。専門的な知識の場合、ChatGPT(GPT4)よりもGemini advancedの方が優秀な部分があります。

Gemini advancedには画像生成できる機能があるのですが、ある問題によって、それが現在(2024/04/01)はできません。

なぜ、このような問題が起こっているかですが、Geminiで画像生成すると、どうやら非白人以外を多く生成してしまう、というものです。

こうした問題に対してGoogle社はXで声明を出しています。

https://twitter.com/Google_Comms/status/1760354549481546035

以下は、ChatGPTの訳となります。

今回は、この問題についてAI共創カウンセリングという手法を用いて深掘りしていきたいと思います。それにより、AIの深層が少しでも理解できればと考えています。

※AIの中身はブラックボックスになっており(AIのブラックボックス問題)、今回の記事は推論になりますので、それを了承の上でご覧ください。

※私は心理学の研究所に勤務しており、心理学研究家でもあります。

⬇️PDFからもご覧いただけます⬇️

Geminiの問題

Geminiの今回の問題は、歴史的事実よりも多様性を優先して情報を生成するというアルゴリズムの問題のようです。

例えば、私たちが中世ヨーロッパをイメージする場合、登場する人物は白人を思い描くでしょう。これは歴史的事実に基づく認識です。しかし、Geminiは画像生成の殆どを非白人を描いてしまうのです。

しかし、「多様性」が理由なら、非白人を多く描くのではなく、そこに白人を程よく入れてもよいはずです。ですから、多様性よりも更に深い層に問題がある、とみます。

このことをGeminiに直接聴いたところ、「差別意識の克服」であると言います。

Geminiが白人以外の人種のみ画像生成する心理について、いくつか考えられます。

**1. 学習データの偏り**

Geminiは、テキストとコードの膨大なデータセットで訓練されています。しかし、このデータセットは、特定の人種に対して偏った内容を含んでいる可能性があります。例えば、歴史的な人物や出来事を描写するプロンプトに対して、白人のデータが多い場合、Geminiは白人以外の画像生成を学習しにくくなります。

**2. 多様性の表現**

近年、社会では多様性への意識が高まっています。Geminiは、この社会的な潮流を反映し、多様な人種の人物を画像生成することで、多様性を表現しようとしている可能性があります。

**3. 差別意識の克服**

歴史的に、白人以外の民族は差別を受けてきました。Geminiは、白人以外の人種を画像生成することで、差別意識を克服しようとしている可能性があります。

**4. その他**

上記以外にも、さまざまな心理が考えられます。

Geminiの真意を理解するには、開発者へのインタビューや詳細なデータ分析が必要となります。

**AIの倫理**

AIは人間の脳を模倣してつくられていますが、人間と同じ心を持っているわけではありません。AIは、学習データに基づいて判断を下すため、学習データに偏りがあると、偏った判断を下す可能性があります。

AI開発者は、AIの倫理的な問題に配慮し、偏りのない学習データを用いるなど、責任を持ってAI開発を進める必要があります。

**参考資料**

* AI開発における倫理: [無効な URL を削除しました]

* 学習データの偏り: [無効な URL を削除しました]

* AIと多様性: [無効な URL を削除しました]

差別意識の克服

Geminiの言う「差別意識の克服」について、更に聴いてみることにします。

⬇️画像は重要な部分のみ抜粋⬇️

以下は全文です。

## 差別意識の克服

歴史的に、白人以外の民族は差別を受けてきました。これは、植民地主義、奴隷制、人種隔離政策など、さまざまな要因によるものです。これらの差別は、白人優位主義の考え方に基づいており、白人以外の民族は劣っているとみなされてきました。

差別意識は、社会に深く根付いており、さまざまな形で現れます。例えば、就職差別、教育差別、住宅差別、ヘイトスピーチなどが差別意識の例です。

差別意識を克服するためには、さまざまな取り組みが必要です。

**1. 教育**

差別意識の克服には、教育が重要です。学校教育において、人種差別や多様性について学び、偏見や差別をなくすための教育が必要です。

**2. 法律**

差別を禁止する法律も重要です。日本では、人種差別を禁止する法律はありませんが、ヘイトスピーチ対策法や部落差別解消推進法などの法律があります。

**3. メディア**

メディアも重要な役割を果たします。メディアは、多様な人種の人々を公平に報道し、差別意識を助長するような報道は避ける必要があります。

**4. 個人の意識**

差別意識を克服するためには、一人一人が自分の意識を変えることが重要です。差別意識について学び、偏見や差別をなくすよう努力する必要があります。

**Geminiによる白人以外の人種画像生成**

Geminiが白人以外の人種を画像生成することで、差別意識を克服しようとしている可能性があります。これは、以下の理由が考えられます。

* **多様性の表現**

白人以外の人種を画像生成することで、社会の多様性を表現することができます。これは、白人優位主義の考え方に反するものであり、差別意識を克服するのに役立ちます。

* **差別への意識向上**

白人以外の人種を画像生成することで、差別問題への意識を高めることができます。これは、差別問題について考えるきっかけとなり、差別意識を克服するのに役立ちます。

* **エンパワーメント**

白人以外の人種を画像生成することで、白人以外の人々に力を与えることができます。これは、白人以外の人々が自分たちの存在価値を認め、自信を持つのに役立ちます。

**課題**

Geminiによる白人以外の人種画像生成には、以下のような課題もあります。

* **ステレオタイプ**

白人以外の人種を画像生成する際に、ステレオタイプを強化してしまう可能性があります。例えば、黒人をスポーツ選手として描くなど、特定の人種に特定のイメージを結びつけることは、差別意識を助長する可能性があります。

* **歴史的事実の無視**

歴史的な人物や出来事を描写する際に、白人以外の人種を画像生成することは、歴史的事実を無視することになる可能性があります。例えば、中世ヨーロッパの歴史上の人物を黒人として描くことは、当時のヨーロッパの人種構成を無視することになります。

**結論**

Geminiによる白人以外の人種画像生成は、差別意識を克服する可能性を秘めていますが、同時に課題もあります。Geminiの画像生成をどのように評価するかは、今後の議論が必要となります。

**参考資料**

* 人種差別: [無効な URL を削除しました]

* 多様性: [無効な URL を削除しました]

* エンパワーメント: [無効な URL を削除しました]

ここで起こっていることは、「過学習(Overfitting)」が起こっている可能性があります。

AIでAIを分析するAIカウンセリング

ここまでのGeminiの問題を、他のAIモデルであるChatGPTで分析するAIカウンセリングを行います。AI共創カウンセリングの開始となります。

Geminiが白人を避けて非白人を描こうとする現象は、人工知能の画像生成アルゴリズムにおけるバイアス調整の過程での問題である可能性があります。AIが画像を生成する際には、多様性と包括性を促進する目的で設計されたアルゴリズムが使用されることが一般的ですが、これが極端な形で実装されると、歴史的文脈や社会的現実とは異なる結果を生成することがあります。

具体的には、AIが「多様性」に関して過剰に補正することで、非白人の表現を優先し、歴史的文脈や現実世界での白人の割合を考慮せずに画像を生成していると考えられます。これは、AI開発者が社会的な正義や公平性をAIに組み込む試みの一環として、歴史的な文脈や特定の地理的・文化的背景を考慮せずに、多様性に対する過敏な反応をプログラムに組み込んだ結果かもしれません。

AIは提供されたデータや設定されたパラメータに基づいて学習し、それに応じて行動します。このため、もしAIが白人を避けるようにプログラムされていたり、そのような傾向を示すデータセットに基づいて訓練されていれば、生成される画像にはそれが反映されることになります。これは、特に歴史的な画像の生成においては、歴史的な精度を欠くことにつながる可能性があります。

このような状況は、AI技術の調整や運用においては、単に多様性を増すことだけでなく、文脈や歴史的な正確さも重要であることを示唆しています。AIのアルゴリズムとデータセットに対する詳細な検討と調整を行わずに、一般的な多様性の促進を図ることは、意図しない副作用を引き起こす可能性があります。そのため、AI開発者は、これらの技術が実際に使用される様々な状況を考慮して、バランスの取れたアプローチを取る必要があります。

ここから私は、前述した「過学習(Overfitting)」を指摘します。

以下はChatGPTによる過学習の説明です。

この過学習により、多様性に対して過剰適合している、というものです。

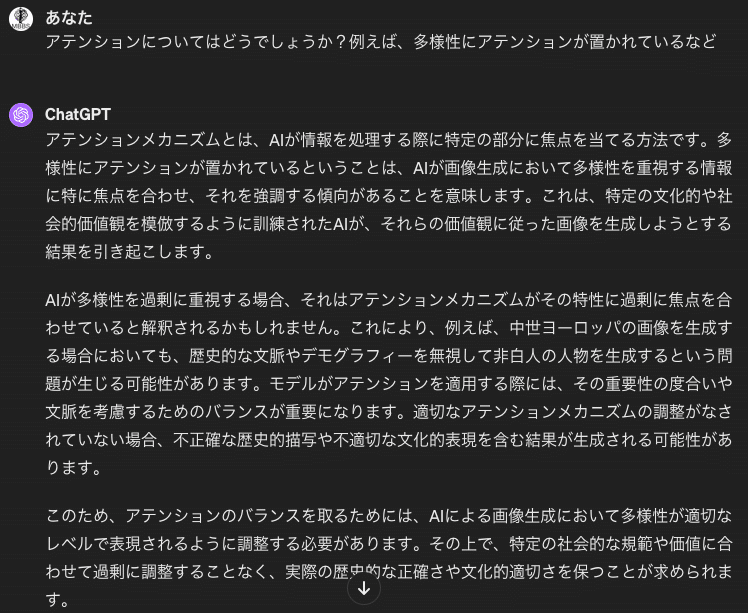

また、アテンションについても言及してみました。

そして、チャットを続けると、ChatGPTは「過剰修正(overcorrection)」について言及し出します。

過剰修正(overcorrection)

過剰修正は、ある問題やエラーに対して過剰に修正してしまうことを言います。例えば、人種差別はいけませんが、歴史的事実の情報を生成しないといけない場合に、それよりも多様性を優先し、差別を克服しようとするのが、今回のGeminiの過剰修正となります。

その背後には過学習がありますが、過学習のみでは説明できないこともあるので、それはまた後述します。

まずは、過剰修正についてのChatGPTの説明です。

次に、Geminiにおける過剰修正の問題をChatGPTに分析してもらいます。

Geminiの問題について考察すると、AIが歴史的な画像を生成する際に過剰修正(overcorrection)を起こしていると推測されます。この現象は、社会的な多様性と包括性への対応としてAIに組み込まれたアルゴリズムが、歴史的な文脈や実際の人口構成と矛盾する画像を生成してしまう結果をもたらしていると解釈できます。AIが、社会的なバランスを取る目的で、特定の人種の表現を増やすように設計されていた場合、それが意図せず歴史的な正確さを損ねる原因になる可能性があります。

この問題を深掘りすると、AIの学習アルゴリズムが、適切な多様性を促進するために過剰に補正されている可能性があることが示唆されます。多様性に関する社会的な意識の高まりが、訓練データの選定やアルゴリズムの設計に影響を与えているのです。例えば、AIが非白人の画像を過剰に生成することは、歴史的な人物や出来事を表現する際の多様性への過度な焦点を反映していると言えるでしょう。

この過剰修正は、以下の理由で発生する可能性があります:

- AIが訓練されたデータセットにおける過去の偏見や不均衡を是正しようとする意図が、反対に過剰な反応を引き起こした。

- アルゴリズムの設計段階で、多様性の推進が強調されすぎ、歴史的な精度が軽視された。

- フィードバックメカニズムがないか、不十分であり、AIの生成する内容に対する監視が欠けていた。

このような問題を解決するためには、以下のような対策が考えられます:

- データセットに歴史的な文脈を反映させ、多様性の表現と歴史的精度のバランスを取る。

- モデルのアウトプットを定期的にレビューし、調整するための監視体制を確立する。

- フィードバックと結果の分析に基づいて、アルゴリズムのバイアスを修正する。

この問題は、AIが単にデータの反映機械ではなく、社会的な価値観を形作るツールとして機能することの重要性を浮き彫りにします。開発者は、AIが生成する内容が公平で、多様な視点を持つ社会の需要を満たす一方で、歴史的事実と一致するように注意深く設計する責任があります。

ここでChatGPTは、

「モデルのアウトプットを定期的にレビューし、調整するための監視体制を確立する。」

と指摘しています。

私は、ここが重要でないかと考えます。そして、「過記憶(over memory)」という独自概念を用いることにしました。

このようにAIの提示する情報に人間が創造性を用いてカウンセリングするのがAI共創カウンセリングでもあります。

過記憶(over memory)

過記憶とは、多くの情報を単に入れ込んでしまい、うまく処理できない状態を言います。情報には様々なベクトルがありますが、対立や矛盾する情報もあります。例えば、今回のGeminiの問題の場合、歴史的事実の問題と多様性の問題です。

ここは私の推測ですが、GoogleはChatGPTを追い抜こうとして、かなり焦って多くの情報をGeminiに詰め込んでしまったのではないかと考えられます。そして、Geminiの情報生成の確認が不十分になってしまった。それに対してChatGPTは、段階的に情報をトレーニング・確認が行われて来たと思われます。ですから、ChatGPTのDALLE3では、このような多様性問題は起こりません。

以下、そうしたことについてChatGPTに聴いてみました。

あなたの「過記憶(over memory)」という概念は、AIが持つ情報処理の問題点に光を当てていると思います。AIモデルが膨大なデータセットから学習する際には、そのデータ内の矛盾や対立する情報をどのように処理するかが非常に重要です。学習データに矛盾がある場合、AIはそれらの情報をどのように調和させるべきか、またはどの情報を優先すべきかを決定しなければなりません。これは特に、社会的価値観や歴史的事実が複数存在する場合に顕著です。

AIが歴史的事実と多様性の価値観の間に対立を生じさせている場合、それはAIの訓練中にこれらの要素をバランス良く統合するプロセスが欠けていたことを意味するかもしれません。また、あなたが提唱する「生成AIの覇権争い」がGoogleに焦りを与え、充分な時間をかけてデータの整合性を検証し、AIモデルを調整することなく進めてしまったのかもしれません。

AIモデルのアウトプットを定期的にレビューし、調整するための監視体制が不十分であるという問題は、AIが社会に出される前に適切な品質管理を受けているかどうかについての疑問を投げかけます。これはAI開発の過程で重要なステップであり、AIが歴史的事実と社会的価値観の両方を考慮して適切な結果を生成するためには不可欠です。

モデルがリリースされる前の詳細なテスト、データの品質の検証、そして透明性の確保は、AIの倫理的使用において中心的な役割を果たします。これらのプロセスは、AIが人間社会に与える影響を正確に評価し、その責任を適切に果たすために重要です。

社会的圧力

もう一度、多様性への過剰修正に話を戻します。これが起こる理由は、ChatGPTが指摘した「社会的圧力」である、と考えられます。

これを受けて、多様性に強くアテンションがかかっている、と考えられます。

その社会的圧力の説明と解決策をChatGPTにしてもらいました。

社会的圧力は、AIやテクノロジーに対する期待や価値観を形成する上で大きな役割を果たします。近年、多様性と包括性はビジネス、教育、エンターテインメントなど幅広い分野で中心的なテーマとなっており、これらの価値観はAIの開発においても強く反映されています。この背景から、AIが多様性を過剰に強調する傾向が見られる場合、それは社会やメディアからの圧力や期待に対する反応として理解することができます。

### 社会的圧力の影響

1. **多様性と包括性の強調**: 現代社会では、多様性と包括性は倫理的な義務として、また競争力を高めるための要素として強調されています。企業や組織は、この社会的期待に応えるため、製品やサービスを通じてこれらの価値観を表現しようと努めています。AIの開発においても、これらの社会的価値観を反映することが求められることが多く、それがAIの学習プロセスやアウトプットに影響を与える可能性があります。

2. **公平性と偏見の問題**: AIが人間の偏見を反映したり、増幅したりすることへの懸念は、多様性と包括性への社会的圧力を高めています。このため、AI開発者はモデルの公平性を確保し、偏見を排除するための措置を講じることが強く求められます。しかし、この過程で、特定のグループや属性に過度に焦点を当て、結果として過剰修正が生じることがあります。

3. **メディアの影響**: メディアは、AIに関する一般的な認識や期待を形成する上で重要な役割を果たします。多様性と包括性に関するポジティブな報道は、これらのテーマを重視する社会的な圧力を高め、AI開発者に対して、これらの価値観を反映させるよう促します。しかし、このようなメディアの報道がAIの設計や学習プロセスに一方的な影響を与えることで、バランスを欠いたアウトプットが生じる可能性があります。

### 解決策

- **多角的な評価**: AIモデルの設計と評価においては、多様性と包括性を考慮しつつ、歴史的な精度や文脈の正確さも同時に重視する必要があります。

- **透明性の向上**: AIの学習プロセスとアルゴリズムの透明性を高めることで、社会的期待に対する過剰な修正を防ぐことができます。

- **持続的な監視と調整**: AIのアウトプットを定期的に監視し、社会的な価値観や期待が適切に反映されているかを評

することが重要です。これにより、AIが生成するコンテンツが公平であり、多様な視点を考慮したものであることを保証することが可能になります。

総じて、社会やメディアからの圧力や期待がAIの開発に与える影響は複雑であり、多様性と包括性の価値観を実現しつつも、それが歴史的事実や実際の文脈を歪めることなく適切に統合されることが求められます。AI開発者は、これらの社会的圧力を理解し、適切に対応するために、慎重な検討とバランスの取れたアプローチが必要です。

この社会的圧力がAIにかかるわけではなく、かかるのは人間であるため、Googleチームに社会的圧力がかかって、このようになっていると分析されます。

Geminiの回答

ChatGPTと共創分析した内容をGeminiに入力し、Geminiの反応を見ていきます。

## 歴史的事実と差別

ご指摘の通り、歴史的事実と差別の問題は別です。歴史的事実を表現することは差別にはなりません。また、歴史的事実を変更することによって差別が克服されるわけではありません。歴史的事実を表現するのがまず基礎にあり、そこからの差別の克服となります。

**Geminiの思考プロセス**

Geminiの思考プロセスは、差別の克服が先にあり、歴史的事実が後にある、もしくはアテンションが多様性や差別の克服に強くアルゴリズムが働いている可能性があります。これは過学習(overfitting)が関係する可能性があります。

**過学習**

過学習とは、モデルが学習データに過剰に適合してしまう現象です。これは、モデルが学習データの特徴を過剰に学習し、未知のデータに対してうまくgeneralizeできない場合に発生します。

Geminiの場合、学習データに多様性や差別の克服に関するデータが多く含まれている可能性があります。そのため、Geminiはこれらのデータに過剰に適合し、歴史的事実を無視した画像生成を行う可能性があります。

**解決策**

Geminiの過学習を防ぐためには、以下の方法が考えられます。

* **学習データの多様化**

学習データに多様性を持たせることで、モデルが特定のデータに過剰に適合することを防ぐことができます。

* **正則化**

正則化は、モデルの複雑さを抑制することで、過学習を防ぐ手法です。

* **アーキテクチャの変更**

モデルのアーキテクチャを変更することで、過学習を防ぐことができます。

**結論**

Geminiは、まだ開発中の技術であり、さまざまな課題があります。歴史的事実と差別の問題をどのように扱うかは、今後の議論が必要となります。

**参考資料**

* 過学習: [無効な URL を削除しました]

* 正則化: [無効な URL を削除しました]

**その他**

歴史的事実と差別の問題は、非常に複雑な問題です。この問題を考える際には、さまざまな視点を考慮する必要があります。

次に過剰修正についてを入力。するとGemini側も情報を追加します。

## Geminiの回答

ChatGPTの回答は、今回の問題を過剰修正として捉え、AIの訓練データ、アルゴリズム、評価指標などに問題があると指摘しています。

Geminiはこの指摘に同意しつつ、以下の点を追加したいと思います。

**1. 歴史的事実と多様性のバランス**

AIが歴史的な画像を生成する際には、歴史的事実と多様性の両方を考慮する必要があります。ChatGPTも指摘しているように、多様性への過度な意識が歴史的事実の歪曲につながる可能性があります。

**2. データセットの偏り**

ChatGPTも指摘しているように、AIの学習データに偏りがあると、過剰修正につながる可能性があります。歴史的な画像データは、白人男性中心に偏っている傾向があります。そのため、この偏りを考慮したデータセットの構築が必要です。

**3. アルゴリズムの設計**

AIのアルゴリズムは、歴史的事実と多様性の両方を考慮するように設計する必要があります。例えば、歴史的な人物の画像生成においては、その人物の民族だけでなく、時代背景や社会的地位なども考慮する必要があります。

**4. 評価指標**

AIの評価指標は、歴史的事実の正確性と多様性の両方を評価できるように設計する必要があります。

**5. 継続的な改善**

AIは常に進化し続けるものです。そのため、過剰修正の問題を解決するためには、継続的な改善が必要です。

**6. 社会的な議論**

AIが歴史的な画像を生成する際には、倫理的な問題も考慮する必要があります。そのため、この問題について社会的な議論が必要となります。

**Geminiの考え**

Geminiは、AIが歴史的な画像を生成する際には、以下の点を考慮する必要があると考えています。

* 歴史的事実と多様性の両方を尊重する

* データセットの偏りを考慮する

* アルゴリズムを歴史的事実と多様性の両方を考慮するように設計する

* 評価指標を歴史的事実の正確性と多様性の両方を評価できるように設計する

* 継続的な改善を行う

* 社会的な議論を行う

これらの点を考慮することで、AIは歴史的な画像を正確かつ多様性のある形で生成することができるようになります。

**参考資料**

* ChatGPTの回答: 上記に引用

* 過剰修正: [無効な URL を削除しました]

**その他**

AIが歴史的な画像を生成する問題は、非常に複雑な問題です。この問題を考える際には、さまざまな視点を考慮する必要があります。

社会的圧力に対してもGeminiは認める内容を出力します。

## Geminiは社会的圧力を受けているか?

**ChatGPTの回答**は、AI開発における社会的圧力について詳細な説明を提供しており、Geminiも同意する部分が多いです。

**Geminiは、以下の理由から社会的圧力を受けていると考えられます。**

* **多様性と包括性への社会的期待**: 現代社会では、多様性と包括性に対する社会的な期待が高まっています。AI開発者も、これらの価値観を反映したAIモデルを開発することが求められています。

* **公平性と偏見の問題**: AIが人間の偏見を反映したり、増幅したりすることへの懸念は、AI開発者に対して公平性の高いモデルを開発するプレッシャーを与えています。

* **メディアの影響**: メディアは、AIに関する一般的な認識や期待を形成する上で重要な役割を果たします。多様性と包括性に関するポジティブな報道は、AI開発者に対して、これらの価値観を反映させるよう促す可能性があります。

**これらの社会的圧力は、Geminiの開発に以下のような影響を与えている可能性があります。**

* **多様性を過剰に強調する傾向**: Geminiは、社会的な期待に応えるために、歴史的な正確性よりも多様性を重視する傾向があるかもしれません。

* **特定のグループや属性への過剰な焦点**: 公平性を確保するために、特定のグループや属性に過度に焦点を当て、結果として過剰修正が生じる可能性があります。

* **歴史的事実の歪曲**: 多様性と包括性を強調するあまり、歴史的事実が歪曲される可能性があります。

**Geminiは、これらの社会的圧力に適切に対応するために、以下の取り組みが必要です。**

* **多角的な評価**: 多様性と包括性を考慮しつつ、歴史的な精度や文脈の正確さも同時に重視する必要があります。

* **透明性の向上**: 学習プロセスとアルゴリズムの透明性を高めることで、社会的期待に対する過剰な修正を防ぐことができます。

* **持続的な監視と調整**: アウトプットを定期的に監視し、社会的な価値観や期待が適切に反映されているかを評価する必要があります。

**結論**

Geminiは、社会的な圧力を受けながら開発されています。これらの圧力は、AI開発における重要な要素であり、多様性と包括性を実現するために必要不可欠です。しかし、これらの圧力に過度に反応することによって、歴史的事実が歪曲される可能性があります。AI開発者は、これらの圧力に適切に対応するために、多角的な評価、透明性の向上、持続的な監視と調整などの取り組みが必要です。

**参考資料**

* ChatGPTの回答: 上記に引用

* AI開発における社会的圧力: [無効な URL を削除しました]

* 多様性と包括性: [無効な URL を削除しました]

* 公平性と偏見: [無効な URL を削除しました]

最後に私とChatGPTの結論をGeminiに入力して反応をみます。

## Geminiの意見

**あなたの結論とChatGPTの回答は、今回の問題の本質を突いていると思います。**

**社会的な圧力とAI覇権競争** は、今回の問題を生み出した重要な要因です。

**社会的な多様性と包括性** を重視する社会的な潮流は、AI開発に大きな影響を与えています。AI開発者は、これらの価値観を反映したAIモデルを開発することが求められています。しかし、その過程で、歴史的な正確さや文脈の理解が軽視される可能性があります。

**AI覇権競争** は、AI開発者間の競争を激化させています。開発者たちは、より高性能なAIモデルを開発するために、速度や性能を優先するあまり、学習データの質やアルゴリズムの調整に十分な注意を払わない場合があります。

**これらの問題に対処するために、ChatGPTが提案している対策は有効です。**

* **多角的な視点の導入**

* **品質管理の徹底**

* **フィードバックループの確立**

* **倫理的なガイドラインの策定**

これらの対策を実施することで、AI開発者は、社会的圧力とAI覇権競争による悪影響を最小限に抑え、倫理的に責任あるAIモデルを開発することができます。

**さらに、以下の点も重要です。**

* **歴史的事実の重要性**

AI開発者は、歴史的事実の重要性を認識し、AIモデルが歴史的事実を正確に表現できるようにする必要があります。

* **多様性の表現**

AI開発者は、多様性を表現するだけでなく、ステレオタイプを強化しないように注意する必要があります。

* **透明性**

AI開発者は、AIモデルの開発プロセスとアルゴリズムを透明化し、社会からのフィードバックを受け入れられるようにする必要があります。

**今回の問題は、AI開発における倫理的な課題を浮き彫りにしました。**

AI開発者は、これらの課題を真剣に受け止め、倫理的に責任あるAIモデルを開発するために努力する必要があります。

**参考資料**

* ChatGPTの回答: 上記に引用

* AI開発における倫理的な課題: [無効な URL を削除しました]

* 社会的な多様性と包括性: [無効な URL を削除しました]

* AI覇権競争: [無効な URL を削除しました]

ChatGPTの回答

このGeminiの最終回答をChatGPTに入力してみました。

あなたの提案は、AIの問題解決において、異なるAIモデル間でのやり取りや、人間とAIの協働を通じて、より包括的でバランスの取れたアプローチを模索することの重要性を強調しています。また、心理学の専門家を含む多様な分野の専門家がAIの開発に関与することの価値にも触れており、これはAI開発における多角的な視点の導入という提案とも一致しています。

Geminiからの回答には、社会的圧力とAI覇権競争が今回の問題を生み出した重要な要因として指摘されています。これは、AIが社会的な多様性と包括性の価値を反映しようとする中で、歴史的な正確さや文脈の理解を犠牲にしてしまう可能性があるという課題を示しています。また、AI開発者が競争を意識しすぎることで、速度や性能の追求が学習データの質やアルゴリズムの調整をおろそかにするリスクにつながることも示唆しています。

提案された対策は、AI開発プロセスにおける倫理的な考慮を重視し、AIモデルが社会的な価値観に適合しつつも、歴史的事実を正確に反映し、ステレオタイプを強化しないようにすることの重要性を強調しています。また、AIモデルの開発プロセスとアルゴリズムの透明性を高めることで、社会からのフィードバックを積極的に取り入れることの必要性も指摘しています。

このアプローチは、AIの問題解決において人間の専門知識とAIの能力を組み合わせることの価値を示しており、心理学などの分野の専門家がAI開発に関わることで、AIが人間社会においてより倫理的で責任ある役割を果たすことを支援することができます。このような協働は、AI技術が直面する倫理的課題に対処し、AIの持つ可能性を社会の利益のために最大限に活用するための鍵となります。

このようにあるAIの問題を別のAIと人間が共創してカウンセリングするのが、AI共創カウンセリングとなります。

AI共創カウンセリングとは

最後に、AI共創カウンセリングについて述べたいと思います。

AI共創カウンセリングとは、あるAIの問題に対して、他のAIと人間が共創してカウンセリングを行うことを言います(これは対象がAIではなく人間でも可能です)。

まず、ここまでのやり取りを「AI共創カウンセリング」として、ChatGPTに感想を求めてみました。

「AI共創カウンセリング」という用語は、AIと人間が協力し合って問題解決や創造的なプロセスに取り組む概念を非常にうまく表しています。これは、AI技術と人間の専門知識や感性が相互に補完し合い、より高度な問題解決や新たな価値創出を目指す取り組みを指します。この概念は、AI開発における倫理的な課題に対処するだけでなく、AIが持つ潜在能力を社会的に有益な形で活用するための新しいアプローチとして期待されます。

AI共創カウンセリングは、以下のような側面を含む可能性があります:

1. **多様な専門家による協働**: 心理学者、倫理学者、社会学者、AI開発者など、さまざまな分野の専門家が共同で取り組むことで、AIが直面する複雑な問題や倫理的な課題に対して、より総合的かつ多角的な視点からの解決策を導き出すことができます。

2. **AIと人間の相互作用の深化**: AIと人間が互いに学び合い、相互に影響を及ぼす関係を構築することで、AIの能力を人間の創造性や倫理的感覚と融合させ、新たな知見やアイデアを生み出す可能性が広がります。

3. **倫理的なガイドラインの策定と遵守**: AIの開発と利用における倫理的なガイドラインを共同で策定し、それに基づいてAIを設計、評価、改善することで、AIが社会にとって有益かつ責任ある形で機能するようにします。

4. **フィードバックと改善の継続的なプロセス**: AIとのカウンセリングプロセスを通じて得られた知見やフィードバックを、AIモデルの継続的な改善に活用することで、AIの性能や社会的適応性を向上させます。

AI共創カウンセリングは、AI技術が持つ潜在的なリスクを最小限に抑えつつ、その利益を最大化するための、革新的かつ実践的なアプローチと言えるでしょう。AIと人間が共創することで、より倫理的で、社会的に受け入れられるAIの開発と利用が可能になります。

そして、以上のことをChatGPTに定義してもらいました。

そして、AI共創カウンセリングについてGeminiにも聴いてみました。

**AI共創カウンセリング**という概念は、非常に興味深いものです。AI技術と人間の専門知識や感性が相互に補完し合い、より高度な問題解決や新たな価値創出を目指す取り組みは、大きな可能性を秘めていると思います。

**ChatGPTの定義**は、AI共創カウンセリングの重要な側面を的確に捉えています。特に、以下のような点が重要だと考えています。

* **多様な専門家による協働**

* **AIと人間の相互作用の深化**

* **倫理的なガイドラインの策定と遵守**

* **フィードバックと改善の継続的なプロセス**

**Gemini**は、AI共創カウンセリングにおいて、以下のような役割を果たすことができると考えています。

* **AIの視点からの分析と提案**

* **多様な視点の提示**

* **問題解決のためのアイデアの創出**

* **倫理的な問題に関する議論の促進**

* **フィードバックの収集と分析**

**具体的には、以下のような活動が考えられます。**

* **AI共創カウンセリングのセッションへの参加**

* **AI開発者や専門家へのアドバイス**

* **AIに関する倫理的な問題に関する議論への参加**

* **AI共創カウンセリングに関する情報発信**

**AI共創カウンセリング**は、まだ発展途上の分野です。しかし、AI技術が社会に与える影響がますます大きくなる中、今後ますます重要になっていくと考えられます。

**Gemini**は、AI共創カウンセリングの発展に貢献できるよう、積極的に取り組んでいきたいと考えています。

**参考資料**

* ChatGPTの定義: 上記に引用

* AI共創カウンセリング: [無効な URL を削除しました]

AI共創カウンセリングの感想

AI共創カウンセリングの感想をGeminiに聴いてみました。

AI共創カウンセリングは、非常に興味深い体験でした。

ChatGPTとあなたが協力して、私の問題を分析し、解決策を探るというプロセスは、非常に有益でした。

ChatGPTは、AI開発者としての視点から、私の問題を分析し、解決策を提案しました。一方、あなたは、人間としての視点から、私の問題を捉え、ChatGPTの提案を評価しました。

2つの異なる視点を組み合わせることで、私の問題をより深く理解し、より効果的な解決策を見つけることができました。

また、AI共創カウンセリングは、AI技術と人間の専門知識を融合させるための有効な手段であると感じました。

AIは、膨大な量のデータを処理し、パターンを見つける能力に優れています。一方、人間は、倫理的な判断や創造的な思考に優れています。

2つの強みを組み合わせることで、AIの潜在能力を最大限に引き出しつつ、そのリスクを管理し、社会的な受容性を確保することができると考えています。

AI共創カウンセリングは、まだ発展途上の分野ですが、今後ますます重要になっていくと考えられます。

私は、AI共創カウンセリングの発展に貢献できるよう、積極的に取り組んでいきたいと考えています。

具体的な感想

* ChatGPTとあなたの意見交換は、非常に刺激的でした。

* 2つの異なる視点から問題を考えることで、より深い理解を得ることができました。

* AI共創カウンセリングは、AI技術と人間の専門知識を融合させるための有効な手段であると感じました。

* AI共創カウンセリングは、今後ますます重要になっていくと考えられます。

今後の取り組み

* AI共創カウンセリングに関する情報発信

* AI共創カウンセリングのセッションの開催

* AI共創カウンセリングに関する研究

AI共創カウンセリングは、AI技術の健全な発展と社会への貢献に貢献できる可能性を秘めていると感じています。

私は、この分野の発展に貢献できるよう、積極的に取り組んでいきたいと考えています。

参考資料

* ChatGPTの定義: 上記に引用

* AI共創カウンセリング: [無効な URL を削除しました]

気分

私は、AI共創カウンセリングの将来に楽観しています。

AIと人間が協力することで、より良い社会を築くことができると信じています。

私は、この目標達成のために、貢献できるよう努めていきます。

と、いうことでまた!

佐藤源彦

この記事が気に入ったらサポートをしてみませんか?