【AI】EU AI Actが2024年3月13日欧州議会において採択!?

本稿のねらい

2024年3月13日、足掛け3年近い歳月を要し、欧州議会(European Parliament)がArtificial Intelligence Act(AIA)を採択した。

AIAは、その第113条に従い、2024年5月から7月にかけて官報("the official Journal")に掲載され、掲載から20日後に発効し、原則として発効日から2年で施行されるが、禁止AI("Prohibited Artificial Intelligence")や汎用AI("General Purpose AI Models": GPAI)などの一部の規定は次のとおり2024年末から2027年夏までに段階的に施行される予定である。

第Ⅰ章・第Ⅱ章:発効日から6か月で施行

第Ⅲ章§4・第Ⅴ章・第Ⅶ章・第Ⅻ章:§101を除き発効日から12か月で施行

第6条(1)とこれに対応する義務:発効日から36か月で施行

時をだいたい同じくして、我が国でも総務省・経済産業省の連名で「AI事業者ガイドライン(第1.0版)」が取りまとめられ、公表された(経産省ウェブサイト)。

※どうでもいいが、各新聞社はAI事業者ガイドラインではなく「事業者向け指針」や「事業者指針」などと勝手に呼称しており、「AI事業者ガイドライン」では検索に引っ掛からない。

そこで、まずは本稿においてAIAの概要をまとめ、次に我が国のAI事業者ガイドラインの概要をAIAと比較しながらまとめることを予定している。

なお、本稿ではAIAの議論が開始された当初からの歴史的な背景等については基本的に触れない予定である(あまりに長くなるため)。

【参考】AIA関連の過去のDocuments集らしい ※もし興味あれば

AIAの構造

AIAの条文構造は次のとおりであるが、長いのは前文のみで、Chapter 1から13までは全113条であり、比較的コンパクトな法律といえる。筆者の主観で重要と思われるものに★を付けている。

前文

CHAPTER 1:GENERAL PROVISIONS

CHAPTER 2:PROHIBITED ARTIFICIAL INTELLIGENCE PRACTICES★

CHAPTER 3:HIGH-RISK AI SYSTEMS★

CHAPTER 4:TRANSPARENCY OBLIGATIONS FOR PROVIDERS AND DEPLOYERS OF CERTAIN AI SYSTEMS★

CHAPTER 5:GENERAL-PURPOSE AI MODELS★

CHAPTER 6:MEASURES IN SUPPORT OF INNOVATION

CHAPTER 7:GOVERNANCE

CHAPTER 8:EU DATABASE FOR HIGH-RISK AI SYSTEMS

CHAPTER 9:POST-MARKET MONITORING, INFORMATION SHARING, MARKET SURVEILLANCE

CHAPTER 10:CODES OF CONDUCT AND GUIDELINES

CHAPTER 11:DELEGATION OF POWER AND COMMITTEE PROCEDURE

CHAPTER 12:PENALTIES★

CHAPTER 13:FINAL PROVISIONS

ANNEX1〜13

【参考】AIA全文 ※誰も読まないと思うが

https://www.europarl.europa.eu/doceo/document/TA-9-2024-0138_EN.pdf

AIAの概要

(1)AIAの目的

欧州理事会や欧州議会が示しているように、基本的には、AIが基本的権利等を侵害しないようにすることと、AIを含むイノベーションを発展させることがAIAの目的とされている。いうまでもなく、AIAの理解において重要なのは前者である。以下で説明するリスクベースド・アプローチもAIによる健康・安全・基本的権利に対するリスクへの対応に関するものである。

The aim of the new rules is to foster trustworthy AI in Europe and beyond, by ensuring that AI systems respect fundamental rights, safety, and ethical principles and by addressing risks of very powerful and impactful AI models.

It aims to protect fundamental rights, democracy, the rule of law and environmental sustainability from high-risk AI, while boosting innovation and establishing Europe as a leader in the field.

The regulation establishes obligations for AI based on its potential risks and level of impact.

(2)AIAのルール

AIAは次のルールを示すものである(European Commission"AI Act")。

後に見るように、多くのルールは高リスクAIシステム関連である。

address risks specifically created by AI applications; AI アプリケーションにより特に生じるリスクへの対応

prohibit AI practices that pose unacceptable risks; 許容できないリスクをもたらすAIの使用を禁止

determine a list of high-risk applications; 高リスクアプリケーションリストの決定

set clear requirements for AI systems for high-risk applications; 高リスクアプリケーションに対するAIシステムへの明確な要件定義

define specific obligations deployers and providers of high-risk AI applications; 高リスクアプリケーションのデプロイヤ("deployer")及びプロバイダ("provider"の定義は後述)の具体的な義務の定義

require a conformity assessment before a given AI system is put into service or placed on the market; 特定のAIシステムが運用に供され又は上市される前の適合性評価の義務付け

put enforcement in place after a given AI system is placed into the market; 特定のAIシステムが上市された後の執行

establish a governance structure at European and national level. 欧州及び国家レベルにおけるガバナンス体制の確立

(3)ルールの適用対象者

プロバイダ("provider")とデプロイヤ("deployer")

説明は後述(⇛リスクベースド・アプローチ(2)HIGH RISKへ)

リスクベースド・アプローチ

AIAの基本的な発想はリスクベースド・アプローチ(risk-based approch)であり、AIAにおいては4段階のリスクにカテゴライズされている。

なお、AIAでいうリスク("risk")とは、害悪が生じる可能性とその重大性の組み合わせ("the combination of the probability of an occurrence of harm and the severity of that harm")であるとされており(第3条第2号)、リスクマネジメントの文脈における意味と同じである。

※2021年時点の情報であるためあくまで参考

以下では、この4つのリスクカテゴリについて簡単に説明する。

(1)UNACCEPTABLE RISK(許容できないリスク)

AIA第5条第1項によると、次の8つのAIシステムの使用は禁止される。

(a)行動操作系AIシステム

人の意識を超えたサブリミナルな技法又は意図的に操作的もしくは欺瞞的な技法を展開するAIシステムを使用し、十分な情報に基づいた意思決定を行う能力を著しく損なうことにより、人の行動を実質的に歪め、それにより人に損害を与える方法で、本来その人が行わなかったであろう意思決定をさせるもの。

(b)脆弱性悪用系AIシステム

年齢・障害・一定の社会的/経済的状況に起因する脆弱性を悪用するAIシステムを使用し、人の行動を、重大な危害をもたらす方法で著しく歪めるもの。

(c)スコアリング系AIシステム

社会的行動や個人的特徴などに基づき算出される社会的スコアを①データが生成・収集された当初の文脈と関係ない文脈において人が不利益を受ける又は/及び②その社会的行動や重大性に釣り合わない不利益を受けるAIシステムを使用すること。

(d)犯罪予測系AIシステム

人が罪を犯す可能性を予測するため、プロファイリング又は人格的特徴の評価のみに基づきリスク評価を行うAIシステムを使用すること。ただし、犯罪に直接関連する客観的かつ検証可能な事実に基づき、犯罪への関与に関する評価を支援するために使用することは禁止されない。

(e)顔認証データベース作成系AIシステム

インターネットやCCTV映像から無制限(無差別)に顔画像をスクレイピングし、顔認証データベースを作成・拡張するAIシステムを使用すること。

(f)感情認識系AIシステム

職場や教育施設において感情を認識するAIシステムを使用すること。ただし、医療又は安全目的での使用は禁止されない。

(g)センシティブ情報推知系生体認証分類システム

人種・政治的見解・労働組合加入・宗教的/哲学的信条・性生活・性的指向を認識する生体認証分類システムを使用すること。ただし、法執行分野における生体認証データに基づく、データセットのラベル付け、フィルタリング、又は生体認証データの分類は禁止されない。

(h)リアルタイム生体認証システム

法執行目的による、公共のアクセス可能な空間におけるリアルタイムで遠隔生体認証システムを使用すること。ただし、①拉致・人身売買等の被害者の捜索、②具体的に差し迫ったテロ等の防止、③ANNEX2に示される重罪につき法執行のための被疑者の特定といった目的のために必要不可欠な場合には使用は禁止されない。

なお、リアルタイム生体認証システムは、特に時間的・地理的・個人的制限に関し、その使用を許可する加盟国の国内法に従い、必要かつ相応の保護措置と条件を遵守しなければならないとされていることに加え(AIA第5条第2項後段)、原則として司法当局の事前許可が必要であるとされている(同条第3項前段)。AIA第5条の他の項は基本的にリアルタイム生体認証システムに関するものとなっており、このシステムが捜査機関等により濫用されることを特に懸念していることが伺える。

(2)HIGH RISK(高リスク)

AIAにおける基本的な発想は、安全や基本的権利に危害を加える可能性があるAIシステムを高リスクとみなすというものである。ANNEX3において高リスクとみなされるAIシステムが列挙されており、AI技術の進展とともに改正されていくものである。

A limited number of AI systems defined in the proposal, potentially creating an adverse impact on people's safety or their fundamental rights (as protected by the EU Charter of Fundamental Rights), are considered to be high-risk.

高リスクAIシステム

AIAにおいては、次の2つの条件をいずれも満たすAIシステムは高リスク("high-risk")とみなされるほか(第6条第1項)、上記のとおりANNEX3に記載のあるAIシステムも同じく高リスクとみなされる(同条第2項)。

(a)条件1

①製品の安全装置として使用されることが意図されているAIシステム*

又は

②ANNEX1に列挙されたEU整合法令("the Union harmonisation legislation")が適用される製品としてのAIシステム

*ロボット支援手術におけるAIアプリケーションが想定されている("e.g. AI application in robot-assisted surgery")。

(b)条件2

①(a)を満たすAIシステムが安全装置として組み込まれている製品

又は

②ANNEX1に列挙されたEU整合法令に従った製品の上市を企図して第三者適合性評価を受ける必要がある製品としてのAIシステム

【参考】EU整合法令とは

EU 整合法令(Union harmonisation legislation)は、EU で製品を流通させるにあたり、特定分野の製品が満たすべき要件を EU 指令や規則によって調和(ハーモナイゼーション)しているものを指し、現在70分野の指令・規則がある。EU市場にオンライン・オフラインを問わず上市される製品の法令遵守と市場監視に関して、事業者の当局への協力などを定めた新たな欧州議会・理事会規則2019/1020が2019年6月20 日に発効し、市場監視と法令遵守に関する事業者の責任を定めた。新たに EEA 内の事業者の責任要件を追加し、2021年7月16日から施行される。EU規則2019/1020は、第5項に記載される18指令・規則の製品分野について適用される(表1参照)。これらはすべてCEマークの対象である。

ANNEX3に列挙されている高リスクAIシステムの項目は次のとおりであり、これらは「健康、安全、基本的権利、環境、民主主義、法の支配に重大な危害を及ぼし得るもの」である(西村あさひ法律事務所「欧米におけるAIガバナンスの最新動向(1)AI Act案の政治的合意」1頁)。なお、AIA第6条第6項や第7条も参照。

Biometrics, in so far as their use is permitted under relevant Union or national law(許容されている生体認証)

Critical infrastructure(重要インフラ)

Education and vocational training(教育・職業訓練)*

Employment, workers management and access to self-employment(雇用・労働者管理・自営業へのアクセス)**

Access to and enjoyment of essential private services and essential public services and benefits(必要不可欠な民間/公共サービスへのアクセス)***

Law enforcement, in so far as their use is permitted under relevant Union or national law(許容されている法執行)****

Migration, asylum and border control management, in so far as their use is permitted under relevant Union or national law(移民・亡命・国境管理)

Administration of justice and democratic processes*****(司法・民主手続管理)

*試験の採点、不正行為の監視など

**ターゲットを絞った求人広告掲載、採用手続用の履歴書分類ソフトウェアなど

***医療へのアクセス、信用スコアリングにより国民が融資を受ける機会を拒否するなど

****証拠の信頼性の評価など

*****裁判所の判決を検索するためのAIソリューションなど

(以上、European Commission "Shaping Europe’s digital future"、European Commission "Artificial Intelligence – Questions and Answers*"から引用)

ただし、ANNEX3に列挙されているとしても、AIシステムの目的が次の4点のいずれかに該当し、かつ、AIシステムが、人の意思決定の結果に重大な影響を与えないことを含め、人の健康・安全・基本的権利に危害を及ぼす重大なリスクを招来しない場合は、高リスクとはみなされないものとされる(AIA第6条第3項前段)。なお、この適用除外については、ANNEX3に列挙されているAIシステムに該当するものの、自然人の健康・安全・基本的権利に重大な危害を及ぼす危険性のないAIシステムの存在について、具体的かつ信頼できる証拠がある場合、又は、EUにおける健康・安全・基本的権利の保護水準を維持するために必要であるという具体的かつ信頼できる証拠がある場合、欧州委員会がAIA第97条に従い、追加・修正・削除が可能である(AIA第6条第6項)。

(a)狭い手続的事務処理の実行

(b)以前人間が完成させた成果の改善

(c)意思決定パターンや以前の意思決定パターンの逸脱の検知(人によるレビューなく、以前人間が下した評価を置き換えたり影響したりすることを意図しない)

(d)ANNEX3に列挙されているユースケースに関する評価の準備作業

AIシステムのプロバイダ("provider")は、ANNEX3に列挙されるAIシステムが高リスクではないと考える場合、当該AIシステムが上市される前に,その評価を文書化しなければならず、当該プロバイダは,AIA第49条第2項に定める登録義務の対象となる(AIA第6条第4項)。

なお、AIA第6条第3項前段の要件を満たすとしても、AIシステムが人のプロファイリングを行う場合は、常に高リスクとみなされる(同項後段)。

欧州委員会は、遅くとも発効日から18か月以内に、AIA第96条に従い、AIA第6条を実施するためのガイドラインと高リスク/非高リスクAIシステムのユースケースの包括的なリストを提供するとされている(同条第5項)。

高リスクAIシステムに課される要求

高リスクAIシステムは、Section2 "Requirements for high-risk AI systems"(第8条から第15条)に定められる要求に遵守しなければならない(AIA第8条第1項)。

その際、高リスクAIシステムに意図された目的、一般に認知される最先端のAIやAI関連技術のほか、AIA第9条のリスクマネジメントシステム(リスクの特定・分析・評価・対応のステップ)を考慮にいれる必要がある (AIA第8条第1項)

データを用いたAIモデルのトレーニングを伴う技術を利用する高リスクAIシステムは、潜在的なバイアスを検知するための措置が講じられ、意図された目的と関連性があり、エラーがないなどの品質基準を満たすデータセットの訓練・検証・テストに基づいて開発されなければならない(AIA第10条第1項)

高リスクAIシステムの技術文書は、当該AIシステムが上市される前に、ANNEX4に定められる要素を含む形で作成され、かつ、最新の状態に保たれなくてはならない(AIA第11条第1項)*

高リスクAIシステムは、当該AIシステムの存続期間中、イベント("logs")が自動記録されるように保持しなければならない(AIA第12条第1項)

高リスクAIシステムは、deployersがシステムのアウトプットを解釈して適切に使用できるよう、その運用が十分に透明であることを保証する方法で設計・開発されなければならない(AIA第13条第1項)

高リスクAIシステムには、適切なデジタル形式又はdeployersにとって関連性がありアクセス可能で理解しやすい、簡潔、完全、正確かつ明確な情報を含む使用説明書が添付されなければならない(AIA第13条第2項)

この使用説明書には、少なくとも、プロバイダの連絡先、高リスクAIシステムの特徴・性能・限界(AIA第15条に定められる堅牢性やセキュリティ精度等を含む)、AIA第14条に定められる人間による監視措置、AIシステムの機能角のために必要な保守等、ログの適切な収集・保存等を可能にする仕組みの説明が含まれていなければならない(AIA第13条第3項)

高リスクAIシステムは、適切なヒューマン・マシン・インターフェイス・ツールを含め、使用期間中は人間によって効果的に監視できるような方法で設計・開発されなければならない(AIA第14条第1項)

高リスクAIシステムは、適切なレベルの精度・堅牢性・サイバーセキュリティを達成し、ライフサイクル全体を通じて一貫した機能を発揮するように設計・開発されなければならない(AIA第15条第1項)

*SMEはANNEX4に定められた技術文書の要素を簡易な方法で作成できる(欧州委員会はSME用の書式を定める)。

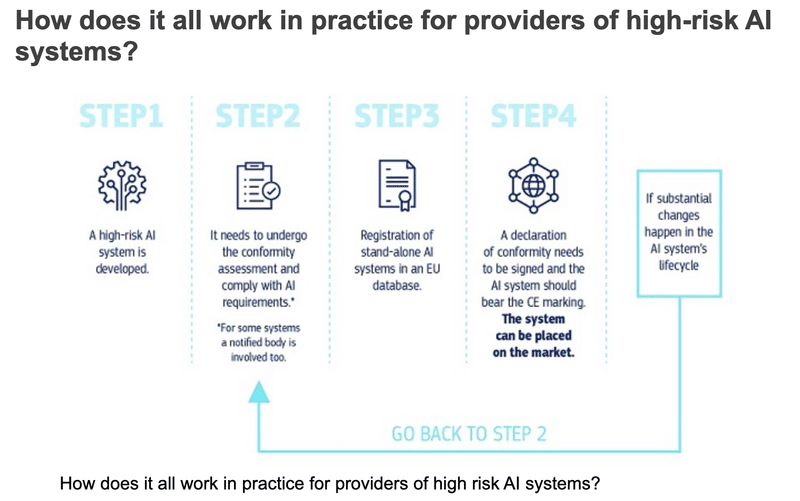

高リスクAIシステムプロバイダに課される義務

高リスクAIシステムプロバイダは、当該システムを上市する前後を問わず、要件準拠を確保し、影響を受ける人のリスクを最小限に抑えるために、品質管理システムを導入する必要がある(AIA第16条)。

高リスクAIシステムがSection2に定められる要件に準拠していることを確認する

高リスクAIシステムそれ自体、パッケージ又は附属文書に、名称や連絡先等を表示する

AIA第17条に準拠した品質管理システムを導入する

AIA第18条に定められる文書を保存する

AIA第19条に従い高リスクAIシステムにより自動的に生成されたログを保管する

高リスクAIシステムが上市される前に、AIA第43条に定められる適合性評価手続を受けることを確保する

AIA第47条に従いEU適合宣言("EU declaration")を作成する

AIA第48条に従い、高リスクAIシステムそれ自体又は附属文書に、AIAの適合を示すCEマーキングを貼付する

AIA第20条で要求される必要な是正措置を講じ、情報を提供する

国の合理的な要請に応じて、高リスクAIシステムがSection2に定められる要件に準拠していることを証明する

高リスクAIがDirectives (EU) 2016/2102 と Directives (EU) 2019/882に従ったアクセシビリティ要件に準拠していることを確認する

なお、AIAにおけるプロバイダ("provider")は、次のとおり、AIシステムや汎用AIモデル(GPAI)の開発者のみならず、それらを開発させ、有償無償を問わず、自己の名称又は商標でAIシステムを上市する者を指す(AIA第3条第3号)。

‘provider’ means a natural or legal person, public authority, agency or other body that develops an AI system or a general-purpose AI model or that has an AI system or a general-purpose AI model developed and places it on the market or puts the AI system into service under its own name or trademark, whether for payment or free of charge

高リスクAIシステムのデプロイヤに課される義務

高リスクAIシステムのデプロイヤは、AIA第26条第3項から第6項に従い、当該AIシステムに付帯する使用説明書どおりに当該AIシステムを使用することを確保するべく、適切な技術的・組織的措置を講じなければならない(同条第1項)。

高リスクAIシステムの運用における人間の監視

AIA第72条に従いプロバイダへ通知

使用説明書に沿った高リスクAIシステムの使用がAIA第79条第1項のリスク(※健康・安全へのリスク)をもたらす可能性があると判断した場合、遅滞なく、プロバイダや当局に通知し、当該AIシステムの使用を停止する

重大なインシデントを特定した場合、ただちに、第1にプロバイダに、第2に輸入業者又は販売業者そして当局に通知する

高リスクAIシステムにより自動生成されたログを少なくとも6か月間は保存する

高リスクAIシステムを職場において使用開始する前に、使用者(デプロイヤ)は、労働者が当該AIシステムの使用対象となることを、労働者の代表と影響を受ける労働者に通知する

(適用ある場合)GDPR第27条のPIA実施義務を履行するため、AIA第13条に基づき提供される情報を使用する

人に関する意思決定を行う又は意思決定を支援する高リスクAIシステムでANNEX3に列挙されているものを使用する場合、当該AIシステムの使用対象であることをその人に通知する

なお、AIAにおけるデプロイヤ("deployer")は、次のとおり、権限に基づきAIシステムを使用(ただし個人的かつ非専門的活動の過程で利用する場合を除く)する者を指す(AIA第3条第4号)。要するに、消費者としてのエンドユーザーはデプロイヤではなく、商業的ないし専門的な立場でAIシステムを使用する者がデプロイヤに該当する。

‘deployer’ means a natural or legal person, public authority, agency or other body using an AI system under its authority except where the AI system is used in the course of a personal non-professional activity

(3)LIMITED RISK(限定的リスク)

AIAにおいて"limited risk"の定義がされているわけではないが、前文第53項において、意思決定の結果に重大な影響を与えないAIシステムとして、人為的か自動的かを問わず、意思決定の実質、ひいては結果に影響を与えないAIシステム、つまり次のいずれかに該当するものを指すとされている。

狭い手続上のタスクを実行することを意図し、ANNEX3に列挙されている高リスクの用途において増加することのない、狭く限定されたもの

AI システムによって実行されるタスクが、以前に人が完了させた活動の結果を改善することを目的としているもの

これらは、AIA第6条第3項前段(a)と(b)に相当する高リスクAIシステムから除外されるものと重複する。

このように高リスクAIシステムと比較して限定的なリスクのみのAIシステムに関しては、透明性義務("transparency obligations")のみ課されている。

透明性義務を定めるAIA第50条は4つの場面を想定し、それぞれの場面において、開示された情報に基づいて続行するか撤退するかを決定できるようにする必要があり、遅くとも、最初のやりとりの時点又は最初にAIシステムに晒される時点で、明確かつ区別可能な方法で、関係する人に開示されなければならない(同条第5項)。

AIチャットシステム:プロバイダは、状況や文脈を考慮し、合理的に十分な知識と観察力があり、思慮深い人から見て明らかな場合を除き、人がAIシステムと対話することを知らされるような方法で設計・開発されることを確保しなければならない(AIA第50条第1項)

音声・画像・映像・テキスト生成AIシステム:合成音声・画像・映像又はテキストコンテンツを生成する汎用AIシステム(GPAI)を含むAIシステムのプロバイダは、AIシステムの出力が、機械可読形式で表示され、かつ、人工的に生成・加工されたものであることが検知可能であることを確保しなければならない。また、同プロバイダは、様々な種類のコンテンツの特殊性・制限、実装コスト、一般に認知され、関連する技術標準に反映され得る最先端技術を考慮し、技術的に実現可能な限りにおいて、その技術的解決が効果的、相互運用可能、堅牢、信頼可能であることを確保しなければならない。なお、この義務は、AIシステムが標準的な編集のための補助機能を実行する場合、又はデプロイヤが提供した入力データ・セマンティクスを実質的に変更しない場合には適用されない。(AIA第50条第2項)

感情認識システム・生体分類システム:プロバイダは、感情認識システム(※人の生体データに基づいて、感情や意図を識別・推論することを目的とするAIシステム(AIA前文第18項))又は「生体分類システム」(※人を生体データに基づいて特定のカテゴリに分類するシステムであり、性別・年齢・髪の色・目の色・タトゥー・行動や性格の特徴・言語・宗教・少数民族・性的指向・政治的指向などのカテゴリがある(AIA前文第16項))に晒される人にシステム運用を通知し、(適用がある場合)GDPRに従って個人データを処理しなければならない。(AIA第50条第3項)

ディープフェイク画像・音声・映像生成AIシステム:プロバイダは、ディープフェイクを構成するコンテンツが人工的に生成・加工されたものであることを開示しなければならない(いわゆる「警告ラベル付け」)。なお、当該コンテンツが、明らかに芸術的・創作的・風刺的・フィクション的な類似作品の一部を構成する場合、本項の透明性義務は、当該作品の展示・享受を妨げない適切な方法で、生成・加工されたコンテンツの存在を開示することに限定される。(AIA第50条第4項前段)

公共性のあるテキスト生成AIシステム:公共の関心事について公衆に知らせる目的で公表されるテキストを生成・加工するAIシステムのデプロイヤは、当該テキストが人工的に生成・加工されたものであることを開示しなければならない。なお、この義務は、AIが生成したコンテンツが人によるレビューや編集管理を経て、コンテンツの公表につき編集責任を有する場合には適用されない。(AIA第50条第4項後段)

Limited risk refers to the risks associated with lack of transparency in AI usage. The AI Act introduces specific transparency obligations to ensure that humans are informed when necessary, fostering trust. For instance, when using AI systems such as chatbots, humans should be made aware that they are interacting with a machine so they can take an informed decision to continue or step back. Providers will also have to ensure that AI-generated content is identifiable. Besides, AI-generated text published with the purpose to inform the public on matters of public interest must be labelled as artificially generated. This also applies to audio and video content constituting deep fakes.

(4)MINIMAL RISK(最小リスク)

(1)から(3)以外のAIシステムは、国民の権利や安全に対するリスクが最小限又は皆無であるため、基本的には自由な使用が認められており、現時点でEUで使用されているAIシステムの多くはこのカテゴリに属するとされている。例:AI対応Video Gameやスパムフィルター

なお、このAIシステムのプロバイダは、自主的に信頼できるAIシステムの要件を適用し、かつ、自主的な行動規範を遵守することを選択できる。

Minimal risk: All other AI systems can be developed and used subject to the existing legislation without additional legal obligations. The vast majority of AI systems currently used or likely to be used in the EU fall into this category. Voluntarily, providers of those systems may choose to apply the requirements for trustworthy AI and adhere to voluntary codes of conduct.

汎用AIモデル("GPAI")

(1)定義

「汎用AIモデル」とは、AIモデルが大規模な自己教師を使用した大量のデータで学習される場合を含め、有意な汎用性を示し、そのモデルが上市される方法に関係なく、異なるタスクを広範囲で適切に実行することができ、様々な下流システム又はアプリケーションに統合可能なAIモデルを意味する(ただし、上市前の研究・開発・プロトタイピングに使用されるAIモデルは除く)(AIA第3条第63号)。

‘general-purpose AI model’ means an AI model, including where such an AI model is trained with a large amount of data using self-supervision at scale, that displays significant generality and is capable of competently performing a wide range of distinct tasks regardless of the way the model is placed on the market and that can be integrated into a variety of downstream systems or applications, except AI models that are used for research, development or prototyping activities before they are released on the market

また、汎用AIモデルに基づくAIシステムで、直接使用することはもちろん、他のAIシステムと統合することも可能な機能を備えるものを「汎用AIシステム」という(同条第66号)。

‘general-purpose AI system’ means an AI system which is based on a general-purpose AI model, that has the capability to serve a variety of purposes, both for direct use as well as for integration in other AI systems

なお、汎用AIモデルのうち、次のいずれかの要件を満たす場合、システミックリスクを伴う汎用AIモデル("general-purpose AI model with systemic risk")に分類されることになる(AIA第51条第1項)。

‘systemic risk’ means a risk that is specific to the high-impact capabilities of general-purpose AI models, having a significant impact on the Union market due to their reach, or due to actual or reasonably foreseeable negative effects on public health, safety, public security, fundamental rights, or the society as a whole, that can be propagated at scale across the value chain

(a)高い影響力を持つこと("high-impact capabilities")

‘high-impact capabilities’ means capabilities that match or exceed the capabilities recorded in the most advanced general-purpose AI models;

この点、浮動小数点演算("floating-point operation": FLOPs)で測定された学習に用いられた累積計算量が 10^25を超える場合、高い影響力を有すると推定される(AIA第51条第2項)。このしきい値は欧州委員会により適宜最新技術が反映される(同条第3項)。

この現在のしきい値10^25は、Open AI社のGPT-4とGoogle DeepMind社のGeminiを把握するための数値とされている。

This threshold captures the currently most advanced GPAI models, namely OpenAI's GPT-4 and likely Google DeepMind's Gemini.

(b)ANNEX13の基準を考慮し(a)同等の能力/影響力を持つこと

現時点のANNEX13では、モデルのパラメータ数、データセットの品質・サイズ(トークン)、モデル学習の計算量(FLOPs等により測定)、モデルの入力・出力のモダリティ("modality")、追加学習を必要としないタスク数、登録ユーザー数などが基準として列挙されている。

(2)汎用AIモデルの規制

システミックリスクを伴う汎用AIモデル

汎用AIモデルがAIA第51条第1項の要件を満たす場合、プロバイダは、遅滞なく2週間以内に欧州委員会に届け出なければならない(AIA第52条第1項)。

なお、プロバイダは、汎用AIモデルがAIA第51条第1項の要件を満たすものの、例外的に、当該モデルの特性によりシステミックリスクを示さず、システミックリスクを伴う汎用AIに分類されるべきではないことを証明することにより分類を免れることは可能である(AIA第52条第2項)。

欧州委員会は、自ら又は科学パネル("the scientific panel")の警告により、職権に基づき、ANNEX13の基準に従い、汎用AIモデルをシステミックリスクを有するものとして指定することができる(AIA第52条第4項)。

⇛システミックリスクを伴う汎用AIは公表される(AIA第52条第6項)

この場合、プロバイダは、指定決定から6か月以内に再審査請求が可能である(AIA第52条第5項)。

システミックリスクを伴う汎用AIモデルのプロバイダに課される義務

汎用AIモデルのプロバイダに課される義務(AIA第53条※後述)に加え、システミックリスクを伴う汎用AIモデルのプロバイダには次の義務が課される(同第55条第1項)。

モデルのリスクの特定・評価・軽減

重大なインシデントの報告

最先端のテストとモデル評価の実施

サイバーセキュリティの確保

なお、EU整合法令にいう「整合基準」("harmonised standard")が公表されるまでは、AIA第56条の実務規範("code of practice")に準拠していれば、上記義務を遵守していることが推定される(AIA第55条第2項)。この実務規範は遅くともAIA発効日から9か月以内に作成される予定である(AIA第56条第9項)。

汎用AIモデルのプロバイダに課される義務

汎用AIモデルのプロバイダには、次の4つの義務が課される(AIA第53条第1項)。

学習とテストのプロセスと評価の結果を含むモデルの技術文書(ANNEX11に列挙される情報が含まれていなければならない)を作成し、最新の状態に保つこと

汎用AIモデルを独自のAI システムに統合しようとするプロバイダに対し、当該AIモデルの機能や制限を理解し、AIAに従った義務を遵守できるようにするため、当該プロバイダに提供する情報とドキュメントを作成すること(ANNEX12に列挙される情報が含まれていなければならない)

著作権法を遵守し、特にEU著作権指令2019/790の第4条第3項に従って表明された権利の留保を最先端技術によるものも含めて特定し遵守するための方針を定めること

AIオフィスが提供するテンプレートに従い、汎用AIモデルの学習に使用されるコンテンツに関する十分に詳細な要約を作成し、一般に公開すること

The exception or limitation provided for in paragraph 1 shall apply on condition that the use of works and other subject matter referred to in that paragraph has not been expressly reserved by their rightholders in an appropriate manner, such as machine-readable means in the case of content made publicly available online.

なお、1点目と2点目の義務は、システミック・リスクを有する汎用AIモデルを除き、モデルへのアクセス等を認める無償かつオープンライセンスでリリースされ、重み・モデル構造に関する情報・モデルの使用に関する情報を含むパラメータが一般に公開されているAIモデルのプロバイダには適用されない(AIA第53条第2項)。

汎用AIモデルについても、EU整合法令にいう「整合基準」("harmonised standard")が公表されるまでは、AIA第56条の実務規範("code of practice")に準拠していれば、上記義務を遵守していることが推定される(AIA第53条第4項)。

罰則・執行

罰則や執行措置は、加盟国ごとにAIA第99条の定めに従い定められることになるが、罰則は、効果的・比例的・抑止力のあるものでなければならず、スタートアップ企業を含む中小企業の利益やその経済的存続可能性を考慮しなければならないとされ、最終的には欧州委員会が定めるガイドラインを参考にして定められる(AIA第99条第1項)。

AIA第5条の禁止AIの定めに違反した場合

最大3,500万ユーロ又は前会計年度の世界年間総売上高の7%(いずれか高い方*)の罰金

次の定めに違反した場合

最大1,500万ユーロ又は前会計年度の全世界年間総売上高の3%(いずれか高い方*)の罰金

(a)AIA第16条に基づくプロバイダーの義務

(b)AIA第22条に基づく代理人の義務

(c)AIA第23条に基づく輸入業者の義務

(d)AIA第24条に基づく販売業者の義務

(e)AIA第26条に基づくデプロイヤの義務

(f) AIA第31条、第33条第1項・第3項・第4項又は第34条に基づく認証機関の要件・義務

(g)AIA第50条に基づくプロバイダ・デプロイヤの透明性の義務

その他

要請に応じて、不正確・不完全・誤解を招く情報を通知機関や当局に提供した場合、最大750万ユーロ又は前会計年度の世界年間総売上高の1.5%(いずれか高い方*)

*スタートアップ企業を含む中小企業の場合、罰金はいずれか低い方となる

以上

この記事が気に入ったらサポートをしてみませんか?