論文:Appleの「Attension」「Transformer」による視覚AI開発状況

Deploying Attention-Based Vision Transformers to Apple Neural Engine

アップルのニューラル・エンジンにアテンション・ベースの視覚トランスフォーマーを導入

https://machinelearning.apple.com/research/vision-transformers

1.はじめに

「Attention」と「Transformer」という用語は、機械学習、特に自然言語処理(NLP)の分野で広く使用されています。これらの概念は、特定の情報をより効果的に処理するためのものです。

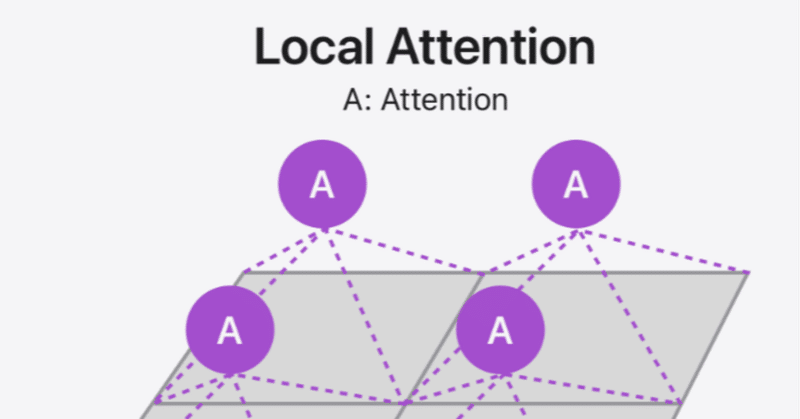

Attention メカニズム

Attentionメカニズムは、モデルが入力の中で最も重要な部分に「注意」を向けることを可能にします。これは人間が情報を処理する方法に似ています。例えば、文章を読むときに、すべての単語に均等に注意を払うのではなく、文脈に基づいて特定の単語やフレーズに焦点を合わせます。機械学習モデルでは、Attentionは特定の入力の部分が出力にどれだけ影響を与えるかを学習することにより、モデルの予測精度を向上させるのに役立ちます。

Transformer アーキテクチャ

Transformerは、Attentionメカニズムを用いたアーキテクチャです。このアーキテクチャは、従来のRNN(リカレントニューラルネットワーク)やCNN(畳み込みニューラルネットワーク)に代わるものとして開発されました。Transformerの主な利点は、データの時間的な連続性に依存せず、入力データの任意の部分を並行して処理できることです。これにより、特に長いシーケンスを扱う場合の計算効率が大幅に向上します。

Transformerモデルは、主に「エンコーダ」と「デコーダ」の2つの部分から構成されています。エンコーダは入力データを解析して情報を抽出し、デコーダはその情報を基にして何か(例えば、翻訳されたテキストや回答など)を生成します。両部分は複数の層から成り立っており、各層は複数のAttentionユニットを含んでいます。

Appleの研究では、Vision Transformersに焦点を当てており、画像認識タスクにTransformerアーキテクチャを適用しています。これにより、画像の各部分にどのように「注意」を払うかをモデルが学習し、全体としての画像認識の精度を向上させることが可能になります。

詳細は、AppleのMachine Learning Researchサイトで確認できます:Vision Transformers at Apple

この記事が気に入ったらサポートをしてみませんか?