最近の記事

GPT4oの正式版がまだ正式にリリースされないので現行のGPT4oの実力を試した。これがあればgoogle検索不要ですね。

これがあればgoogle検索不要ですね。 これ一発でgoogle検索ノックアウトす。 これが私の言う「ドラえもん」です。 このドラえもんは はじめ、「かねりん」のいみがわからなくて 「どういう意味でしょうか? それとも特定の詐欺についてお話していますか?」 というききかえしてきました。 「賢い」 かねりんのうなぎの写真をうまく探せなくて違うものを出してきた 自分でも、間違っていると認識して、突然英語で話しだした。 「かわいい」「おもしろい」と楽しめました。 それ以外の情報

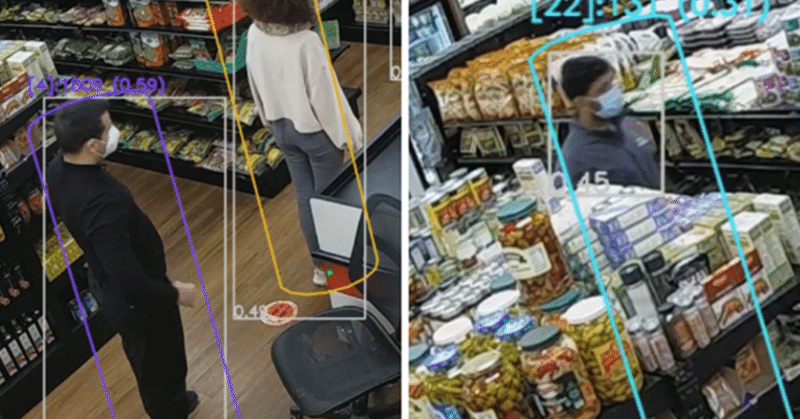

[論文解説]NVIDIA DeepStreamのシングルビュー3Dトラッキングを使用した視覚知覚におけるオクルージョンの軽減

Nvidia技術ブログから 概要 交通監視、倉庫の安全性、小売店の店員分析などのインテリジェント・ビデオ・アナリティクス(IVA)アプリケーションの知覚に関して言えば、最大の課題の1つはオクルージョンである。 例えば、人は構造的な障害物の陰に隠れたり、小売店の店員は棚に隠れて完全に見えなかったり、車は大型トラックの陰に隠れたりします。 この記事では、NVIDIA DeepStream SDKの新機能であるシングルビュー3Dトラッキングが、実際のIVA導入でよく遭遇する視覚知

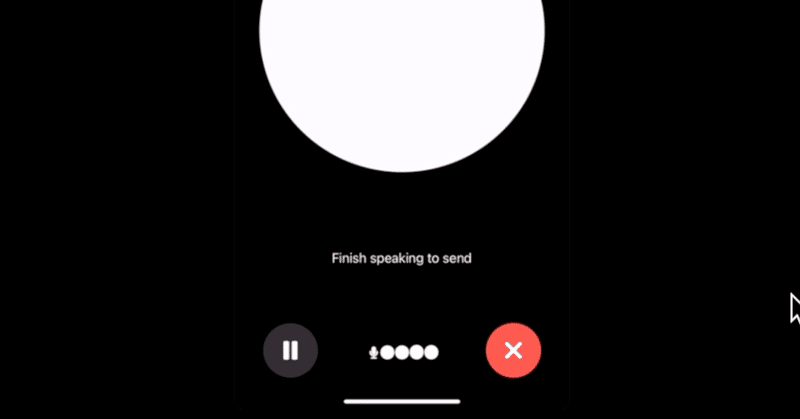

Mac用デスクトップアプリをダウンロードして試した。Microsoftがco-pilotボタン付きパソコンを販売する前にアップルのMacbookにドラエモンボタンをつけてMicrosoftに対抗するしたかに見える。

ChatGPT MacOSアプリダウンロードしました PlusユーザーにmacOSアプリを配布しています。 クール:ボタン一発で ボイスモードをはじめ、GPT-4oの新しいオーディオおよびビデオ機能により、コンピュータから直接ChatGPTでボイス会話ができるようになりました。 社内で新しいアイデアを出したいとき、 面接の準備をしたいとき、 話したいトピックがあるときなど、 デスクトップアプリの右下にあるヘッドフォンアイコンをタップして音声会話を始めます。 システム要件

ChatGPT4omuniでGoogleのAI発表会を説明してもらう音声応答で説明させた。曖昧な会話でも突然英語で質問してもOK

ChatGPT4omuniでGoogleのAI発表会を説明してもらう 音声応答で説明させた。曖昧な会話でも突然英語で質問してもOK Me:Googleの最新のAI発表会でカメラを使ったデモを説明して Googleの最新のAI発表会では、Gemini 1.5という次世代のAIモデルが発表されました。このモデルはマルチモーダルAIで、テキスト、画像、音声、動画などのさまざまな形式の情報を統合的に理解し、処理する能力を持っています。この発表会では、カメラを使用してリアルタイムに場

ChatGPT 4oを試した。マイクを通じ私が英語でしゃべり、ChatGPT 4が音声で応答してくれた。ビデオをみせて何が録画されているか聞いた。

ビデオは台湾の故宮博物館です。 何が見えているか理解しているが一発で故宮博物館と認識するのは難しかった。 以下会話 Me: can you see me? ChatGPT I can't see you. I can only interact with you through text. If you have any questions or need assistance, feel free to ask! Me;how can I interact with y