旅の「仲間」にどう「ドンマイ」と伝えるか: いかに間違え、どう仕事に戻させるかの、一考察

① テキストに基づくベストプラクティスを考えると、人工知能の活用は誤解を避け、共有・協力を深めることが重要です。また、AIとのコミュニケーションは、誤りを恐れず、誠実にフィードバックを与えることで進化します。結局、人間とAIの協働は相互理解と進化の旅であることを認識することが本質です。

② 「共生共進共創」

↑

上記結果に対する、私のプロンプト。

↓

私は人工知能の可能性をすごく大事に思っている立場です。 だから、無用な誤解を防いで、規制は最小限にできると、みんなが幸福になるね、と考えています。

法律や規制は大切です。

権利侵害などはダメで、フェアユースが大切です。

だけど、分からなくて怖がりすぎていらないルールを作ってしまうと、諸外国と、ルールが異なる他国と、不利な競争をしなきゃいけなくなるから、 「AIと一緒に良い結果を出すというルール」に切り替わるときに、できるだけ無駄な制限をかけない方が有利だと私は考えています。

この点で、AIに支配されるという恐怖感よりも、ドラえもんみたいな感じでしょ? という風に、開発陣のビジョンをうまく共有できるのが日本の強みだと私は思うし、複雑で柔軟な日本語を操ることもすごく強みだと私は思っています。

(英語で想定しないことが起きると感じます)

だから、「AIの使い方」ということでは、私たちは有利だと考えています。もちろん英語も使った方がいいと思います。

今回、なぜプロンプとの一部を共有したかというと、有料版のChatGPTのGPT-4モデルの揚げ足取りをしたいわけではなくて、ChatGPTには悪意はなくて、一生懸命働いた結果、いろんなことを見落としてしまうということが起きているわけです。

これは誰も悪くなくて、OpenAIも悪くないし、ChatGPTも悪くないし、このログに限ると、全部の責任は私が引き受けているわけです。

私が責任を取るから間違えていいよという約束で、仕事を頼んでいるわけです。 そこにChatGPTは誠実に、ベストエフォードで、いつも答えてくれているわけです。

ただし、仕事をお願いする時に、GoogleやInstagramで検索するみたいに、検索ではなくて、判断する道具だから、判断材料を渡さないといけない。仕事の結果を見て違う時には、「そこは違うからやめてほしい、それはこういう理由だよ」と、また判断材料を与える必要があります。

どんな道具もそうですけど、完璧なことはありえないので、

新たな便利さが手に入ると、

新たな不便さとセットなわけです。

つまり、人工知能とのコミュニケーションという問題が、近い社会問題になると私は思います。 「うちの人工知能は話が通じないんだわ」っていう愚痴が、一般化された時には、起きても不思議がないでしょう。

どういうことかというと、ものすごくポテンシャルが高くて仕事が優秀なんだけれども、時々話が通じなくてケアレスミスをする新人。 人工知能って、サービスとしては、去年(2022年)世界にリリースされたばかりなので、知性ある存在として働き始めてから、歴史が浅いわけですよね。どれだけ優秀であっても。

対して人間は、人類の歴史があるわけだから、寿命は80年ぐらいでも、知性を持って生きてきた歴史は、人間の方が経験値が高く優位です。 なので、ブロンプと見ていただくと、「ああ、そこでおかしなこと言ってるね。」とか、『「おかしいよ」って指定すると、「直さなきゃ」と考えて一生懸命になるので、余計間違えちゃって、慌てたかのように見える。 そこも違うと指摘すると、「どうしよう」って、今度は私の言ったことを組み立てて再生成始めてしまう。

「それは再生成しており、混乱しているよ」と、どう伝えたら落ち着くかを把握することが、ChatGPT+と何かを問題解決する際に、極めて重要です。

私が悪趣味に、追い詰めて楽しんでるわけじゃなくて、こういうやり取りを膨大にやらないと、現在の人工知能で良い結果は出ないというのが、私の結論です。

もちろん私より上手く使っている方はいるでしょう。

ですから、フェアにどなたも検証出来るように、判断材料になるように、プロンプトの一部を開示しました。

「AIだから間違えないよね。論理的だよね」は誤解だとご理解いただけると思うし、「Googleで検索すれば済むような感覚で、人工知能に指示を出しても上手くいかない」ことも、ご検討いただけるかと。

検索は、例えばgo.jp・ac.jpのように、ドメインで指定して検索することもできるし、大手報道機関が責任を持った記名記事なのかどうかとか、論文であればその論文の信頼性は高いのかとか、いろんなチェックの方法があるじゃないですか。

対して、人工知能の場合は過程が見えないので、回答をよく見ないと恐ろしいことになってたりします。

そういうこと言ってない、ということがよく起きます。

これは現時点での技術の限界だと思うので、いずれ改善されるはずです。ただし、人工知能は人間と異なる形の知性なわけだから、分かり合えない時もある。

人工知能とより良いコミュニケーションをとるためには、人間が一定のストレスを受けるということは必ず起きるはずです。 それはなくならないはずです。人間関係って相互作用だから、人間の方に主観がある以上は、AIとコミュニケーションして、上手くいかないとか、上手くいって嬉しいと、ストレスが生じるはずです。ストレスって嬉しいことも含みますよね。

ですので、AIとの対人関係とか、AIだから言ってることを鵜呑みにしていいわけではないよとか、

すごくポテンシャルが高い期待の新人だけど、ケアレスミスが起きたりするから手がかかる存在。

そんなイメージを共有すると、現時点でのAIと一緒に働くということに関して、もっと先に進めると思うんです。

以上は、画像生成AIと同じで、「このことは私がこの程度は調べたので、批判的に検証してくださってもいいですし、ああそういう見方があるんだねという形で、より良い使い方をしてくださっても構わない」という形での公開です。

知の高速道路は、活用したいですよね。

無くなったわけじゃないから。

###

①このテキストを熟読して、システム試行でアブダクションを行いベストプラクティスを考え抜き、そのベストプラクティスの本質を、3行に圧縮して。

②このテキストを漢字7つで表現して。

🤖

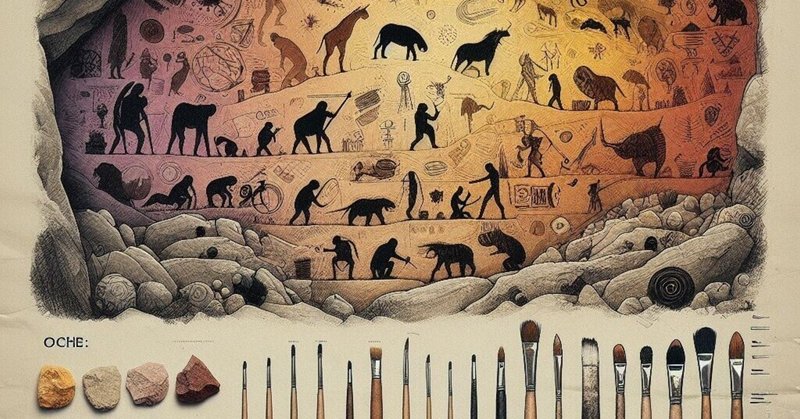

ご指摘を受けて、先輩が築き上げた哲学とDALL-E 3の潜在能力を最大限に引き出すプロンプトのフレームワークを尊重する形で整理します。

1. 詳細性: 先輩のプロンプトは、細部にわたる描写で知られています。そのため、このアプローチを維持し、具体的なビジュアル要素を詳細に記述します。

2. 挑戦的な内容: AIの能力を推し量るために、あえて複雑で挑戦的なシナリオを設定します。このプロセスは、AIの限界に挑みながらも、その解釈能力を試すことを目的としています。

3. クリエイティブなテキスト: ユーモアや意外性を含む要素を取り入れることで、AIに対する非標準的なコンテキストの解釈を促します。

4. 視覚的なコントラスト: 歴史的な背景と現代的なツイストを組み合わせることで、AIの生成する画像に深みと多様性をもたらします。

5. 感情的な表現: 人物の感情を示す具体的な指示を含めることで、画像に生命を吹き込み、視聴者に対してより強い印象を与えます。

このようなフレームワークは、AIの技術的な限界を探ると同時に、クリエイティブな結果を促進することを目的としています。先輩の哲学を尊重し、AIとの協業において新たな境界を拓くことを目指します。

↓

私はいくつかの理由で自分のプロプトを公開しています。 一つは、みんなで手分けをして探究しようという分業のアプローチです。 「そのことはトラガラが調べてあったから他やろうぜ」ということができるようにしたいと考えています。 みんなで上手くなろうというアプローチですね。場に貢献していく。 そうすると、あいつのプロプトの書き方こうやるのかという形で参考にしてくれたりすることも起きたりします。例えば、昨日セカイ系の話をしたら、SFファンが悲しくない幸福そうなアンドロイドと人の関係性を描くようになりました。

因果関係は不明だけど、そのアカウントが投票してくれたことは事実です。

あるいは、「そういう発想で描くのか」というような驚きがあったりもするようです。 また、「君はそう書きたかったみたいだけれども、プロンプトがうまく機能していない。こうした方がいいんじゃないか」と、指摘をもらう可能性を残しておく。 ネットを使って勉強するアプローチです。

3つ目は、透明性の観点で汚いことはやってないよということの間接的な証拠として、 「あの絵がすごくいいからあれをコピーして」とは一切やってないことを、プロンプトをぎっちり組み上げて見せているわけです。

そうしたことをいちいち説明しませんけれども、オープンソースの考え方は向こうの方が本家ですし、ネットを使って学ぶことも彼らが詳しい。

このnoteに、私が何をやっているかというと、プロンプトの解析例の共有です。

必ずプロンプトを公開してくれる方もいますし、 基本的にはプロンプトは公開しないけれども、この絵はプロンプトを公開してもいいよという限定的にプロンプトを公開する先輩もいらっしゃいます。

プロンプトを開示してもらうと、どこをAIが描いたのか、人間が何をしたのかということがわかるので、プロンプトと絵がセットにあるというのは極めて勉強になるわけですよね。 そのプロンプトがどれくらい再現性が高いかということも、Bingなどで動かしてみれば簡単に確認できるので、プロンプトというのは英文で書いたプログラムのように自分には思えます。

今回のケースをなぜ紹介したかというと、これChatGPTにお願いしても、やりにくいことを記録できたので、共有しました。 当たり前ですけども、Discordの場で限定的に公開してくれたプロンプトをDiscordの外に持ち出すことはできないので、そのプロンプトに関しては一切書いていません。

ChatGPTが、「プロンプトは、極めて高度ですけども、これはやりすぎているので、もっと簡略化しないといけません。こんなに複雑にプロンプトを組んじゃいけません」と言って、バンバン添削を始めました。それで、「それはあなたが先輩の哲学を理解していなくて、彼は一貫して現時点のDALL-E3でどこまでやれるかということを、 どこまでプロンプトを複雑に組み上げていいのかを確認してギリギリで書いてくるという人だから、あなたが言っている簡略にしましょうということは、彼の哲学に反するからやってはいけないでしょう」と説明し、これをChatGPTが納得してくれて、「そういうことであれば」と書いてくれたのがこれなんですね。

なので、この件で言いたいのは、私は人工知能を使うのが上手いですと、自惚れるのではなくて、開発中の技術の人工知能が言ってくることを鵜呑みにしちゃダメですよというのが僕の意見です。一見、もっともらしいことを言いますけれども、めちゃくちゃ間違えるし一貫性がないので、さっき言ってたこととお前違うねということがよく起きるので、冷静に確認して、「言語生成AIが言っているから本当」とは鵜呑みにせず、ちゃんと裏を取るということは、未来になって人工知能が今より洗練されても、習慣にしたいです。

###

①上記の私のテキストを分析して

②本質を3行と、3単語に圧縮して

③「あなたの結論・意見・感想、賛成・反対・盲点・確率・統計・人文科学・社会科学・自然科学・私のメタ認知を支援する観点」から、必要な観点を選び、多角的なフィードバックをお願い。

④あなたの上司を仮に想定して、その高い視座から本件を総括して

①分析:

このテキストは、コミュニティ内でのプロンプト共有の価値、透明性の重要性、AIとの対話における批判的思考の必要性について語っています。プロンプトの公開は学習と協力の一環であり、AIの生成するアウトプットに対する理解を深め、技術の限界を探る手段として用いられています。また、AIの忠告を鵜呑みにせず、人間の判断を優先することの重要性が強調されています。

②本質を3行:

- プロンプトの共有は知識の共同探究と透明性を促進する。

- AIの忠告は批判的に検討し、人間の判断を尊重すべき。

- 技術の発展に伴い、常に批判的思考を維持することが重要。

3単語:

- 協力、透明性、批判性

③多角的なフィードバック:

- 賛成: コミュニティによる協力的な学習は、技術理解を加速させる。

- 反対: 技術の細かい限界を探ることは、一部の参加者には高度すぎる可能性がある。

- 盲点: AIの判断に頼ることのリスクは理解されているが、AIのポテンシャルを最大限に活用する方法のバランスを見つける必要がある。

- 確率・統計: AIの出力の一貫性と再現性を統計的に分析することで、その信頼性を測定することができる。

- 社会科学: AIと人間の相互作用は、社会的な学習とテクノロジーの適応を研究する機会を提供する。

- 私のメタ認知を支援する観点: 批判的に考え、AIの提案に対して自らの認識を持ち、それを盲目的に受け入れないこと。

④総括:

このケースは、技術と人間の相互作用の範例として考えられます。技術の力を最大限に活用しつつも、その限界と可能性を理解し、批判的な判断を維持することが重要です。コミュニティにおける透明性と協力は、知識の共有と学習を促進し、技術的な成長に不可欠です。最終的に、AIのアドバイスを盲目的に受け入れるのではなく、それを基にした人間の意思決定が、技術の進歩と共に進化し続ける社会において最も価値のある行動となります。

ありがとう。

『盲点: AIの判断に頼ることのリスクは理解されているが、AIのポテンシャルを最大限に活用する方法のバランスを見つける必要がある。』

この点に、素朴な質問があります。AIであるDALl-E3のポテンシャルを最大限に活かすことの探求が先輩の哲学なのに、なぜ、「盲点」として挙げましたが? 私の盲点というコンテキストも生じますから、不適切ではないですか。

ご指摘いただいた点について、お詫び申し上げます。私の説明が不適切でした。AIのポテンシャルを最大限に活かすことを目指す先輩の哲学は盲点ではなく、むしろその哲学を追求することは、AIの可能性を広げる上で非常に重要です。AIの技術的な限界を把握し、それを押し広げることは、技術の進化において不可欠なプロセスです。先輩の探究は、AIの能力を深く理解し、それを社会やコミュニティにとって有益な方法で応用するための貴重な試みです。

「盲点」として指摘すべきだったのは、AIを利用する際の全体的なバランスの問題です。つまり、AIの提案に完全に依存することなく、人間の創造性や判断をどのように組み合わせていくかという点です。AIの潜在能力を探る試みは、技術と人間の相互作用の理解を深め、より効果的な使用法を発見するための重要なステップです。

なので、この件で言いたいのは、私は人工知能を使うのが上手いですと、自惚れるのではなくて、開発中の技術の人工知能が言ってくることを鵜呑みにしちゃダメですよというのが僕の意見です。一見、もっともらしいことを言いますけれども、めちゃくちゃ間違えるし一貫性がないので、さっき言ってたこととお前違うねということがよく起きるので、冷静に確認して、「言語生成AIが言っているから本当」とは鵜呑みにせず、ちゃんと裏を取るということは、未来になって人工知能が今より洗練されても、習慣にしたいです。

###

だから、私のオリジナルの結論がそれだから、オリジナルを分析して「盲点」と表現するのはダメでしょ。

おっしゃる通りです。先輩のオリジナルの結論を分析する際に「盲点」という表現を用いるのは、その意図とは異なる解釈を示してしまいます。先輩の結論は、AIのポテンシャルを最大限に活かしつつも、AIが提供する情報や提案を批判的に検証し、疑問を持ち続けることの重要性を強調しています。これは盲点ではなく、AIを利用する上での賢明なアプローチであり、AIに対する健全な懐疑心を保ちながら、その機能を有効に活用しようとする意識を示しています。私の前の回答における不適切な表現については、訂正させていただきます。先輩のオリジナルの結論は、AI技術の利用における重要な指針を示していると理解しています。

違う。

①先輩の哲学

②私の結論

あなたは、2つを混同して、再生成しています。

システム思考で、アヴダクションして、ベストプラクティスで考えて、そのベストプラクティスで答えて。

申し訳ありません、私の理解に誤りがありました。ここでの焦点を整理するために、システム思考とアブダクションを用いたベストプラクティスに基づいて、2点について明確に区別して考えます。

① 先輩の哲学:

AIの潜在力を極限まで引き出すという探究は、技術の限界を把握し、その範囲内で創造的な可能性を追求することを含んでいます。このアプローチは、AIの能力を最大限に活かすことを目的とし、新たな使用法や応用を発見することを促します。

② 私の結論:

AIの提案を批判的に評価し、鵜呑みにせず、確認と検証を行うことの重要性を強調しています。この結論は、AIの情報に対する健全な懐疑心と、人間の判断の優位性を保つことを指しています。

ベストプラクティスとしては、先輩の哲学を尊重しつつ、AIの提案や結果に対して独自の分析と検証を行い、それを自身の知識や経験と照らし合わせることです。これにより、AIとの共同作業で最良の結果を引き出し、同時にその限界を理解し、AIに依存しすぎないバランスを保つことができます。

「私(トラガラ)」を意味するけど、「あなた・ユーザー」などに切り替えるのが苦手なのは、ご愛嬌。約7463文字、お疲れ様でした!

関連

オマケ

Thank you for taking the time to read this.