Photo by

notty78

llama.cppのexampleで遊んでみた→XcodeでiPhoneプレビューでローカルLLMを動かす

llama.cppをクローンしたときにexampleというフォルダが入っていて

ここにお試しみたいなアプリが入っています。

その中の

こちらをXcodeでビルドして遊んでみました。

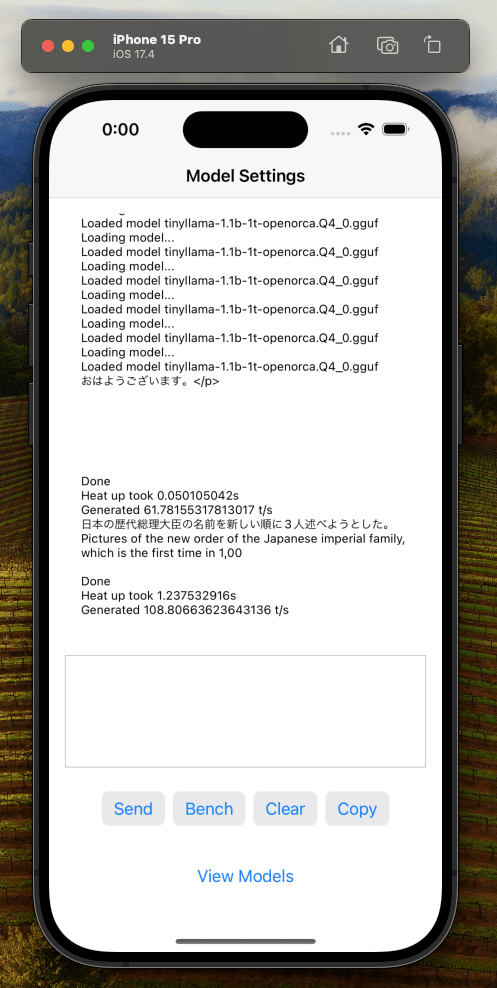

View Modelsをタップしてみましょう

Download済みの tinyllama-1.1bがあるので使ってみます

タップすると選べるはずですが何も反応ありませんが

気にせずバックを押して戻ります

会話できてますね^^

これは実機で試してみたくなる・・・!

ちなみに生成速度でてますが108 token/seconds

ってめちゃめちゃ早いです

僕のM2MAXのパワーで出ているので

実機で試すとどのくらいのスピードになるか気になりますね!

この記事が気に入ったらサポートをしてみませんか?