音を使ってロボットの知覚を改善 – Carnegie Mellon University

昨今ロボットは視覚(Computer Vision) や触覚(Haptics) などを急速に取り込み進化を続けています。人は日常五感(視覚、聴覚、触覚、味覚、嗅覚) を使って様々な事象に対処しており、ロボットがより人に近い判断をするためには人と同じ情報を得る必要がありますし、新たな感覚を得ることで今までロボットが苦手としている作業もスムーズにこなすことが可能になる可能性があります。この五感の中で以前から注目しているのが聴覚、つまり音です。

音は実に多くの情報を提供してくれると同時に、音の伝わる速度は 340m/秒と光に比べて格段に処理しやすいのに加え、音の解析技術は昔から多く行われています。既存の技術をロボットに応用し視覚・触覚と組み合わせることでより高度な処理が可能になります。例えば複数のマイクと使うことで音の方向や距離も分かりますし、壁にぶつかった時の音で壁の材質や構造もある程度わかります。また音に含まれる成分を分析することで音の発生源の素材や形状もある程度予測することが可能ですし、移動する物体が発する音を分析することでその移動物体の進んでいる方向や速度も分かります。特に注目しているのは、音は光と異なり見えない場所や物陰でも活用できる点です。

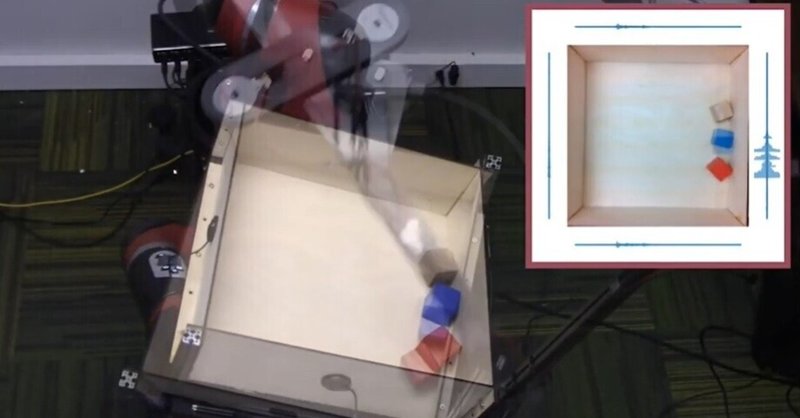

昨年ロボット技術開発のトップ研究機関であるカーネギーメロン大学で物が動く時の音をカタログ化しているという研究発表が行われました。サンプリングしているのは金属製のトレイ内に物体を入れ、トレイを傾けることでトレイ内の物体が移動する際に発する音や金属トレイの壁にぶつかる音を収集しているそうです。カタログ化を進めることで今後物体識別がより簡単、正確に行うことができそうです。

まだまだ研究段階ではありますが、今後 Computer Visionと共に重要な要素技術になる可能性に期待しています。

※リファレンス: “Sounds of Action: Using Ears, Not Just Eyes, Improves Robot Perception”, Carnegie Mellon University, 2020/8/14

この記事が気に入ったらサポートをしてみませんか?