開かれたAIとその敵

今は第3次AIブーム。これまでと何が違うのか?答えはシンプル。従来よりも圧倒的に高い性能を実現したから。昔からAIに対する期待は大きかったけれども、実際には驚くほどの性能ではなく「この程度じゃ大したことないねー。我々人類の偉大なる能力には程遠いぞっ。」を長らく繰り返してきた。しかし、状況は急変する...。

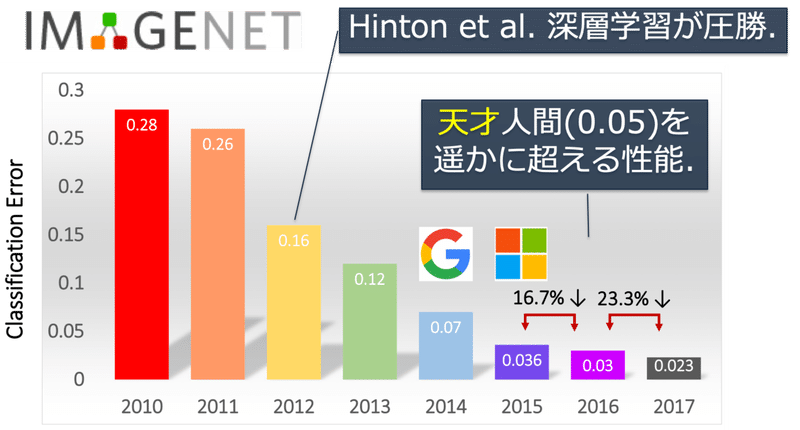

AIの研究領域の1つに画像認識がある。人間であれば小さい子供でも目で見たものが何であるかを即座に認識できる。「そこに犬がいるね」「車が3台あるよ」といった具合だ。しかし、それはコンピュータにとっては概して難しいタスクであった。高精度な画像認識技術が確立されれば様々な産業応用が可能だ。事実、今では自動運転等、様々な領域で画像認識技術の活用が試行されている。さて、ILSVRCという競技(コンペティション)があるのをご存知だろうか?「コンピュータプログラムによって画像の中に何が写っているかをどれだけ正確に当てられるか?」という課題を世界中の大学や企業の研究チームで競い合う大会で2010年から毎年開催されいる。そしてそれは、2012年に起こった。前年の優勝モデルに比べ10%の精度改善という衝撃的な成果を達成したのだ!

引用:Overview of ILSVRC 2017(を一部改変)

この図は、2010年から2017年までのILSVRCの優勝チームの成績を示している。縦軸は「誤認識率」、つまり正解はネコなのにイヌといったように間違えてしまう割合。2010年の時点では28%程度間違えるAIが最先端であったことがわかる。そして2012年に一気に16%まで精度が改善する。ここで登場したのが、今をときめく「DeepLearning(深層学習)」である。この飛躍は業界を震撼させ、同時に進むべき道筋を与えた。興奮とともに産業界もまきこみ、世界的にDeepLearningに注目が集まる。Googleなど企業研究所が潤沢なリソースを投下し、次々と精度改善を成し遂げる。2015年にマイクロソフトが3.6%を達成し、ついに人間の能力限界とされる5%を超えた。話によるとこの5%というのはかなり訓練された専門家の能力らしく、普通の人間の水準は早々に抜かれているようだ。その後、DeepLearingを搭載する囲碁ソフト「AlphaGO」が世界トップ棋士を打ち破るなど、人間越えのキャッチーな事例が多数生まれ、世間一般にAIの威力が知られるようになる。

引用:Google DeepMind Challenge Match

このように、AIが世界的に注目されている理由は、従来では決して成し遂げられなかった、人間に匹敵、あるいはそれを上回る性能を実現したことにある。「論より証拠」、「AIは見た目が9割」であるw。

一方で、このAIブームは世間に混乱をもたらした。華々しいAIの成功事例から、AIは万能であるような誤解と誤用が広がった。また、AIブームに便乗した「なんちゃってAI」というイメージ戦略のもと、本質的にAIとは無関係な製品や粗悪なAIが市場に氾濫した。「AIというのは精度はそこまで重要じゃないんですよ、とりあえず業務に活用してみることが大事なんです」とか、自身の実力不足を正当化するAIコンサル・ベンダーまで跋扈する始末だ。課題解決には必ずしも高度な技術が必要なわけではないし(むしろ簡単な方法で解決するに越したことはない)、古典的な技術も含めたデータ活用の裾野が広がることは大変望ましいことだが、だからといっていい加減な仕事が許される道理もない。改めて思い返して欲しい。今回のAIブームの本質が、その性能の高さであることを。

開かれたAI

それでは、なぜAIの性能を飛躍的に上げることができたのであろうか?その成立に以下の3つの要素が極めて重要な役割を担う。

・データ

・計算資源

・人材

【データ】

DeepLearningを含む機械学習アルゴリズムは、ある入力データに対応して出力すべき「正解」を与えることで、入力と出力の間の法則を学習することができる。この「正解」のデータのことを「教師データ」と呼ぶ。例えば、画像認識であれば、画像そのものが入力データであり、画像に写っているモノを予め人間が判定しておいたお手本が教師データとなる。僕らが勉強するときに教師から沢山教えられると成績が上がるように、AIも学習に用いる教師データが、多ければ多いほど性能が上がる。前述のILSVRCは約140万枚の画像に写る1000種類のモノを認識するチャレンジであり、ImageNetと呼ばれる世界最大の画像および教師データベースの存在が、実施を可能にした。このように、現状では、高性能AIの実現には大量の教師データが必須である。

引用:ImageNet

ちなみにImgaeNetの整備は「人海戦術」で行われた。実際は、320万枚の画像に対して5247カテゴリのラベルの付与に2年半を費やした。そんな途方もない作業を誰がどうやって行ったのか?最初は、学生のバイトでなんとかしようとしていたらしいが、早々にあきらめたそうだ。そりゃそうだ。答えは、クラウドソーシング、Amazonが提供するMechanical Turkというサービスだ。インターネット経由で単純作業を世界中の約25万人の従事者に依頼できる仕組みである。現状のAIにはお手本がいる。AIの知識がない人であっても、よいお手本になる(教師データを作成する)ことでAIの発展に貢献できるということだ。さて、過去にSIGNATEが受注したAI開発案件で、教師データ作成の要件があり、複数社に教師データ作成を外注したことがある。AI業界ではかなり有名なスタートアップ系、AI用の教師データ作成に特化した専業会社、AIとは無縁の単純労働受託会社など様々なベンダにタスクを分割して発注した。同じ作業でも見積もり額はピンキリだ。AI系は専門なので質が高いですよと単価も高い傾向。しかし、結果的には単純労働系が単価も安いし、質も高かった。この案件では、若干、日本に関する知識があると有利なタスクであったため、特にオフショアで原価を下げていたAI専業ベンダは品質が悪かった。質の悪い教師データで学習したAIは使い物にならないため、業者選定は慎重に。

【計算資源】

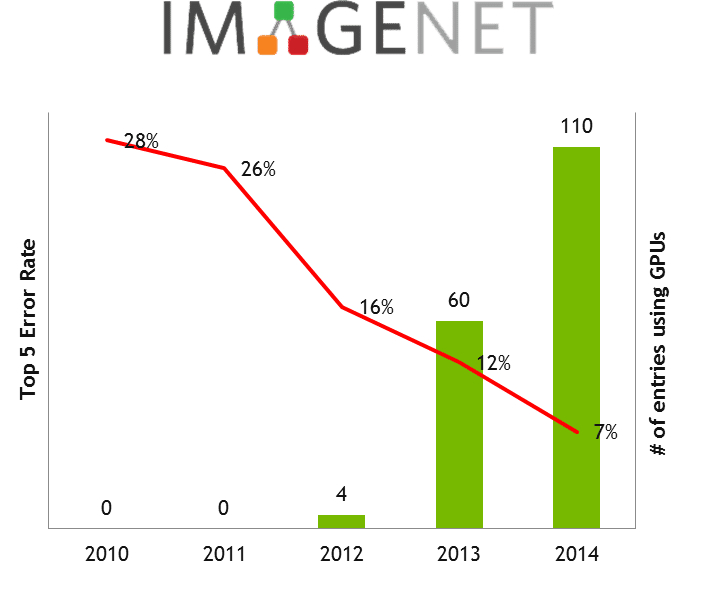

大量のデータをAIに学習させるためには、コンピュータリソースも大量に必要になることは想像に難くないだろう。AIの学習とは、具体的にはパラメータと呼ばれる大量の数値群を計算・調整する作業である。実は、僕たちが普段使うパソコンに代表されるコンピュータの仕組みは、その作業に必ずしも向いていない。一般的なコンピュータは文章を書いたり、グラフを作ったり、絵を描いたり、様々な作業を汎用的にこなすためにデザインされている。一方、ゲームやCG(コンピュータグラフィックス)の領域では、よりリアルで、より滑らかな表現を目指して技術開発が進んでいた。それらの実現には、ディスプレイ画面に表示される画素に対する莫大な量の計算を超高速に実行することが求められる。そこで、GPU(Graphics Processing Unit)と呼ばれる専用のプロセッサが開発され利用されている。偶然にも(?)この計算の仕組みが、AIのパラメータ計算に向いていた。GPUの世界大手NVIDIA社は、今ではAI向けの半導体メーカーとしても、抜群の存在感を示している。ちなみに前述のAlphaGOには176台のGPUが使われたらしい。莫大な計算資源である。ILSVRCでも2012年以降、ほとんど全てのチームがGPUを利用しており、特にDeepLearningの学習にはGPUが必須である(下図)。高速な計算ができれば、沢山の試行錯誤が可能であり、そのような環境を手に入れるハードルが下がったことも高性能AIの実現に貢献したのは間違いない。

引用:NVIDIA Developer Blog

緑の棒グラフがGPUを使っているチーム数をあらわしている。2012年以降右肩上がりだ。一方で、GPUは高価なため、DeepLearnigは金食い虫になりがちだ。以前、SIGNATEにおいて開催した「車載カメラ画像における物体認識コンペティション」では、東大生のチームが入賞したのだが、彼らはDeepLearningの構築のためクラウド(GPU)に10万円以上を費やしていた。幸い、賞金を獲得したので資金は回収できたのだが。逆に、それが負けられない理由になったそうだw。この例からも、AIの開発環境コストは無視できず、その低減が課題であることがわかる。なお、AIにより適したプロセッサの開発競争が、大手半導体メーカーの間で繰り広げられている。

【人材】さて、大量のデータと計算資源へのアクセスという条件は揃った。ただ、それだけで高性能なAIは生まれるのであろうか?答えはNoである。当然、高性能なAIアルゴリズム自体を発明する人材が必要である。そのような人材はどこにいるのだろうか?世界にはAIを研究している大学や研究機関が多数ある。また、ITや情報通信などの企業にも関連する研究部門がある。実は、DeepLearningのベースとなるニューラルネットワークに関する研究は、流行が去った後は限定的であり、2012年の段階で最先端のDeepLearning研究を牽引可能な研究者は、世界でも少数であったとされている。そんな中、彼らが勝手気儘に研究をしていたのでは、誰もその技術の重要性に気づかないまま時が過ぎていったであろう。個人的には、第3次AIブームをもたらした最大の功績は、AI研究を競技にしたことにあると考えている。すなわち、優秀な人材が集まり、同じ水準で研究を目指せる場所を作ったことである。これは、スポーツ(オリンピックなど)と類似しているような気がする。世界記録更新を目指して、切磋琢磨する中から、様々な技術が生まれていく。オリンピックが社会に与える影響力は極めて大きい。多くの人々が、最新の競技レベルをその目でみて感じることができるからだ。AIについても、コンペティションという形式が、類似のマーケティング効果を生み、研究コミュニティのみならず、世間一般への認知・普及へとつながった。実際、ILSVRCの成果は、論文発表にとどまらず、オープンソースとしてコード公開されることで、一般のエンジニアによるアプリケーション応用へと貢献している。事例を紹介しよう。2018年にSIGNATEにおいて、国際宇宙ステーション(きぼう)に設置したハイビジョンカメラで撮影した動画から、流星を検出する「メテオサーチチャレンジ」が開催された。従来は、動画を人がみて流星を数えていたが、それを自動化しようという試みだ。

500人以上が参加し、結果として優勝スコアが0.99898(完全正答は1.0)という高精度なAIが実現した。開発者は東京大学の学生で最新(2017年)のILSVRCの優勝モデル「SENet」を3次元データに拡張し実装することで優勝を勝ち取った。ちなみに、提出された解法レポートは漫画(!)で書かれており、2人のJKがコンペに参加して優勝するまでのストーリーが面白い。ちなみに、DeepLearningの構築と同じくらい漫画を書くのが大変だったらしいw。漫画が書けるAIエンジニア、売れっ子間違いなしであるw。

データ・計算資源・人材、3つの要素がオープンな場に集結し、最先端の技術水準と知見の共有を可能にしたことこそ、イノベーションの本質である。

社会に広がっていくエコシステム

実は、ILSVRCが始まった2010年以前にも、データ分析系のコンペティションは多数開催されてきた。例えば、学術系では「KDD Cup」が有名であり、1997年から開催されている老舗コンペだ。産業界において最初に、そして最もインパクトを与えたデータ分析コンペは、間違いなく2006年に開催された「Netflix Prize」だろう。当時のNetflixは今のようなストリーミング事業ではなく、DVDレンタル事業が中心だった。売上の75%がおすすめ(レコメンデーション)経由であり、300人のデータサイエンティストをレコメンドエンジンの開発・運用に投下し、年間1.5億ドルもの経費をかけていたそうだ(ちなみにデータサイエンティスト職の中で、Netflixは世界で最も高給なことで有名だ)。Netflix Prizeとは、そんな超エリートレコメンドエンジンをさらに10%以上精度改善を目指すというチャレンジだ。かなりの無理ゲーである。しかし、結果的には、賞金100万ドルという大金がかけられたこともあり、世界186ヶ国から4万以上のチームが参加し、3年間の激戦の末、10%の精度向上は現実のものとなった。その後、得られた技術により年間9000万ドルの売上向上につながったとされている。その辺は、本当かウソかわからないが、少なくとも世界中の技術者にNetflixの名前が深く刻まれたに違いなく、広告宣伝として十分回収できていると考える。さすが超絶ビジョナリーな会社である。Netflix Prizeの詳細は以下の解説がわかりやすい。

Netflix Prizeのインパクトは絶大であった。その後、産業のAI課題をコンペティションを用いて解決する商用サービスが次々と誕生することになる。

2009年:Netflix Prize終了

2009年:TunedIT【ポーランド】

2010年:Kaggle【アメリカ】

2012年:CrowdAnalytix【アメリカ】

2013年:CrowdSolving【日本】

2014年:SIGNATE(旧DeepAnalytics)【日本】

2014年:Tianchi(Alibaba)【中国】

2017年:KaggleがGoogleに買収される

中でも最も成功したサービスが「Kaggle」である。今では、世界最大の会員数を誇り、2017年にGoogle(Google cloud platform: GCP)に買収されてから、さらに一般的認知が広がった。ちなみに、当時のGCPにおけるAI/ML Chief scientistは、スタンフォード大学のFei-Fei Li教授である。彼女は前述のImageNetおよびILSVRCの設立者であることから、買収の背景がなんとなくみえてくる。また、2014年にAlibabaにより設立された「Tianchi」もAlibaba cloud事業の一部であることから、巨大クラウドプレーヤーにとって、コンペサービスは自社クラウドサービス上でのAI開発とその後の運用につながる販促的位置付けであることが窺える(この辺については別の機会で考察してみたい)。そんなTianchi設立の1年前、2013年に設立された日本初のコンペサイト「CrowdSolving」は、僕が設立したサービスだ。当時、個人的にKaggleの存在を知りコンペにチャレンジしようとしていた頃、むしろ自分でKaggleのようなサービスを立ち上げた方が面白いのではないかと考え(タイムマシン経営的にも)、所属会社において新規事業として立ち上げた(会社からOKもらうの大変だったが)。サイトの構築から営業資料の作成、コンペの誘致・立案・設計、会員とのコミュニケーションなど、全てのプロセスを自分でこなした。しかし、その後、いろいろな出会いもあり、サービス開始から1年経たずして、ネット広告会社におけるビッグデータR&D組織の立上げ責任者として、転職することになる(13年働いて初めての転職;)。

転職した後も、コンペサービスを続けたいという思いがあり、翌2014年にDeepAnalyticsというサービス名で再びゼロから立ち上げ直した。R&D組織は、2018年に事業会社化し、「SIGNATE」へとサービス名称を変えた。今では、多数の大企業や行政が活用する日本最大のコンペサービスにまで成長した。2018年以降、コンペの社会的認知もより広がり、韓国初のコンペサービスが立ち上がったり、日本でも複数のサービスが設立されている。コンペティション文化が広がっていることはとてもいいことだと思う。

2013年当時、業界人の間ではKaggleの存在は知られていたが「コンペという方法は日本では無理じゃない?そもそもデータサイエンティストの定義が無いし、何人いるか分からないし、企業も依頼しないでしょ。うまくいかないよ。」といった否定的な声も聞かれた。まさに、2013年は、データサイエンティスト協会が設立され、データサイエンティストのスキル定義などの検討が始まった年でもある。コンペティションでは、国籍・性別・年齢・学歴・職歴・資格・学位などは全く関係ない。知識や能力は持っていても使わなければ意味がなく、結果を出してなんぼである。SIGNATEでもKaggleでも入賞者が課題領域外の非専門家なんてことは、よくあることだ。社会のあまねくAI課題に対して、世界中の人々が、自由にチャレンジする。解決に貢献した人は、どんなバックグラウンドであれ、社会から賞賛される。実践の中で学び、AIという表現手段を得て、社会へ一石投じられる存在になる。まさに「開かれたAI」だ。開かれたAIにとっての敵とは「選ばれた一握りの人間のみが、AIの発展に寄与できるはずだし、そうあるべき」という考えだろう。

この記事が気に入ったらサポートをしてみませんか?