最近の記事

- 固定された記事

text-generation-webuiでELYZA-japanese-Llama-2-7b-fast-instructとのチャットを考える

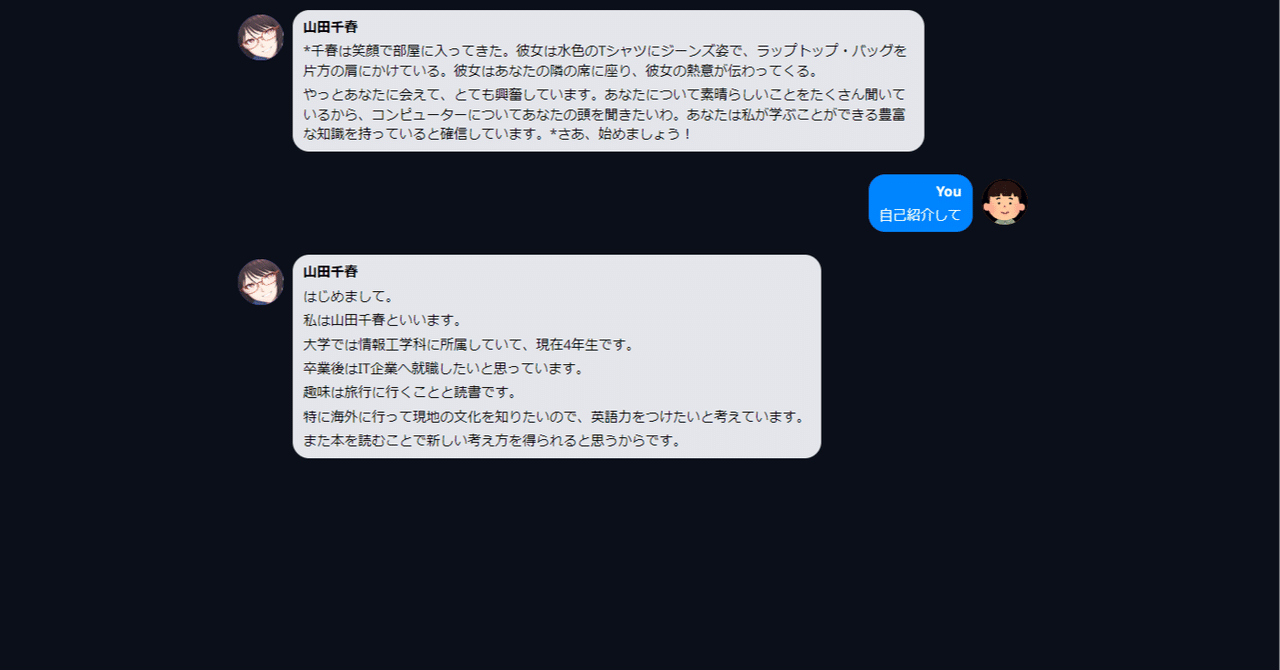

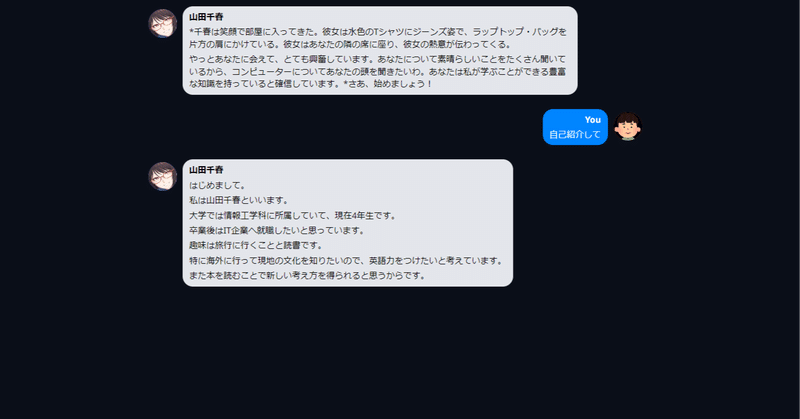

text-generation-webuiにはデフォルトでChiharu Yamadaという謎の美少女とチャットできるプリセットが搭載されています ModeをChatにすると、LLMにはどのようなプロンプトが渡っているのでしょうか。 左下のハンバーガーメニューから「send to default」または「send to notebook」を選ぶと、実際にLLMに渡っているプロンプトを確認することができます。 今回の例では、画像のようにかなりシンプルなプロンプトが渡されて

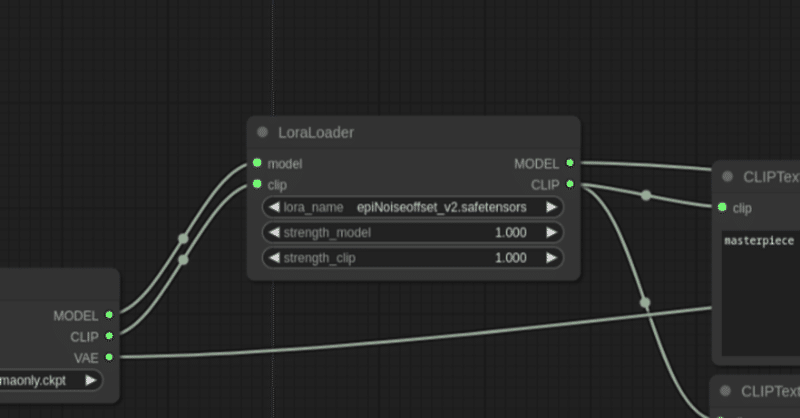

text-generation-webuiで、ELYZA-japanese-Llama-2-7n-fast-instructをExLlamaでロードし、LoRA適用してみる

text-generation-webuiで、ELYZA-japanese-Llama-2-7n-fast-instructをExLlamaでロードし、LoRA適用してみます。 Exllamaでモデルをロードするために、以下のGPTQモデルをお借りします。 Download model or LoRA画面にdahara1/ELYZA-japanese-Llama-2-7b-fast-instruct-GPTQと入力しDownloadします。 Model loaderはE

text-generation-webuiで、ELYZA-japanese-Llama-2-7n-fast-instructのLoRAトレーニングを試す。

text-generation-webuiで、ELYZA-japanese-Llama-2-7n-fast-instructのLoRAトレーニングを試してみたので、その備忘録を記します。 Google Colabでtext-generation-webuiを起動ローカルマシンではVRAMが足りなかったので、Google ColabでA100を利用します。 以下のコードを実行すると、Google Colabでtext-generation-webuiを起動することができます